一种基于单词删除的同声传译方法及系统

本发明涉及自然语言处理,尤其涉及一种基于单词删除的同声传译方法及系统。

背景技术:

1、机器翻译技术经历了规则机器翻译、统计机器翻译、神经网络机器翻译等发展阶段。典型的机器翻译方案有:

2、(1)基于词典和规则的机器翻译,依靠人工制定的词汇对应规则进行翻译,翻译质量低。

3、(2)统计机器翻译,使用大规模平行语料训练机器翻译模型,典型方法有词对齐模型、短语基础模型等。统计机器翻译提高了翻译质量,但仍存在词序错误、意译错误等问题。

4、(3)神经网络机器翻译,典型方法是编码器-解码器(seq2seq)框架,使用lstm等循环神经网络对源语言进行编码,再解码生成目标语言。提高了翻译流畅性,但仍存在无法处理长句子的问题。

5、(4)注意力机制机器翻译,在seq2seq框架中加入注意力模块,可以建模源语言和目标语言词之间的相关性,显著提升了翻译质量。

6、文本同声传译根据时延策略也可以分为固定读写策略和动态读写策略。

7、固定读写策略将输入文本划分固定大小片段后进行翻译,时延一致但容易产生语序错误。动态读写策略根据整句语义进行翻译,时延不稳定但语序正确。

8、典型的文本同传系统也采用流行的机器翻译模型,以seq2seq等模型为主,配合触发词预测、缓存机制等技术进行翻译。文本同传翻译存在翻译错误堆叠、意译偏差等问题。

9、3.3机器翻译中的单词删除技术

10、为增强机器翻译的鲁棒性,提出使用单词删除技术。主要包括:

11、(1)训练过程中对源语言句子进行单词删除,增强模型对不完整输入的鲁棒性。

12、(2)推理过程中对解码器输出进行单词删除。

13、(3)基于单词重要性对低重要性单词进行删除。

14、当前文本同声传译系统中,固定读写策略较为常用,其典型模型是wait-k模型。

15、wait-k模型的训练过程:

16、1)构建编码器-解码器(seq2seq)模型结构,编码器和解码器均采用transformer结构。

17、2)使用带有固定延迟k的平行语料进行训练,即源语言序列右移k个单词后与目标语言序列构成训练样本。

18、3)通过最大化目标语言序列的似然估计,训练模型参数。

19、wait-k模型的推理过程:1)待翻译的源语言输入到编码器产生语义向量表示。2)解码器根据当前语义向量和前k个词的记录,预测下一个词。3)输出的词汇再输入解码器作为新信息,预测下个词汇。4)重复上述过程直到翻译完成。

20、但是wait-k模型存在以下问题:1)训练数据的源语言缺失,导致解码过度依赖目标端,产生翻译偏差,2)不存在对翻译幻觉问题的针对性处理。

21、综上所述,现有wait-k等文本同传模型尚无法有效解决翻译偏差、翻译幻觉等问题,因此有进一步改进的必要。

技术实现思路

1、本发明提供了一种基于单词删除的同声传译方法及系统,解决现有技术中wait-k等文本同传模型尚无法有效解决翻译偏差、翻译幻觉的问题。

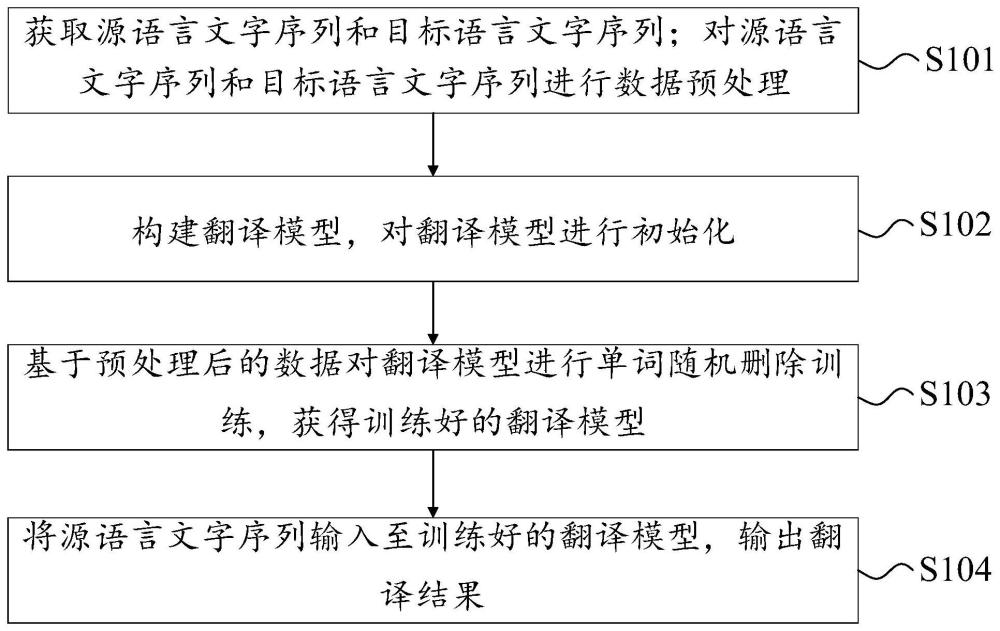

2、为解决上述发明目的,本发明提供的技术方案如下:一种基于单词删除的同声传译方法,步骤包括:

3、s1:获取源语言文字序列和目标语言文字序列;对源语言文字序列和目标语言文字序列进行数据预处理;

4、s2:构建翻译模型,对翻译模型进行初始化;

5、s3:基于预处理后的数据对翻译模型进行单词随机删除训练,获得训练好的翻译模型;

6、s4:将源语言文字序列输入至训练好的翻译模型,输出翻译结果。

7、优选地,步骤s1中,对源语言文字序列和目标语言文字序列进行数据预处理,包括:

8、s11:对源语言文字序列和目标语言文字序列进行分词处理,获得分词后的源语言文字序列和目标语言文字序列;

9、s12:基于分词后的源语言文字序列构建源语言词汇表;基于分词后的目标语言文字序列构建目标语言词汇表;

10、s13:使用开源工具fairseq对分词后的平行语料进行数字化编码,将文字表示转换为序号表示。

11、优选地,步骤s2中,构建翻译模型,对翻译模型进行初始化,包括:

12、s21:构建翻译模型,翻译模型包括编码器和解码器;

13、s22:初始化编码器和解码器参数,其中,编码器和解码器均采用transformer神经网络结构。

14、优选地,步骤s3中,基于预处理后的数据对翻译模型进行单词随机删除训练,获得训练好的翻译模型,包括:

15、s31:基于预处理后的数据对翻译模型进行迭代训练;每次迭代时,对目标语言序列中的每个分词分别以p概率进行随机替换,替换为<unk>标记;

16、s32:通过最大化目标语言序列的最大似然估计条件,更新翻译模型参数,获得训练好的翻译模型。

17、优选地,步骤s31中,对目标语言序列中的每个分词分别以p概率进行随机替换,替换为<unk>标记,包括:

18、获取分词后的目标语言序列;

19、以概率p随机生成一个掩码矩阵,通过掩码矩阵对分词后的目标语言序列中的每个分词进行<unk>替换。

20、优选地,步骤s32中,通过最大化目标语言序列的最大似然估计条件,更新翻译模型参数,获得训练好的翻译模型,包括:

21、基于单词随机替换后的目标语言序列,通过最大化目标语言序列的最大似然估计条件,获得目标语言索引,根据目标语言词汇表获得目标语言词汇;

22、更新翻译模型参数,获得训练好的翻译模型。

23、优选地,步骤s4中,将待翻译数据输入至训练好的翻译模型,输出翻译结果,包括:

24、s41:输入源语言序列至编码器,输出源语言句子的源语言向量;

25、s42:通过解码器根据源语言向量和目标语言词汇,预测下一次需要翻译的目标语言词汇;

26、s43:重复执行所述步骤s41-s42,直至翻译完成,输出翻译结果。

27、一种基于单词删除的同声传译系统,系统用于上述的基于单词删除的同声传译方法,系统包括:

28、数据预处理模块,用于获取源语言文字序列和目标语言文字序列;对源语言文字序列和目标语言文字序列进行数据预处理;

29、模型初始化模块,用于构建翻译模型,对翻译模型进行初始化;

30、模型训练模块,用于基于预处理后的数据对翻译模型进行单词随机删除训练,获得训练好的翻译模型;

31、翻译模块,用于将源语言文字序列输入至训练好的翻译模型,输出翻译结果。

32、优选地,数据预处理模块,用于对源语言文字序列和目标语言文字序列进行分词处理,获得分词后的源语言文字序列和目标语言文字序列;

33、基于分词后的源语言文字序列构建源语言词汇表;基于分词后的目标语言文字序列构建目标语言词汇表;

34、使用开源工具fairseq对分词后的平行语料进行数字化编码,将文字表示转换为序号表示。

35、优选地,模型初始化模块,用于构建翻译模型,翻译模型包括编码器和解码器;初始化编码器和解码器模型参数,其中,编码器和解码器均采用transformer神经网络结构。

36、一方面,提供了一种电子设备,所述电子设备包括处理器和存储器,所述存储器中存储有至少一条指令,所述至少一条指令由所述处理器加载并执行以实现上述基于单词删除的同声传译方法。

37、一方面,提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令,所述至少一条指令由处理器加载并执行以实现上述基于单词删除的同声传译方法。

38、上述技术方案,与现有技术相比至少具有如下有益效果:

39、上述方案,通过对模型目标端单词随机删除,这样可以使得同声传译模型在训练的时候不会过多依赖目标端的假输入。随机删除目标语言单词的技术手段,强迫模型减少对完整目标语言的依赖,迫使其关注源语言端的信息,增强模型对不完整源语言序列的建模能力。通过针对性的单词随机删除技术方案,可以有效解决文本同传中产生的翻译幻觉问题。

- 还没有人留言评论。精彩留言会获得点赞!