多尺度细节特征增强的矿井图像单目深度估计方法与流程

本发明涉及图像处理,尤其涉及一种多尺度细节特征增强的矿井图像单目深度估计方法。

背景技术:

1、

2、在计算机视觉中,三维重建的过程是指通过使用图像或视频等二维数据来推断场景的三维结构和深度信息。在单目深度估计中,仅使用单张图像来估计场景中各个像素点的深度,由于单视图的信息不完全,因此,三维重建需要利用经验知识。而多视图的三维重建相对比较容易,其方法是先对摄像机进行标定,即计算出摄像机的图像坐标与世界坐标系的关系,然后利用多个二维图像中的信息重建出三维信息,在整个过程中,如何准确获得深度信息是能否从二维图像重建出三维信息的关键,然而大多数应用场景中,往往只有一个摄像机对三维场景图像进行采集,因此,单目深度估计技术在三维场景重建中显得至关重要。

3、现有单目深度估计方法所有的密集预测体系结构大多数是基于u-net架构,它的结构由编码器和解码器组成,通过对称连接的方式结合了底层特征和高层语义信息,通过编码器和解码器之间的特征传递和融合,u-net能够充分利用图像中的多层次信息进行像素级别的预测,其中:编码器负责从输入图像中提取特征,并逐渐减少特征的空间尺寸,增大感受野,减少参数数量,解码器负责将编码器提取的特征进行上采样,并逐渐恢复到原始输入图像的尺寸,如此操作,会存在以下缺陷:

4、1、编码器在输入图片下采样的过程中会丢失图像的特征和细节信息,这些特征和细节信息在解码过程中无法恢复;

5、2、图像中物体边界丰富的深度信息没有提取利用;

6、3、未对局部细节进一步处理,导致深度图出现模糊伪影。

技术实现思路

1、本发明要解决的技术问题是:为了解决现有单目深度估计网络模型深度估计后深度图出现模糊伪影的技术问题,本发明提供一种多尺度细节特征增强的矿井图像单目深度估计方法,通过单目深度估计网络模型的改进,能够改善深度图出现的模糊伪影。

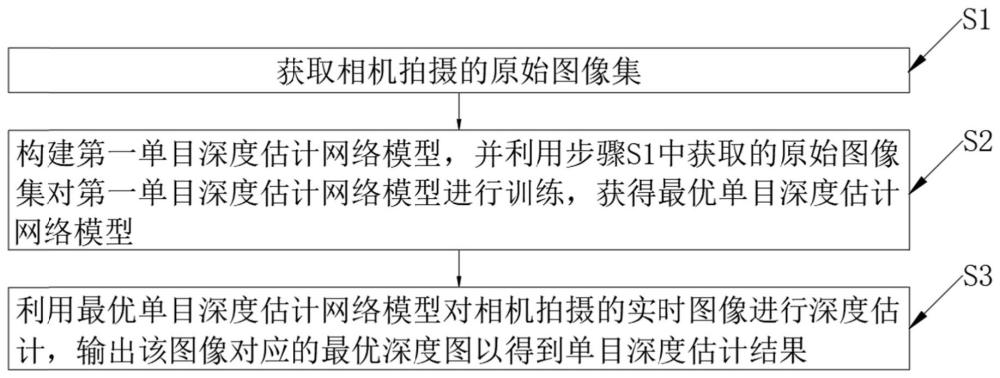

2、本发明解决其技术问题所采用的技术方案是:一种多尺度细节特征增强的矿井图像单目深度估计方法,包括以下步骤:

3、s1、获取相机拍摄的原始图像集;

4、s2、构建第一单目深度估计网络模型,并利用步骤s1中获取的原始图像集对所述第一单目深度估计网络模型进行训练,获得最优单目深度估计网络模型;

5、s3、利用所述最优单目深度估计网络模型对相机拍摄的实时图像进行深度估计,输出该图像对应的最优深度图以得到单目深度估计结果。

6、由此,通过对第一单目深度估计网络模型的训练,得到最优单目深度估计网络模型,并利用该最优单目深度估计网络模型对相机拍摄的实时图像进行深度估计,能够改善该图像对应最优深度图出现的模糊伪影。

7、进一步地,所述步骤s2包括以下步骤:

8、s2-1、通过可训练的sobel算子并执行卷积对步骤s1中获取的原始图像集的目标帧图像it,进行处理,输出边缘信息特征图x,将目标帧图像it和边缘信息特征图x在通道上叠加、并一同输入到所述第一单目深度估计网络模型中;

9、s2-2、在第二单目深度估计网络模型中加入全局结构感知模块和浅层-深层特征融合模块以得到所述第一单目深度估计网络模型,并利用所述第一单目深度估计网络模型中的深度估计网络对步骤s2-1中获取的目标帧图像it和边缘信息特征图x进行处理,输出目标帧的深度图dt;

10、s2-3、获取步骤s1中原始图像集中的源帧图像it′和目标帧图像it,获取相机参数k,并利用所述第一单目深度估计网络模型中的位姿估计网络计算出源帧图像it′和目标帧图像it之间对应的相机位姿关系tt′→t;

11、s2-4、利用所述相机位姿关系tt′→t对步骤s2-2中获取的目标帧的深度图dt和步骤s2-3中获取的源帧图像it′进行扭曲处理,输出重建图it′→t;

12、s2-5、对步骤s2-1中获取的目标帧图像it和步骤s2-4中获取的重建图it′→t进行损失计算,得到总损失l;

13、s2-6、多次重复上述步骤s2-1至步骤s2-5,直至原始图像集中所有的目标帧图像it均扭曲处理完后,所述第一单目深度估计网络模型的输出结果满足精度要求;

14、其中:将满足输出精度的所述第一单目深度估计网络模型设为最优单目深度估计网络模型。由此,通过可训练的sobel算子并执行卷积对目标帧图像it进行处理,能够在数据源层面丰富第二单目深度估计网络模型的输入信息,并能够增强第二单目深度估计网络模型的边缘信息;通过引入全局感知模块,使得目标帧的深度图dt的每个通道图从所有其他通道图中捕捉到更多不同的区域相应,并聚合这些不同区域的相应,从而增强对场景结构的感知,减少卷积网络中下采样过程中的信息丢失,获取更多的深度特征信息;通过引入浅层-深层特征融合模块,将来自编码器的浅层全局结构特征和来自上一层解码器的深层局部细节特征通过注意力图自适应的融合特征,以改善简单的通道叠加导致深度图出现的模糊伪影。

15、进一步地,在步骤s2-2中,全局结构感知模块是指:

16、边缘信息特征图x的特征维度为:h*w*c,该边缘信息特征图x线性投影到相同维度查询的计算公式为:

17、q=xwq;

18、键值的计算公式为:

19、k=xwk;

20、值的计算公式为:

21、v=xwv;

22、其中:wq、wk、wv表示权重矩阵。

23、进一步地,在步骤s2-2中,交叉协方差注意力用于增强输入的计算公式为:

24、

25、增强特征非线性的计算公式为:

26、

27、其中:attention(q,k,v)=v·softmax(qt·k),softmax为归一化函数,linear为线性函数,linearg为线性渐变函数,qt为转置矩阵,ln表示归一化层。

28、进一步地,在步骤s2-2中,浅层-深层特征融合模块是指:

29、首先,利用卷积层将特征维度匹配一致,然后,将这些特征沿着通道维度连接起来,并通过两个3*3卷积归一化relu层,最后,将该卷积层和sigmoid层产生一个双通道注意力图;其中:每个浅层特征和深层特征与每个通道相乘,这些相乘的特征逐元素相加。由此,能够关注重要位置,以构建混合特征。

30、进一步地,在步骤s2-4中,目标帧图像it的像素pt映射到源帧图像it′的像素pt′,其对应关系表示为:

31、pt′~ktt→t′dt(pt)k-1pt;

32、重建图it′→t的计算公式为:

33、it′→t=it′<proj(dt,tt→t′,k)>;

34、其中:proj()为转换函数,<·>为局部亚可微的双线性采样算子。

35、进一步地,在步骤s2-5中,目标帧图像it与重建图it′→t进行相似度对比,其对比关系表示为:

36、

37、光度重建误差ρ的计算公式为:

38、

39、光度重投影损失lp的计算公式为:

40、lp=∑t′ρ(it,it′→t);

41、其中:l()为照片透明度函数,c()为图片对比度函数,s()为图像结构函数。由此,由于真实环境中光照条件并非固定不变,通过结构相似度损失ssim能够更好地处理复杂光照的变化。

42、进一步地,在步骤s2-5中,边缘光滑损失ls的计算公式为:

43、

44、其中:表示平均归一化反深度。由此,当图像出现纹理较弱的区域时,边缘平滑损失ls能在光度重投影损失lp失效的情况下对深度预测值进行约束。

45、进一步地,在步骤s2-5中,尺度一致性损失lc的计算公式为:

46、

47、其中:将源帧深度图dt’根据相机位姿关系tt→t′向目标帧深度图dt扭曲投影后,再将像素网格对齐后得到的深度图由此,尺度一致性损失lc能够保证深度预测的一致性。

48、进一步地,在步骤s2-5中,总损失l的计算公式为:

49、l=μlp+γls+τlc;

50、其中:μ=[mint′ρ(it,it′→t)<mint′ρ(it,it′)],若小于,则μ=1,反之,则μ=0,γ表示边缘光滑损失ls的权重,τ表示尺度一致性损失lc的权重。

51、与现有技术相比,本发明的有益效果是:

52、1、本发明通过可训练的sobel算子并执行卷积对目标帧图像it进行处理,能够在数据源层面丰富第二单目深度估计网络模型的输入信息,并能够增强第二单目深度估计网络模型的边缘信息。

53、2、本发明通过引入全局感知模块,使得目标帧的深度图dt的每个通道图从所有其他通道图中捕捉到更多不同的区域相应,并聚合这些不同区域的相应,从而增强对场景结构的感知,减少卷积网络中下采样过程中的信息丢失,获取更多的深度特征信息。

54、3、本发明通过引入浅层-深层特征融合模块,将来自编码器的浅层全局结构特征和来自上一层解码器的深层局部细节特征通过注意力图自适应的融合特征,以改善简单的通道叠加导致深度图出现的模糊伪影。

- 还没有人留言评论。精彩留言会获得点赞!