一种面向多种聚合框架的联邦元学习差分隐私噪声分配方法

本发明涉及一种面向多种聚合框架的联邦元学习差分隐私噪声分配方法,特别是隐私噪声分配。

背景技术:

1、联邦学习的目的在于保护客户端的私有本地数据,在训练过程中客户端拒绝将自己的个人数据直接传输给服务器和其他客户端,可是尽管客户端和服务器之间避免了原始数据的交互,但是目前仍存在多种攻击手段可以泄露客户端隐私数据,如成员推理攻击、属性推理攻击和重构攻击;

2、联邦学习因其优秀的隐私保护能力和较低的数据传输量得到了广泛的重视和应用,现有技术中在联邦学习过程中仍然会通过客户端和服务器之间的交互数据造成隐私的泄露,因此需要更进一步的措施来对隐私数据进行防御,在差分隐私防御机制中,过高的噪声会使得模型准确率下降,而过低的噪声又无法达到理想的防御效果,在模型能够允许的噪声范围内充分利用噪声预算以达到最好的防御效果尤为重要。

技术实现思路

1、发明目的:提出一种面向多种聚合框架的联邦元学习差分隐私噪声分配方法,以解决现有技术存在的上述问题。

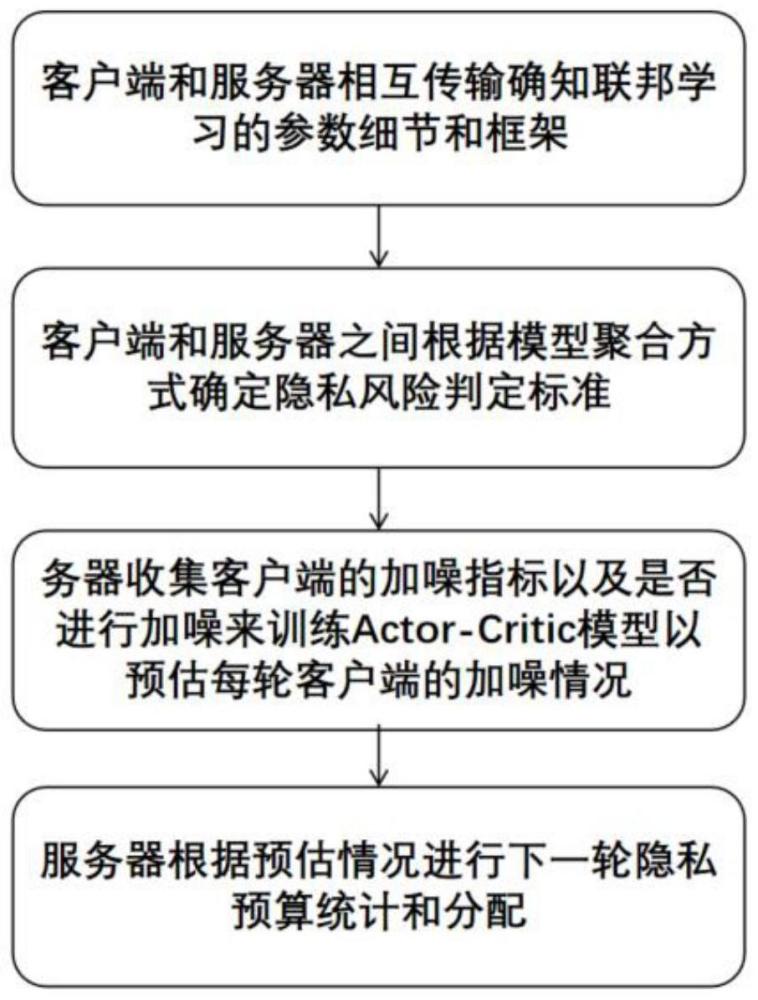

2、技术方案:一种面向多种聚合框架的联邦元学习差分隐私噪声分配方法,包括:

3、步骤一,客户端和服务器相互传输已知联邦学习的参数细节和框架;

4、步骤二,客户端和服务器之间根据模型聚合方式确定隐私风险判定标准;

5、步骤三,服务器收集客户端的加噪指标,判定是否进行加噪来训练actor-critic模型以预估每轮客户端的加噪情况;

6、步骤四,服务器根据预估情况对各轮隐私预算进行统计和分配。

7、在进一步的实施例中,所述步骤一,首先确定联邦学习所使用的框架,联邦学习在学习开始之前,客户端和服务器之间达成一致的学习协议,选定适用的框架和参数,根据fedsgd和fedavg基本框架进行差分隐私噪声分配,fedsgd在客户端和服务器之间通过传输损失函数的梯度数据进行模型学习的构建,fedavg通过交互模型的权重参数,所述权重参数包含客户端的本地隐私信息,而隐私信息存在泄露风险;

8、当模型学习到一定的程度,损失函数越小,梯度逐渐接近于零,模型参数也逐渐不再变化,在不同的客户端的不同训练阶段的数据泄露风险,不一致,则需要统一标准进行衡量并分配噪声;

9、根据差分隐私的加噪使联邦学习按照一定的协议顺利进行,在开始模型训练之前,服务器和客户端确定好参数的选择,客户端和服务器之间通过历史经验和实际成本约束在联邦学习开始之前进行协商确定。

10、在进一步的实施例中,所述步骤二中客户端和服务器之间通过模型聚合中的fedsgd框架确定隐私风险判定标准;

11、在fedsgd框架,客户端和服务器之间通过损失函数的梯度进行信息更新和模型构建,通过分层互信息神经估计,计算发送梯度和原始数据之间的互信息量上界,进而计算发送梯度所包含的原始数据的信息量,判断隐私泄露风险,其中信息量的计算基于kullback-leibler散度,得出如下表达式:

12、

13、式中,i表示xb和gt的互信息表达式;dkl表示相应的kl散度表达式;xb和gt分别表示客户端中以批量大小为b的原始数据以及客户端要发送给服务器的梯度数据;和分别表示xb和gt的联合分布和边际分布;表示联合分布的期望;t表示网络参数;表示边缘分布的期望;et表示对数;

14、将kullback-leibler散度计算得到数据,带入t中的期望减去从边际分布采样得到的数据代入et的期望,通过互信息的神经估计对大小不一致的xb和gt两种数据维度进行处理,其中,批量为b的每个数据和梯度组成一个数据块om={xm,gt},m=1,...,b保证每个数据块同分布,其中xm为批量大小为b的原始数据,gt为梯度,保证每个数据块同分布,然后通过一个共享子网络将他们映射到b个嵌入向量hm,嵌入向量串联后通过多个全连接层降低维数,使输出单个标量vk,计算其互信息量上界,具体表达式如下:

15、

16、式中,v表示互信息量上界;s表示在b下客户端总的样本大小;

17、通过互信息量的大小来反应隐私泄露风险,判定每一轮处理中客户端是否需要添加噪声防御,若是大于在学习开始前与服务器协议好的互信息上界,则进行加噪防御。

18、在进一步的实施例中,所述fedavg框架下的隐私风险判定标准;

19、在fedavg框架,客户端和服务器之间通过模型权重进行信息更新,在梯度深度泄露的变形攻击中使用模型权重更新量的匹配来替代梯度匹配,通过评估权重变化差值来衡量隐私泄露的可能性,设定权重矩阵是一个m行n列的矩阵,表达式如下:

20、

21、式中,wt表示在第t轮上需要发送的权重矩阵,wt+1表示第t+1轮则轮上需要发送的权重矩阵;位于i行j列位置的神经元权重差值δij,表达式如下:

22、

23、将所有差值进行叠加平均,得出如下表达式:

24、

25、式中,v表示平均差值;

26、在fedavg的框架中,通过观察平均差值v来评估要发送的权重信息是否有较大更新,存在隐私风险;若客户端在发送权重信息前计算,发现每一轮处理中的权重信息和上一轮权重信息的差值大于在联邦学习开始前与服务器协议好差值的上界,则需要进行加噪防御。

27、在进一步的实施例中,所述步骤三中服务器收集客户端的加噪数据进行actor-critic模型的训练以预估下一轮客户端的加噪情况的具体如下:

28、所述actor-critic元学习网络进行客户端加噪需求的快速学习和预测,actor-critic模型由actor网络以及critic网络两个部分组成,其中actor网络用于预测各轮客户端的加噪需求,critic网络用于监督actor网络进行快速学习,通过预测奖励函数快速优化actor网络。

29、在进一步的实施例中,服务器收集客户端的加噪状态并输入给actor网络进行下一轮客户端加噪人数的预测;

30、将隐私判定标准结果和加噪情况通过加噪标识发送给客户端,客户端聚集每个参与学习的客户端的信息并作为状态st,输入到以预测下一轮会有多少客户端需要加噪的actor网络中;

31、设定actor模型的输出为at,即预测在第t轮迭代过程中的相关加噪行动,包括了加噪的噪声预算,则整个模型表达式如下:

32、

33、式中,pθ表示actor网络的函数;θ表示actor网络的待优化的神经元参数;y表示整个模型依靠下一轮的客户端训练出的真实加噪需求,并计算出相应的奖励并以最大化奖励函数的目标来进行对actor网络优化,其中为actor网络预测的加噪的客户端数量;l为损失函数的计算公式,rt为第t轮迭代下的奖励值;

34、服务器在预测出加噪的人数后根据整个联邦学习的具体情况进行下一轮隐私预算的规划计算,具体表达式如下:

35、

36、式中,εc表示服务器计算的客户端允许使用的噪声隐私预算,也是actor网络的输出;ε(·)表示加噪函数,根据预测的需要加噪的客户端数量来计算得到的。

37、在进一步的实施例中,根据预测的具体情况和实际的加噪情况学习critic网络,考虑到奖励函数不稳定且需要在整个联邦学习中进行每轮学习后才能获得的采样,其对于actor网络的优化性能不存在及时性,因此根据critic网络来对奖励函数r进行更加稳定频繁的估算,采用值函数近似的概念来对状态-行为的出质量预估值函数进行计算。

38、在进一步的实施例中,所述critic网络以φ为参数,以第t个轮次的状态st,actor网络的学习得到的行为at为输入,输出一个期望的奖励,根据贝尔曼公得出如下表达式:

39、

40、式中,q表示最大化模型质量;rt表示预测的奖励函数值;φ表示critic网络的模型参数;

41、在状态st下采取动作at的q值得到当前状态的奖励rt再加上下一时刻的q值乘以权重值γ,critic网络通过对下一时刻的状态行为的预测来获取预测奖励值rt。

42、在进一步的实施例中,所述critic网络监督actor网络加快学习使两个网络得到优化,在服务器中添加actor-critic网络准确快速的预测每一轮客户端需要加噪的个数,因此除了使用每一轮的实际加噪情况计算出的奖励函数rt,还需要使用经过critic网络的预测奖励函数critic网络赋予actor优化数据以快速进行模型学习;

43、actor优化的奖励函数rt,而critic网络准确地预测奖励,则用奖励差来优化,具体表达式如下:

44、

45、

46、式中,θ表示actor网络的模型参数,q表示最大化模型质量,φ表示critic网络的模型参数,通过预测奖励qφ(st,at)-γqφ(st+1,at+1)和优化奖励函数rt之间的差值优化critic模型。

47、在进一步的实施例中,所述步骤四中服务器根据预估情况进行下一轮隐私预算统计和分配的具体步骤包括:

48、步骤4-1:客户端确定本轮可使用的噪声预算;

49、在服务器确知共有n个客户端且预设迭代总轮次为t的情况下,则第一轮所有客户端总共可以使用的噪声预算总量为εall/t,由于第一轮服务器中的actor-critic网络没有进行学习预测,设定第一轮每个客户端都会去加噪的情况去分配预算,则每个客户端分配到的噪声就是其中εc表示客户端能够使用的隐私预算量;

50、在第t轮迭代时,服务器预测的本轮会加噪的客户端个数为则该轮需要加噪防御的客户端的隐私预算为其中,εr为噪声预算剩余量,服务器将该轮可供每个客户端使用的噪声预算和更新好的全局模型一同发送给每个客户端,

51、步骤4-2:服务器更新预算余量;

52、服务器在聚合所有参与学习的客户端数据后通过统计标识符了解共有kt个客户端加噪,更新剩余预算量为:其中,公式右边的εr为上一轮计算得到的预算剩余量,而公式左边的εr为该轮更新后的预算剩余量,当剩余隐私预算更新结束后就标志每轮学习的结束;

53、步骤4-3:服务器最后一轮噪声预算计算;

54、每轮重复操作步骤4-1和步骤4-2,在最后一轮学习中,保证合理使用预算,需要对每个客户端进行加噪处理,即对于第t-1轮剩余下来的隐私预算εr进行所有客户端的分配

55、有益效果:本发明提出了一种面向多种聚合框架的联邦元学习差分隐私噪声分配方法,通过对不同的联邦学习框架选择合适的数据隐私性的风险指标来判断,是否有加噪防御的必要,并将这些评价指标作为状态输入加噪需求预测网,在服务器中训练actor-critic模型以快速准确的去预测下一轮的加噪人数,以达到充分利用噪声防御的目的,不同于固定的加噪模式,通过学习的加噪方式能够对不同的数据模式以及模型架构做出更快、更个性化的学习结果,加噪结果也会更加精准有效;

56、噪声分配流程详细描述了在每一轮噪声分配需求未知的情况下,在客户端和客户端、客户端和服务器之间无法通信交互计算,共有多少客户端有加噪需求时进行噪声分配,在已知服务器的模型训练中接受噪声预算后,能够充分使用预算以达到最好的整体防御效果。

- 还没有人留言评论。精彩留言会获得点赞!