基于退出点流行度的模型缓存方法、装置、计算机设备

本发明涉及数据缓存,尤其涉及基于退出点流行度的模型缓存方法、装置、计算机设备及存储介质。

背景技术:

1、分布式推理是一种分布式计算范式,旨在提高模型推理性能,特别是在处理大规模数据或复杂任务时。在分布式推理中,多个计算节点或终端设备协同工作,以加速模型的推理过程。分布式推理充分利用云或边缘计算节点的并行计算能力,可以同时处理多个推理请求,提高推理速度。分布式推理可以提供更快的响应时间,适用于对时延要求较高的应用,如实时视频分析和物联网设备。

2、然而在分布式推理过程中,由于不同节点的计算能力和网络通信状态不同,将用户的数据全部传输到边缘节点或云节点上时会导致计算机网络系统中的巨大网络拥塞,这会导致大大增加推理过程的时延。并且大部分现有的分布式推理算法没有充分利用模型缓存。模型缓存是一种存储神经网络模型的机制,可以在用户请求的推理任务中重复使用。通过合理利用模型缓存,可以减少重复计算,提高推理效率,但目前大部分算法并没有充分考虑这一点。

3、为了适应不同应用的时延和能耗需求,一种可行的解决方案是在边缘计算环境中引入神经网络提前退出机制,与一般的深度神经网络的单输出结构不同,提前退出机制在多个神经网络层添加了分类器作为出口,在浅层的神经网络层即可输出中间结果。通过这种方式,一部分推理任务可以通过浅层神经网络获得高置信度,并以可接受的精度提前完成。同一模型可能被多个用户重复请求,将流行度高的模型缓存到边缘服务可以降低模型下载时延。每个用户对精度需求可能不同,同一模型不同退出点的流行度不同,缓存完整模型导致缓存资源浪费。

技术实现思路

1、本发明实施例的目的在于提出一种基于退出点流行度的模型缓存方法、装置、计算机设备及存储介质,以解决现有技术中同一模型不同退出点的流行度不同,缓存完整模型导致缓存资源浪费的问题。

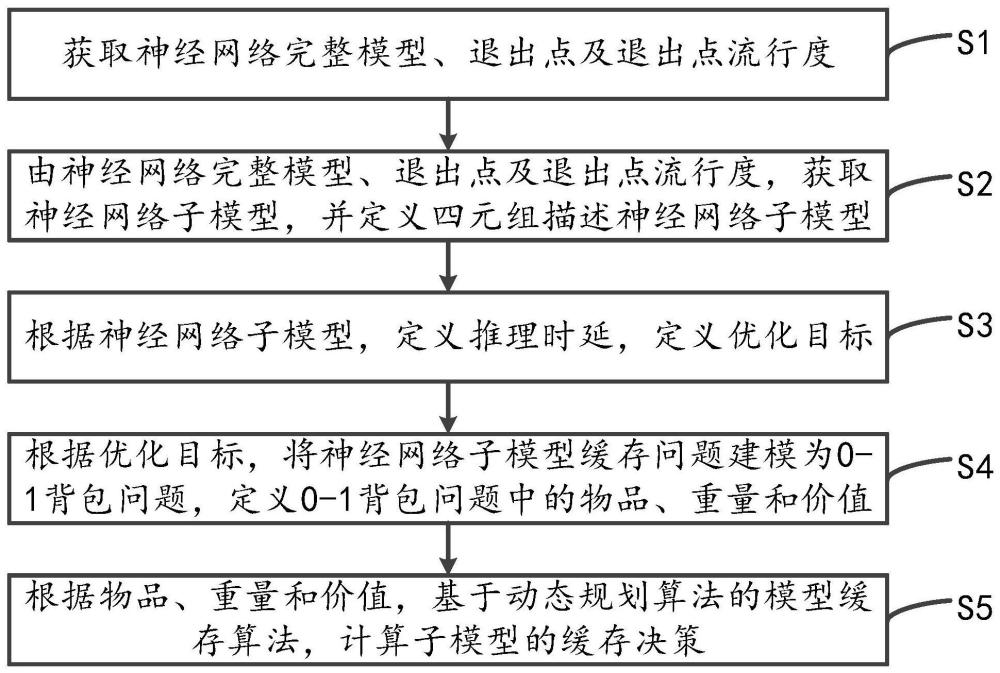

2、为了解决上述技术问题,本发明提供一种基于退出点流行度的模型缓存方法,采用了如下所述的技术方案,包括:

3、获取神经网络完整模型、退出点及退出点流行度;

4、由所述神经网络完整模型、退出点及退出点流行度,获取神经网络子模型,并定义四元组描述神经网络子模型;

5、根据所述神经网络子模型,定义推理时延,定义优化目标;

6、根据所述优化目标,将神经网络子模型缓存问题建模为0-1背包问题,定义0-1背包问题中的物品、重量和价值;

7、根据所述物品、重量和价值,基于动态规划算法的模型缓存算法,计算子模型的缓存决策。

8、优选地,所述获取神经网络完整模型、退出点及退出点流行度的步骤具体包括:

9、云服务器训练完整的神经网络模型;

10、云服务器根据用户精度需求确定退出点;

11、云服务器根据历史请求信息计算退出点请求概率,即退出点流行度。

12、优选地,所述由所述神经网络完整模型、退出点及退出点流行度,获取神经网络子模型,并定义四元组描述神经网络子模型的步骤具体包括:

13、根据所述退出点将神经网络模型分割为多个神经网络子模型;

14、定义四元组描述神经网络子模型,退出点li,j,j∈m的子模型的信息用四元组li,j={ii,ωi,j,pi,j,pi,j}表示,其中ii表示该网络的输入数据,ωi,j表示该退出点的计算密度,pi,j表示退出点li,j-1到退出点li,j的参数量,pi,j为退出点li,j的流行度。

15、优选地,所述根据所述神经网络子模型,定义推理时延,定义优化目标的步骤具体包括:

16、当用户发出子模型为li,k推理请求时,将用户数据发送到边缘服务器进行推理,推理时延包含计算时延,用户数据传输时延和子模型下载时延三部分;

17、优化目标为最小化分布式推理过程的总推理时延,包括模型下载时延,任务的计算时延和用户数据传输时延三部分。

18、优选地,所述根据所述优化目标,将神经网络子模型缓存问题建模为0-1背包问题,定义0-1背包问题中的物品、重量和价值的步骤具体包括:

19、将算法中的物品定义为神经网络模型退出点对应的子模型li,j;

20、将背包的容量定义为边缘服务器上缓存空间的大小c;

21、将物品li,j的重量定义为子模型所包含的参数量物品的价值vi,j定义为缓存子模型li,j在分布式推理过程中的时延减少量。

22、优选地,所述根据所述物品、重量和价值,基于动态规划算法的模型缓存算法,计算子模型的缓存决策的步骤具体包括:

23、将子模型li,j的参数量子模型li,j的计算密度ωi,j,用户的请求概率pi,j,云到边的传输数据率rce,缓存空间的大小c作为输入;

24、初始化每个子模型的缓存变量、不同缓存空间的缓存决策;

25、对不同的缓存空间从小到大开始决策;

26、输出子模型的缓存决策矩阵xi,j。

27、为了解决上述技术问题,本发明还提供一种基于退出点流行度的模型缓存装置,采用了如下所述的技术方案,包括:

28、第一获取模块,用于获取神经网络完整模型、退出点及退出点流行度;

29、第二获取模块,用于由所述神经网络完整模型、退出点及退出点流行度,获取神经网络子模型,并定义四元组描述神经网络子模型;

30、子模型定义模块,用于根据所述神经网络子模型,定义推理时延,定义优化目标;

31、建模模块,用于根据所述优化目标,将神经网络子模型缓存问题建模为0-1背包问题,定义0-1背包问题中的物品、重量和价值;

32、缓存模块,用于根据所述物品、重量和价值,基于动态规划算法的模型缓存算法,计算子模型的缓存决策。

33、优选地,所述缓存模块包括:

34、输入模块,用于将子模型li,j的参数量子模型li,j的计算密度ωi,j,用户的请求概率pi,j,云到边的传输数据率rce,缓存空间的大小c作为输入;

35、初始化模块,用于初始化每个子模型的缓存变量、不同缓存空间的缓存决策;

36、决策模块,用于对不同的缓存空间从小到大开始决策;

37、输出模块,用于输出子模型的缓存决策矩阵xi,j。

38、为了解决上述技术问题,本发明还提供一种计算机设备,采用了如下所述的技术方案,包括存储器和处理器,所述存储器中存储有计算机可读指令,所述处理器执行所述计算机可读指令时实现上述的基于退出点流行度的模型缓存方法的步骤。

39、为了解决上述技术问题,本发明还提供一种计算机可读存储介质,采用了如下所述的技术方案,所述计算机可读存储介质上存储有计算机可读指令,所述计算机可读指令被处理器执行时实现上述的基于退出点流行度的模型缓存方法的步骤。

40、与现有技术相比,本发明主要有以下有益效果:首先获取神经网络完整模型、退出点及退出点流行度;再由神经网络完整模型、退出点及退出点流行度,获取神经网络子模型,并定义四元组描述神经网络子模型;然后根据神经网络子模型,定义推理时延,定义优化目标;再根据优化目标,将神经网络子模型缓存问题建模为0-1背包问题,定义0-1背包问题中的物品、重量和价值;最后根据物品、重量和价值,基于动态规划算法的模型缓存算法,计算子模型的缓存决策,利用提前退出机制将模型分割为多个子模型,根据退出点流行度、子模型特征(四元组所定义的内容)和边缘服务器的缓存空间进行模型缓存,通过缓存子模型而非完整模型,提高网络资源利用率,降低推理时延,避免模型的重复传输,实现用户的低时延推理。

- 还没有人留言评论。精彩留言会获得点赞!