一种企业可信度评估方法、装置、系统及存储介质与流程

本技术属于数据处理,尤其涉及一种企业可信度评估方法、装置、系统及存储介质。

背景技术:

1、在产业园区管理者对产业链下企业评估的场景中,可信度评估仍然是一个关键挑战。不准确的可信度评估可能会对园区的稳定性造成威胁,对园区经济产生负面影响,并影响园区内其他企业。

2、通常情况下,企业的可信度评估数据集中,低可信度企业的样本数量远远小于正常可信度企业的样本数量,这种不平衡的数据分布可能会导致模型的预测结果严重偏向正常可信度企业类别。为了解决这种问题,目前存在三种主要的方法,尽管这些方法在一定程度上解决了数据不平衡问题,但它们也存在以下局限性:

3、(1)对数据进行预处理,通过消除多数类样本和增加少数类样本缓解数据不平衡的情况。但由于数据量差异过大,删除的多数类别样本会出现信息丢失使模型无法训练时无法利用已有信息,而增加的少数类样本由于其原始数据的有限性,会出现缺乏多样性的情况,容易造成模型的过拟合。

4、(2)通过特征工程和选择获得数据之间的隐藏特征。可以通过将现有特征进行组合或变换,创造新的特征,有助于更好地区分不同类别的样本。或者使用特征选择方法,选择最具区分度的特征,从而减少不平衡数据带来的干扰。然而特征工程在处理不平衡的数据时易出现模型难以收敛,过度关注学习噪声信息等问题。

5、(3)集成学习,通过集成多个弱分类器将其组为强分类器来避免单个分类器对不平衡数据分类产生的错误。但其是黑盒模型,难以对结果进行合理解释,需要结合前两种方法进行近一步优化。

技术实现思路

1、本技术的目的,在于提供一种企业可信度评估方法、装置、系统及存储介质,基于生成式对抗网络ds-gan和深度神经网络解决现有技术中企业可信度评估数据集数据不平衡的问题。

2、为了达成上述目的,本技术的解决方案是:

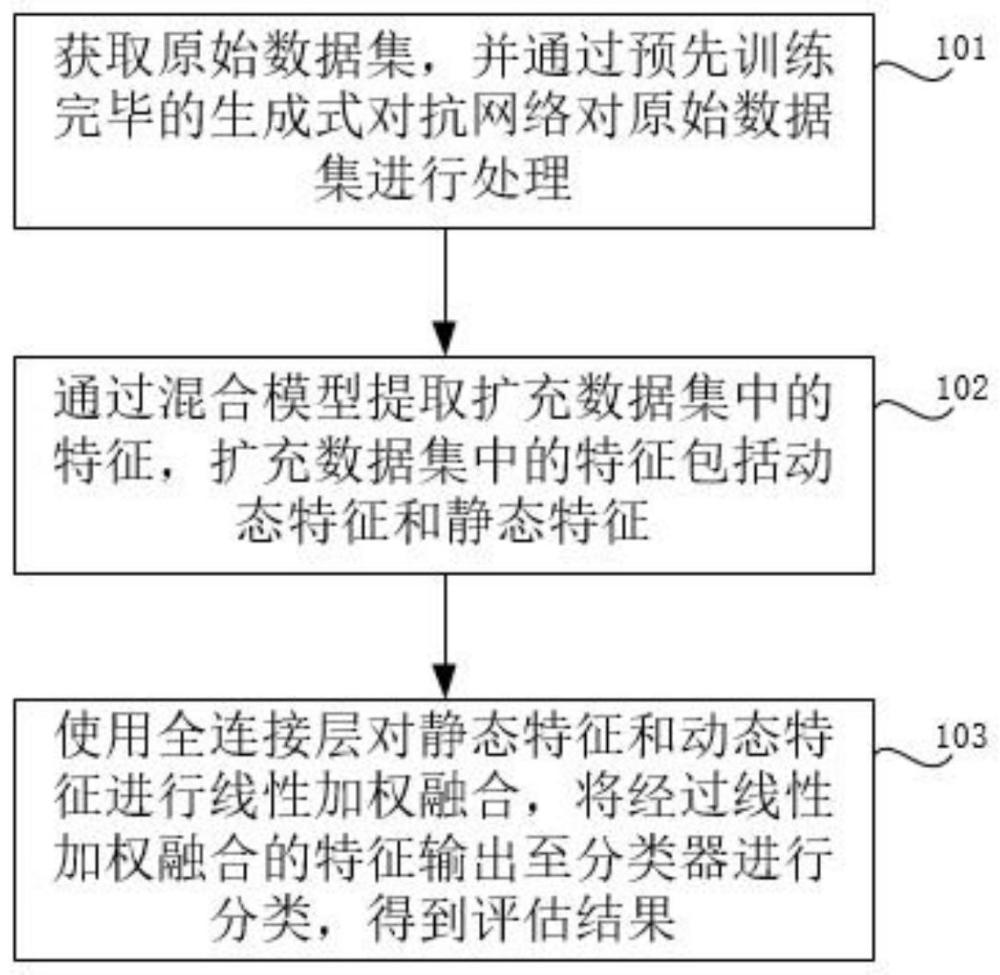

3、第一方面,本技术实施例提供一种企业可信度评估方法,包括:

4、获取原始数据集,并通过预先训练完毕的生成式对抗网络ds-gan对原始数据集进行处理,处理方法包括对原始数据集中的不平衡数据进行扩充处理,得到扩充数据集;

5、通过cnn-lstm混合模型提取扩充数据集中的特征,扩充数据集中的特征包括动态特征和静态特征,提取方法包括:通过cnn-lstm混合模型中的cnn提取静态特征,通过cnn-lstm混合模型中的lstm提取动态特征;

6、使用全连接层对静态特征和动态特征进行线性加权融合,将经过线性加权融合的特征输出至分类器进行分类,得到评估结果。

7、根据本技术实施例的上述方法,还可以具有以下附加技术特征:

8、进一步的,通过预先训练完毕的生成式对抗网络ds-gan对原始数据集进行处理,其中生成式对抗网络ds-gan的训练方法包括:

9、创建生成器g(·)和判别器d(·);

10、初始化生成器g(·)的权重参数θg和判别器d(·)的权重参数θd;

11、向生成器g(·)中输入随机噪声n和条件c,其中n=(n1,n2,...,nm);

12、输出与原始数据集分布类似的扩充数据集xnew=(x1,x2,...,xm);

13、计算交叉层crossn与隐藏层hn的输出,公式如下所示:

14、

15、hn=wnxn-1+bn

16、其中,wn-1表示第n-1项的权重;wn表示第n项的权重;bn-1表示第n-1项的偏差值;bn表示第n项的偏差值;xn-1表示扩充数据集中的第n-1项;x0表示原始输入;表示扩充数据集中第n-1项的转置;

17、将交叉层crossn与隐藏层hn的输出线性融合后输入判别器d(·);

18、判别器d(·)输出数据真实虚假概率和预测分类结果

19、采用梯度上升的方法更新判别器d(·)的权重参数θd,使判别器d(·)的损失函数达到最大值,公式如下所示:

20、lossd=ex~p(x)[d(x)]-en~p(n)·[d(g(n|c))]-lossgp+lossac

21、

22、其中,ex~p(x)表示原始数据集分布的期望函数;en~p(n)表示噪声数据分布的期望函数;lossgp表示梯度惩罚函数,lossac表示二值交叉熵损失;η表示学习率,表示梯度;

23、采用梯度下降的方法更新生成器g(·)的权重参数θg,使生成器g(·)的损失函数达到最小值,公式如下所示:

24、lossg=lossac-en~p(n)·[d(g(n|c))]

25、训练生成式对抗网络ds-gan直至达到纳什平衡。

26、进一步的,在将原始数据集输入判别器d(·)之前,通过交叉层计算特征之间的关联性。

27、进一步的,判别器d(·)包括一个辅助分类器,生成式对抗网络ds-gan的输入包括随机噪声n和条件c,辅助分类器用于输出分类结果将分类结果与条件c进行二值交叉熵损失计算并将计算结果进行反向传播。

28、进一步的,采用wasserstain距离测量扩充数据集分布与原始数据集分布之间的差异,利用参数数值约束最小化生成数据分布与真实数据分布的距离。

29、进一步的,在cnn-lstm混合模型中引入注意力机制,注意力机制包括空间注意力机制和时间注意力机制,其中空间注意力机制的公式如下所示:

30、ms(x)=σ(f([avgpool(x);maxpool(x)]))

31、其中,x表示特征,maxpool表示池化层,avgpool表示全局平均池化层,f表示一维卷积,σ表示sigmoid函数;

32、时间注意力机制的公式如下所示:

33、

34、ai=softmax(ui)

35、ui=tanh(whi+b)

36、其中,hi表示lstm在时间i的输出,b表示偏差,w表示权重矩阵,t表示输入序列长度,ai表示时间i输出的权重,ui表示上下文向量。

37、第二方面,本技术实施例提供一种企业可信度评估装置,包括:

38、数据获取模块,被配置为用于获取原始数据集;

39、数据处理模块,被配置为用于通过预先训练完毕的生成式对抗网络ds-gan对原始数据集进行处理,得到扩充数据集;通过cnn-lstm混合模型提取扩充数据集中的特征;

40、企业评估模块,被配置为用于基于分类算法对静态特征和动态特征进行线性加权融合,得到评估结果。

41、进一步的,装置还包括网络训练模块,被配置为用于对生成式对抗网络ds-gan进行训练,包括:

42、创建生成器g(·)和判别器d(·);

43、初始化生成器g(·)的权重参数θg和判别器d(·)的权重参数θd;

44、向生成器g(·)中输入随机噪声n和条件c,其中n=(n1,n2,...,nm);

45、输出与原始数据集分布类似的扩充数据集xnew=(x1,x2,...,xm);

46、计算交叉层crossn与隐藏层hn的输出,公式如下所示:

47、

48、hn=wnxn-1+bn

49、其中,wn-1表示第n-1项的权重;wn表示第n项的权重;bn-1表示第n-1项的偏差值;bn表示第n项的偏差值;xn-1表示扩充数据集中的第n-1项;x0表示原始输入;表示扩充数据集中第n-1项的转置;

50、将交叉层crossn与隐藏层hn的输出线性融合后输入判别器d(·);

51、判别器d(·)输出数据真实虚假概率和预测分类结果

52、采用梯度上升的方法更新判别器d(·)的权重参数θd,使判别器d(·)的损失函数达到最大值,公式如下所示:

53、lossd=ex~p(x)[d(x)]-en~p(n)·[d(g(n|c))]-lossgp+lossac

54、

55、其中,ex~p(x)表示原始数据集分布的期望函数;en~p(n)表示噪声数据分布的期望函数;lossgp表示梯度惩罚函数,lossac表示二值交叉熵损失;η表示学习率,表示梯度;

56、采用梯度下降的方法更新生成器g(·)的权重参数θg,使生成器g(·)的损失函数达到最小值,公式如下所示:

57、lossg=lossac-en~p(n)·[d(g(n|c))]

58、训练生成式对抗网络ds-gan直至达到纳什平衡。

59、第三方面,本技术实施例提供了一种企业可信度评估系统,系统包括处理器和存储器,存储器中存储有计算机程序,计算机程序由处理器加载并执行,以实现如本技术实施例第一方面提供的企业可信度评估方法。

60、第四方面,本技术实施例提供了一种计算机可读存储介质,存储介质中存储有计算机程序,计算机程序被处理器执行时,用于实现如本技术实施例第一方面的企业可信度评估方法。

61、采用本技术实施例提供的企业可信度评估方法,与现有技术相比,具有如下有益技术效果:

62、本技术实施例提供了一种生成式对抗网络ds-gan用于企业可信度评估数据生成,以应对可信度评估领域的数据不平衡问题。通过比较不同的不平衡数据样本生成算法,本技术实施例的生成式对抗网络ds-gan在模型训练的收敛速度和分类效果方面更有优势。在这个基础上,本技术实施例提出了一个基于cnn和lstm的融合深度神经网络可信度评分框架。cnn-lstm混合模型将特征输入分为静态维度和动态维度,通过cnn从静态数据中提取静态特征,然后使用lstm来捕捉用户操作行为的时间依赖性。为了更好地处理表格数据和时间序列数据,本技术实施例还引入了时空注意力模块,它可以为不同区域的数据分配不同的权重,以关注重要区域的细节信息。本技术实施例在召回率、f1值、auc值以及ks值等评价指标上都取得了显著的提升。解决了企业可信度评估中的数据不平衡问题,提高了模型的性能和预测准确性。

- 还没有人留言评论。精彩留言会获得点赞!