可信任的压缩感知和混洗的差分隐私联邦学习方法

本发明涉及联邦学习,具体涉及一种可信任的压缩感知和混洗的差分隐私联邦学习方法。

背景技术:

1、随着大数据、移动互联网和人工智能技术的快速发展,许多组织和机构面临着处理海量数据的挑战,而数据隐私保护也是它们所面临的另一个重要问题。数据孤岛问题是其中的一种表现,指的是不同机构或个人所拥有的数据存在着隔阂,无法进行有效的数据交互和数据共享的现象。这种情况导致数据难以进行跨机构、跨领域的整合和分析。

2、为了解决这一问题,联邦学习应运而生。联邦学习是一种机器学习方式,允许多个参与方在不共享原始数据的情况下协作训练模型。相反,每个参与方使用自己的数据训练本地模型,然后只共享模型更新到中央服务器或网络中的其他参与方。这种方法特别适用于数据敏感或分布在多个位置的情况,因为它允许参与方在保持对自己数据控制的同时,从网络的集体知识中受益。联邦学习已被应用于各种领域,包括医疗保健、金融和电信,并有可能改变机器学习的实践方式。

3、但是在现有技术中,联邦学习中仍然存在其他隐私安全问题,如梯度泄露。因为在联邦学习中,每个参与方都会计算梯度并将其共享给其他参与方,以便进行全局模型的更新;但由于梯度包含了一定的隐私信息,攻击者可以通过分析梯度来推断出原始数据,从而破坏隐私保护。

4、为了解决这一问题,现有技术提出了各种方法,如差分隐私、安全多方计算、同态加密等,以保护联邦学习中的隐私安全。其中,差分隐私是最常用的隐私保护技术之一,已经被广泛应用于联邦学习中。差分隐私主要分为中心化差分隐私和本地差分隐私两种形式。相比于中心化差分隐私,本地差分隐私更为去中心化,不需要可信的服务器作为中心节点进行隐私保护。在本地差分隐私中,参与者在本地对自己的数据进行加噪或扰动,使得数据变得模糊化,从而保护数据的隐私性。同时,本地差分隐私还具有良好的灵活性和可扩展性,适用于不同的数据处理场景和应用领域。

5、但是,对于常用的高斯噪声、拉普拉斯噪声等,由于噪声源服从随机分布,因此采样噪声是随机的,其大小是不可预测和不可控制的;这可能导致一些权重被过度扰动,会阻碍模型训练,损害模型的准确性。

技术实现思路

1、针对现有技术存在的不足,本发明提出一种可信任的压缩感知和混洗的差分隐私联邦学习方法,以解决现有技术中存在的在联邦学习过程中权重被过度扰动,阻碍模型训练、损害模型准确性的技术问题。

2、本发明采用的技术方案如下:

3、第一方面,提供了一种可信任的压缩感知和混洗的差分隐私联邦学习方法,包括:

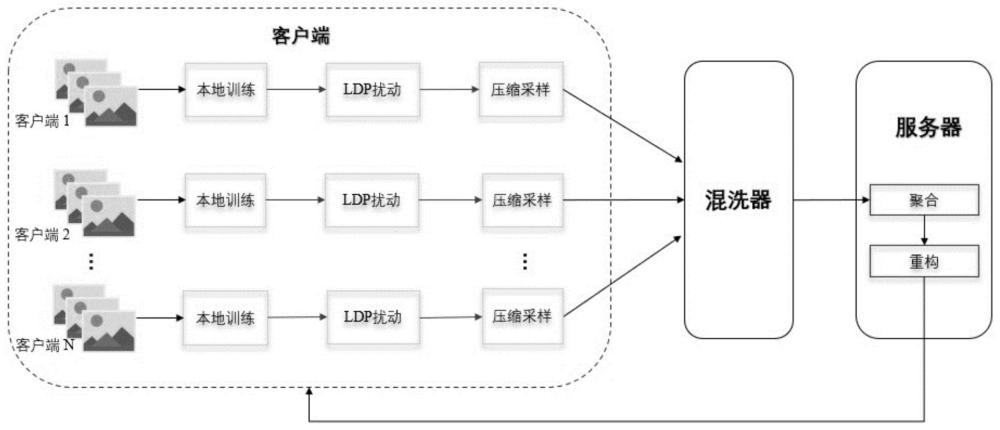

4、每个客户端根据自采样策略动态更新概率,根据概率独立随机决定是否参与该轮训练;参加该轮次训练的客户端结合本地数据集和上一轮的全局模型参数,对本地模型进行更新;客户端对更新后的本地模型参数进行自适应扰动,得到扰动后的本地模型参数更新值;对本地模型参数更新值进行压缩感知,得到压缩数据;将压缩数据发送给混洗器,混洗器将压缩数据进行混洗后上传至中心服务器;中心服务器对接收到的数据进行聚合,根据聚合后的数据对模型进行重构得到本轮训练的全局模型,再下发给相关客户端。

5、进一步的,根据自采样策略动态更新概率,包括:

6、客户端分别计算上一轮自己的模型参数与全局模型参数更新值之间的余弦相似性与曼哈顿距离;根据余弦相似性和曼哈顿距离动态更新概率。

7、进一步的,根据余弦相似性和曼哈顿距离,按以下方式动态更新概率:

8、

9、在上式中,cos表示余弦相似度,norm_dis表示归一化的曼哈顿距离。

10、进一步的,参加该轮次训练的客户端结合本地数据集和上一轮的全局模型参数,对本地模型进行更新,包括:

11、客户端对本地的数据集进行二次采样,得到子数据集;

12、基于子数据集以及当前梯度,执行梯度下降法得到更新后的本地模型。

13、进一步的,客户端对更新后的本地模型参数进行自适应扰动,包括:根据深度神经网络每层的模型权重变化范围,扰动局部模型参数。

14、进一步的,根据深度神经网络每层的模型权重变化范围,扰动局部模型参数,包括:

15、找到深度神经网络第l层的权重最大值maxl和最小值minl;

16、按下式计算中心cl和rl:

17、

18、rl=maxl-cl

19、计算w与中心cl的偏移量μ:

20、μ=w-cl

21、按下式对w进行扰动:

22、

23、其中,w*是扰动后的模型参数更新值,w.p.表示“以概率”;∈表示隐私预算。

24、进一步的,本地模型参数更新值进行压缩感知,包括:

25、对本地模型参数更新值进行topk稀疏化;

26、使用高斯随机矩阵对模型参数进行随机投影,得到压缩采样后的压缩数据。

27、进一步的,混洗器将压缩数据进行混洗后,先进行匿名化处理,再上传至中心服务器。

28、进一步的,中心服务器接收混洗器发送的数据,使用fedavg算法来更新全局模型;使用迭代硬阈值算法来进行模型重构。

29、第二方面,提供了一种电子设备,包括:

30、一个或多个处理器;

31、存储装置,用于存储一个或多个程序;

32、当一个或多个程序被一个或多个处理器执行,使得一个或多个处理器实现第一方面所提供的联邦学习方法。

33、由上述技术方案可知,本发明的有益技术效果如下:

34、可以在降低通信开销的同时保护用户隐私,有助于降低数据传输和通信成本,同时确保在跨多个客户端之间的模型协同训练过程中维持隐私的安全性和效率;特别适用于分布式大规模问题的解决,从而保护模型不受隐私威胁。

技术特征:

1.一种可信任的压缩感知和混洗的差分隐私联邦学习方法,其特征在于,包括:

2.根据权利要求1所述的联邦学习方法,其特征在于,根据自采样策略动态更新概率,包括:

3.根据权利要求2所述的联邦学习方法,其特征在于,根据余弦相似性和曼哈顿距离,按以下方式动态更新概率:

4.根据权利要求1所述的联邦学习方法,其特征在于,参加该轮次训练的客户端结合本地数据集和上一轮的全局模型参数,对本地模型进行更新,包括:

5.根据权利要求1所述的联邦学习方法,其特征在于,客户端对更新后的本地模型参数进行自适应扰动,包括:根据深度神经网络每层的模型权重变化范围,扰动局部模型参数。

6.根据权利要求5所述的联邦学习方法,其特征在于,根据深度神经网络每层的模型权重变化范围,扰动局部模型参数,包括:

7.根据权利要求1所述的联邦学习方法,其特征在于,对所述本地模型参数更新值进行压缩感知,包括:

8.根据权利要求1所述的联邦学习方法,其特征在于,混洗器将压缩数据进行混洗后,先进行匿名化处理,再上传至中心服务器。

9.根据权利要求1所述的联邦学习方法,其特征在于,中心服务器接收混洗器发送的数据,使用fedavg算法来更新全局模型;使用迭代硬阈值算法来进行模型重构。

10.一种电子设备,其特征在于,包括:

技术总结

本发明提供一种可信任的压缩感知和混洗的差分隐私联邦学习方法,包括:每个客户端根据自采样策略动态更新概率,根据概率独立随机决定是否参与该轮训练;参加该轮次训练的客户端结合本地数据集和上一轮的全局模型参数,对本地模型进行更新;客户端对更新后的本地模型参数进行自适应扰动,得到扰动后的本地模型参数更新值;对本地模型参数更新值进行压缩感知,得到压缩数据;将压缩数据发送给混洗器,混洗器将压缩数据进行混洗后上传至中心服务器;中心服务器对接收到的数据进行聚合,根据聚合后的数据对模型进行重构得到本轮训练的全局模型,再下发给相关客户端。本发明可以在降低通信开销的同时保护用户隐私,特别适用于解决分布式大规模问题。

技术研发人员:肖迪,李浩伟,李敏

受保护的技术使用者:重庆大学

技术研发日:

技术公布日:2024/3/11

- 还没有人留言评论。精彩留言会获得点赞!