一种基于动作边界预测的中学理化生实验动作检测方法

本发明涉及一种基于动作边界预测的中学理化生实验动作检测方法,属于视频理解中的时序动作定位。

背景技术:

1、随着人工智能技术的不断发展,其在教育领域的应用也越来越广泛。传统的中学理化生实验考试需要老师亲自批改学生的实验报告,这不仅费时费力,而且还存在主观因素。为了契合以创新技术促进教育智能化转型的趋势,推出ai赋能理化生实验操作考试解决方案,构建教育细分领域落地新场景,这种智能评分系统则可以通过人工智能技术对学生的实验报告进行自动评分,不仅可以提高评分的准确性,还可以节省老师的时间和精力。

2、时序动作检测可以看作由两个子任务组成,一个子任务是预测动作的起止时序区间,另一个子任务是预测动作的类别。由于动作识别领域经过近年来的发展,预测动作类别的算法逐渐成熟,因此时序动作定位的关键是预测动作的起止时序区间。

3、当前动作定位及分类技术,传统方法有聚类、基于特征相似性等,这些方法通常依赖于手工设计的特征或规则,无法捕捉到复杂的视频场景和语义信息。

技术实现思路

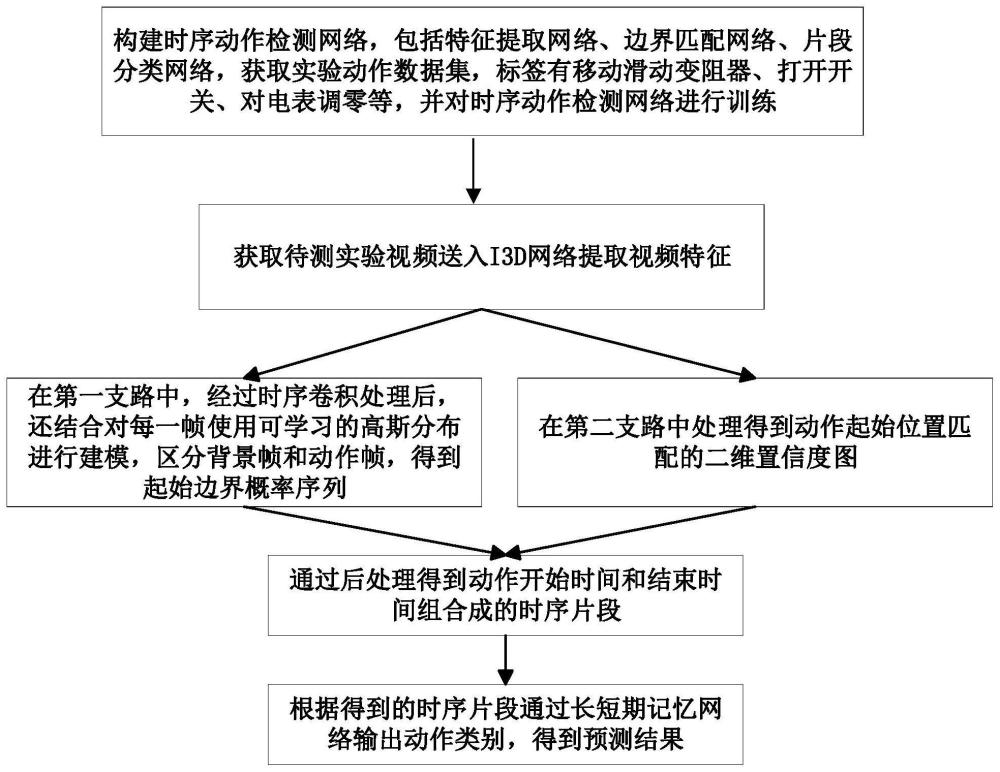

1、本发明主要研究在理化生实验智能考评系统中时序动作检测算法,旨在通过一定的技术手段去除视频中的冗余信息,并生成视频中关键动作片段。一方面在评分系统中可以提供关键技术支撑,将片段用在判分模块之前,节约运行时间,加快系统判分;另一方面可以通过这些生成关键动作作为摘要保留,便于后期用户审核,追溯复查,有效减少工作量。

2、目的:鉴于以上技术问题中的至少一项,本发提供一种基于动作边界预测的中学理化生实验动作检测方法。

3、本发明采用的技术方案为:

4、第一方面,本发明提供一种基于动作边界预测的中学理化生实验动作检测方法,包括:

5、获取待测实验视频;其中所述待测实验视频为包含有中学理化生实验动作的视频;

6、利用特征提取网络对所述待测实验视频进行特征提取得到视频特征;

7、利用边界匹配网络对所述视频特征进行边界匹配得到动作开始时间和结束时间组合成的时序片段;其中所述边界匹配网络包含两个支路,在第一支路中,经过时序卷积处理后,对每一帧使用可学习的高斯分布进行建模,区分背景帧和动作帧,得到起始边界概率序列;在第二支路中处理得到动作起始位置匹配的二维置信度图,将起始边界概率序列和动作起始位置匹配的二维置信度图通过后处理得到时序片段;

8、利用片段分类网络对所述时序片段进行分类,得到实验动作检测结果。

9、在一些实施例中,其中所述特征提取网络采用i3d网络、变速网络slowfast、稀疏时间采样网络tsn、或三维卷积网络c3d。

10、在一些实施例中,其中所述片段分类网络采用长短期记忆网络、图卷积网络或循环神经网络rnn。

11、利用特征提取网络对所述待测实验视频进行特征提取得到视频特征,包括:

12、对待测实验视频以每秒25帧进行处理,确定一个滑动窗口,滑动窗口对视频不重叠切分,得到图片;

13、每次输入16帧尺寸为c×c的图片经过特征提取网络i3d网络,得到输出的图像rgb特征;

14、通过引入l1范数利用光流估计算法得到相邻帧图像的光流,计算一个流场来估计两个连续图像帧中像素的运动,通过光流估计得到动作位于水平和垂直方向的光流效果,相叠加形成光流图,最终输出结果为光流特征;

15、将图像rgb特征和光流特征进行特征融合,得到视频特征。

16、进一步地,在一些实施例中,每次输入16帧尺寸为c×c的图片经过特征提取网络i3d网络,得到输出的图像rgb特征,具体包括:每次输入16帧图片进行一次7×7×7的三维卷积和一个1×3×3的最大池化,输出第一层特征图n1;将第一层特征图n1再进行一个1×1×1的三维卷积和一个3×3×3的三维卷积后,进行降采样后得到第二层特征图n2;将第二层特征图n2经过两个残差模块后再进行一个3×3×3最大池化,得到第三层特征图n3;将第三层特征图n3经过5个相同的残差模块,进行步长为2的降采样,得到最后输出图像rgb特征;其中所述残差模块包括四个支路,残差模块的四个支路都是以上一个模块的输出作为输入,第一支路经过一个1×1×1的三维卷积,第二支路和第三支路都经过一个1×1×1和一个3×3×3的三维卷积,第四支路先进行一个3×3×3最大池化降采样后,再进行1×1×1的三维卷积,最后将这四个支路的输出进行特征融合后,进行步长为2的降采样。

17、在一些实施例中,其中通过全变分算法得到相邻帧图像的光流,构造如下目标函数:

18、

19、其中x表示图像任一像素点的位置,i0(x)表示前一帧图像在像素点x位置上的图像强度值,u1(x)表示前一帧图像在像素点x位置上光流的位移,u2(x)表示后一帧图像在像素点x位置上光流的位移,i1(x+u(x))表示后一帧图在像素点x+u(x)位置上的图像强度值,为计算梯度的哈密顿算子,前一项表示获得平滑位移的正则项,λ为用来控制正则化影响的权重系数,第二项∫ω(i1(x+u(x))-i0(x))2dω为光流约束的数据项;

20、通过向目标函数中添加正则化,使得学习得到的结果满足稀疏化,最后迭代得到动作位于水平和垂直方向的光流效果,相叠加形成光流图,最终输出结果为光流特征。

21、在一些实施例中,利用边界匹配网络对所述视频特征进行边界匹配得到动作开始时间和结束时间组合成的时序片段,包括:

22、将视频特征输入到两个3×3、步长为1的卷积层,处理得到时序特征序列,分别输入两个分支;

23、时序特征序列经过第一分支处理,即两个3×3的卷积层和最大池化后,再进行深度为2的归一化,并在第一分支引入动作重要性对比学习,即结合对每一帧使用可学习的高斯分布进行建模,区分背景帧和动作帧根据动作重要程度调整每个帧在训练中的权重,最后输出起始边界概率序列,即开始概率序列和结束概率序列;

24、时序特征序列经过第二分支处理,先经过一个边界匹配层,确定一个大小为16的滑动窗口,用t表示样本最大的片段长度,从输入的时序特征序列在其时序范围内均匀采样n个点,构成一张n×t的掩码权重,得到对于第n个采样点的从时序特征序列生成c×t的时序特征图,其中n是在一段视频中的采样点个数,其中c是特征的维度数;根据采样点对应的权重矩阵,与c×t的时序特征图加权,计算生成一张c×n的特征图;

25、将c×n的特征图进行32×1×1的三维卷积,将特征维数降到1,再进行1×1和3×3的卷积后,通过sigmoid函数激活生成通道维度为2的置信度,得到最终输出的动作起始位置匹配的二维置信度图,所述二维置信度图中分布在同一行的片段拥有相同的持续长度,分布在同一列的拥有相同的开始边界;

26、将起始边界概率序列和动作起始位置匹配的二维置信度图,进行相乘融合,生成每个动作片段的置信度;

27、根据动作片段的置信度,采用非极大抑制方法来去除冗余,得到最终候选的动作片段,形成时序片段。

28、进一步地,在第一分支引入动作重要性对比学习,具体包括:

29、利用一个可学习的高斯分布来建模动作重要性,明确地分配类高斯权重来模拟动作定位的准确度;针对每帧的动作重要性ploc建模为:

30、

31、其中,来模拟第i帧起始时间定位准确度,来模拟第i帧结束时间定位准确度;

32、

33、

34、其中,μs和σs为可学习的参数,表示每个类别c在起始时间的动作重要程度分布的均值和方差,μe和σe为每个类别c在结束时间的动作重要程度分布的均值和方差,d(i)表示训练过程中从当前第i帧的真实标注片段的中心点的距离;

35、通过上述建模学习得到帧的重要性序列;

36、将重要性序列与时序特征序列进行累加融合,得到起始边界概率序列。

37、进一步地,将起始边界概率序列和动作起始位置匹配的二维置信度图,进行相乘融合,生成每个动作片段的置信度pf,包括:

38、

39、其中,ts表示动作片段的开始时刻,te表示动作片段的结束时刻,为动作片段在开始时刻ts的概率,为动作片段在结束时刻te的概率,pcc为分类置信度,pcr为回归置信度。

40、进一步地,根据动作片段的置信度,采用非极大抑制方法来去除冗余,得到最终候选的动作片段,包括:

41、在每次取出置信度最大的动作片段后,计算此动作片段的起始位置与其他动作片段的重合程度,若重合程度超过阈值则去除,得到最终候选的动作片段,其中所述动作片段包括动作开始时间、动作结束时间以及置信度。

42、在一些实施例中,所述片段分类网络采用长短期记忆网络,则利用片段分类网络对所述时序片段进行分类,包括:

43、将时序片段输入长短期记忆网络,此时刻为t,输入特征向量为nt,由三个门控机制和细胞记忆单元实现对信息的更新与保留,其中三个门控包括遗忘门、输入门与输出门;

44、将上一时刻t-1的输出特征向量ht-1和输入特征向量nt进行拼接,形成特征矩阵m输入到遗忘门,此时得到通过遗忘门的输出状态信息向量ft;

45、ft=σ(wf*m+bf)

46、其中,wf、bf分别表示遗忘门的权重矩阵和偏置值向量,σ表示sigmoid激活函数;

47、将特征矩阵m输入到输入门,通过输入门后得到输出状态信息矩阵fi,同时得到未更新的细胞状态向量

48、fi=σ(wi*m+bi)

49、

50、其中,wi、bi分别表示输入门的权重矩阵和偏置值向量,wc、bc分别表示细胞记忆单元的权重矩阵和偏置值向量,tanh表示tanh激活函数;

51、基于未更新的细胞状态向量将状态信息向量ft和fi,进行更新存储,得到细胞更新向量ct;

52、

53、其中,ct-1为上一时刻t-1的细胞更新向量;

54、将细胞更新向量ct通过输出门后,决定当前的ct中的有效信息输出向量ht,表达式如下:

55、ht=σ(wo*m+bo)*tanh(ct)

56、其中,wo、bo分别表示输出门的权重矩阵和偏置值向量;

57、将有效信息输出向量ht通过全连接层,进行片段的类别预测,生成实验动作检测结果。

58、第二方面,本发明提供了一种基于动作边界预测的中学理化生实验动作检测装置,包括处理器及存储介质;

59、所述存储介质用于存储指令;

60、所述处理器用于根据所述指令进行操作以执行根据第一方面所述的方法。

61、第三方面,本发明提供了一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现第一方面所述的方法。

62、第四方面,本发明提供了一种设备,包括,

63、存储器;

64、处理器;

65、以及

66、计算机程序;

67、其中,所述计算机程序存储在所述存储器中,并被配置为由所述处理器执行以实现上述第一方面所述的方法。

68、本发明的有益效果是:

69、(1)本技术的应用场景是基于中学理化实验视频中关键动作检测,采用先进行时序动作定位生成片段,再进行动作片段识别的两阶段式方法,具有更高的动作片段识别准确度。

70、(2)在未剪辑的视频中有大量的背景片段,检测难度大,难以准确定位动作,本技术建立在全监督数据集进行训练的前提下,提出动作重要性学习,对于每一帧的动作重要程度进行建模,并将学习到的权重应用于损失函数中,在此基础上每一帧的损失函数前再乘以学习到的动作重要度,以促进模型更关注重要的帧,从而更好的训练。

- 还没有人留言评论。精彩留言会获得点赞!