标签生成模型的训练、标签生成方法、装置及存储介质与流程

本公开涉及计算机,尤其涉及一种标签生成模型的训练、标签生成方法、装置及存储介质。

背景技术:

1、现有的短视频推荐领域中的相关研究主要依赖基于规则的策略进行标签生成。某些方法专注于将用户反馈,如观看时长,转化为新的语义标签,以捕捉用户偏好的隐藏信号。例如,比较用户观看时长和视频时长构造完播标签表示用户是否完全观看视频。其他方法试图建立规则来优化原始反馈,重点在于消除标签中的偏差。例如,先根据视频时长对数据分组,之后每组分别生成基于分位点的标签。

2、虽然现有的标签生成的工作能够一定程度上提取用户喜好信息,并取得了不错的效果,但它们存在如下所述缺点:

3、(1)标签的生成依赖于手动规则,有效生成规则的设计需要耗费大量人力成本。

4、(2)标签的生成不能保证与平台目标对齐,推荐模型拟合标签后难以保证多个平台目标的全面提升,可能导致在某个目标如用户满意度的性能下降。

技术实现思路

1、本公开提供一种标签生成模型的训练、标签生成方法、装置及存储介质,以至少解决相关技术中标签的生成效率低下的问题。本公开的技术方案如下:

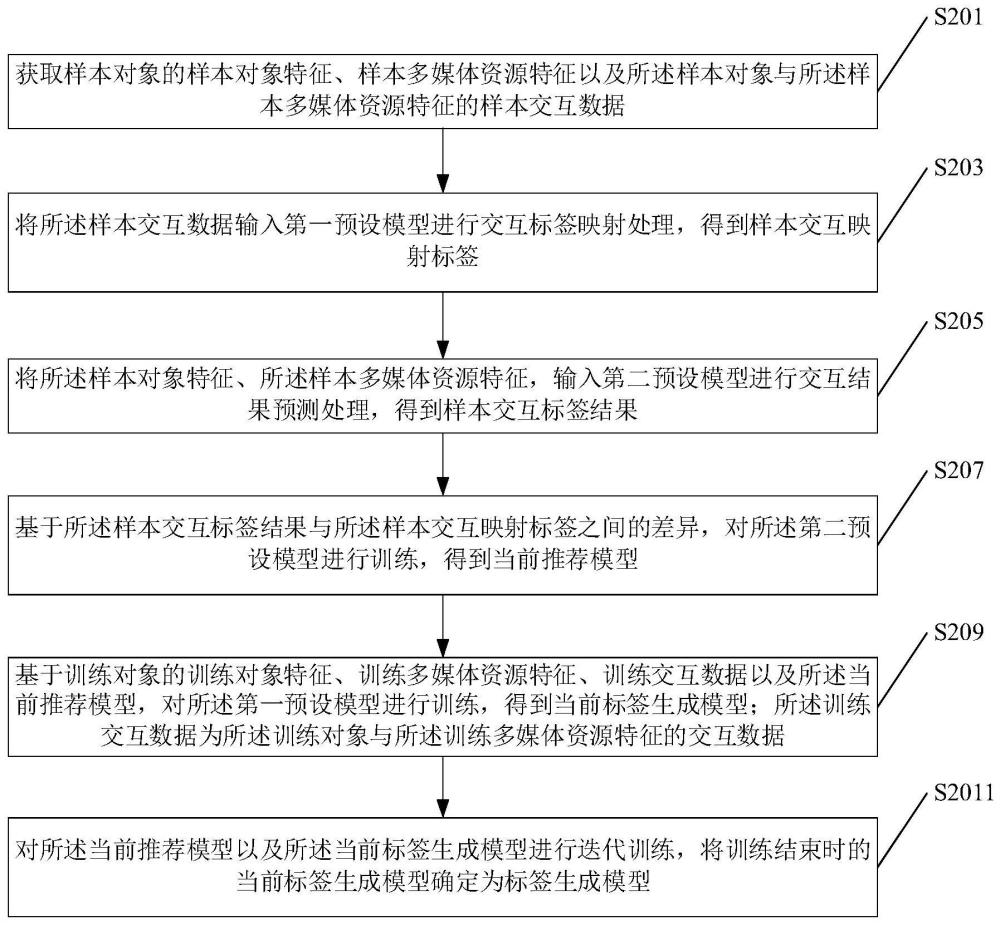

2、根据本公开实施例的第一方面,提供一种标签生成模型的训练方法,包括:

3、获取样本对象的样本对象特征、样本多媒体资源特征以及所述样本对象与所述样本多媒体资源特征的样本交互数据;

4、将所述样本交互数据输入第一预设模型进行交互标签映射处理,得到样本交互映射标签;

5、将所述样本对象特征、所述样本多媒体资源特征,输入第二预设模型进行交互结果预测处理,得到样本交互标签结果;

6、基于所述样本交互标签结果与所述样本交互映射标签之间的差异,对所述第二预设模型进行训练,得到当前推荐模型;

7、基于训练对象的训练对象特征、训练多媒体资源特征、训练交互数据以及所述当前推荐模型,对所述第一预设模型进行训练,得到当前标签生成模型;所述训练交互数据为所述训练对象与所述训练多媒体资源特征的交互数据;所述训练对象与所述样本对象为同一类型的对象,所述训练对象特征与所述样本对象特征为同一类型的特征,所述训练多媒体资源特征与所述样本多媒体资源特征为同一类型的特征,所述训练交互数据与所述样本交互数据为同一类型的数据;

8、对所述当前推荐模型以及所述当前标签生成模型进行迭代训练,将训练结束时的当前标签生成模型确定为标签生成模型;所述迭代训练包括重复步骤:固定所述当前标签生成模型的模型参数对所述当前推荐模型进行训练以及固定所述当前推荐模型的模型参数对所述当前标签生成模型进行训练。

9、在一示例性的实施方式中,所述基于训练对象的训练对象特征、训练多媒体资源特征、训练交互数据以及所述当前推荐模型,对所述第一预设模型进行训练,得到当前标签生成模型,包括:

10、将所述训练对象特征以及所述训练多媒体资源特征,输入所述当前推荐模型进行交互结果预测处理,得到当前训练交互标签结果;

11、将所述训练交互数据输入所述第一预设模型进行交互标签映射处理,得到训练交互映射标签;

12、基于所述训练交互映射标签与所述当前训练交互标签结果之间的差异,对所述第一预设模型进行训练,得到所述当前标签生成模型。

13、在一示例性的实施方式中,所述对所述当前推荐模型以及所述当前标签生成模型进行迭代训练,将训练结束时的当前标签生成模型确定为标签生成模型,包括:

14、将所述样本交互数据输入所述当前标签生成模型进行交互标签映射处理,得到当前样本交互映射标签;

15、将所述样本对象特征、所述样本多媒体资源特征输入所述当前推荐模型进行交互结果预测处理,得到当前样本交互标签结果;

16、基于所述当前样本交互标签结果与所述当前样本交互映射标签之间的差异,对所述当前推荐模型进行训练,并将训练结束时的模型重新作为当前推荐模型;

17、将所述训练对象特征、所述训练多媒体资源特征,输入所述当前推荐模型进行交互结果预测处理,得到当前训练交互标签结果;

18、基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,得到所述标签生成模型。

19、在一示例性的实施方式中,所述基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,得到所述标签生成模型,包括:

20、基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,并将训练结束时的模型重新作为当前标签生成模型;

21、重复所述将所述样本交互数据输入所述当前标签生成模型进行交互标签映射处理,得到当前样本交互映射标签,至所述基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,并将训练结束时的模型重新作为当前标签生成模型的步骤直至满足训练结束条件;

22、将训练结束时的当前推荐模型确定为所述推荐模型,将训练结束时的当前标签生成模型确定为所述标签生成模型。

23、在一示例性的实施方式中,所述样本交互数据包括样本浏览信息、样本评价信息以及样本留存率信息中的至少一项,所述第一预设模型包括预设浏览时长标签预测模型、预设评价标签预测模型以及预设留存率标签预测模型中的至少一项,所述第一预设模型基于所述样本交互数据确定,所述将所述样本交互数据输入第一预设模型进行交互标签映射处理,得到样本交互映射标签,包括:

24、执行目标标签映射操作,所述目标标签映射操作包括第一标签映射操作、第二标签映射操作、第三标签映射操作中的至少一种;其中,所述第一标签映射操作为将所述样本浏览信息输入所述预设浏览时长标签映射模型,进行浏览时长标签映射处理,得到样本浏览时长标签;所述第二标签映射操作为将所述样本评价信息输入所述预设评价标签映射模型,进行评价标签映射处理,得到样本评价标签;所述第三标签映射操作为将所述样本留存率信息输入所述预设留存率标签映射模型,进行留存率标签映射处理,得到样本留存率标签;

25、将所述样本浏览时长标签、所述样本评价标签以及所述样本留存率标签中的至少一项确定为所述样本交互映射标签。

26、在一示例性的实施方式中,所述第二预设模型包括预设浏览时长预测模型、预设评价信息预测模型以及预设留存率预测模型中的至少一项,所述第二预设模型基于所述样本交互数据确定,所述将所述样本对象特征、所述样本多媒体资源特征,输入第二预设模型进行交互结果预测处理,得到样本交互标签结果,包括:

27、执行目标结果预测操作,所述目标结果预测操作包括第一结果预测操作、第二结果预测操作、第三结果预测操作中的至少一种;其中,所述第一结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设浏览时长预测模型进行浏览时长预测处理,得到样本浏览时长结果;所述第二结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设评价信息预测模型进行评价信息预测处理,得到样本评价信息结果;所述第三结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设留存率预测模型进行留存率预测处理,得到样本留存率结果;

28、将所述样本浏览时长结果、所述样本评价信息结果以及所述样本留存率结果中的至少一项,确定为所述样本交互标签结果;所述样本交互标签结果与所述样本交互映射标签的类型相同。

29、在一示例性的实施方式中,所述基于所述样本交互标签结果与所述样本交互映射标签之间的差异,对所述第二预设模型进行训练,得到当前推荐模型,包括:

30、执行目标损失确定操作;所述目标损失确定操作包括第一损失确定操作、第二损失确定操作、第三损失确定操作中的至少一项;其中,所述第一损失确定操作为基于所述样本浏览时长结果与所述样本浏览时长标签之间的差异,确定第一样本损失信息;所述第二损失确定操作为基于所述样本评价信息结果与所述样本评价标签之间的差异,确定第二样本损失信息;所述第三损失确定操作为基于所述样本留存率结果与所述样本留存率标签之间的差异,确定第三样本损失信息;

31、基于所述第一样本损失信息、所述第二样本损失信息、所述第三样本损失信息中的至少一项,确定目标样本损失信息;

32、基于所述目标样本损失信息调整所述第二预设模型的参数,得到当前推荐模型。

33、在一示例性的实施方式中,所述方法还包括:

34、执行获取所述样本浏览信息的第一权重、获取所述样本评价信息的第二权重、获取所述样本留存率信息的第三权重中的至少一项;

35、所述基于所述第一样本损失信息、所述第二样本损失信息以及所述第三样本损失信息中的至少一项,确定目标样本损失信息,包括:

36、执行根据所述第一权重与所述第一样本损失信息确定第一加权损失、根据所述第二权重与所述第二样本损失信息确定第二加权损失、根据所述第三权重与所述第三样本损失信息确定第三加权损失中的至少一项;

37、根据所述第一加权损失、所述第二加权损失、所述第二加权损失中的至少一项,确定目标样本损失信息。

38、在一示例性的实施方式中,所述当前推荐模型包括当前浏览时长预测模型、当前评价信息预测模型、当前留存率预测模型中的至少一个,所述将所述训练对象特征以及所述训练多媒体资源特征,输入所述当前推荐模型进行交互结果预测处理,得到当前训练交互标签结果,包括:

39、针对所述训练对象特征以及所述训练多媒体资源特征执行以下至少一项输入操作:

40、第一输入操作:输入所述当前浏览时长预测模型进行浏览时长预测处理,得到训练浏览时长结果;第二输入操作:输入所述当前评价信息预测模型进行评价信息预测处理,得到训练评价信息结果;第三输入操作:输入所述当前留存率预测模型进行留存率预测处理,得到训练留存率结果;

41、将所述训练浏览时长结果、所述训练评价信息结果、所述训练留存率结果中的至少一项,确定为所述训练交互标签结果。

42、在一示例性的实施方式中,所述训练交互数据包括训练浏览信息、训练评价信息、训练留存率信息中的至少一个,所述将所述训练交互数据输入所述第一预设模型进行交互标签映射处理,得到训练交互映射标签,包括:

43、执行训练标签预测操作;所述训练标签预测操作包括第一标签预测操作、第二标签预测操作、第三标签预测操作中的至少一项;其中,所述第一标签预测操作为将所述训练浏览信息输入预设浏览时长标签预测模型,进行浏览时长标签预测处理,得到训练浏览时长标签;所述第二标签预测操作为将所述训练评价信息输入预设评价标签预测模型,进行评价标签预测处理,得到训练评价标签;所述第三标签预测操作为将所述训练留存率信息输入预设留存率标签预测模型,进行留存率标签预测处理,得到训练留存率标签;

44、将所述训练浏览时长标签、所述训练评价标签以及所述训练留存率标签中的至少一项确定为所述训练交互映射标签。

45、在一示例性的实施方式中,所述基于所述训练交互映射标签与所述当前训练交互标签结果之间的差异,对所述第一预设模型进行训练,得到所述当前标签生成模型,包括:

46、执行目标训练损失确定操作;所述目标训练损失确定操作包括第一训练损失确定操作、第二训练损失确定操作、第三训练损失确定操作中的至少一项;其中,所述第一训练损失确定操作为基于所述训练浏览时长结果与所述训练浏览时长标签之间的差异,确定第一训练损失信息;所述第一训练损失确定操作为基于所述训练评价信息结果与所述训练评价标签之间的差异,确定第二训练损失信息;所述第三训练损失确定操作为基于所述训练留存率结果与所述训练留存率标签之间的差异,确定第三训练损失信息;

47、基于所述第一训练损失信息、所述第二训练损失信息、所述第三训练损失信息中的至少一项,确定目标训练损失信息;

48、基于所述目标训练损失信息对所述第一预设模型进行训练,得到所述当前标签生成模型。

49、根据本公开实施例的第二方面,提供一种标签生成方法,所述方法包括:

50、获取目标对象与目标多媒体资源特征的目标交互数据;

51、将所述目标交互数据输入标签生成模型进行交互标签映射处理,得到目标交互映射标签;其中,所述标签生成模型基于上述的训练方法训练得到。

52、根据本公开实施例的第三方面,提供一种标签生成模型的训练装置,包括:

53、样本数据获取模块,被配置为执行获取样本对象的样本对象特征、样本多媒体资源特征以及所述样本对象与所述样本多媒体资源特征的样本交互数据;

54、样本标签确定模块,被配置为执行将所述样本交互数据输入第一预设模型进行交互标签映射处理,得到样本交互映射标签;

55、样本交互标签结果确定模块,被配置为执行将所述样本对象特征、所述样本多媒体资源特征,输入第二预设模型进行交互结果预测处理,得到样本交互标签结果;

56、第一模型训练模块,被配置为执行基于所述样本交互标签结果与所述样本交互映射标签之间的差异,对所述第二预设模型进行训练,得到当前推荐模型;

57、第二模型训练模块,被配置为执行基于训练对象的训练对象特征、训练多媒体资源特征、训练交互数据以及所述当前推荐模型,对所述第一预设模型进行训练,得到当前标签生成模型;所述训练交互数据为所述训练对象与所述训练多媒体资源特征的交互数据;所述训练对象与所述样本对象为同一类型的对象,所述训练对象特征与所述样本对象特征为同一类型的特征,所述训练多媒体资源特征与所述样本多媒体资源特征为同一类型的特征,所述训练交互数据与所述样本交互数据为同一类型的数据;

58、模型生成模块,被配置为执行对所述当前推荐模型以及所述当前标签生成模型进行迭代训练,将训练结束时的当前标签生成模型确定为标签生成模型;所述迭代训练包括重复步骤:固定所述当前标签生成模型的模型参数对所述当前推荐模型进行训练以及固定所述当前推荐模型的模型参数对所述当前标签生成模型进行训练。

59、在一示例性的实施方式中,所述第二模型训练模块包括:

60、当前结果确定单元,被配置为执行将所述训练对象特征以及所述训练多媒体资源特征,输入所述当前推荐模型进行交互结果预测处理,得到当前训练交互标签结果;

61、训练标签确定单元,被配置为执行将所述训练交互数据输入所述第一预设模型进行交互标签映射处理,得到训练交互映射标签;

62、第一模型训练单元,被配置为执行基于所述训练交互映射标签与所述当前训练交互标签结果之间的差异,对所述第一预设模型进行训练,得到所述当前标签生成模型。

63、在一示例性的实施方式中,所述模型生成模块包括:

64、当前标签确定单元,被配置为执行将所述样本交互数据输入所述当前标签生成模型进行交互标签映射处理,得到当前样本交互映射标签;

65、当前推荐模型确定单元,被配置为执行将所述样本对象特征、所述样本多媒体资源特征输入所述当前推荐模型进行交互结果预测处理,得到当前样本交互标签结果;基于所述当前样本交互标签结果与所述当前样本交互映射标签之间的差异,对所述当前推荐模型进行训练,并将训练结束时的模型重新作为当前推荐模型;

66、当前预测结果确定单元,被配置为执行将所述训练对象特征、所述训练多媒体资源特征,输入所述当前推荐模型进行交互结果预测处理,得到当前训练交互标签结果;

67、标签生成单元,被配置为执行基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,得到所述标签生成模型。

68、在一示例性的实施方式中,所述标签生成单元包括:

69、训练单元,被配置为执行基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,并将训练结束时的模型重新作为当前标签生成模型;

70、重复单元,被配置为执行重复所述将所述样本交互数据输入所述当前标签生成模型进行交互标签映射处理,得到当前样本交互映射标签,至所述基于所述训练交互数据以及所述当前训练交互标签结果,对所述当前标签生成模型进行训练,并将训练结束时的模型重新作为当前标签生成模型的步骤直至满足训练结束条件;

71、模型生成单元,被配置为执行将训练结束时的当前推荐模型确定为所述推荐模型,将训练结束时的当前标签生成模型确定为所述标签生成模型。

72、在一示例性的实施方式中,所述样本交互数据包括样本浏览信息、样本评价信息以及样本留存率信息中的至少一项,所述第一预设模型包括预设浏览时长标签预测模型、预设评价标签预测模型以及预设留存率标签预测模型中的至少一项,所述第一预设模型基于所述样本交互数据确定,所述样本标签确定模块包括:

73、目标标签映射操作单元,被配置为执行目标标签映射操作,所述目标标签映射操作包括第一标签映射操作、第二标签映射操作、第三标签映射操作中的至少一种;其中,所述第一标签映射操作为将所述样本浏览信息输入所述预设浏览时长标签映射模型,进行浏览时长标签映射处理,得到样本浏览时长标签;所述第二标签映射操作为将所述样本评价信息输入所述预设评价标签映射模型,进行评价标签映射处理,得到样本评价标签;所述第三标签映射操作为将所述样本留存率信息输入所述预设留存率标签映射模型,进行留存率标签映射处理,得到样本留存率标签;

74、样本交互映射标签确定单元,被配置为执行将所述样本浏览时长标签、所述样本评价标签以及所述样本留存率标签中的至少一项,确定为所述样本交互映射标签。

75、在一示例性的实施方式中,所述第二预设模型包括预设浏览时长预测模型、预设评价信息预测模型以及预设留存率预测模型中的至少一项,所述第二预设模型基于所述样本交互数据确定,所述样本交互标签结果确定模块包括:

76、目标结果预测操作单元,被配置为执行目标结果预测操作,所述目标结果预测操作包括第一结果预测操作、第二结果预测操作、第三结果预测操作中的至少一种;其中,所述第一结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设浏览时长预测模型进行浏览时长预测处理,得到样本浏览时长结果;所述第二结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设评价信息预测模型进行评价信息预测处理,得到样本评价信息结果;所述第三结果预测操作为将所述样本对象特征以及所述样本多媒体资源特征,输入所述预设留存率预测模型进行留存率预测处理,得到样本留存率结果;

77、样本交互标签结果确定单元,被配置为执行将所述样本浏览时长结果、所述样本评价信息结果以及所述样本留存率结果,确定为所述样本交互标签结果。

78、在一示例性的实施方式中,所述第一模型训练模块包括:

79、目标损失确定操作单元,被配置为执行目标损失确定操作;所述目标损失确定操作包括第一损失确定操作、第二损失确定操作、第三损失确定操作中的至少一项;其中,所述第一损失确定操作为基于所述样本浏览时长结果与所述样本浏览时长标签之间的差异,确定第一样本损失信息;所述第二损失确定操作为基于所述样本评价信息结果与所述样本评价标签之间的差异,确定第二样本损失信息;所述第三损失确定操作为基于所述样本留存率结果与所述样本留存率标签之间的差异,确定第三样本损失信息;

80、目标样本损失信息确定单元,被配置为执行基于所述第一样本损失信息、所述第二样本损失信息以及所述第三样本损失信息中的至少一项,确定目标样本损失信息;

81、当前推荐模型确定单元,被配置为执行基于所述目标样本损失信息调整所述第二预设模型的参数,得到当前推荐模型。

82、在一示例性的实施方式中,所述装置还包括:

83、权重获取单元,被配置为执行执行获取所述样本浏览信息的第一权重、获取所述样本评价信息的第二权重、获取所述样本留存率信息的第三权重中的至少一项;

84、相应的,所述目标样本损失信息确定单元包括:

85、损失确定单元,被配置为执行执行根据所述第一权重与所述第一样本损失信息确定第一加权损失、根据所述第二权重与所述第二样本损失信息确定第二加权损失、根据所述第三权重与所述第三样本损失信息确定第三加权损失中的至少一项;

86、目标损失确定单元,被配置为执行根据所述第一加权损失、所述第二加权损失、所述第三加权损失中的至少一项,确定目标样本损失信息。

87、在一示例性的实施方式中,所述当前推荐模型包括当前浏览时长预测模型、当前评价信息预测模型、当前留存率预测模型中的至少一个,所述当前结果确定单元包括:

88、训练结果确定子单元,被配置为针对所述训练对象特征以及所述训练多媒体资源特征执行以下至少一项输入操作:第一输入操作:输入所述当前浏览时长预测模型进行浏览时长预测处理,得到训练浏览时长结果;第二输入操作:输入所述当前评价信息预测模型进行评价信息预测处理,得到训练评价信息结果;第三输入操作:输入所述当前留存率预测模型进行留存率预测处理,得到训练留存率结果;

89、训练预测结果确定子单元,被配置为执行将所述训练浏览时长结果、所述训练评价信息结果以及所述训练留存率结果中的至少一项,确定为所述训练交互标签结果。

90、在一示例性的实施方式中,所述训练交互数据包括训练浏览信息、训练评价信息以及训练留存率信息中的至少一个,所述训练标签确定单元包括:

91、训练标签确定子单元,被配置为执行训练标签预测操作;所述训练标签预测操作包括第一标签预测操作、第二标签预测操作、第三标签预测操作中的至少一项;其中,所述第一标签预测操作为将所述训练浏览信息输入预设浏览时长标签预测模型,进行浏览时长标签预测处理,得到训练浏览时长标签;所述第二标签预测操作为将所述训练评价信息输入预设评价标签预测模型,进行评价标签预测处理,得到训练评价标签;所述第三标签预测操作为将所述训练留存率信息输入预设留存率标签预测模型,进行留存率标签预测处理,得到训练留存率标签;

92、训练交互映射标签确定子单元,被配置为执行将所述训练浏览时长标签、所述训练评价标签、所述训练留存率标签中的至少一项,确定为所述训练交互映射标签。

93、在一示例性的实施方式中,所述第一模型训练单元包括:

94、训练损失确定子单元,被配置为执行目标训练损失确定操作;所述目标训练损失确定操作包括第一训练损失确定操作、第二训练损失确定操作、第三训练损失确定操作中的至少一项;其中,所述第一训练损失确定操作为基于所述训练浏览时长结果与所述训练浏览时长标签之间的差异,确定第一训练损失信息;所述第一训练损失确定操作为基于所述训练评价信息结果与所述训练评价标签之间的差异,确定第二训练损失信息;所述第三训练损失确定操作为基于所述训练留存率结果与所述训练留存率标签之间的差异,确定第三训练损失信息;

95、目标训练损失信息确定子单元,被配置为执行基于所述第一训练损失信息、所述第二训练损失信息、所述第三训练损失信息中的至少一项,确定目标训练损失信息;

96、当前标签生成模型确定子单元,被配置为执行基于所述目标训练损失信息对所述第一预设模型进行训练,得到所述当前标签生成模型。

97、根据本公开实施例的第四方面,提供一种标签生成装置,所述装置包括:

98、目标数据获取模块,被配置为执行获取目标对象与目标多媒体资源特征的目标交互数据;

99、目标标签确定模块,被配置为执行将所述目标交互数据输入标签生成模型进行交互标签映射处理,得到目标交互映射标签;其中,所述标签生成模型基于上述的训练方法训练得到。

100、根据本公开实施例的第五方面,提供一种电子设备,包括:

101、处理器;

102、用于存储所述处理器可执行指令的存储器;

103、其中,所述处理器被配置为执行所述指令,以实现如上所述的标签生成模型的训练方法或标签生成方法。

104、根据本公开实施例的第六方面,提供一种计算机可读存储介质,当所述计算机可读存储介质中的指令由电子设备处理器执行时,使得电子设备能够执行如上所述的标签生成模型的训练方法或标签生成方法。

105、根据本公开实施例的第七方面,提供一种计算机程序产品,包括计算机程序,所述计算机程序被处理器执行时实现如上所述的标签生成模型的训练方法或标签生成方法。

106、本公开的实施例提供的技术方案至少带来以下有益效果:

107、本公开获取样本对象的样本对象特征、样本多媒体资源特征以及样本对象与样本多媒体资源特征的样本交互数据;将样本交互数据输入第一预设模型进行交互标签映射处理,得到样本交互映射标签;将样本对象特征、样本多媒体资源特征,输入第二预设模型进行交互结果预测处理,得到样本交互标签结果;基于样本交互标签结果与样本交互映射标签之间的差异,对第二预设模型进行训练,得到当前推荐模型;基于训练对象的训练对象特征、训练多媒体资源特征、训练交互数据以及当前推荐模型,对第一预设模型进行训练,得到当前标签生成模型;训练交互数据为训练对象与训练多媒体资源特征的交互数据;对当前推荐模型以及当前标签生成模型进行迭代训练,将训练结束时的当前标签生成模型确定为标签生成模型。本公开在标签生成模型的训练过程中,引入了推荐模型,通过对初始的标签生成模型以及推荐模型进行交替迭代训练,从而可以得到准确率较高的标签生成模型;通过标签生成模型可以实现快速、准确地预测对象的交互数据对应的交互标签。

108、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

- 还没有人留言评论。精彩留言会获得点赞!