基于无锚框的鱼眼图像行人检测方法

本发明涉及视频图像中的行人检测的,尤其是基于无锚框的鱼眼图像行人检测方法。

背景技术:

1、目前,传统的图像行人检测算法主要有特征提取和深度学习两类方法。基于特征提取的方法通常使用hog、lbp等特征描述符和svm分类器进行行人检测,但这类方法往往敏感于自然环境的影响,特别是光照变化对其检测准确度的影响较大。而基于深度学习的图像检测算法,如yolo、ssd、mask-rcnn和centernets等,在标准透视图像上的目标检测效果较好,主要针对非畸变的直立行人。然而,直接应用于鱼眼图像的检测并不理想,因为鱼眼图像的非线性畸变导致目标尺度和形态变化难以预测。odedkrams等人在鱼眼顶视图下的行人检测中,通过几何建模扩展聚合通道特征(acf)检测器,同时充分考虑背景的变化因素与准确标注问题。arkobarman等人通过预处理技术和新颖的搜索算法,实现了鱼眼镜头下的人员再识别。seidel_r等人直接使用yolo网络进行鱼眼图像行人检测,但存在行人漏检的情况。为了更好地检测鱼眼图像中畸变的行人,lin等人将鱼眼图像分割为多张子图,并使用faster r-cnn对每张子图进行检测,最后将检测结果重新映射到原始鱼眼图像上,同样li使用yolov3在24张子图上进行检测。虽然该方法在检测效果上表现较好,但需要复杂的预处理和后续处理过程,效率较低。rapid利用带锚框的网络进行角度值回归,避免了生成多张子图,但使用非极大抑制增加了推理时间,无法满足实时性要求。quan等人提出了一种面向鱼眼图像行人检测的anchor-free rotation-aware people detection usingtopview fisheye camera(arpd)方法,直接预测鱼眼图像中的目标边界框,并预测边界框的旋转角度。

2、但是,上述现有技术中,仍存在以下问题:

3、第一,在处理鱼眼图像时,无法迅速适应新的视场角度、光照变化等情况,无法对不同层次的特征进行自适应融合,无法只保留有用的信息进行组合,不能强调重要的特征,从而降低了融合特征的判别能力和特征的尺度不变性;

4、第二,在鱼眼图像中,由于畸变等因素的存在,现有技术无法处理特征的不确定性和变化;

5、第三,在鱼眼图像中,旋转边界框的回归效果差,存在的边界问题,在类正方形情况下,缺少角度信息,导致物体的角度混乱的问题。

技术实现思路

1、针对现有基于无锚框的鱼眼图像行人检测方法的技术不足,本发明提出了基于无锚框的鱼眼图像行人检测方法,能更好地捕捉输入图像的细节和特征,增强了融合特征的判别能力,提高了特征的尺度不变性,能够更好地处理特征的不确定性和变化。可以提升旋转边界框的回归效果,避免了传统边界框所存在的边界问题,同时也解决了在类正方形情况下,缺少角度信息会导致物体的角度混乱的问题。

2、为实现上述目的,本发明采用如下技术方案:

3、基于无锚框的鱼眼图像行人检测方法,包括以下步骤:

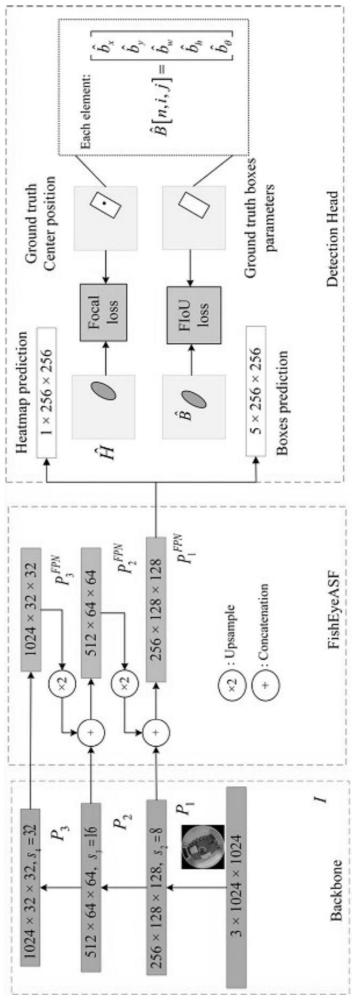

4、步骤1:输入图像,骨干网络yolov8独立提取鱼眼图像特征图;

5、步骤2:经由主干网络yolov8提取的特征图进入fisheyeasf特征融合模块,同时引入遗忘因子来平衡历史特征信息和新特征信息的影响;

6、步骤201:得到融合后的特征fisheyeasf-1,将p1层和p2层的特征进行下采样,调整与p3层通道数和分辨率一致;

7、步骤202:得到融合后的特征fisheyeasf-2,对p3层的特征进行上采样,对p1层的特征进行下采样,使通道数和分辨率与p3层特征一致;

8、步骤203:得到融合后的特征fisheyeasf-3,将p1层和p2层的特征进行下采样,调整与p3层通道数和分辨率一致;

9、步骤204:通过将p1层、p2层和p3层的特征与权重参数w相乘并相加,得到新的融合特征fisheyeasf,计算公式如下:

10、

11、其中,和是权重参数,表示(i,j)位置上的特征向量从第t层调整到l层的特征映射;

12、步骤3:使用自适应融合算法,设实际目标位置作为期望值,通过计算预测位置与真实目标位置之间的差异,作为残差来优化权重参数,将残差用e(i,j)表示,选择权重参数,使得残差平方和构成的代价函数最小;

13、步骤301:设代价函数为ξ(t),并在其定义中引入加,权因子ψ(t,k)进行调节,ξ(t)表示为:

14、

15、步骤4:将特征图传入检测头网络生成热图,焦点损失函数预测目标的中心点,提出fiou损失函数预测边界框,所述检测头网络包括两个预测分支,总损失函数的计算式如下:

16、

17、其中,ltotal是全局损失函数,lc是中心点损失函数,lreg是边界框的回归损失函数,ωc和ωangle是用于调整这两个分支的权重参数;

18、步骤401:通过高斯分布模拟iou损失的计算过程,利用高斯分布将目标框表示为一个椭圆,将边界框转换为高斯分布计算边界框的面积;

19、步骤402:将两个预测边界框的相交区域转换为高斯分布;

20、步骤403:使用卡尔曼滤波算法更新高斯分布;

21、步骤404:当图像目标形状为类正方形时,提出高斯角度损失。

22、进一步地,所述步骤1中,采用yolov8作为骨干特征提取网络,骨干网络采用残差结构,并输出3个不同尺度的特征图,这些特征图对应于输入图像经过不同的下采样步长所得到的结果。

23、进一步地,所述步骤2中,fisheyeasf特征融合模块采用多尺度自适应特征融合的方法,该方法通过学习权重参数,使网络能够自动学习如何在空间上过滤其他层次的不相关特征,并不断更新权重参数以捕捉特征信息的动态变化。

24、进一步地,所述步骤201中,将p1层的特征调整到p3层,在3×3卷积的基础上添加步长为2的最大池化操作,以调整p1层和p3层的特征图尺寸一致;

25、所述步骤202中,对p3层的特征进行上采样,使用一个3×3的卷积层,设置步长为2同时调整通道数和分辨率;

26、所述步骤203中,对p3层的特征图进行上采样操作,使其尺寸调整为与p1层相同,并通过1×1卷积调整它们的通道数一致,并使用插值的方式将它们调整为相同的大小;

27、所述步骤204中,和分别来自p1层、p2层和p3层的特征,权重参数和是分别通过resize后的p1层~p3层的特征图经过1×1卷积得到的,这些权重参数经过concat之后,通过softmax函数进行归一化处理,使其取值范围在[0,1]且和为1,计算公式如下:

28、

29、进一步地,所述步骤301中,加权因子ψ(t,k)应满足以下关系:0<ψ(t,k)≤1,k=1,2,…,t;

30、定义为:

31、ψ(t,k)=λt-k,k=1,2,…,t

32、其中,λ是一个接近1但小于1的正常数,指数级的t-k用于表示不同数据集图片特征输入的先后顺序,用于控制历史特征的权重衰减。

33、进一步地,所述步骤4中,中心点损失函数计算式如下:

34、

35、其中,n是热力图像素点的总数;hxy和分别是目标中心热力图上所有正样本的像素值和所有负样本的预测值,在焦点损失中,αc和βc是超参数,设置αc=2,βc=4。

36、进一步地,所述步骤401中,将任意方向的边界框转换为高斯分布g(u,σ),其中u为:

37、u=(x,y)t,σ=rλrt

38、其中σ和u分别是将旋转框转化为高斯表征后对应高斯分布的协方差矩阵和均值;(x,y)是中心点坐标,r表示旋转矩阵,λ表示特征值的对角矩阵,t表示转置运算符;

39、通过它的协方差可以计算出旋转边界框的面积s:

40、

41、进一步地,所述步骤402中,将两个预测边界框的相交区域高斯函数相乘,得到一个新的高斯函数,表示相交区域的概率分布,计算式如下:

42、γgfk(u,σ)=gpt(upt,σpt)ggt(ugt,σgt)

43、γ=gγ(ugt,σpt+σgt)

44、其中:gpt和ggt分别是预测框和真实框对应的高斯分布,gfk是预测框和真实框相交区域的高斯分布,upt和ugt分别是预测框和真实框对应的高斯分布的均值即中心点坐标,σpt和σgt分别是预测框和真实框对应的高斯分布的协方差,系数γ为距中心点的距离,引入中心点损失使两个高斯分布同中心。

45、进一步地,所述步骤403中,通过利用卡尔曼滤波,得到两个高斯分布的相交区域的协方差矩阵,计算式如下:

46、k=σpt(σpt+σgt)-1

47、σ=σpt-kσpt

48、其中:k是卡尔曼增益,σ是预测框和真实框相交区域对应的高斯分布的协方差。

49、进一步地,所述步骤404中,当对象是正方形时,即w=h,其二维高斯分布是一个不能准确表示方向的圆,提出了高斯角度损失:

50、

51、其中:η为3,wt和ht分别对应目标框的长宽,δθ=θpt-θgt,δθ表示预测角度值θpt和真实角度值θgt的差值。

52、本发明的有益效果:

53、1、本发明基于无锚框的鱼眼图像行人检测方法,采用了多尺度自适应特征融合的方法。该方法通过学习权重参数,使网络能够自动学习如何在空间上过滤其他层次的不相关特征,并不断更新权重参数以捕捉特征信息的动态变化。在处理鱼眼图像时,该方法能够迅速适应新的视场角度、光照变化等情况,并对不同层次的特征进行自适应融合,只保留有用的信息进行组合,强调重要的特征,从而增强了融合特征的判别能力,提高了特征的尺度不变性。

54、2、本发明基于无锚框的鱼眼图像行人检测方法,引入了遗忘因子来平衡历史特征信息和新特征信息的影响。在自适应特征融合中,遗忘因子用于控制旧特征图的权重衰减速度,使其逐渐减小对融合结果的影响。较大的遗忘因子会导致更快的衰减,从而更快地减少旧特征图在融合中的贡献。相反,较小的遗忘因子会使旧特征图的影响保持更长时间。通过利用历史特征信息进行适应和调整,该方法能够减少噪声和冗余信息的影响。在鱼眼图像中,由于畸变等因素的存在,该方法能够更好地处理特征的不确定性和变化。

55、3、本发明基于无锚框的鱼眼图像行人检测方法,改进损失函数,focal loss和提出的fiou loss线性组合可以提升旋转边界框的回归效果。fiou loss能够更准确地描述旋转目标的边界,避免了传统边界框所存在的边界问题,同时也解决了在类正方形情况下,缺少角度信息会导致物体的角度混乱的问题。

- 还没有人留言评论。精彩留言会获得点赞!