一种基于注意力增强与粗细粒度协同的文档信息提取方法

本发明应属于富文本文档理解领域,具体来说是一种基于注意力增强与粗细粒度协同的文档信息提取方法,能够有效的对富文本文档进行关键信息提取。

背景技术:

1、文档理解是自然语言处理中一个关键的研究领域,旨在自动化文档信息抽取并为众多商业应用提供支持。通过自动文档分类、实体识别、语义关系抽取等技术,文档理解可以显著简化繁琐的文档处理工作流程。

2、文档理解分为两类任务:实体节点分类任务、实体节点链接任务。基于gcn图神经网络架构的文档理解主要包括五个环节:节点定义、边定义、图采样、gcn和特定任务描述。目前主流的解决方案有两种,可定义为单阶段类型、两阶段类型。单阶段类型是优先对实体节点和边的特征进行定义,再通过gcn图神经网络架构节点特征与边特征的相互学习,最终得到节点特征和边特征用于不同的任务。两阶段类型是先获取实体节点特征通过gcn图神经网络架构,先只进行实体节点特征的相互学习,得到的实体节点学习特征后先用于实体节点分类任务。再对原始文档进行图采样获取实体节点对,结合实体节点对进行边特征的定义,边特征再通过神经网络层处理实体节点链接任务。虽然单阶段可以共同学习边特征和节点特征,但在实际应用中往往会因为特征互相学习的随机性而导致节点特征或边特征的部分信息缺失,存在很大的不确定性,降低两类任务的预期效果。

3、两阶段类型基于gcn图神经网络架构,在处理实体节点分类任务时,需获取实体节点的特征,目前可以通过图像特征、文本特征、布局特征来共同定义实体节点特征。在富文本文档理解领域中现有的对实体节点特征融合方法,要么是简单的拼接,要么是特征进行自注意力(self-attention)后再拼接,再作为实体节点的最终特征进行学习。该融合特征方式只保留了模态内的个性化,缺失了不同特征之间的关联,忽略了模态间的交互。

4、两阶段类型在处理实体链接任务时,需要先对图进行合理的图采样(graphsampling),传统的图采样包括全连接图、距离采样等方法获取节点对,用于边特征的定义。图采样之后需要对获取的节点对进行边定义,目前现有的可定义的边特征包括节点阅读顺序特征、相对位置特征、极坐标特征、距离特征以及融合节点分类后的特征。但往往会缺失实体节点对在原文档中的语义特征、图像特征融合。因此在边特征定义时会缺失部分原始文本、图像的信息。削弱了实体对之间的关系表达,从而导致最终的实体节点链接任务的效果欠佳。

技术实现思路

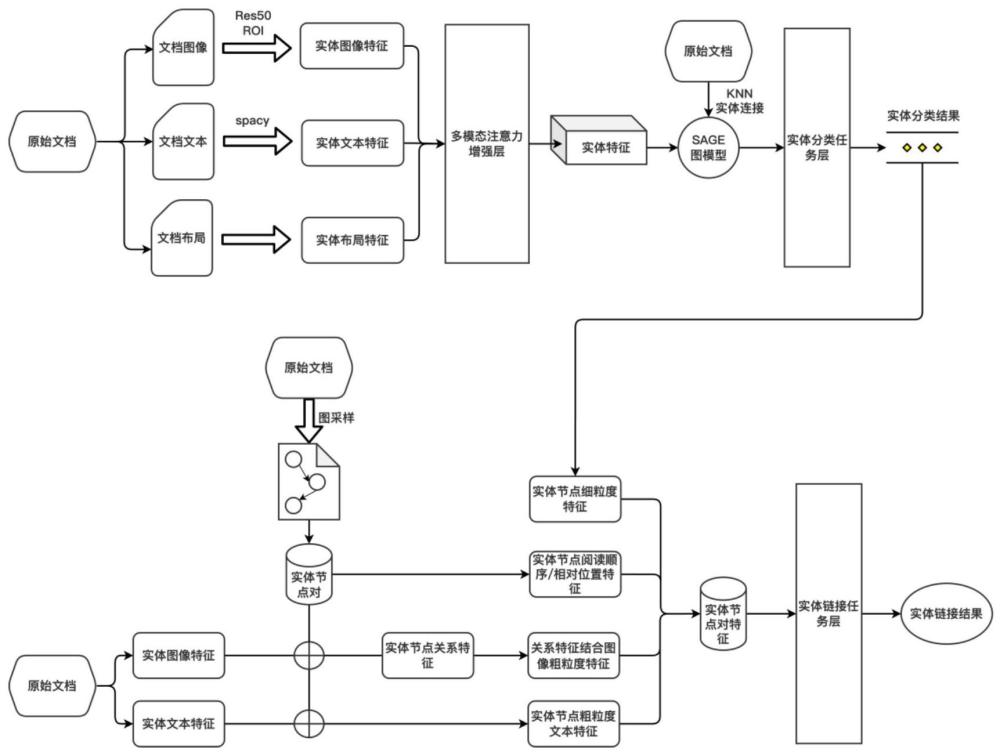

1、本发明的目的是针对现有技术的不足,提供了一种基于注意力增强与粗细粒度协同的文档信息提取方法,通过引入多模态注意力互补增强的编码方式对实体节点特征进一步编码,以学习模态间的特征关系来增强模态内的特征交互,并选取graphsage图模型作为gcn图神经网络架构进行节点学习,提高实体节点分类任务的准确率。采用粗细粒度协同融合边特征定义的方法,减少在边特征定义时对原文档特征的忽视,增强实体对之间的交互关系。

2、本发明解决其技术问题所采用的技术方案包括如下步骤:

3、步骤(1)通过ocr(光学字符识别)获取文档中若干实体以及对于实体的文本内容和文本框信息。通过resnet50提取文档图像特征,再利用roi对齐层获取区域级实体节点图像粗粒度特征、通过spacy模型提取文档的实体节点文本粗粒度特征,根据实体节点坐标以及文档宽高定义实体节点布局粗粒度特征;

4、步骤(2)对步骤(1)获取的实体节点图像粗粒度特征、实体节点文本粗粒度特征、实体节点布局粗粒度特征进行注意力互补增强,每个特征以自身为核心,在模态内自注意力的基础上,将其余两个特征与当前特征进行模态间注意力并融合,最终得到多模态注意力互补增强后并进行拼接的实体节点特征。

5、步骤(3)获取文档中每个实体节点相邻最近的n个实体节点,计算实体节点文本框左上角、右下角、中心点之间的综合距离,得到最近的n个实体节点索引生成边邻接矩阵。

6、步骤(4)将步骤(2)获取到的实体节点特征以及步骤(3)的边邻接矩阵通过graphsage图网络模型进行节点特征学习,得到实体节点分类的细粒度特征,并输入到一个全连接层和线性层进行特征融合以及实体节点分类;。

7、步骤(5)对文档进行图采样,获取实体节点对,所述实体节点对中实体节点之间的基础边特征包括实体节点之间的关系特征、实体节点的阅读顺序特征和极坐标特征,引入步骤(1)原数据集文档的实体节点图像粗粒度特征、实体节点文本粗粒度特征以及步骤(4)实体节点分类的细粒度特征,进行拼接作为协同融合边特征,并与基础边特征进行拼接融合得到最终边特征。

8、步骤(6)将步骤(5)边特征输入到全连接层进行边分类。

9、本发明的有益效果如下:

10、本发明提出了一种基于注意力增强与粗细粒度协同的文档信息提取方法,重点优化编码器对模态间的特征进行交叉融合,得到的实体节点特征通过graphsage进行相互学习,解决节点分类问题。节点分类后所得到的实体节点分类细粒度特征与原始文档实体节点图像粗粒度特征、原始文档实体节点文本粗粒度特征作为协同融合特征去定义边特征解决实体链接问题。结果表明,这种方法具有更好的鲁棒性和自适应能力。在funsd数据集上实体分类任务的f1值为83.19%,比基准模型高了2.62%,实体节点链接任务的f1值为85.46%,比基准模型高了8.4%。在基于gcn图模型架构领域内属于领先水平。

技术特征:

1.一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(2)具体实现过程如下:

3.根据权利要求2所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(3)中,特征交叉融合方法:

4.根据权利要求3所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(4)中,实体节点获取邻接矩阵方法:

5.根据权利要求4所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(5)中,graphsage模型实现方式如下:

6.根据权利要求5所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述实体节点特征entityfinal-feat输入到全连接层进行融合特征,并使用线性层wh*c对实体节点进行分类,h表示隐藏层,c表示实体节点的类别数量。

7.根据权利要求1所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(6)中,图采样方法为:

8.根据权利要求7所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述实体节点之间的关系特征frelation为根据关系建议,假设两个节点有潜在的关系,我们定义一个主节点s,另一个副节点o,并二者关系之间的关系用r表示,因此,有:

9.根据权利要求8所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,

10.根据权利要求9所述的一种基于注意力增强与粗细粒度协同的文档信息提取方法,其特征在于,所述步骤(7)中,边特征fpair,用融合特征的全连接层和用于推断节点对之间是否存在边的线性层wh*2。

技术总结

本发明公开了一种基于注意力增强与粗细粒度协同的文档信息提取方法,包括如下步骤,根据实体以及对于实体的文本内容和文本框信息得到实体节点图像特征、实体节点文本特征、实体节点布局特征;获取文档中每个实体节点相邻最近的n个实体节点,得到最近的n个实体节点索引生成边邻接矩阵;获取到的实体节点特征以及边邻接矩阵通过GraphSAGE图网络模型进行节点特征学习,并输入到全连接层进行节点分类;对文档中进行图采样,获取实体节点对,获得节点对之间的边特征,与边特征融合得到最终边特征;输入到全连接层进行边分类。该方法采用粗细粒度协同融合边特征定义的方法,减少在边特征定义时对原文档特征的忽视,增强实体对之间的交互关系。

技术研发人员:姜明,余德志,张旻

受保护的技术使用者:杭州电子科技大学

技术研发日:

技术公布日:2024/3/12

- 还没有人留言评论。精彩留言会获得点赞!