一种视频录制方法、系统、电子设备及介质与流程

本发明属于虚拟现实交互,具体涉及一种视频录制方法、系统、电子设备及介质。

背景技术:

1、随着vr(virtual reality,虚拟现实)应用的普及,用户使用vr设备在虚拟场景中体验游戏、召开会议或直播的参与时间越来越多。但虚拟现实的高沉浸感一方面让未使用vr设备的旁观者无法感受vr玩家的体验,另一方面也让vr玩家以第三者视角对其体验过程进行分享造成了困难。目前以混合现实技术为基础的录播方案可以实现将真实用户场景与虚拟场景融合在一起,形成可进行分享的录播视频。但是,在使用现有技术过程中,发明人发现现有技术中至少存在如下问题:

2、现有的很多方案只支持拍摄设备以固定位置获取用户所在的真实场景视频,不能对用户在真实场景中的行为实时动态拍摄,无法对用户在虚拟场景中的体验实现全方位记录,未实现用户实际位置与其在虚拟场景中位置的一致性。

3、申请号为cn201010598597.5的中国专利公开了一种利用移动拍摄设备进行动态纹理采集及虚实融合的方法,其通过直接将获取的原始的真实场景视频与虚拟场景视频相融合,然后得到混合现实视频,在此过程中解决了位置信息一致性的问题,但由于虚拟场景中的环境特征与玩家所处的真实场景的环境特征在视觉观感上是不一致的(例如:虚实物体遮挡、光影效果等),融合后难免会“突兀”的感觉,使得该现有技术得到的融合影像数据无法实现视觉感官的一致性。

技术实现思路

1、本发明旨在至少在一定程度上解决上述技术问题,本发明提供了一种视频录制方法、系统、电子设备及介质。

2、为了实现上述目的,本发明采用以下技术方案:

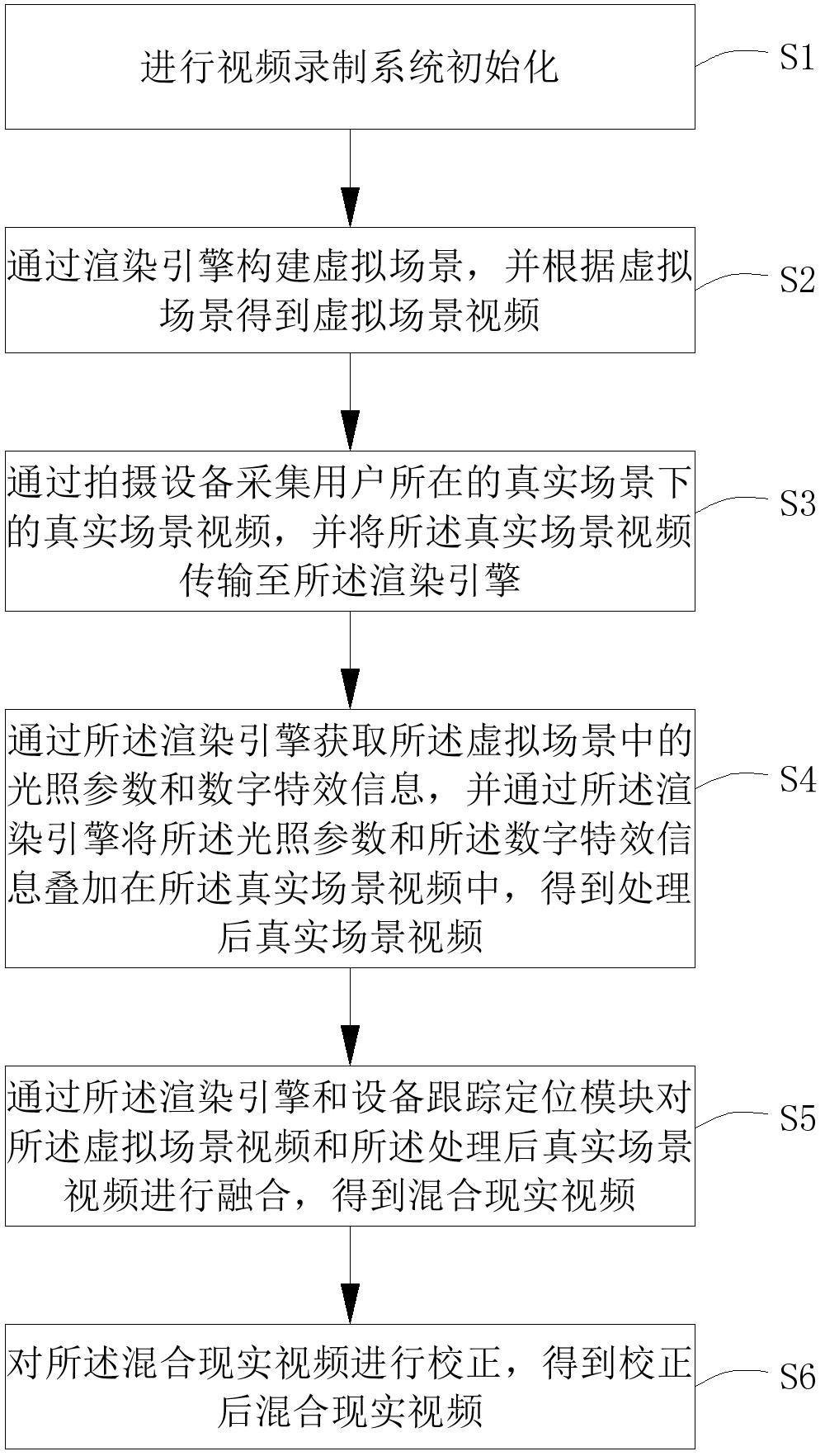

3、第一方面,本发明提供了一种视频录制方法,包括:

4、进行视频录制系统初始化;

5、通过渲染引擎构建虚拟场景,并根据虚拟场景得到虚拟场景视频;其中,所述虚拟场景通过vr头显进行显示;

6、通过拍摄设备采集用户所在的真实场景下的真实场景视频,并将所述真实场景视频传输至所述渲染引擎;

7、通过所述渲染引擎获取所述虚拟场景中的光照参数和数字特效信息,并通过所述渲染引擎将所述光照参数和所述数字特效信息叠加在所述真实场景视频中,得到处理后真实场景视频;

8、通过所述渲染引擎和设备跟踪定位模块对所述虚拟场景视频和所述处理后真实场景视频进行融合,得到混合现实视频。

9、本发明不同于现有的虚实融合视频录制方式,在进行视频录制系统初始化并得到虚拟场景视频后,通过将真实场景的视频信号直接传入渲染引擎中,再将所述虚拟场景中的光照参数和数字特效信息叠加在所述真实场景视频中,得到处理后真实场景视频,最后对所述虚拟场景视频和所述处理后真实场景视频进行融合,得到混合现实视频。在此过程中,通过所述渲染引擎和所述设备跟踪定位模块不仅能将真实场景下的真实场景视频与虚拟场景下的虚拟场景视频进行融合,实现虚实融合的位置一致性,还可通过将所述光照参数和所述数字特效信息叠加在所述真实场景视频中,实现虚实融合的视觉感官一致性,例如:在枪战游戏中,可以根据用户的游戏体验,在录制视频中的用户真实身体上叠加中弹受伤后的特效,进而可利于增强视频分享的效果。

10、在一个可能的设计中,所述视频录制系统还包括用于用户进行佩戴的用户跟踪定位模块,所述设备跟踪定位模块包括跟踪器和激光发射器,所述跟踪器固定设置在所述拍摄设备上,用于实时获取所述拍摄设备的设备位置信息,所述激光发射器设置有多组;对应地,进行视频录制系统初始化,包括:

11、在用户佩戴所述vr头显并站立在多组激光发射器之间的标定位置时,所述vr头显显示预设的虚拟场景;

12、所述vr头显获取用户的虚拟手部二维位置信息,并根据所述虚拟手部二维位置信息将用户虚拟手部显示在虚拟场景中;

13、根据所述拍摄设备采集的用户图像以及所述设备跟踪定位模块采集的所述拍摄设备的设备位置信息得到用户姿态矩阵,根据所述用户跟踪定位模块采集得到用户的真实手部三维位置信息,并根据所述真实手部三维位置信息与所述用户姿态矩阵,得到用户的真实手部平面位置信息;

14、将所述虚拟手部二维位置信息和所述真实手部平面位置信息进行配准,由此实现视频录制系统的初始化。

15、在一个可能的设计中,将所述真实场景视频传输至所述渲染引擎后,所述真实场景视频呈现在所述渲染引擎的一个虚拟二维平面上,且该虚拟二维平面与所述渲染引擎中的一个虚拟相机绑定;对应地,通过所述渲染引擎将所述光照参数和所述数字特效信息叠加在所述真实场景视频中,得到处理后真实场景视频,包括:

16、通过所述渲染引擎在所述虚拟相机中设置与所述光照参数一致的光照参数,并通过所述渲染引擎在所述虚拟相机中设置与所述数字特效信息一致的数字特效信息;

17、通过所述虚拟相机得到叠加有所述光照参数和所述数字特效信息的处理后真实场景视频。

18、在一个可能的设计中,所述真实场景视频的2d平面在渲染引擎中的画面默认比例为1920×1080;对应地,所述虚拟二维平面在所述渲染引擎中画面的宽为:

19、w=d×a×2

20、式中,d为虚拟场景中所述虚拟相机与所述虚拟二维平面之间的距离;a为真实场景的视场角的调整系数,且a=tan(fov/2),fov为真实场景的视场角;

21、所述虚拟二维平面在所述渲染引擎中画面的高为:

22、h=w×1080/1920。

23、在一个可能的设计中,通过所述渲染引擎和所述设备跟踪定位模块对所述虚拟场景视频和所述处理后真实场景视频进行融合,得到混合现实视频,包括:

24、获取用户所在的真实场景的空间参数,并通过所述设备跟踪定位模块获取所述拍摄设备的设备位置信息,通过所述vr头显获取用户的虚拟手部二维位置信息;

25、根据所述真实场景的空间参数、所述设备位置信息以及所述虚拟手部二维位置信息将所述虚拟场景视频和所述处理后真实场景视频进行融合,得到混合现实视频。

26、在一个可能的设计中,所述渲染引擎采用unity引擎或unreal引擎。

27、在一个可能的设计中,得到混合现实视频后,所述方法还包括:

28、对所述混合现实视频进行校正,得到校正后混合现实视频。

29、第二方面,本发明提供了一种视频录制系统,用于实现如上述任一项所述的视频录制方法;所述视频录制系统包括渲染引擎、拍摄设备、设备跟踪定位模块和vr头显,所述设备跟踪定位模块用于实时获取所述拍摄设备的设备位置信息,所述vr头显用于用户进行佩戴,所述拍摄设备、所述设备跟踪定位模块和所述vr头显均与所述渲染引擎通信连接。

30、第三方面,本发明提供了一种电子设备,包括:

31、存储器,用于存储计算机程序指令;以及,

32、处理器,用于执行所述计算机程序指令从而完成如上述任一项所述的视频录制方法的操作。

33、第四方面,本发明提供了一种计算机可读存储介质,用于存储计算机可读取的计算机程序指令,所述计算机程序指令被配置为运行时执行如上述任一项所述的视频录制方法的操作。

- 还没有人留言评论。精彩留言会获得点赞!