一种基于姿态估计的防溺水视觉预测方法

本发明属于视觉检测,涉及一种基于姿态估计的防溺水视觉预测方法。

背景技术:

1、目前游泳运动存在重大安全隐患问题,经常发生溺水事故,这是由于突发情况和各种不确定的因素导致的,如意外磕碰、自身疾病引起的突发性昏迷或无意识等,即使经验丰富的游泳者也会因为这些原因容易导致溺水事故。一旦发生溺水事故,不但危害了溺水者个人生命安全,同时也对游泳馆场所造成经济损失。因此,在泳池不断建设的过程中,也更加重视泳池的安全性。

2、游泳馆场所也安装了大量摄像头,目的更倾向于监控功能。针对溺水检测,场馆选择的是人工监视,但是缺点十分明显:一方面这种监控方式所需要的人力成本过高,另一方面对监控人员的精力带来了巨大的挑战,容易发生漏检现象。据相关数据显示,为避免大部分溺水事故的发生,不仅需要积极宣传防溺水教育和游泳技能的重要性,还需要加强游泳场馆的安全建设。从技术角度出发,利用泳池溺水风险视觉识别预警全自动监控系统来加强场馆安全建设是极具有意义的。

技术实现思路

1、本发明是为了解决上述现有技术存在的不足之处,提出一种基于骨架提取的防溺水视觉识别方法,以期使用轻量型网络改进的数据集以及优化的yolov7模块,使模型对于泳池检测的游泳人员运动状态与位置的检测结果更加精确,从而能保障游泳者的生命安全,也显著降低安全事故的发生。

2、本发明为达到上述发明目的,采用如下技术方案:

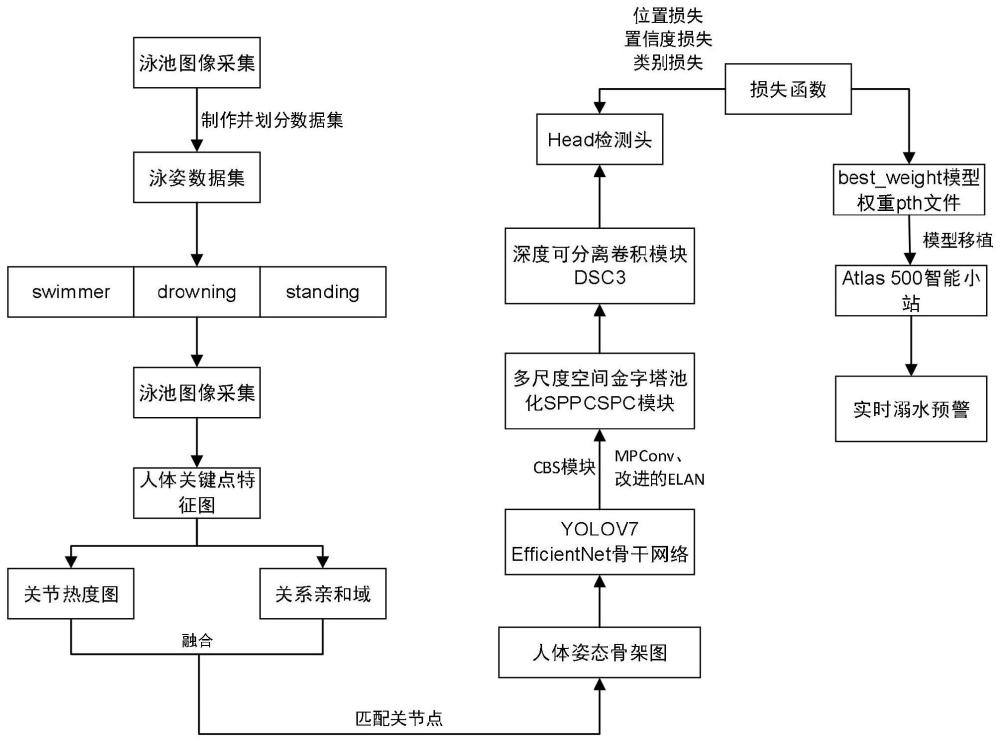

3、本发明一种基于姿态估计的防溺水视觉预测方法的特点在于,包括如下步骤:

4、步骤1:采集游泳视频数据集并进行抽帧和预处理后,得到泳姿图像帧序列记为fori={fori,1,fori,2,...,fori,n,...,fori,n},其中,fori,n表示第n个游泳图像帧;n=1,2,...,n,n表示抽帧后的图像帧总数;

5、对fori,n中每个游泳人员的位置、运动状态以及姿态关键点进行标注,得到标注后的第n个游泳图像帧,记为fn,从而得到标注后的泳姿图像帧序列f={f1,f2,...,fn,...,fn},将fn中第m个游泳人员的位置、运动状态以及人体姿态关键点的标注信息记为

6、所述标注信息的运动状态分为三类:游泳swimmer、站立standing、溺水drowning;

7、步骤2:构建姿态估计轻量化网络对fn进行处理,得到人体姿态骨架图fop,n;

8、步骤3:构建优化后的yolov7预测网络对fop,n进行处理,得到fn中第m个游泳人员的预测框与预测类别概率;

9、步骤4:构建损失函数,包括:位置损失置信度损失与类别损失利用梯度下降法对所述姿态估计轻量化网络和优化后的yolov7预测网络进行训练,并计算位置损失、置信度损失与类别损失以更新网络参数,直到位置损失、置信度损失与类别损失均收敛为止,从而得到训练后的优化后的yolov7推理模型;

10、步骤5:将优化后的yolov7推理模型移植到atlas 500智能小站,并将优化后的yolov7推理模型的权重文件转换为适应atlas 500智能小站的om文件格式,所述atlas 500智能小站上的npu嵌入式神经网络处理器利用将优化后的yolov7推理模型对游泳视频数据进行预测,从而得到人体姿态骨架图对应目标检测结果。

11、本发明所述的一种基于姿态估计的防溺水视觉预测方法的特点也在于,所述步骤2中的姿态估计轻量化网依次包括:resnet18网络、t个stage模块,其中,每个stage模块包括:顶部分支ρ与底部分支

12、步骤2.1:所述resnet18网络中的前若干个不同尺度的残差层对标注好的第n个游泳图像帧fn进行特征提取,得到第n个人体关键点的特征图ffeat,n,从而得到人体关键点的特征图集合ffeat={ffeat,1,ffeat,2,...,ffeat,n,...,ffeat,n};

13、步骤2.2:当t=1时,第t个stage模块中的顶部分支ρt与底部分支采用深度卷积与点卷积操作分别对ffeat,n进行处理,相应得到第t个关节热度图与第t个关系亲和域

14、当t=2,3,...,t时,将ffeat,n与第t-1个stage模块输出的关节热度图和关系亲和域进行拼接后,作为第t个stage模块的输入,并由第t个stage模块输出第t个关节热度图与第t个关系亲和域从而由第t个stage模块输出第t个关节热度图与第t个关系亲和域

15、将ffeat,n与和拼接后的特征图中的关节点进行两两匹配连接,从而得到第n个人体关键点特征图ffeat,n对应的人体姿态骨架图,记为fop,n,从而得到人体姿态骨架图序列fop={fop,1,fop,2,...,fop,n,...,fop,n}。

16、所述步骤2中的优化后的yolov7预测网络包括:特征提取efficientnet网络、yolov7颈部模块以及head检测头;

17、步骤3.1:所述特征提取efficientnet网络依次由串联的q个cbs基础单元以及3个组合模块,每个组合模块中包含一个mpconv模块和改进的elan模块,其中,任意第q个cbs基础单元由1个卷积层、批归一化层和silu激活层依次构成;mpconv模块的上分支包括最大池化层maxpool与一个cbs模块,mpconv模块的下分支由若干cbs模块组成;改进的elan模块的上分支为1×1卷积层,改进的elan模块的下分支依次包括:1×1卷积层、若干cbs模块与1个saconv模块;其中,所述saconv模块包括上、中、下三条分支;

18、将fop,n输入到特征提取模块efficientnet网络中,并依次经过q个串联的cbs基础单元的特征提取处理后,得到第n个粗特征图sn,cbs;

19、当j=1时,sn,cbs输入第j个组合模块中,并分别经过第j个mpconv模块的上分支和下分支的处理后,得到的两个结果拼接后,作为第j个mpconv模块的输出结果,记为

20、第j个改进的elan模块的上分支对进行处理后,得到第j个改进的elan模块的上分支处理结果

21、第j个改进的elan模块的下分支中的1×1卷积层、若干cbs模块依次对进行处理后,得到第j个cbs特征图

22、输入第j个saconv模块中,并利用式(1)得到第j个saconv特征图

23、

24、式(1)中,w表示卷积层中待学习的权重参数,conv表示卷积运算,r为超参数,δw为待训练的权值,g表示开关函数;

25、将和拼接后,得到第j个改进的elan模块输出的第j个加强特征提取图

26、当j=2,3时,输入第j个组合模块中进行处理,得到第j个加强特征提取图从而得到特征提取efficientnet网络的输出结果,记为进而得到fop经过efficientnet网络后的加强特征提取图集合s={s1,s2,...,sn,...,sn};

27、步骤3.2:所述yolov7颈部模块,包括:多尺度空间金字塔池化的sppcspc模块、两个cbs基础单元、深度可分离卷积的dsc3模块以及c3模块,其中,多尺度空间金字塔池化的sppcspc模块包含上、下分支,上分支包含若干个cbs基础单元以及有不同池化核的p个并联池化层,下分支有若干个cbs基础单元;dsc3模块包含两个结构相同的上、下分支,每个分支中依次包含两个深度可分离处理块,每个深度可分离处理块依次包括:一个深度可分离卷积层、一个批归一化层和一个激活层silu;c3模块包含上、下分支,每个分支有若干cbs基础单元;

28、将输入sppcspc模块中,并经过上分支的p个并联池化层的处理后,得到的并联池化结果进行拼接,再输入上分支的若干cbs基础单元中进行处理后,得到sppcspc模块的上分支处理结果scn,up;同时,经过sppcspc模块的下分支中的若干个cbs基础单元的处理后,得到sppcspc模块的下分支处理结果scn,down;

29、scn,up和scn,down进行拼接后,得到sppcspc模块输出的第n个多尺度空间金字塔池化结果scn,从而得到多尺度空间金字塔池化序列sc={sc1,sc2,...,scn,...,scn};

30、和scn分别经过第1个cbs基础单元的处理,得到的两个结果进行拼接后,记为融合特征

31、分别经过dsc3模块的上、下分支中的第一深度可分离处理块的处理后,得到的上、下分支结果进行拼接,再输入第二深度可分离处理块中进行处理,得到dsc3模块的处理结果middscn;

32、和middscn分别再经过第2个cbs基础单元的处理,得到的两个结果进行拼接后,记为融合特征

33、分别经过dsc3模块的上、下分支中的第一深度可分离处理块的处理后,得到的上、下分支结果进行拼接,再输入第二深度可分离处理块中进行处理,得到对应的融合后的特征结果

34、经过下采样处理后,与middscn进行拼接,再将拼接结果经过dsc3模块的上、下分支中的第一深度可分离处理块处理后,得到的上、下分支结果进行拼接,再输入第二深度可分离处理块中进行处理,得到对应的融合后的特征结果

35、经过下采样处理后,与第n个多尺度空间金字塔池化结果scn进行拼接,再将拼接结果经过c3模块上、下分支的处理,得到的上、下分支结果进行拼接后,作为对应的融合后特征结果从而得到yolov7颈部模块输出的融合特征图记为进而得到融合特征图集合neck={neck1,neck2,...,neckn,...,neckn};

36、步骤3.3:所述head检测头对neckn进行处理,得到fn中第m个游泳人员的预测框与预测类别概率其中,分别表示第m个游泳人员预测框的左上角与右下角坐标,预测类别标签为

37、所述步骤4中的损失函数是按如下过程建立:

38、步骤4.1:利用式(2)构建fn中第m个游泳人员的位置损失

39、

40、式(2)中,为第m个游泳人员的真实框的左上角与右下角坐标;

41、步骤4.2:利用式(3)构建fn中第m个游泳人员的类别损失

42、

43、式(3)中,表示fn中第m个游泳人员的真实类别标签;

44、步骤4.3:利用式(4)构建fn中第m个游泳人员的置信度损失

45、

46、式(4)中,表示fn中第m个游泳人员的预测框与真实框的交并比,与分别表示fn中第m个游泳人员的预测框与真实框对应的中心点,ρn,m表示预测框与真实框的中心点间的欧氏距离,cn,m表示包围fn中第m个游泳人员的预测框与真实框的最小封闭矩形的对角线长度,vn,m是fn中第m个游泳人员的预测框与真实框的长宽比,并由式(5)得到,α是一个用来平衡长宽比列的参数,并由式(6)得到;

47、

48、式(5)中,wnm与表示fn中第m个游泳人员的真实框的宽、高,与表示fn中第m个游泳人员的预测框的宽、高;

49、

50、本发明一种电子设备,包括存储器以及处理器的特点在于,所述存储器用于存储支持处理器执行所述防溺水视觉预测方法的程序,所述处理器被配置为用于执行所述存储器中存储的程序。

51、本发明一种计算机可读存储介质,计算机可读存储介质上存储有计算机程序的特点在于,所述计算机程序被处理器运行时执行所述防溺水视觉预测方法的步骤。

52、与现有技术相比,本发明的有益效果在于:

53、1、本发明操作简单,针对不同型号的游泳池溺水人员预判,重新设置硬件参数即可,便于操作,可以应用于绝大部分的溺水人员预判中,具有结构简单、操作方便、识别率高、便于产品更新等特点。

54、2、本发明采用基于姿态估计方法的改进型数据集轻量化模块,可以对数据集进行优化改进,避免了大量数据集制作和打标签带来的繁琐问题,提高了数据集的质量。

55、3、本发明采用基于优化的yolov7推理模型预测模块,采用小样本学习的方法,避免了不良样本数量过少造成的无法训练等情况,并通过自适应调整接收域以及改进型损失函数,提高了溺水检测的识别率。

56、4、本发明采用基于昇腾atlas 500智能小站的推理加速模块,使用atlas 500智能小站中的npu微处理器进行优化的yolov7模型推理,提升了模型的推理速度。

- 还没有人留言评论。精彩留言会获得点赞!