智能体推理方法、系统、设备及存储介质

本发明涉及计算机并行计算,尤其涉及一种智能体推理方法、系统、设备及存储介质。

背景技术:

1、智能体通过基于transformer的神经网络计算推理,理解用户的文本输入,输出文本与用户进行交互,可以应用在各种场景。在基于transformer的神经网络中,代表模型有bert和gpt等,但是这类模型通常为了数据预测精度,其计算性能欠佳,其模型结构中的transformer编码器或解码器的计算占比最大,而其还有很大的改进空间。同时,越来越多的处理器核心被同时放置在一台机器上,多核处理器引入了非统一内存访问体系结构(numa),如intel cpu和amd cpu等,多个核心被组织成一个numa节点,若干个numa节点组织成一台众核设备。虽然这些特性潜在地带来了更高的聚合计算能力,但由于缓存争用、线程同步和numa远程访问而导致的低效并行性也变得更加严重。

2、因此,在众核cpu上部署深度学习应用程序需要更复杂的并行化来实现更高的性能。目前的智能体推理应用大多是传统多核cpu或多gpu平台进行推理加速,但是欠缺对众核设备平台的适配和优化,若直接运行在众核平台上,会存在较低的核使用率、线程配置和调度优化缺乏整体性和协调性、低效的矩阵相乘算法等问题,导致推理速度较慢。

技术实现思路

1、本发明的主要目的在于提供一种智能体推理方法、系统、设备及存储介质,旨在解决现有技术中智能体推理应用推理加速中欠缺对众核设备平台的适配和优化,导致推理速度较慢的技术问题。

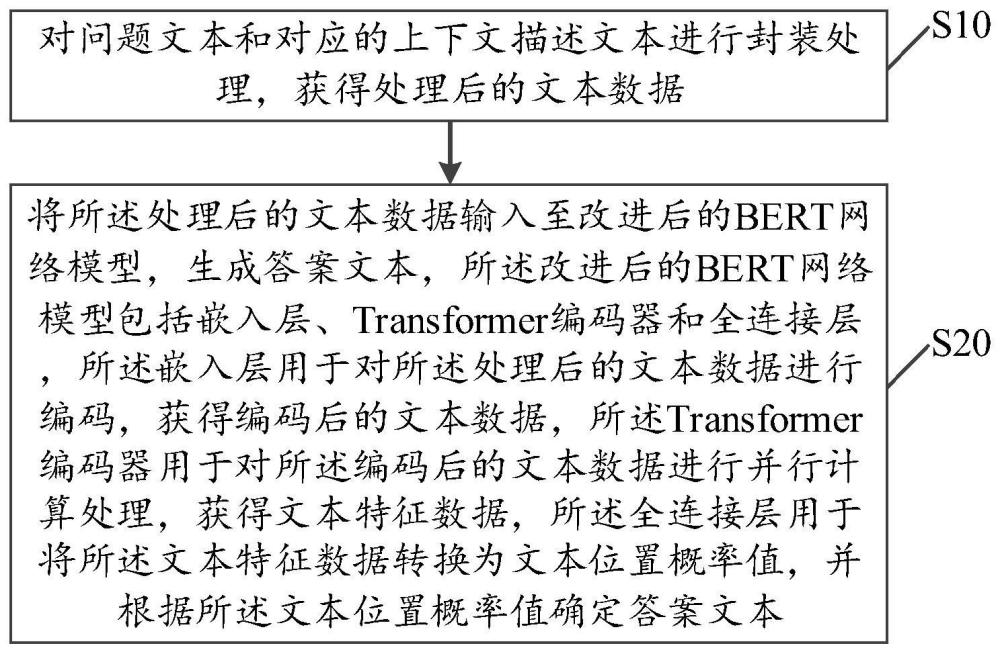

2、为实现上述目的,本发明提供一种智能体推理方法,所述方法包括以下步骤:

3、对问题文本和对应的上下文描述文本进行封装处理,获得处理后的文本数据;

4、将所述处理后的文本数据输入至改进后的bert网络模型,生成答案文本,所述改进后的bert网络模型包括嵌入层、transformer编码器和全连接层,所述嵌入层用于对所述处理后的文本数据进行编码,获得编码后的文本数据,所述transformer编码器用于对所述编码后的文本数据进行并行计算处理,获得文本特征数据,所述全连接层用于将所述文本特征数据转换为文本位置概率值,并根据所述文本位置概率值确定答案文本。

5、可选地,所述将所述处理后的文本数据输入至改进后的bert网络模型,生成答案文本,包括:

6、将所述处理后的文本数据输入至所述嵌入层进行编码,获得编码后的文本数据;

7、通过所述transformer编码器对所述编码后的文本数据进行并行计算处理,获得文本特征数据;

8、通过所述全连接层将所述文本特征数据转换为文本位置概率值,并根据所述文本位置概率值确定答案文本。

9、可选地,所述通过所述transformer编码器对所述编码后的文本数据进行并行计算处理,获得文本特征数据,包括:

10、通过所述transformer编码器将所述编码后的文本数据和网络模型参数执行优化后的细粒度并行的矩阵乘法任务,获得qkv矩阵,所述qkv矩阵包括q矩阵、k矩阵和v矩阵;

11、对所述qkv矩阵执行优化后的细粒度并行的矩阵乘法任务,获得自注意力特征数据;

12、对所述自注意力特征数据和所述网络模型参数执行优化后的细粒度并行的矩阵乘法任务,获得升维特征数据;

13、对所述升维特征数据和所述网络模型参数执行优化后的细粒度并行的矩阵乘法任务,获得文本特征数据。

14、可选地,所述transformer编码器包括主实例和辅助实例;所述通过所述transformer编码器将所述编码后的文本数据和网络模型参数执行优化后的细粒度并行的矩阵乘法任务,获得qkv矩阵,包括:

15、基于所述编码后的文本数据的批大小和序列长度从预设查找表中确定所述主实例和所述辅助实例分别对应的cpu核心数;

16、根据所述主实例和所述辅助实例分别对应的cpu核心数将所述编码后的文本数据划分为第一文本数据和第二文本数据,并将所述第一文本数据输入所述主实例,将所述第二文本数据输入所述辅助实例;

17、通过所述主实例和所述辅助实例分别基于所述第一文本数据、所述第二文本数据和网络模型参数执行优化后的细粒度并行的矩阵乘法任务,获得qkv矩阵。

18、可选地,所述执行优化后的细粒度并行的矩阵乘法任务,包括:

19、根据各阶段文本数据的批大小、序列长度和操作类型生成配置id,并根据所述配置id在预设查找表中确定最佳并行配置,所述各阶段文本数据包括所述编码后的文本数据、所述qkv矩阵、所述自注意力特征数据和所述升维特征数据,所述操作类型包括qkv生成、qkv计算、升维和降维;

20、根据所述最佳并行配置并行执行定制矩阵乘法计算,在所述最佳并行配置中包含numa感知线程调度时,将所述定制矩阵乘法计算划分到各个numa节点中执行,并根据数据转移开销确定是否将所述编码后的文本数据提前复制到各个numa节点的内存中。

21、可选地,所述定制矩阵乘法计算包括调整后的高瘦矩阵乘法的打包策略、调整后的微内核的分块策略和简化后的小矩阵乘法的优化栈;

22、所述调整后的高瘦矩阵乘法的打包策略包括打包矩阵的一部分,并将打包整个矩阵的操作分散至高瘦矩阵乘法的计算过程中;

23、所述调整后的微内核的分块策略包括为矩阵乘法的基本计算单元微内核分配与硬件适配的寄存器分块策略;

24、所述简化后的小矩阵乘法的优化栈包括在矩阵乘法的优化栈中仅保留寄存器分块和仅打包小矩阵乘法以外的部分。

25、可选地,所述文本位置概率值包括起始位置概率值和结束位置概率值;所述通过所述全连接层将所述文本特征数据转换为文本位置概率值,并根据所述文本位置概率值确定答案文本,包括:

26、通过所述全连接层根据所述文本特征数据确定起始特征和结束特征;

27、根据所述文本特征数据和所述起始特征确定起始位置概率值;

28、根据所述文本特征数据和所述结束特征确定结束位置概率值;

29、截取起始位置概率值最高的位置和结束位置概率值最高的位置之间的上下文描述文本,生成答案文本。

30、此外,为实现上述目的,本发明还提出一种智能体推理系统,所述智能体推理系统包括:

31、数据处理模块,用于对问题文本和对应的上下文描述文本进行封装处理,获得处理后的文本数据;

32、答案生成模块,用于将所述处理后的文本数据输入至改进后的bert网络模型,生成答案文本,所述改进后的bert网络模型包括嵌入层、transformer编码器和全连接层,所述嵌入层用于对所述处理后的文本数据进行编码,获得编码后的文本数据,所述transformer编码器用于对所述编码后的文本数据进行并行计算处理,获得文本特征数据,所述全连接层用于将所述文本特征数据转换为文本位置概率值,并根据所述文本位置概率值确定答案文本。

33、此外,为实现上述目的,本发明还提出一种智能体推理设备,所述设备包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的智能体推理程序,所述智能体推理程序配置为实现如上文所述的智能体推理方法的步骤。

34、此外,为实现上述目的,本发明还提出一种存储介质,所述存储介质上存储有智能体推理程序,所述智能体推理程序被处理器执行时实现如上文所述的智能体推理方法的步骤。

35、在本发明中,公开了对问题文本和对应的上下文描述文本进行封装处理,便于模型预测的答案与问题对应;然后基于改进后的bert网络模型生成答案,改进后的bert网络模型包括嵌入层、transformer编码器和全连接层,通过嵌入层对处理后的文本数据进行编码,通过transformer编码器对编码后的文本数据进行细粒度优化的并行计算,从而能够将数据划分到多个实例进行并行计算,每个实例可以使用更少的内核实现更低的延迟,提高了资源利用率,最后通过全连接层将文本特征数据转换为文本位置概率值,并根据文本位置概率值确定答案文本,从而能够提高了众核处理器上智能体推理的速度。

- 还没有人留言评论。精彩留言会获得点赞!