一种基于模态交互网络的多模态单目标跟踪方法

本发明涉及单目标跟踪,尤其涉及一种基于模态交互网络的多模态单目标跟踪方法。

背景技术:

1、随着深度学习在计算机视觉领域的发展,卷积神经网络和transformer应用在越来越多的场景中,而单目标跟踪由于其在视频监控、自动驾驶和人机交互中的广泛应用,在计算机视觉领域受到越来越多的重视。单目标跟踪旨在仅给定初始帧中目标的边界框,去推断视频帧中目标的状态。传统的单目标跟踪方法,基于纯rgb(红、绿、蓝)视频序列,称为rgb跟踪器。尽管经过长时间的研究和发展,rgb跟踪方法已经取得了比较优异的跟踪性能,但在一些复杂场景下(如变形、光照和遮挡等)仍面临挑战,多模态跟踪由于能够利用辅助模态来补充信息,从而提供更准确和鲁棒的跟踪结果,并且传感器捕获辅助模态信息的成本愈加低廉,因而逐渐受到越来越多的关注。目前主流多模态单目标跟踪方法为基于rgb跟踪架构,增加辅助模态分支,即整体跟踪框架沿用rgb结构,将rgb和辅助模态信息输入网络,然后在多模态跟踪数据集上重新训练,或使用与rgb数据相同的特征提取方式后进行简单的特征融合再处理。

2、上述方法未考虑到不同模态的独特性和潜在的互补性,缺乏对模态内模态间不同信息的交互和融合处理,或所采取的特征融合处理方式略显粗糙,需要更加行之有效的多模态特征交互融合处理方案;同时,现有多模态跟踪数据集与rgb跟踪数据集无论是在目标类别、视频帧数量,还是视频质量上都没有可比性,如何在借鉴发展成熟的rgb跟踪架构的同时,将丰富的大规模rgb跟踪数据利用起来,也是一个多模态单目标跟踪任务的研究热点。

3、多模态单目标跟踪方法的核心思想是在一个深度学习网络中输入rgb主模态和辅助模态信息进行目标跟踪,通过辅助模态提供的额外互补信息提高跟踪器在复杂场景下跟踪的准确性和鲁棒性。然而大部分多模态单目标跟踪方法主要将重点放在对rgb跟踪模型进行全微调,即对rgb跟踪架构在多模态跟踪数据集上重新训练,却忽略了下游数据(多模态单目标跟踪数据集)的稀缺性和可移植性差等原因。

4、目前,现有技术中的一种视觉提示多模态跟踪方法(vipt)使用预训练基础rgb模型参数,学习与模态相关的提示(prompt),只引入了少量的可训练参数(不到模型参数的1%),在多个下游跟踪(rgbd、rgbt、rgbe)任务上实现了领先的跟踪效果。该方法使用参数冻结的vit网络结构进行多模态特征提取和交互,在各个vit网络层之间插入视觉提示器模块(mcp),以学习到模态内模态间的相关知识。

5、上述现有技术中的视觉提示多模态跟踪方法的缺点包括:该方法对辅助模态的利用不够深入,仅在rgb跟踪架构的基础上增加辅助模态输入,或者采用与rgb相同的特征提取方式进行简单融合,缺乏不同模态之间有效的交互与深层次融合,这导致了不同模态间潜在的互补信息没有被充分挖掘,限制了跟踪性能的提升。其次,该方法在跟踪过程中未能有效利用历史信息,主要依赖于初始帧或前一帧的信息,这在目标发生较大变形或遮挡时,会导致跟踪结果不稳定和不可靠。

技术实现思路

1、本发明的实施例提供了一种基于模态交互网络的多模态单目标跟踪方法,以实现有效地进行多模态单目标跟踪。

2、为了实现上述目的,本发明采取了如下技术方案。

3、一种基于模态交互网络的多模态单目标跟踪方法,包括:

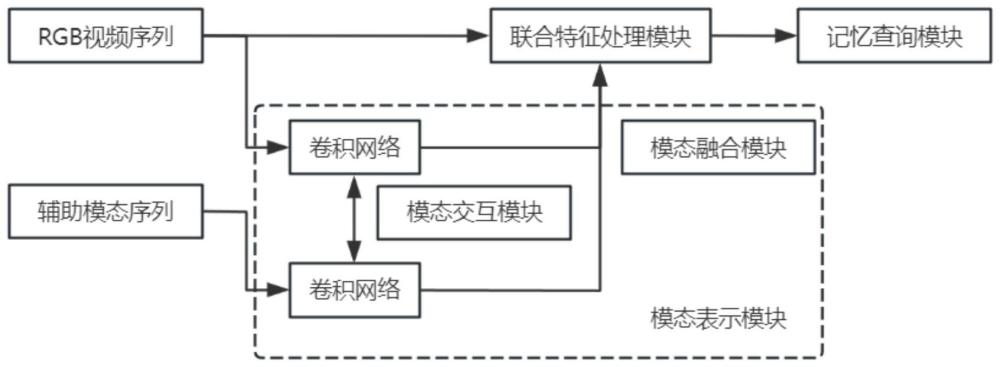

4、构建多模态跟踪网络架构,该多模态跟踪网络架构包括模态表示模块、联合特征处理模块和记忆查询模块;

5、将训练数据集中的有标注的rgb视频序列以及对应的辅助模态视频序列作为所述多模态跟踪网络架构的输入数据,利用所述模态表示模块在不同模态间实现多尺度交互和融合,利用所述联合特征处理模块对不同的模态进行特征提取融合处理,利用所述记忆查询模块建立当前目标特征和历史目标特征之间的长距离依赖关系,得到训练好的多模态跟踪网络架构;

6、将待进行目标跟踪的有标注的rgb视频序列以及对应的辅助模态视频序列输入到训练好的多模态跟踪网络架构,多模态跟踪网络架构输出有标注的rgb视频序列中的目标位置信息。

7、优选地,所述的构建多模态跟踪网络架构,该多模态跟踪网络架构包括模态表示模块、联合特征处理模块和记忆查询模块,包括:

8、构建包括模态表示模块、联合特征处理模块和记忆查询模块的多模态跟踪网络架构,所述模态表示模块包括特征提取的轻量级卷积网络、模态交互模块和模态融合模块,用于进行相同模态内与不同模态间的特征交互与融合,所述联合特征处理模块包括参数冻结的vit网络和视觉提示器,用于在不同语义层次上提取并学习不同模态的互补性,所述记忆查询模块用于执行历史多模态信息与搜索特征中的每个位置相关的时态特征的聚合,建立当前目标与历史目标之间的长期依赖关系。

9、优选地,所述的将训练数据集中的有标注的rgb视频序列以及对应的辅助模态视频序列作为所述多模态跟踪网络架构的输入数据,利用所述模态表示模块在不同模态间实现多尺度交互和融合,包括:

10、获取所述多模态跟踪网络架构的多模态单目标跟踪数据集,将训练数据集中的有标注的rgb视频序列以及对应的辅助模态视频序列作为所述多模态跟踪网络架构的输入数据,将所述输入数据输入到模态表示模块,模态表示模块使用两个相同结构的轻量级卷积网络对输入数据进行特征提取,卷积网络有四个阶段,不同阶段得到不同尺度语义的模态特征,将同一阶段得到的两模态特征通过模态交互模块进行不同模态间的信息交互,并参与下一阶段的模态特征交互,模态融合模块实现模态间的通信和融合,得到目标特征表示。

11、优选地,所述的利用所述联合特征处理模块对不同的模态进行特征提取融合处理,包括:

12、将原始rgb图像通过卷积操作划分成多个小补丁,将小补丁转换为一个固定维度的嵌入向量,得到原始rgb图像的嵌入rgb特征,联合特征处理模块包括参数冻结的vit网络和视觉提示器,视觉提示器被插入到vit网络的多个阶段,联合特征处理模块接收所述嵌入rgb特征和所述模态表示模块输出的目标特征表示,使用参数冻结的vit网络模型对不同的模态进行特征提取融合处理,挖掘模态间的完整性信息,得到当前目标特征和搜索区域特征,并将目标特征保存下来,得到目标历史特征。

13、优选地,所述的利用所述记忆查询模块建立当前目标特征和历史目标特征之间的长距离依赖关系,得到训练好的多模态跟踪网络架构,包括:

14、记忆查询模块接收并保存所述联合特征处理模块输出的目标历史特征和搜索区域特征,将所述目标历史特征与所述搜索区域特征以非局部的方式进行聚合,执行历史目标特征与搜索区域特征中的每个位置相关的时态特征的聚合,形成一个关联矩阵,该关联矩阵表示搜索中每对位置和时间特征之间的相互作用关系,建立起当前目标特征和历史目标特征之间的长距离依赖关系,将最终得到的特征输入预测头,得到预测出的目标的边界框,该边界框表示了目标的位置信息;

15、利用所述目标特征表示和所述当前目标特征和历史目标特征之间的依赖关系,在多模态单目标跟踪数据集上训练迭代所述多模态跟踪网络架构,更新和调整所述多模态跟踪网络架构的参数,得到训练好的多模态跟踪网络架构。

16、由上述本发明的实施例提供的技术方案可以看出,本发明通过设计独特的多模态跟踪网络架构(minet),克服了现有技术在多模态跟踪领域的局限性。模态表示模块通过模态间交互和融合,提取更具判别力的特征,这在复杂的跟踪场景下尤为重要。记忆查询模块的应用,允许系统利用历史信息,增强跟踪过程中的稳定性和准确性。

17、本发明附加的方面和优点将在下面的描述中部分给出,这些将从下面的描述中变得明显,或通过本发明的实践了解到。

- 还没有人留言评论。精彩留言会获得点赞!