一种基于多尺度特征扩展的行人再识别方法、系统及介质

本发明涉及计算机视觉,特别涉及一种基于多尺度特征扩展的行人再识别方法、系统及介质。

背景技术:

1、行人再识别是指从大量记录的图像(视频)中找到查询图像(视频)中感兴趣的人,其目的在于解决跨摄像机非重叠视域下具体行人检索问题。但是在实际的应用环境中可能无法捕获rgb图像,如夜晚等黑暗条件,传统的同质行人再识别无法适用。为了解决上述问题,考虑到微软kinect相机所拍摄深度图像(depth images,简称d)对光照的变化具有鲁棒性,当光线条件差或无法获取rgb图像时,深度图像可以作补充,它记录场景的深度信息,并弥补纯视觉技术在缺乏纹理、光照不足、过度曝光、计算复杂度高、快速运动等问题上的不足。

2、rgb-d跨模态行人再识别任务主要研究在给定一个特定个体的图像,尝试在两种模态下的图像库中检索匹配属于同一个体图像的问题。由于rgb图像与深度图像之间存在着巨大的模态差异,而现有的高质量跨模态rgb-d行人再识别训练数据集又极为匮乏,网络模型难以从有限的训练数据中学习到充分的rgb与深度图像两个模态的共性行人特征。因此,缓解rgb-d行人再识别训练数据匮乏的问题亟待解决。此外,大多数的研究工作只通过更为复杂的模型、更为繁琐的训练策略尝试使模型学习到更精细的行人特征。目前最新的方法通过将局部和全局自注意力机制引入跨模态网络进行训练来解决传统神经网络只提取局部特征而忽略全局特征的缺陷,并且引入了一种将异质中心损失、交叉熵损失以及三元组损失函数相结合的联合损失函数机制,用来拉近属于同一类别的两个模态中心点之间的距离,从而提高类内跨模态的特征相似度。虽然这种基于局部与全局自注意力机制相结合的rgb-d跨模态行人再识别方法取得了较好的结果,但是受限于当前匮乏的训练数据,当前较为复杂的跨模态行人再识别模型往往很快就收敛了,并没有充分挖掘深层网络模型的潜力。

3、现有的rgb-d跨模态行人再识别技术主要集中在从特征提取阶段入手,使用自注意力机制等技术将局部特征和全局特征相结合以期得到两个模态所共享的对行人身份识别起重要作用的判别性特征。但是由于当前缺乏足量的高质量rgb-d跨模态行人再识别训练数据集,所采用的深度神经网络往往早早收敛,限制了当前rgb-d跨模态行人再识别算法精度的进一步提升。

技术实现思路

1、本发明的目的克服现有技术存在的不足,为实现以上目的,采用一种基于多尺度特征扩展的行人再识别方法、系统及介质,以解决上述背景技术中提出的问题。

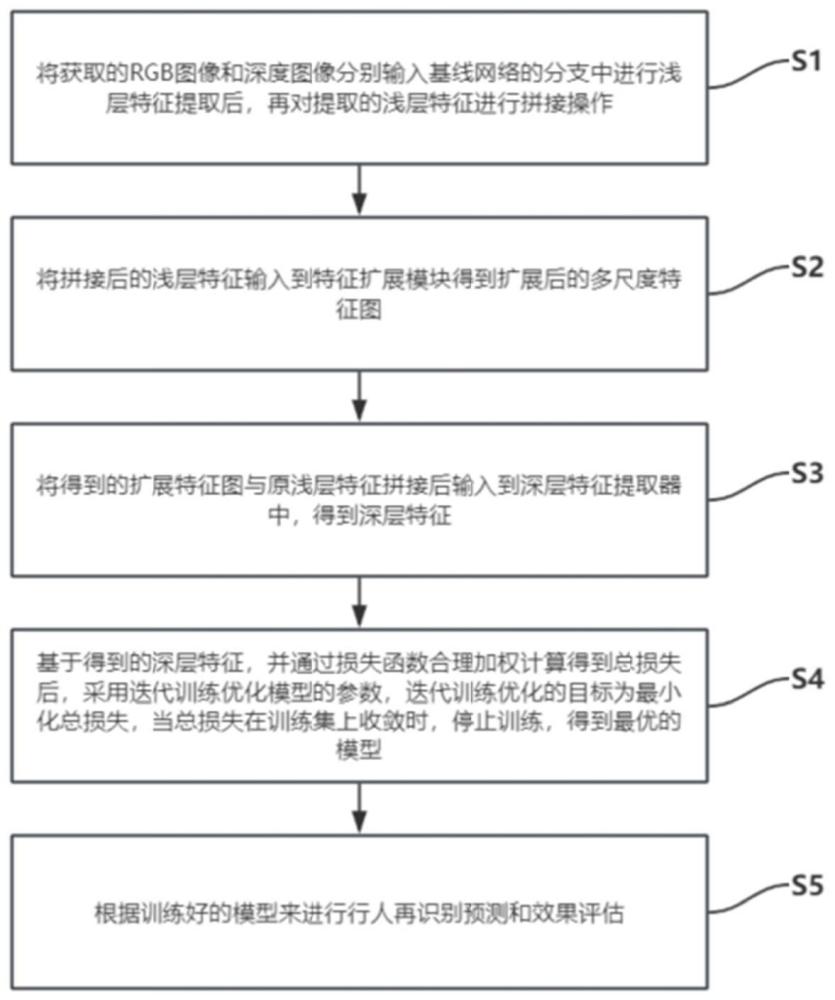

2、一种基于多尺度特征扩展的rgb-d跨模态行人再识别方法,模型包括基线网络,以及多尺度特征扩展模块,所述模型训练方法包括以下步骤:

3、步骤s1、将获取的rgb图像和深度图像分别输入基线网络的分支中进行浅层特征提取后,再对提取的浅层特征进行拼接操作;

4、步骤s2、将拼接后的浅层特征输入到特征扩展模块得到扩展后的多尺度特征图;

5、步骤s3、将得到的扩展特征图与原浅层特征拼接后输入到深层特征提取器中,得到深层特征;

6、步骤s4、基于得到的深层特征,并通过损失函数合理加权计算得到总损失后,采用迭代训练优化模型的参数,迭代训练优化的目标为最小化总损失,当总损失在训练集上收敛时,停止训练,得到最优的模型;

7、步骤s5、根据训练好的模型来进行行人再识别预测和效果评估。

8、作为本发明的进一步的方案:所述步骤s1中的具体步骤包括:

9、获取rgb图像和深度图像的两种模态图像;

10、分别将rgb图像和深度图像输入到基线网络分支的两个浅层特征提取器中,提取浅层特征fv和fd,再进行拼接操作得到拼接特征fu;

11、其中,基线网络由两个参数不共享的浅层特征提取器和一个参数共享的深层特征提取器组成。

12、作为本发明的进一步的方案:所述步骤s2中的具体步骤包括:

13、将浅层特征拼接之后的拼接特征fu输入到多尺度特征扩展模块中;

14、将得到的浅层提取特征图fu的通道数变为其自身大小的1/4,然后将fu分别通过可形变卷积层dcn1,深度可分离卷积层dp1,以及空洞卷积层dl1得到各自输出并相加,然后通过relu激活层来提高模块所提取特征的非线性表示能力,再将通过一个卷积层fc将扩展特征调整为和原拼接特征fu通道数相同,得到生成的扩展特征图具体公式为:

15、

16、其中,i表示由第i个多尺度特征扩展模块的子模块得到的扩展特征向量,多尺度特征扩展模块由两组多尺度信息提取模块组成,每组多尺度信息提取模块分别由一个可形变卷积层dcn1,一个深度可分离卷积层dp1,以及一个空洞卷积层dl1组成。

17、作为本发明的进一步的方案:所述步骤s3中的具体步骤包括:

18、将每个分支得到的扩展特征与原浅层特征fu在第0维拼接组成fs,将fs输入到深层特征提取器中,得到两种模态图像更深层次的深层特征fb。

19、作为本发明的进一步的方案:所述步骤s4中的具体步骤包括:

20、利用深层特征fb计算三元组损失ltri、中心引导对挖掘损失lc,以及正交损失lo;

21、将深层特征fb经过批量归一化(bn)层后得到特征fbl,再将特征fbl输入到softmax层中得到身份概率分布,利用预测的身份概率分布与样本的真实身份标签计算交叉熵损失lce;

22、通过将以上四个损失函数合理加权计算得到总损失ltotal;

23、采用迭代训练优化模型的参数,迭代训练优化的目标为最小化总损失,当总损失在训练集上收敛时,停止训练,得到最优的模型。

24、作为本发明的进一步的方案:所述利用深层特征fb计算三元组损失ltri的具体步骤包括:

25、将特征fb经过平均池化层后得到特征fpl,利用特征fpl计算三元组损失ltri:

26、ltri=max(d(a,p)-d(a,n)+β,0);

27、其中,a是锚点,是取自于其中一个模态的图像特征,p是取自与a相同模态的正样本特征,n是取自于另一个模态的负样本特征,d(a,p)和d(a,n)分别表示锚点与正、负样本之间的距离,β是三元组损失函数的边界值。

28、作为本发明的进一步的方案:所述利用深层特征fb计算中心引导对挖掘损失lc的具体步骤包括:

29、

30、其中d表示计算两个特征之间的欧氏距离;fr和fd分别是rgb模态和深度模态的原始浅层特征;是rgb模态的第i个分支生成的扩展特征;j,k是每个训练批次中的不同行人身份的浅层特征,并且[z]+=max(z,0);

31、式中将生成的rgb模态扩展特征拉向相同身份的深度模态原始浅层特征,以减少生成的rgb模态扩展特征与深度模态之间的模态差异;同时分别将生成扩展与原特征推开使得扩展特征具有更加多样化的特征表示,并且使得类内距离小于类间距离;

32、同时,为了使生成的扩展特征中心具有判别性,引入如下损失:

33、

34、其中cr、cd分别表示rgb模态和深度模态的特征中心;

35、对于深度模态生成的特征中心,同有如下公式:

36、

37、最终的中心引导对损失为lc:

38、

39、作为本发明的进一步的方案:所述利用深层特征fb计算正交损失lo的具体步骤包括:

40、对同一浅层特征生成的多个扩展特征相互正交,以最小化重叠元素,引入正交损失lo:

41、

42、其中,m和n分别表示原始浅层特征生成的第m个和第n个扩展特征。

43、作为本发明的进一步的方案:所述步骤s5中的具体步骤包括:

44、构建跨模态行人再识别任务,设计两种测试方案,即d-rgb测试模式和rgb-d测试模式;

45、在d-rgb测试模式下,待搜索行人以深度图像模态给出,而图库由rgb模态的图像组成;

46、而rgb-d测试模式设置相反,待搜索行人以rgb模态给出,图库由深度图像组成;

47、在robotpku和biwi数据集上进行了对比实验,并输出结果,评估性能。

48、第二方面的技术方案:一种采用如上述任一项所述的一种基于多尺度特征扩展的rgb-d跨模态行人再识别方法的系统,包括:

49、获取模块,用于将获取的rgb图像和深度图像分别输入基线网络的分支中进行浅层特征提取后,再对提取的浅层特征进行拼接操作;

50、特征生成模块,用于将拼接后的浅层特征输入到特征扩展模块得到扩展后的多尺度特征图;并将得到的扩展特征图与原浅层特征拼接后输入到深层特征提取器中,得到深层特征;

51、模型训练模块,用于基于得到的深层特征,并通过损失函数合理加权计算得到总损失后,采用迭代训练优化模型的参数,迭代训练优化的目标为最小化总损失,当总损失在训练集上收敛时,停止训练,得到最优的模型。

52、第三方面的技术方案:一种存储介质,其中存储有处理器可执行的指令,所述处理器可执行的指令在由处理器执行时用于实现如上述任一项所述一种基于多尺度特征扩展的rgb-d跨模态行人再识别方法。

53、与现有技术相比,本发明存在以下技术效果:

54、采用上述的技术方案,通过采用可形变卷积与深度可分离卷积进一步挖掘训练样本图片的行人身体全局特征与通道信息。并且采用了感受野更大的空洞卷积获取更多尺度信息。对原有的中层特征进行扩展得到更多、语义信息更为丰富的行人特征,有效的缓解了由于缺乏高质量训练数据集导致的rgb-d跨模态行人再识别性能低下的问题。

55、为了使得到的扩展特征能够有效的缓解模态差异,本发明提出在联合损失函数机制中引入中心引导对损失函数,该损失函数能够拉近一个模态的扩展特征和另一个模态的原有浅层特征之间的距离,并且拉远相同类间距离和扩展特征与原特征之间的距离。使得在缓解模态差异的同时,模型可以有效的区分开不同身份的行人特征。

- 还没有人留言评论。精彩留言会获得点赞!