基于安全强化学习算法的配电网电压无功控制方法及系统与流程

本发明属于智能强化学习和计算机,具体涉及基于安全强化学习算法的配电网电压无功控制方法。

背景技术:

1、电压无功控制(volt/var control,vvc)是保证配电网电压在允许范围内,最大限度地减少损耗,减少调压装置磨损的关键,然而越来越多分布式资源(distributedresources,drs)的渗透导致配电网vvc的难度不断加大。例如,间歇性的光伏(pv)和风力发电,可能由于其功率快速变化导致电压波动。分布式电源向配电网上游注入实功率会导致电压升高,并干扰传统的vvc控制装置。为了协调vvc设备和分布式资源,人们提出了广泛的基于模型的方法。以配电网电压控制为例,人们提出了混合整数非线性规划模型和混合整数二次约束模型。为了考虑drs的不确定性,提出了随机规划模型。然而,基于随机规划的方法通常假设不确定性的已知概率分布,为了解决这一问题人们又提出了鲁棒优化模型。虽然基于鲁棒优化的方法不需要已知的不确定性概率分布,但它们仍然依赖于一个不确定性集来表征不确定性。

2、通常,基于模型的方法需要一个明确的物理模型来描述配电网,一个精确的统计模型来描述不确定性,一个高效的求解器来在有限的时间内获得最优解。开发这样的方法依赖于广泛的领域知识和在模型选择、参数估计和算法设计方面的人力努力。不适当的物理模型或不准确的参数可能导致性能下降或不现实的解决方案。为了消除配电网对显式模型的依赖和不确定性,基于深度强化学习(drl)技术的无模型方法近年来受到了广泛的关注。对于vvc问题,一些最先进的方法也利用深度神经网络的优势采用了基于drl的方法。例如,有人提出了一种双时间尺度电压控制方案,利用深度q网络优化电容器单元的通断承诺,以维持配电网母线电压。有人开发了一种基于软动作家-评论家的drl算法来优化配电网的电压分布。然而,这些无模型的方法也存在一些问题,首先,在vvc问题中有许多不等式约束,这对于奖励驱动的drl方法来说是棘手的。其次,分布系统表现出严重的不确定性和非线性,这对完全无模型算法的表示和学习能力是一个重大挑战。这些挑战促使我们研究用于vvc问题的安全强化学习(srl)解决方案,因此本发明提出了一种基于安全强化学习算法的配电网电压无功控制方法。

技术实现思路

1、本部分的目的在于概述本发明的实施例的一些方面以及简要介绍一些较佳实施例。在本部分以及本技术的说明书摘要和发明名称中可能会做些简化或省略以避免使本部分、说明书摘要和发明名称的目的模糊,而这种简化或省略不能用于限制本发明的范围。

2、鉴于上述现有存在的问题,提出了本发明。

3、因此,本发明提供了基于安全强化学习算法的配电网电压无功控制方法,能够解决传统的自由表面相关多次波压制方法不能适应海底节点观测方式采集的地震数据的问题。

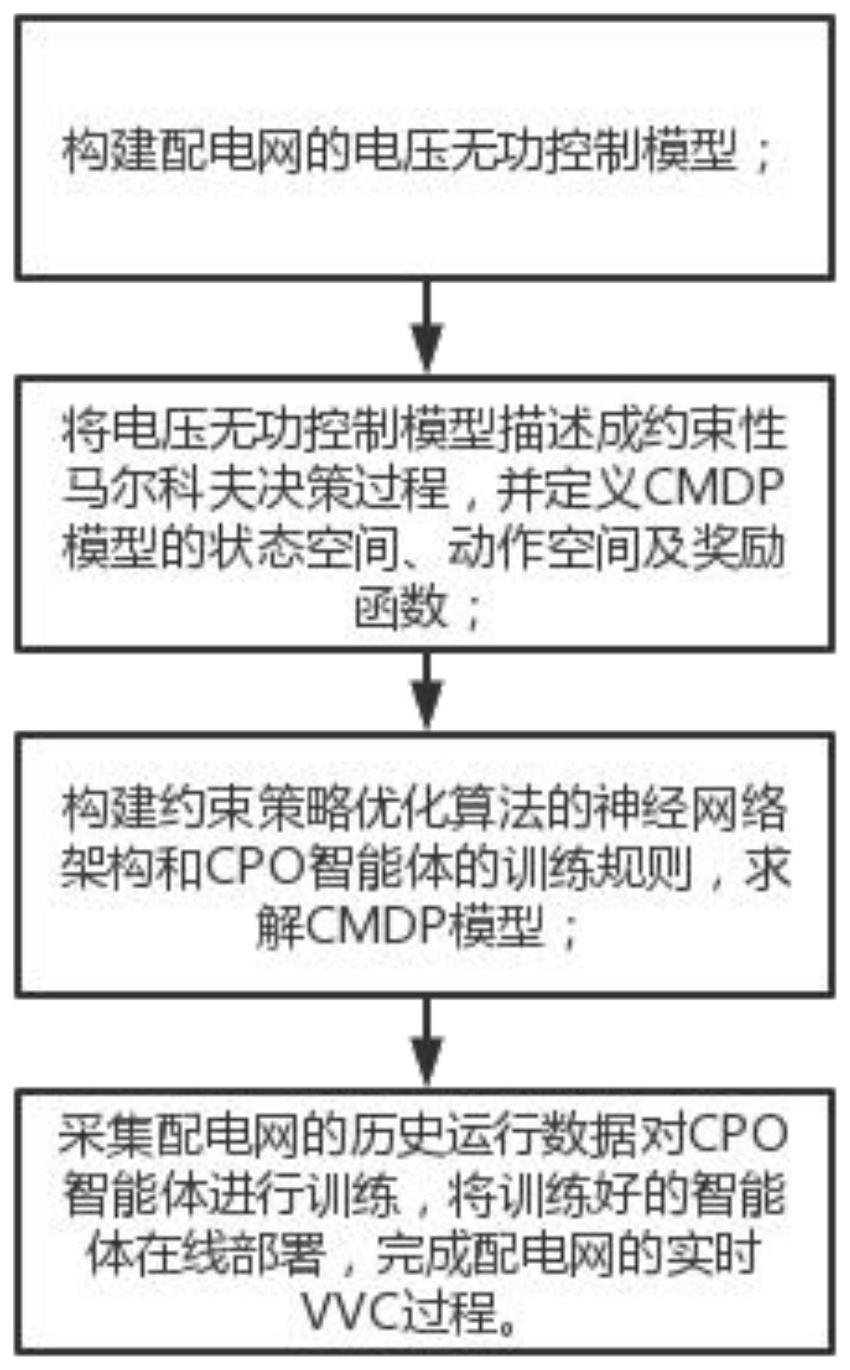

4、为解决上述技术问题,本发明提供如下技术方案,基于安全强化学习算法的配电网电压无功控制方法,包括:

5、构建配电网的电压无功控制模型;

6、将电压无功控制模型描述成约束性马尔科夫决策过程,并定义cmdp模型的状态空间、动作空间及奖励函数;

7、构建约束策略优化算法的神经网络架构和cpo智能体的训练规则,求解cmdp模型;

8、采集配电网的历史运行数据对cpo智能体进行训练,将训练好的智能体在线部署,完成配电网的实时vvc过程。

9、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述电压无功控制模型包括,潮流计算约束模型,pv逆变器和bsss的控制模型;

10、当配电网的运行范围划分为t个时隙时,t∈ωt对时间间隔进行索引,i∈ωn对配电网的节点进行索引,jk∈ωb对配电网的支路进行索引,其中ωt表示时间间隔集合,ωn表示节点集合,ωb表示支路集合;

11、可调度的资源包括pv逆变器和bsss的控制模型,可决策的变量包括pv逆变器输出的无功功率qpv及bsss的有功功率pbsss,qpv决策量的上下限为,

12、qpv,min<qpv,t<qpv,max

13、其中,qpv,t表示i节点pv的无功输出量,qpv,min及qpv,max为t时刻pv的无功裕度;

14、的取值限制为,

15、

16、其中,为节点i的bsss控制变量,和分别表示最大充电功率和最大放电功率;

17、储能的容量限制,在时间间隔t时,bsss中存储的能量约束为,

18、

19、其中,为bsss的能量容量,表示bsss中允许存储的最小能量;

20、以配电网无功优化控制最小化网络有功功率损耗为目的构建t时刻目标函数,

21、

22、其中,f表示t时段内配电网的总有功损耗成本,cp为有功网络损耗的成本系数,ploss(t)为时刻t的有功网络损耗,具体表达式为,

23、

24、其中,gij为支路eij导纳矩阵的实部,ve,i(t)与vf,i(t)分别表示节点i出t时刻电压的实部和虚部,n表示配电网供n个节点;

25、配电网无功优化控制过程中,约束条件分为配电网有功潮流平衡约束及无功潮流平衡约束,有功潮流平衡表示为,

26、

27、其中,bij表示支路eij导纳矩阵的虚部,pi(t)表示节点i处t时刻的有功功率注入量,其计算方式为:

28、pi(t)=pl,i(t)+pibsss(t),i∈ω,t∈ωt

29、其中pl,i(t)表示节点i处t时刻的基础负荷有功功率,pbsss表示bss的有功功率,无功潮流平衡表达式为,

30、

31、其中,qi(t)表示节点i处t时刻的无功功率注入量,其计算方式为,

32、qi(t)=ql,i(t)-qpv,i(t),i∈ωn,t∈ωt

33、其中,ql,i(t)表示节点i处t时刻的基础负荷无功功率,qpv,i(t)表示i节点pv的无功功率输出,节点电压约束如下式:

34、vmin<vi(t)<vmax

35、其中,vmax与vmin分别表示节点电压上下限。

36、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述定义cmdp的状态空间、动作空间及奖励函数包括,

37、所述状态空间包括,t时刻环境状态定义为,

38、st=(x1(t),x2(t),x3(t),...,xn(t))

39、其中,xi(t)表示节点i处的状态信息,各节点xi(t)的具体表达式为:

40、xi(t)=(pi(t),qi(t),vi(t))

41、其中,矩阵特征xi(t)由节点i处的有功功率pi(t)、无功功率qi(t)以及电压幅值vi(t)组成;

42、所述动作空间包括,在t时刻的动作at表示pv的无功输出和bss的有功出力:

43、at={qpv,i(t),pibss(t)},i∈ωn,t∈ωt

44、所述奖励函数包括,配电网vvc的目标是最小化网络损耗,而强化学习的学习目标是最大化累积奖励函数,取反网络损耗作为奖励函数,具体表示为:

45、rt=-cpploss(t)

46、其中,rt为t时刻强化学习智能体所获得的奖励。

47、当节点电压在安全范围内表明约束条件满足,超出则表明违反约束条件,具体如下所示:

48、

49、其中,ct为t时刻强化学习智能体的累积约束。

50、配电网vvc问题的cmdp模型可描述为,

51、

52、s.t.jc(π)≤d

53、其中,jc(π)为强化学习智能体的目标惩罚函数,d为惩罚阈值,jr(π)为强化学习智能体的目标奖励函数,τ为智能体当前的策略。

54、最优决策π*定义为:

55、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述求解cmdp模型包括,使用本地策略搜索寻找最优策略或使用标准策略梯度;

56、所述本地策略搜索包括,局部策略搜索算法通过最近一次迭代的πk附近迭代寻找改进的策略来优化策略,使j(π)最大化,

57、πk+1=arg maxπ∈πj(π)

58、s.t.d(π,πk)≤δ

59、其中,d是距离度量值,δ定义了邻域的大小;

60、典型的局部策略搜索算法是信任域策略优化,使用平均kl散度,

61、

62、其中,πk表示策略k。

63、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述标准策略梯度包括,使用l-2测度d(π,πk)=||θ-θk||2,在πk的邻域最大化线性化目标j(π);

64、通过计算约束函数jc(π)确定策略是否可行,cpo使用代理函数,从收集的样本对πk近似约束和目标,代理函数表示为,

65、

66、

67、

68、其中,表示优势函数,是约束条件下的优势函数,代理函数满足下述条件,

69、

70、当将目标和约束替换为代理函数并根据更新策略得到,

71、

72、

73、策略更新上述公式转换为,

74、

75、

76、

77、由于策略π(s|a)是s和a的函数,利用神经网络参数逼近策略分布参数,并优化神经网络的权值来改进策略。

78、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述利用神经网络参数逼近策略分布参数包括,通过求解优化问题更新参数θ,将上述公式近似为,

79、θk+1=arg maxθ∈θgt(θ-θk)

80、s.t.c+bt(θ-θk)≤0

81、

82、其中,g为梯度b为梯度h为hessian矩阵,c=jc(θk)-d;

83、

84、其中,λ*和ν*是最优对偶解,对于优势函数和如下式所示,

85、

86、

87、其中,γ为折扣因子,r为奖励值,λ是gae参数,值函数和用φ参数化的神经网络逼近,通过最小化平方误差损失来训练:

88、

89、

90、

91、其中,vπk为采取策略k时的价值,c为约束值,l为当前时间步骤,为约束值函数,为奖励值函数,t为第t个时间步骤,φ为值函数的参数,t为总的时间步骤。

92、作为本发明所述的基于安全强化学习算法的配电网电压无功控制方法的一种优选方案,其中:所述采集配电网的历史运行数据包括,配电网的真实的负荷、pv、bsss历史运行数据。

93、本发明的另外一个目的是提供新能源场站多级并行网络快速通讯系统,可以提高配电网的电压稳定性、减少能量损失和设备过载运行,同时也可以使得配电网的电压无功控制更加智能化和自适应。

94、基于安全强化学习算法的配电网电压无功控制方法的系统,其特征在于:包括,模型构建模块,cmdp模型描述模块,强化学习模块,数据采集模块;

95、包括,电压无功控制模型构建模块,cmdp模型转换模块,强化学习智能体训练模块,强化学习智能体测试模块;

96、所述模型构建模块,负责根据配电网的拓扑结构、设备参数、负载信息,构建适合于特定配电网的电压无功控制模型;

97、所述cmdp模型描述模块,将电压无功控制模型转化为约束性马尔科夫决策过程模型,定义状态空间、动作空间和奖励函数;

98、所述强化学习智能体训练模块,包括神经网络架构设计和cpo算法智能体训练规则两个方面,其中训练规则描述了智能体的训练步骤;

99、所述强化学习智能体测试,就是将训练好的智能体进行现场部署,通过输入配电网的观测状态,包括电压、功率、电流信息,得到配电网电压无功控制的决策指令。

100、一种计算机设备,包括存储器和处理器,所述存储器存储有计算机程序,其特征在于,所述处理器执行所述计算机程序时实现如基于安全强化学习算法的配电网电压无功控制方法的步骤。

101、一种计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现如基于安全强化学习算法的配电网电压无功控制方法的步骤。

102、本发明的有益效果:1、提高配电网的安全性和稳定性:通过使用安全强化学习算法,该方法能够动态地调整配电网设备的运行参数,实现对电压无功的精确控制。它能够适应复杂多变的电力系统环境,减轻电压波动带来的潜在风险,保障系统的安全运行。

103、2、优化能源利用和降低损耗:通过协调分布式资源、pv发电和储能系统的运行,该方法能够最大限度地减少配电网的有功损耗并优化电压分布。它利用智能强化学习算法,实现对配电网的无功功率分配的优化,提高电网的能源利用效率。

104、3、自适应性和学习能力:该方法基于强化学习算法,能够根据实时的系统状态进行自适应调节和优化,无需依赖事先建立的物理模型。所提cmdp框架可以独立处理奖励和约束,而不需要为约束违反精心设计具体的奖励函数。同时,它具备学习和优化能力,能够通过与配电网实时交互,不断改进控制策略,提高系统的性能和效果。

105、4、减少人工干预和操作人员工作负担:采用基于安全强化学习算法的方法,能够减少人工干预,降低操作人员的工作负担。系统能够自主学习和决策,实现自动化的电压无功控制,减少对人工操作的依赖,同时cpo算法可以训练复杂的非线性策略来解决具有状态和行为约束的高维控制问题,同时保证单调性能的提高和约束的满足。

106、5、引入创新的技术解决方案:本发明将安全强化学习算法与配电网电压无功控制相结合,为配电网的电力管理领域带来了创新的技术解决方案。它不仅提供了一种新颖的方法来解决电力系统中的电压无功控制问题,还为电力系统的智能化和自主化提供了新的思路和方向。

- 还没有人留言评论。精彩留言会获得点赞!