一种机组组合深度强化学习求解方法

本发明涉及电网机组组合,具体涉及一种机组组合深度强化学习求解方法。

背景技术:

1、机组组合是电力系统运行中的经典问题。它需要确定发电机组的启停方案,以满足电力需求并最大限度地降低成本。由于热力机组的启动或关闭时间长达数小时,因此通常需要提前数小时或一天确定机组启停方案以保持系统稳定运行。近年来,随着可再生能源在传统电网中的渗透率越来越高,在制定机组组合方案时需要额外考虑可再生能源的高利用率。除此之外,可再生能源功率预测误差引起的不确定性对系统运营商造成了新的挑战,需要为应对系统的不确定性制定可靠且经济的机组调度方案。

2、传统的确定性机组组合问题通常被表述为凸优化问题,可以通过数值方法求解,但是计算时间成指数性增长。作为机器学习方法的一个分支,强化学习旨在推导最优决策策略的近似值以最大化系统性能。强化学习算法是在复杂问题中寻找最佳解决方案的强大工具,并且近年来在游戏领域中显示出令人印象深刻的结果,在这些领域中,智能体能够在没有先验知识的情况下依靠自我超越人类专家的表现。目前已经有文献利用强化学习的方法来解决机组组合问题,并且其求解时间能够被大幅缩短。其常规做法首先构建以发电成本最小为目标函数的机组组合数学模型,并以功率平衡、机组出力限制和最小启停时间约束为约束条件,然后将机组组合问题在强化学习框架下完成描述,并对状态空间、动作空间、奖励函数进行定义,最后采用深度q网络算法来训练求解机组组合问题模型。

3、以上工作内容仅限于对确定性的机组组合问题进行求解,并未考虑到电力系统的不确定性如风电出力预测误差。

技术实现思路

1、为解决现有技术中存在的问题,本发明提供一种机组组合深度强化学习求解方法,该方法利用历史风电数据进行深度强化学习模型参数的训练自适应学习风电不确定性对调度方案的影响,从而做出最优的机组组合决策方案。

2、为实现上述目的,本发明采用如下方案:

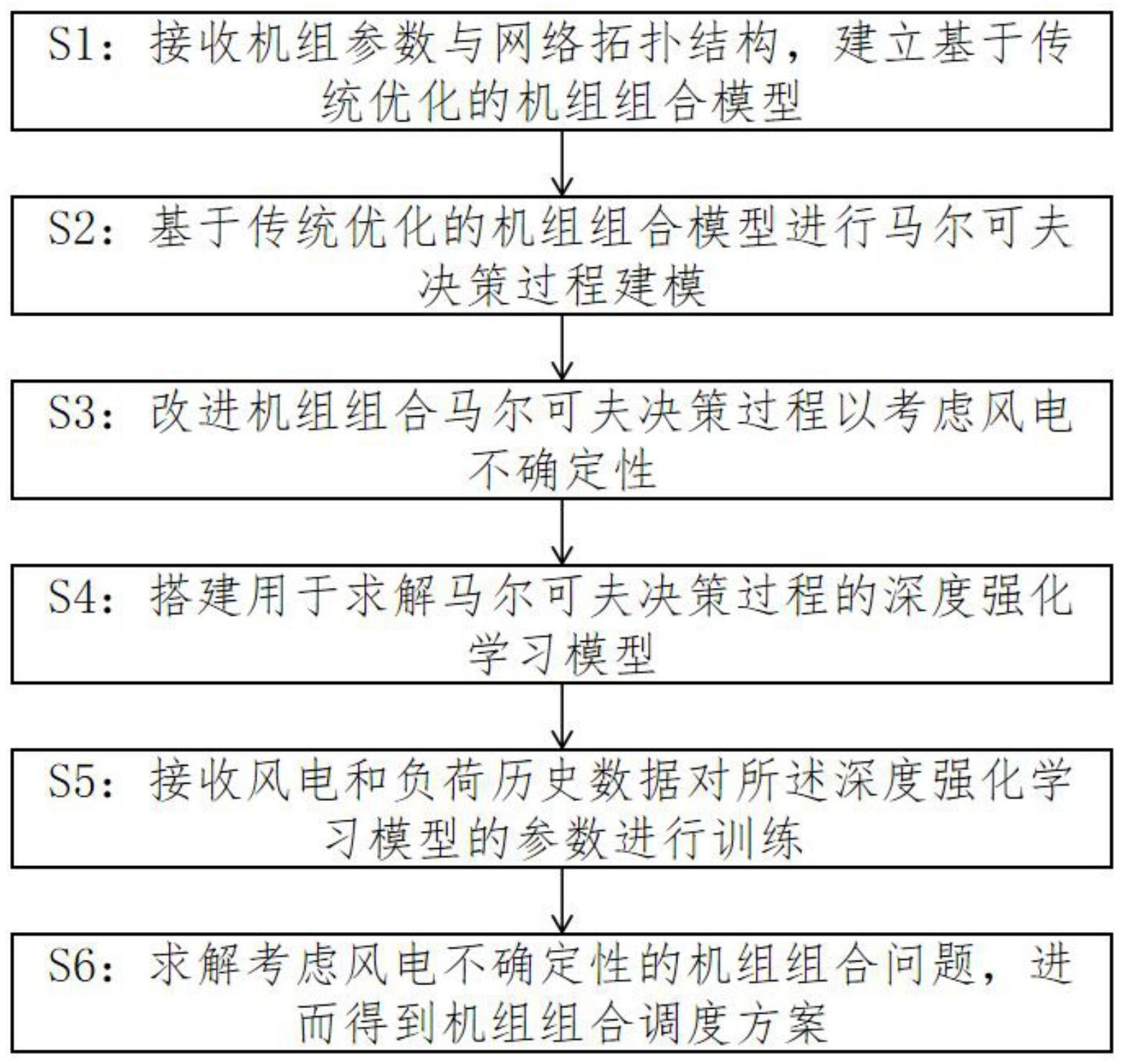

3、本发明提供一种机组组合深度强化学习求解方法,包括以下步骤:

4、s1:接收机组参数与网络拓扑结构,建立基于传统优化的机组组合模型;

5、s2:基于传统优化的机组组合模型进行马尔可夫决策过程建模;

6、s3:改进机组组合马尔可夫决策过程以考虑风电不确定性;

7、s4:搭建用于求解马尔可夫决策过程的深度强化学习模型;

8、s5:接收风电和负荷历史数据对所述深度强化学习模型的参数进行训练;

9、s6:将训练后的所述深度强化学习模型用于求解考虑风电不确定性的机组组合问题,进而得到机组组合调度方案。

10、在一些实施例中,本发明还包括以下技术特征:

11、步骤s1中,所述基于传统优化的机组组合模型包括目标函数、机组运行约束与电力系统约束;

12、所述目标函数表达式为:

13、式中,t是调度时段,n是机组数量,ui,t是第i个机组在t时段的启停状态,pi,t是第i个机组在t时段出力大小,是机组燃料成本函数,是机组启停成本函数,

14、所述机组燃料成本函数表达式为:

15、

16、式中,αi,βi,γi是机组成本二次函数曲线的参数;pi,t是机组的出力大小;

17、所述电力系统约束包括机组容量约束,机组最小启停时间约束,爬坡速率约束;

18、所述机组运行约束包括系统功率平衡约束,旋转备用约束。

19、机组容量约束代表着每个时段机组出力的上下限,所述机组容量约束表达式为:

20、

21、式中,pi是机组出力下限,是机组出力上限,ui,t是机组启停状态;

22、机组最小启停时间约束代表机组处于启动或关停状态所需维持的最小时时长,通常情况下机组容量越大,需要的时间越长,所述机组最小启停时间约束表达式为:

23、

24、

25、式中,tsi是机组最小持续关停时间,toi机组最小持续启动时间;

26、爬坡速率约束代表发电机在一段时间内可以增加或减少的功率输出是有限的;所述爬坡速率约束表达式为:

27、

28、

29、式中,pup,i是机组上爬坡速率,pdown,i是机组下爬坡速率,pshut,i是允许的机组最大功率输出;

30、所述功率平衡约束表达式为:

31、

32、式中,pd,t是系统在时段t的聚合负荷;

33、为了确保系统的稳定运行,旋转备用通常被设为系统负载的10%,所述旋转备用约束表达式为:

34、

35、式中,rt是系统在时段t的旋转备用容量。

36、步骤s2中,所述马尔可夫决策过程包括状态空间,动作空间,奖励函数,环境转移概率,折扣因子五元组,构建所述五元组,将机组组合模型转换为马尔可夫决策过程具体包括以下步骤:

37、s201:构建动作空间:at=[a1,t,…,an,t],an,t∈{0,1}

38、式中,an,t是二元向量,其长度为机组的数量n,取值为0/1,an,t=1代表第n个机组在t+1的时刻会被打开并在该时段内保持开启状态,an,t=0第n个机组在t+1的时刻会被关闭并在该时段内保持关闭状态,整个马尔可夫决策过程的动作空间维度是2n;

39、s202:构建状态空间:st=(bi,dt+1,wt+1,τi,t,t)

40、式中,t是当前调度时段,向量bi包含了机组i的基本信息如最小启停时间,启动成本以及二次燃料曲线的参数;dt+1是t+1的负荷预测值,wt+1是t+1的风力发电预测值,τi,t是机组i在当前时刻t已经被开启/关闭的时段数;

41、s203:构建奖励函数,所述奖励函数是环境返回给智能体的一个标量,该标量反映了当前智能体采取的状态动作映射关系的质量好坏,用于指导智能体根据奖励值的大小调整当前决策策略,所述奖励函数表达式为:

42、

43、式中,是机组燃料成本,是机组启动成本,是负载削减惩罚;所述负载削减惩罚表达式如下:

44、

45、式中,cvoll是减载容量每兆瓦时的单位成本,ζ是减载分辨率,一般取负载的0.1%,负载削减惩罚对代理进行惩罚,避免采取导致减负的不良行为,帮助智能体积极探索可行的解决方案;

46、s204:计算环境转移概率:

47、

48、式中,环境转移概率由环境转移函数决定,环境转移函数将系统当前状态从st转换到st+1,并返回奖励值r,在机组组合问题中,环境转移函数应当严格限制不合法的动作,如违反机组启停约束的开停机动作;

49、所述环境转移概率包括机组运行状态转移,风电预测值转移,负荷预测值转移,其中,风电预测值转移与负荷预测值转移都是将预测值更新到下一个时段的数据;

50、所述机组运行状态转移函数表达式如下:

51、

52、式中,τi,t是机组当前运行/停机时间,根据智能体采取的不同动作,

53、该状态的转移是确定性的。

54、s205:确定折扣因子:所述折扣因子代表智能体对远期奖励和近期奖励的重视程度,取值范围在[0,1]之间。

55、在一些实施例中,所述折扣因子取0.9。

56、步骤s3具体包括以下步骤:

57、s301:采用真实风电数据进行策略学习;

58、为利用无模型强化学习方法的数据驱动特性,避免电力系统建模的复杂随机性,利用真实历史数据的策略学习,即利用真实世界收集的风电数据来学习智能体的策略;在训练过程中,学习风能预测值与实测值之间的变化规律,在掌握其分布特性的基础上,给出了一种能适应实际测试环境的最优调度方案;

59、s302:采用基于状态扰动的马尔可夫决策过程;

60、基于状态扰动的马尔可夫决策过程,实际风电和预测风电之间的修正状态转换过程中,智能体的扰动状态观测定义为预测风功率,使得智能体能够根据随机策略采取相应的动作;而环境仍然从真实状态过渡到下一个状态,并根据实际风电值计算智能体获得的奖励;智能体在原本的根据预测状态学习策略下执行的动作可能是次优的,因此奖励相应减少,在预测状态下奖励较低的动作在探索过程中将较少被采用;

61、s303:采用改进的状态空间;状态空间应尽可能考虑影响决策的因素;在定义状态空间时考虑时序相关性问题,将相邻时期风电功率预测值的变化加入到状态空间中,用风电相邻两个时段的一阶差分形式表示;

62、所述相邻时期风电功率预测值的变化表达式如下:

63、

64、式中,pw,t-1是风电在t-1时段的预测出力值,pw,t是风电在t时段的预测出力值;

65、所述相邻时期风电功率预测值的变化表达式如下:

66、

67、式中,pw,t-1是风电在t-1时段的预测出力值,pw',t-1是风电在t时段的实测出力值;

68、进而,所述改进的状态空间表达式如下:

69、

70、步骤s5中,所述训练包括以下步骤,

71、s501:接收用于训练的历史风电和负荷数据,历史风电需要同时包含风电预测数据以及风电实测数据;

72、s502:行动网络与环境进行交互并将获得的关键信息存储在经验回放池内;行动网络的输出为下一时段机组组合的调度方案,评价网络的输出为状态价值大小;训练过程中智能体与机组组合强化学习环境按时段顺序交互,智能体获取步骤s302中定义的环境状态并输出动作,机组组合强化学习环境计算出步骤s203中定义的标量奖励值给智能体;将整个调度周期每个时段的状态、动作和奖励值在经验池中进行存储;

73、s503:评价网络计算状态价值和折扣奖励,利用计算结果进一步求解优势函数,并对评价网络进行网络权重更新;

74、s504:通过采样网络计算重要性采样比,从而对动作网络进行权重更新;其中采样网络与动作网络共同使用同一权重,但采样网络的权重参数更新滞后于动作网络。

75、步骤s4中,所述深度强化学习模型为基于策略的近端策略优化模型;

76、所述近端策略优化模型基于演员-评论家框架,具有动作网络和评价网络,同时其是基于策略的深度强化学习算法;具有如下特征:通过最大化策略目标函数来逼近和优化策略函数,最终优化得到的策略代表智能体动作的概率分布;基于策略的方法中的最优策略以一定的概率生成动作,即使观察结果相同,结果也可能不同;策略目标函数可以评价当前策略的优劣程度,所述策略目标函数表达式如下:

77、

78、式中,是在当前策略πθ下系统环境处在状态s的概率,πθ(s,a)是智能体根据当前策略πθ观测到状态s后采取动作a的概率,是奖励值;

79、进一步的,所述近端策略优化模型表达式如下:

80、

81、

82、式中,kl(θ,θ')是描述概率分布θ和概率分布)'的kl散度,aθ'(st,at)是在策略θ'下的优势函数;近端策略优化模型直接将kl散度放入要优化的目标函数中,从而可以使用梯度上升算法来最大化目标函数

83、所述近端策略优化模型需要适用于离散的动作空间,其离散化近端策略优化模型的步骤如下:原始的评价网络中,q值函数将状态和动作作为输入,并输出一个q值,因为有无限多种可能的动作;在机组组合马尔可夫决策过程中,动作空间限制为2n个动作,因此可以将其映射到包含每个动作的q值的向量;对于动作网络,动作网络不再需要输出连续动作分布的均值和协方差;相反,动作将直接输出动作空间中所有动作的分类分布;在本发明专利中采用softmax函数应用于最后一层网络层以确保有效的介于0和1之间的概率分布。

84、本发明的有益效果是:

85、1、本发明提出的方法可以自适应考虑风电不确定性,通过将风电出力预测误差对调度方案的影响反映在奖励函数上,该方法只需要借助历史数据即可完成对不确定性的学习,从而避免了像传统鲁棒优化算法/随机优化算法那样需要对随机变量分布的精确描述以及人工选择不确定性预算,避免了主观因素带来的影响。

86、2、本发明提出的方法通过将大量的计算时间离线部署在训练阶段,借助训练好的模型参数完成调度,可以在保证求解精确近似于优化解的同时,大大缩减求解时间。相较于传统的优化算法,该方法通过训练好的深度强化学习智能体,直接输出决策方案,不需要借助求解器求解。

- 还没有人留言评论。精彩留言会获得点赞!