一种视频图像传输方法与流程

1.本公开涉及图像传输领域,尤其涉及一种视频图像传输方法。

背景技术:

2.图像传输是以一定要求进行信源和信道处理,实时地传送或存储图像信息。对视频图像而言,由于此类图像信息量较大,因此通常需要在信源压缩图像信息量使其适应信道的带宽和速率。然而,压缩图像信息量较大会影响信宿处理图像的清晰度,压缩图像信息量较小会对信道带宽和速率提出更高要求。

3.有鉴于此,有必要对现有技术的视频图像传输予以改进,以解决视频图像传输的清晰度问题。

技术实现要素:

4.本发明的实施例提供一种视频图像传输方法,同步传输雷达视频图像和低照度视频图像,并且低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像,利用增强低照度图像增强基础低照度图像,提高视频图像传输的清晰度。

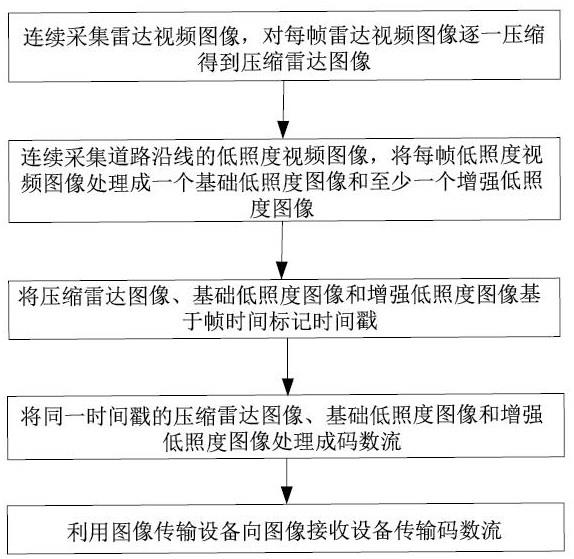

5.为达到上述目的,本发明的实施例采用如下技术方案:一种视频图像传输方法,包括:连续采集雷达视频图像,对每帧雷达视频图像逐一压缩得到压缩雷达图像;连续采集道路沿线的低照度视频图像,将每帧所述低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像;将所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像基于帧时间标记时间戳;将同一时间戳的所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像处理成码数流;利用图像传输设备向图像接收设备传输所述码数流。

6.在一种可能的实现方式中,还包括:将所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像基于gps定位数据标记位置信息;将同一时间戳和同一位置信息的所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像处理成码数流。

7.在一种可能的实现方式中,所述对每帧雷达视频图像逐一压缩得到压缩雷达图像,还包括:对每帧雷达视频图像划分时间域和空间域;根据时间域和空间域裁剪每帧雷达视频图像,得到多张雷达时间域裁剪图像和多张雷达空间域裁剪图像;压缩多张雷达时间域裁剪图像,得到时间域压缩图像;

压缩多张雷达空间域裁剪图像,得到空间域压缩图像。

8.在一种可能的实现方式中,所述将每帧所述低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像,包括:获取每帧所述低照度视频图像;基于时间域和空间域匹配同一帧的所述雷达视频图像和所述低照度视频图像;基于所述雷达视频图像提取所述低照度视频图像的基础信息和至少一个增强信息;根据所述基础信息将所述低照度视频图像处理成所述基础低照度图像,根据至少一个所述增强信息将所述低照度视频图像处理成对应数量的所述增强低照度图像。

9.在一种可能的实现方式中,所述将所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像基于帧时间标记时间戳,包括:所述压缩雷达图像包括时间域压缩图像和空间域压缩图像,每个时间域压缩图像匹配至少一个空间域压缩图像;提取每个时间域压缩图像的时间戳;每个空间域压缩图像对应一个所述基础低照度图像和至少一个所述增强低照度图像;根据所述时间域压缩图像匹配所述空间域压缩图像、所述基础低照度图像和所述增强低照度图像,并在所述空间域压缩图像、所述基础低照度图像和所述增强低照度图像上标记所述时间戳。

10.在一种可能的实现方式中,将同一时间戳的所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像处理成码数流,包括:使用imencode函数处理所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像;将所述压缩雷达图像、所述基础低照度图像和所述增强低照度图像编码成码数流;码数流中增加有时间数据。

11.在本公开中,至少具有如下技术效果或优点:本发明的实施例同步传输雷达视频图像和低照度视频图像,并且低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像,利用增强低照度图像增强基础低照度图像,有效解决了视频图像传输的清晰度问题,进而实现了视频图像传输的清晰度。

附图说明

12.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对本发明实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

13.图1为根据本公开的一些实施例提供的视频图像传输方法流程图一;图2为根据本公开的一些实施例提供的视频图像传输方法流程图二。

具体实施方式

14.下面结合附图所示的各实施方式对本公开进行详细说明,但应当说明的是,这些

angle)可达

±

45度,能探测远达160米的物体。博世中距雷达模块采用英飞凌的扇出rf器件,博世中距雷达模块的mrr雷达系统集成了两个电路板,包括博世、飞思卡尔和意法半导体的电路。rf电路板使用混合ptfe/fr4基板制作非对称结构,并配有平面天线。

23.mrr雷达系统还采用英飞凌77ghz的sige单片微波集成电路(mmic)用作高频发射器和接收器。这两个rf裸片采用由英飞凌研发的嵌入式晶圆级bga(embedded wafer level bga)、扇出晶圆级封装(fan

‑

out wafer level package)。

24.毫米波雷达模块利用它本身的控制系统还可以处理其他雷达传感器、摄像头或超声波传感器的信息。利用毫米波雷达模块与其他雷达传感器、摄像头或超声波传感器的“传感器数据融合”后,毫米波雷达模块结合其他雷达传感器、摄像头或超声波传感器能够得到一个高精确度的图像。

25.本公开实施例的摄像模块,其工作原理是:物体通过镜头聚集的光,通过集成电路把光信号转换成电信号,再经过内部图像处理器转换成数字图像信号输出到数字信号处理器加工处理。本公开实施例的摄像模块包括电荷藕合器件图像传感器,电荷藕合器件图像传感器使用一种高感光度的半导体材料制成,能把光线转变成电荷,通过模数转换器芯片转换成数字信号。电荷藕合器件图像传感器由许多感光单位组成,通常以百万像素为单位。当电荷藕合器件图像传感器表面受到光线照射时,每个感光单位会将电荷反映在组件上,所有的感光单位所产生的信号加在一起,就构成了一帧视频图像。

26.本公开实施例的第三处理模块因为要处理毫米波雷达和摄像头的实时数据,且摄像模块像素值大,因此要对硬件资源的处理能力有较高的要求。优选地,本公开实施例的第三处理模块选用英伟达的jetson tx2嵌入式模块作为数据处理板的核心,通过底板扩展与传感器、上位机等交联的接口。

27.jetson tx2嵌入式模块是基于nvidia pascal架构的ai单模块超级计算机,共两块cpu和一块有256个cuda核心的cpu。cpu一块是双核的denver2,第二块是arm cortexa57。8g的运行内存,32g flash存储器。它性能强大,外形小巧,节能高效,适合机器人、无人机、智能摄像机和便携医疗设备等智能终端设备。支持更大型、更复杂的深度神经网络。

28.jetson tx2嵌入式模块是一个采用多种标准接口、具有高灵活可扩展性的平台,非常适合低能耗和高计算性能的应用。利用linux环境进行预先闪存处理,支持常见的api,且受nvidia完整开发链的支持。处理板具有1路千兆网口、1路usb 3.0,1路usb 2.0,1路串口、2路can、1路hdmi,支持6路摄像机通道。

29.请参阅图2,本公开的实施例提供一种视频图像传输方法,包括:步骤一、连续采集雷达视频图像,对每帧雷达视频图像逐一压缩得到压缩雷达图像;步骤二、连续采集道路沿线的低照度视频图像,将每帧低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像;步骤三、将压缩雷达图像、基础低照度图像和增强低照度图像基于帧时间标记时间戳;步骤四、将压缩雷达图像、基础低照度图像和增强低照度图像基于gps定位数据标记位置信息;步骤五、将同一时间戳和同一位置信息的压缩雷达图像、基础低照度图像和增强

低照度图像处理成码数流;步骤六、利用图像传输设备向图像接收设备传输码数流。

30.在实际应用中,本公开实施例的毫米波雷达模块用于连续采集雷达视频图像;第一处理模块与毫米波雷达模块连接,第一处理模块对每帧雷达视频图像逐一压缩得到压缩雷达图像;摄像模块用于连续采集道路沿线的低照度视频图像;第二处理模块与摄像模块连接,第二处理模块将将每帧低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像;第三处理模块与第一处理模块和第二处理模块连接,第三处理模块先将压缩雷达图像、基础低照度图像和增强低照度图像基于帧时间标记时间戳,第三处理模块然后将同一时间戳的压缩雷达图像、基础低照度图像和增强低照度图像处理成码数流;第三处理模块还将压缩雷达图像、基础低照度图像和增强低照度图像基于gps定位数据标记位置信息,图像传输模块与第三处理模块连接,图像传输模块向图像接收设备传输码数流。

31.本公开实施例先使用各自处理模块对各自图像压缩处理,再利用另外的处理模块将压缩图像处理成数据流,一方面便于视频图像传输和提高视频图像质量,另一方面便于匹配时间戳、gps位置和接收到的视频图像。

32.本公开实施例除了包括毫米波雷达模块、第一处理模块、摄像模块、第二处理模块、第三处理模块和图像传输模块之外,还包括gps模块,gps模块与第三处理模块连接,第三处理模块的传输数据中包含有gps数据。本公开实施例的gps数据包括准确的地理位置和精确的时间信息。本公开实施例的gps数据中精确的时间信息,通过从gps卫星上获取标准的时间信号,时间信号每秒或每分时输出一个脉冲。精确的时间信息为时间戳提供一个基准时间,确保时间戳的时间数据准确度。

33.本公开实施例的第一处理模块包括第一图像压缩芯片和第二图像压缩芯片,第一图像压缩芯片和第二图像压缩芯片并联设置,第一图像压缩芯片和第二图像压缩芯片均与毫米波雷达模块连接;第二处理模块包括第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片,第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片并联设置,第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片均与摄像模块连接;第一图像压缩芯片、第二图像压缩芯片、第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片均与第三处理模块电连接。

34.为了提高雷达压缩图像和低照度视频图像的处理速度,本公开实施例的第一处理模块中第一图像压缩芯片和第二图像压缩芯片优选为tms320c6201dsp芯片,本公开实施例的第二处理模块中第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片优选为tms320c6201dsp芯片。

35.本公开实施例的tms320c6201dsp是一种高性能的定点数字信号处理器。工作频率为200mhz时,每个指令周期为5ns,运算速度可达1600mips;每周期8个32bit的指令并行执行;8个独立的功能单元,有两个16bit乘法器和6个算术逻辑单元;采用加载存储体系结构,数据在多处理单元之间的传输依靠32个32bit的通用寄存器。c6000的存储器寻址空间为32bit,片内有1mbit的sram。片内ram被分为两块:一是存储器,二是内部数据存储器。32bit外部存储器接口可与不同存储器接口,可方便地配置不同速度、不同容量、不同复杂程度的存储器。此外,c6000还有两通道dma处理器、16bit的主机接口hpi、两个多通道缓冲串口,并且其片内锁相环时钟发生器,可以对输入时钟进行不同的倍频处理。这种芯片用来处理图

像压缩这种运算密集型的工作是非常合适的。

36.本公开实施例的第一处理模块还包括第一fpga芯片,第一图像压缩芯片和第二图像压缩芯片均与第一fpga芯片连接;第二处理模块还包括第二fpga芯片,第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片均与第二fpga芯片连接。

37.本公开实施例的第一fpga芯片和第二fpga芯片,属于专用集成电路中的一种半定制电路,是可编程的逻辑列阵。第一fpga芯片主要是调配第一图像压缩芯片和第二图像压缩芯片处理第几帧雷达视频图像,第二fpga芯片主要是调配第三图像压缩芯片、第四图像压缩芯片和第五图像压缩芯片处理第几帧低照度视频图像。

38.本公开实施例的第一fpga芯片连接第一缓存电路,第二fpga芯片连接第二缓存电路;第一缓存电路和第二缓存电路连接。本公开实施例设置的缓存电路是一种存储器,用于临时存储数据。提高第一至第五图像压缩芯片的处理速度。

39.图1和图2中步骤一的对每帧雷达视频图像逐一压缩得到压缩雷达图像,具体为:对每帧雷达视频图像划分时间域和空间域;根据时间域和空间域裁剪每帧雷达视频图像,得到多张雷达时间域裁剪图像和多张雷达空间域裁剪图像;压缩多张雷达时间域裁剪图像,得到时间域压缩图像;压缩多张雷达空间域裁剪图像,得到空间域压缩图像。

40.本公开实施例的时间域,是指雷达视频图像中对象在t1时刻的状态,连续采集雷达视频图像,可以获取同一对象在t1

……

tn时刻的连续状态变化。由于雷达视频图像中有多个甚至无数对象,为了区分对象,本公开实施例还引入了空间域,本公开实施例的雷达视频图像还针对不同对象在每帧图像的空间中划分空间区域。

41.本公开实施例采集的雷达视频图像,基于时间域裁剪目标对象的图像,得到雷达时间域裁剪图像,由于单帧雷达视频图像有多个目标对象,因此本公开实施例基于时间域可以得到多张雷达时间域裁剪图像。

42.本公开实施例采集的雷达视频图像,基于空间域裁剪雷达视频图像,主要是对不同对象在每帧图像的空间中划分空间区域。

43.本公开实施例多张雷达时间域裁剪图像压缩成时间域压缩图像时,也可以把多张雷达时间域裁剪图像的同一目标对象提取出来拼接成一张雷达时间域裁剪图像。

44.图1和图2中步骤二的将每帧低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像,包括:获取每帧低照度视频图像;基于时间域和空间域匹配同一帧的雷达视频图像和低照度视频图像;基于雷达视频图像提取低照度视频图像的基础信息和至少一个增强信息;根据基础信息将低照度视频图像处理成基础低照度图像,根据至少一个增强信息将低照度视频图像处理成对应数量的增强低照度图像。

45.本公开实施例的低照度视频图像处理成基础低照度图像和至少一个增强低照度图像,分成图像输入、图像处理和图像输出。本公开实施例的图像输入就是将低照度视频图像输入值图像处理。本公开实施例的图像处理过程为:#裁剪(crop)

image=cv2.imread(

‘

低照度视频图像’) #读取低照度视频图像;sp=image.shape #读取图像的形状信息并通过数组输出[图像的高,图像的宽,图像通道数];h=sp[0];w=sp[1];#基础低照度视频图像某个区域,可配合random库随机基础,也可以自设基础范围;y1=int((1/3)*h);y2=int((2/3)*h);x1=int((1/3)*w);x2=int((2/3)*w);img=image[y1:y2,x1:x2];#将低照度视频图像左上角视为原点,基础y1到y2、x1到x2的区域;#第一增强低照度视频图像(roating);h,w=image.shape[:2];center=(h//2,w//2)#第一增强对象;#低照度视频图像第一增强;#degree第一增强角度,size第一增强后的大小,等比例第一增强。

[0046]

m = cv2.getrotationmatrix2d(center, degree, size) ;#执行第一增强操作,roated为第一增强后的低照度视频图像;roated = cv2.warpaffine(image, m, (w, h)) ;#第二增强(flip) ;image=cv2.imread(path) ;image=cv2.flip(image,1) #低照度视频图像第二增强;#第三增强;image=cv2.imread(path) ;image=cv2.resize(image,(192,192)) #低照度视频图像第三增强后的图像。

[0047]

本公开实施例的图像输出就是将基础低照度图像和三张增强低照度图像从图像处理输出。

[0048]

图1和图2中步骤三的将压缩雷达图像、基础低照度图像和增强低照度图像基于帧时间标记时间戳,包括:压缩雷达图像包括时间域压缩图像和空间域压缩图像,每个时间域压缩图像匹配至少一个空间域压缩图像;提取每个时间域压缩图像的时间戳;每个空间域压缩图像对应一个基础低照度图像和至少一个增强低照度图像;根据时间域压缩图像匹配空间域压缩图像、基础低照度图像和增强低照度图像,并在空间域压缩图像、基础低照度图像和增强低照度图像上标记时间戳。

[0049]

本公开实施例在空间域压缩图像、基础低照度图像和增强低照度图像上标记时间戳,其目的是便于图像接收设备按照时间点存储、处理空间域压缩图像、基础低照度图像和

增强低照度图像。

[0050]

图1和图2中步骤四的将同一时间戳的压缩雷达图像、基础低照度图像和增强低照度图像处理成码数流,包括:使用imencode函数处理压缩雷达图像、基础低照度图像和增强低照度图像;将压缩雷达图像、基础低照度图像和增强低照度图像编码成码数流;码数流中增加有时间数据。

[0051]

本公开实施例同步传输雷达视频图像和低照度视频图像,并且低照度视频图像处理成一个基础低照度图像和至少一个增强低照度图像,利用增强低照度图像增强基础低照度图像,有效解决了视频图像传输的清晰度问题,进而实现了视频图像传输的清晰度。

[0052]

上文所列出的一系列的详细说明仅仅是针对本公开的可行性实施方式的具体说明,它们并非用以限制本公开的保护范围,凡未脱离本公开技艺精神所作的等效实施方式或变更均应包含在本公开的保护范围之内。

[0053]

对于本领域技术人员而言,显然本公开不限于上述示范性实施例的细节,而且在不背离本公开的精神或基本特征的情况下,能够以其他的具体形式实现本公开。因此,无论从哪一点来看,均应将实施例看作是示范性的,而且是非限制性的,本公开的范围由所附权利要求而不是上述说明限定,因此旨在将落在权利要求的等同要件的含义和范围内的所有变化囊括在本公开内。不应将权利要求中的任何附图标记视为限制所涉及的权利要求。

[0054]

此外,应当理解,虽然本说明书按照实施方式加以描述,但并非每个实施方式仅包含一个独立的技术方案,说明书的这种叙述方式仅仅是为清楚起见,本领域技术人员应当将说明书作为一个整体,各实施例中的技术方案也可以经适当组合,形成本领域技术人员可以理解的其他实施方式。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1