基于显示终端的智能灯光调节方法、装置及存储介质

1.本发明涉及人工智能技术领域,具体地说,涉及基于显示终端的智能灯光调节方法、装置及存储介质。

背景技术:

2.随着互联网技术的飞速发展,教育平台产业正在快速崛起。无论是慕课的建设,还是教学直播,大多需要教师出镜,面对电脑进行授课。教师的样貌,尤其是面部,会近距离被电脑摄像头记录下来。通常教师授课的环境较为简单,日常直播授课是在办公室或者家中,通过笔记本电脑采集教师图像。

3.笔记本电脑自带摄像头的最大优点是方便使用,无需考虑安装任何驱动,也不用安插任何硬件,在启动电脑的同时,就可以方便的接入摄像头。但是在低照明度、人员离摄像头过近等特殊环境下,采集的视频图像画面质量较差,存在画面模糊,噪点多,画面色彩暗淡,图像几何畸变,视觉立体效果差等问题。一方面,处于教学一线的教师,尴尬于皮肤灰暗,人脸变形,体验感很差,面对镜头信心不足,影响教学水平的正常发挥;另一方面,作为教学的主体的学生,看不清老师的肢体动作和表情,知识的传达也受到阻碍,影响学习效果。

4.为了给师生带来感官上的享受,教学演播现场光线和摄像头的布置对教学效果起到举足轻重的作用。但是目前的笔记本电脑虽然在软硬件,包括主板、显卡、cpu、硬盘的内部性能和外观上都做了大量的改进,但是对于摄像头和灯光的改进却不大,依然沿用在笔记本电脑屏幕上方居中位置,放置一个摄像头。部分笔记本电脑摄像头附近虽然会有一个led补光灯,但是亮度色度不可调节,只能有照亮屏幕前方的效果,因此主讲人和观众的体验感有待提升。

技术实现要素:

5.为解决以上问题,本发明公开一种基于显示终端的智能灯光调节方法,包括以下步骤:通过置于显示终端四周边缘的主摄像头和辅助摄像头拍摄人物脸部图像,并将各人物脸部图像融合形成融合图像,其中,在所述显示终端四周边缘间隔设置有多个灯组,每个灯组又包含有至少一个灯珠;通过反复拍摄人物脸部图像获得融合图像输入第一神经网络模型,所述第一神经网络模型包括依次连接的第一输入层、第一中间层、第一输出层,所述第一神经网络模型通过将所述融合图像与标准图像对比,直至损失函数总损失小于或等于损失阈值,则第一输出层输出第一灯组控制指令给灯组,其中,标准图像对应有一组各灯组的灯珠亮度和色度的数值;获取背景音乐,将所述背景音乐输入到第二神经网络模型中,所述第二神经网络模型包括依次连接的第二输入层、第二中间层、第二输出层,所述第二中间层提取音乐节

拍,所述第二输出层根据音乐节拍分类获得音乐风格情感信息,并根据不同音乐风格情感信息输出第二灯组控制指令给各灯组;在背景音乐停止后,将第二灯组控制指令切换为第一灯组控制指令。

6.可选地,辅助摄像头包括在所述主摄像头两侧的第一辅助摄像头、第二辅助摄像头,所述主摄像头从正面拍摄人物脸部rgb图像,第一辅助摄像头为大光圈的黑白摄像头,将第一辅助摄像头拍摄的黑白图像上获取的人物脸部图像的光亮强度补偿到主摄像头拍摄的人物脸部rgb图像,获取增强图像;第二辅助摄像头为彩色摄像头,利用三角定位原理计算被拍摄人物距离显示终端的距离z,与所述增强图像进行背景虚化和立体感重建,获得融合图像。

7.可选地,所述第一中间层基于retinex理论将融合图像分解为融合图像反射图和融合图像光照图,所述第一输出层将融合图像反射图与标准图像的标准图像反射图进行比对,将融合图像光照图与标准图像的标准图像光照图进行比对,将与所述标准图像反射图、所述标准图像光照图对比的损失采用加权求和的方式获得损失函数总损失。

8.可选地,在将所述融合图像输入到第一神经网络模型之前,先进行几何畸变校正。

9.可选地,所述第二中间层通过隐马尔可夫模型提取音乐节拍,所述第二输出层采用支持向量机对所述音乐节拍分类,获得音乐风格情感信息。

10.可选地,所述标准图像为多个,每个标准图像都设置有一组各灯珠亮度和色度的数值,事先切换不同的标准图像给第一神经网络模型,从而根据不同的标准图像输出不同的第一灯组控制指令。

11.可选地,所述将第一辅助摄像头拍摄的黑白图像上获取的人物脸部图像的光亮强度补偿到主摄像头拍摄的人物脸部rgb图像,获取增强图像,包括:采用亮度通道直接替换法或者分层融合的方法,获取增强图像。

12.可选地,对应每一音乐风格情感信息设置有一种第二灯组控制指令。

13.本发明还提供一种基于显示终端的智能灯光调节装置,融合图像生成模块,用于通过置于显示终端四周边缘的主摄像头和辅助摄像头拍摄人物脸部图像,并将各人物脸部图像融合形成融合图像,其中,在所述显示终端四周边缘间隔设置有多个灯组,每个灯组又包含有至少一个灯珠;第一灯组控制指令生成模块,用于通过反复拍摄人物脸部图像获得融合图像输入第一神经网络模型,所述第一神经网络模型包括依次连接的第一输入层、第一中间层、第一输出层,所述第一神经网络模型通过将所述融合图像与标准图像对比,直至损失函数总损失小于或等于损失阈值,则第一输出层输出第一灯组控制指令给灯组,其中,标准图像对应有一组各灯组的灯珠亮度和色度的数值;第二灯组控制指令生成模块,用于获取背景音乐,将所述背景音乐输入到第二神经网络模型中,所述第二神经网络模型包括依次连接的第二输入层、第二中间层、第二输出层,所述第二中间层提取音乐节拍,所述第二输出层根据音乐节拍分类获得音乐风格情感信息,并根据不同音乐风格情感信息的组合输出第二灯组控制指令给各灯组;指令切换模块,用于在背景音乐停止后,将第二灯组控制指令切换为第一灯组控制指令。

14.本发明还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机

程序,所述计算机程序包括程序指令,所述程序指令被处理器执行时,实现如下步骤:通过置于显示终端四周边缘的主摄像头和辅助摄像头拍摄人物脸部图像,并将各人物脸部图像融合形成融合图像,其中,在所述显示终端四周边缘间隔设置有多个灯组,每个灯组又包含有至少一个灯珠;通过反复拍摄人物脸部图像获得融合图像输入第一神经网络模型,所述第一神经网络模型包括依次连接的第一输入层、第一中间层、第一输出层,所述第一神经网络模型通过将所述融合图像与标准图像对比,直至损失函数总损失小于或等于损失阈值,则第一输出层输出第一灯组控制指令给灯组,其中,标准图像对应有一组各灯组的灯珠亮度和色度的数值;获取背景音乐,将所述背景音乐输入到第二神经网络模型中,所述第二神经网络模型包括依次连接的第二输入层、第二中间层、第二输出层,所述第二中间层提取音乐节拍,所述第二输出层根据音乐节拍分类获得音乐风格情感信息,并根据不同音乐风格情感信息输出第二灯组控制指令给各灯组;在背景音乐停止后,将第二灯组控制指令切换为第一灯组控制指令。

15.本发明的基于显示终端的智能灯光调节方法、装置及存储介质不仅适用于笔记本电脑,也适用于包括笔记本电脑、台式机显示器、手机、大屏等所有显示器,可以应用于网络直播、线上教学、视频会议等。

16.本发明具有以下有益效果:(1)通过在显示终端的边缘设置摄像头以及多个灯珠,利用神经网络模型将摄像头拍摄的图像与标准图像比较,输出指令来智能自适应调节灯光,从而调节人脸肤色和清晰度;(2)通过两个辅助摄像头可以有效配合中央主摄像头,提升画面的立体效果,达到虚化更自然,人物更突出的效果;(3)可以根据背景音乐节拍,确定音乐风格情感信息,从而对显示终端的灯光进行亮度、色度智能控制,以适合音乐风格情感信息。

17.(4)也可以根据音乐风格情感信息,或者主讲人手动选择背景图片进行叠加,烘托授课现场气氛。

附图说明

18.通过结合下面附图对其实施例进行描述,本发明的上述特征和技术优点将会变得更加清楚和容易理解。

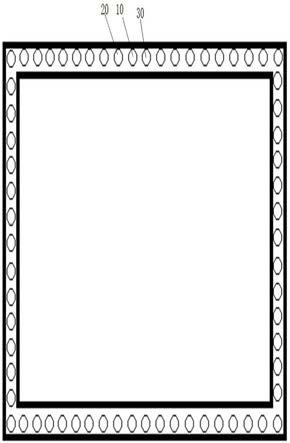

19.图1是表示本发明实施例的显示终端的示意图;图2是表示本发明实施例的第一神经网络模型控制灯组的流程图;图3是表示本发明实施例的第一神经网络模型的图像对比的原理图;图4是表示本发明实施例的第二神经网络模型控制灯组的流程图。

具体实施方式

20.下面将参考附图来描述本发明所述的实施例。本领域的普通技术人员可以认识到,在不偏离本发明的精神和范围的情况下,可以用各种不同的方式或其组合对所描述的

实施例进行修正。因此,附图和描述在本质上是说明性的,而不是用于限制权利要求的保护范围。此外,在本说明书中,附图未按比例画出,并且相同的附图标记表示相同的部分。

21.本实施例的基于显示终端的智能灯光调节方法,包括以下步骤:步骤s2,通过置于显示终端四周边缘的主摄像头10,以及在所述主摄像头两侧的辅助摄像头分别拍摄人脸图像,并将各人脸图像融合形成融合图像,其中,在所述显示终端四周边缘间隔设置有多个灯组,每个灯组又可能包含有多个灯珠,各灯组之间可以独立控制或统一控制,同一灯组的灯珠也可以统一控制或者也可以单独控制。灯组可以是设置在四周的一个边缘,也可以是设置在四周的多个边缘。另外,拍摄图像的区域并没有限定,也可以是上半身图像,可以根据需要自行调节摄像头达到目的。

22.其中,所述显示终端可以是例如笔记本电脑、ipad、手机、台式电脑显示器、大屏等。下文中都以笔记本电脑为例来说明,主摄像头10可以是设置在笔记本电脑屏幕的上部边缘中间位置,而第一辅助摄像头20和第二辅助摄像头30分别在主摄像头的两侧。

23.所述主摄像头10从正面拍摄人物脸部彩色高清图像(rgb图像),其中第一辅助摄像头为大光圈的黑白辅助摄像头(mono),利用黑白摄像头的大光圈,可以保证足够进光量,以主摄像头拍摄的彩色图像为主体,将黑白摄像头拍摄的黑白图像上获取的人物脸部图像的光亮强度补偿到彩色图像上,将两个图像融合,获得增强图像,让画面景物细节更清晰。将主摄像头的彩色图像与该黑白图像融合的步骤如下:(1)将rgb图像和mono图像都分别转换为lab图像;(2)将rgb图像对应的lab图像的l通道替换为mono图像对应的lab图像的l通道;(3)将rgb图像对应的lab图像从lab空间转换会rgb色彩空间。

24.或者也可以采用分层融合的方法,如li s, kang x, hu j. image fusion with guided filtering[j]. ieee transactions on image processing, 2013, 22(7): 2864

‑

2875。

[0025]

第二辅助摄像头为彩色摄像头(rgb图像),与主摄像头相配合,利用三角定位原理,来计算被摄人物距离屏幕的距离z,从而实现背景虚化和立体感重建。

[0026]

其中,t是第二辅助摄像头与主摄像头的距离;f为感光传感器到焦平面的距离;为被摄人物与主摄像头连线与焦平面的交点;为被摄人物与第二摄像头连线与焦平面的交点。

[0027]

步骤s4,将所述融合图像输入到第一神经网络模型中,所述第一神经网络模型包括依次连接的第一输入层、第一中间层、第一输出层。所述第一输入层用于接收该融合图像,所述第一中间层包括依次连接的五个卷积层和一个激活函数层,激活函数层可以采用sigmoid函数。如图3所示,所述第一中间层基于retinex理论(视网膜大脑皮层理论)将融合图像分解为融合图像反射图和融合图像光照图,其中反射图表达了包括物体材质、颜色等在内的与光照环境无关的物体本征反射特性,而光照图则包含了光照环境与物体几何结构作用后的明暗信息。所述第一输出层将融合图像反射图、融合图像光照图与标准图像的标

准图像反射图、标准图像光照图进行比对,将与标准图像反射图、标准图像光照图对比的损失采用加权求和的方式获得损失函数总损失。将损失函数总损失与损失阈值进行比较,若小于或等于损失阈值,则说明融合图像的光照情况优于或等于标准图像的光照情况。若大于损失阈值,则通过调节各灯组的亮度和色度,灯光调节后再次拍摄人物脸部图像,输入到第一神经网络模型,直到损失函数总损失小于或等于损失阈值,则完成灯组调节,并在此灯光条件下进行视频输出。

[0028]

其中,标准图像对应有一组各灯珠亮度和色度的数值。当然也可以设置多个标准图像,每个标准图像都设置有一组各灯珠亮度和色度的数值。光照图比较的是光照度,在此不做详述,而通过比较反射图可以反映出与标准图像的反射特性的差异,反射特性差异越大,则反射图损失越大,反射特性差异越小,则反射图损失越小。反射图损失越小,则表示融合图像反射图与标准图像发射图的反射特性更接近,则更能够体现与标准图像中人物环境反射光线更接近的反射状况,将反射图损失与光照图损失相结合,可以更加准确的获得接近标准图像所对应的灯光效果。

[0029]

其中,决定物体反射特性的因素主要是物体表面状况,例如材质、颜色。具体对图像中物体材质的识别方法可以使用《基于卷积神经网络和集成学习的材质识别和分割方法研究,北京交通大学,李婉婉》中的方法。颜色的识别可以通过rgb图像的三通道进行对比来识别。例如,假设衣服材质相同,标准图像中人物的衣服颜色是黄色,而融合图像人物的衣服颜色是白色,由于白色的反射率更高,在同样的灯光下,拍摄效果也是不同的,而考虑了反射率的差异,能够使得第一神经网络模型尽可能的选择与标准图像中的颜色的反射率更接近的情况下的灯光指令。

[0030]

设定损失函数总损失λ=λ1 *反射图损失+λ2*光照图损失其中,反射图损失是指标准图像反射图与融合图像反射图对比后的损失的绝对值;光照图损失是指标准图像光照图与融合图像光照图对比后的损失的绝对值;λ1和λ2分别为反射图损失、光照图损失的占比权重。可以以光照图损失为主,反射图损失为辅,将光照图损失的权重设定大于0.5。

[0031]

如图2所示,选定标准图像后,在led灯珠当前亮度的情况下,主摄像头、第一、第二辅助摄像头拍摄图像,形成融合图像后输入给第一神经网络模型,第一神经网络模型根据灯组内的各灯珠的色度范围、亮度范围、灯珠坐标等参数输出第一灯组控制指令给各灯珠。各灯珠根据指令发生亮度和色度变化后,再次拍摄并形成融合图像输入给第一神经网络模型,如此反复,直至损失函数总损失小于或等于损失阈值,则完成灯组调节。

[0032]

进一步地,在将融合图像输入到第一神经网络模型之前,先进行几何畸变校正。几何畸变是由于图像中的像素点发生位移而产生的。通过中央主摄像头和第二辅助摄像头,对像素的位置重新映射,可以利用opencv的undistort()方法实现几何畸变校正。设uov为正常图像的坐标系,o为畸变后的坐标系。k1、k2、k3为径向畸变系数,p1、p2为切向畸变系数。其数学算法原理为:径向畸变数学模型

其中,(x,y)为正常图像的坐标点。

[0033]

切向畸变数学模型。

[0034]

步骤s6,如图4所示,获取背景音乐,将所述背景音乐输入到第二神经网络模型中,所述第二神经网络模型包括第二输入层、第二中间层、第二输出层,所述第二中间层通过隐马尔可夫模型(hmm)提取音乐节拍(ryyn

ä

nen m p, klapuri a p. automatic transcription of melody, bass line, and chords in polyphonic music[j]. computer music journal, 2008, 32(3): 72

‑

86.),第二输出层根据音乐节拍进行音乐风格情感信息的分类。所述第二输出层根据不同音乐风格情感信息输出第二灯组控制指令给各灯组,并在该灯光条件下进行视频输出。可以对应不同的音乐风格情感信息设置几种第二灯组控制指令,使得灯组的灯光能够与该组合所营造的音乐氛围匹配。比如红色风格或者热情洋溢的歌曲,采用黄色和红色等暖色灯光;温婉宁静的歌曲,采用冷色调,比如淡蓝色。灯光可以随节拍进行闪烁或者明暗变换。

[0035]

音乐风格情感信息的识别,都可以在提取音色特征、旋律及和声特征、节奏特征基础上,采用分类网络,比如支持向量机等方法进行实现。其中,所述音乐风格是指各种音乐要素结合产生的某一种显著的或独特的音响,音乐要素包括曲调、节奏、音色、力度、和声、织体和曲式等,例如民歌、戏曲、爵士音乐等音乐风格。

[0036]

所述音乐情感是指例如伤感、喜庆、安静、甜蜜等从听觉效果上可以使人展现出某种情绪的音乐。其中,该第二灯组控制指令包括例如灯光亮度变化频率、灯光色度变化频率、灯光亮度变化幅值、灯光色度变化幅值等。所述第二灯组控制指令与第一灯组控制指令不同,第一灯组控制指令主要用于通过控制灯珠的亮度和色度来使得显示终端的画面清晰。所述第二灯组控制指令则是用于与不同的音乐风格情感信息形成匹配的灯光效果。

[0037]

步骤s8,在背景音乐停止后,将第二灯组控制指令切换为第一灯组控制指令,并保持视频输出。

[0038]

进一步地,根据音乐风格情感信息的识别,还通过查找背景图像库,从其中查找与音乐情感相匹配的背景图像,并将该背景图像作为背景叠加在人物图像下层。其中,与音乐情感相匹配的背景图像,可以是在背景图像库中事先设定好的,例如,悲伤的音乐,其背景图像可以是车站的离别,例如喜庆的音乐,可以是庆典图像等。例如蒙古族歌曲,则展现辽阔的草原等相关图像。更进一步地,当第二神经网络模型识别出音乐风格情感信息后,根据音乐情感在情感图片库中查找与其相对应的图像。该情感图片库中事先存储有表达各种情感的图片。将各图片所表达的情感信息与音乐情感求取相似度,例如余弦相似度,相似度达到或超过相似度阈值,则判定该图片符合该音乐情感。与该情感信息相符的可能有多张图片,可以是随机选取其中一张作为背景,也可以依次按余弦相似度排列,选取相似度最高的作为背景。

[0039]

以上所述仅为本发明的优选实施例,并不用于限制本发明,对于本领域的技术人

员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1