用于协作通信的基于深度学习的多分支联合检测方法

:

1.本发明涉及协作通信的信号处理技术领域,具体的说是一种能够有效对多节点信号进行处理、消除通信过程中的码间干扰的用于协作通信的基于深度学习的多分支联合检测方法。

背景技术:

2.协作通信具有很多优势,包括提高系统的链路可靠性等。但链路可靠性的提高在一定程度上取决于能否对来自于多节点的信号进行有效处理。特别是有些环境下的信道具有频率选择性,还需考虑码间干扰(isi,inter-symbol interference)的有效消除。

3.目前大多数研究将多节点信号的合并和均衡独立考虑,且均衡通常都是采用传统的均衡算法。为了取得更好的协作性能,现有技术中已经提出了一种多分支联合检测器(mjd,multi-branchjoint detector),该检测器联合实现了多分支合并和均衡,相对于分离的多分支合并和均衡,能取得显著的性能改善。但其均衡采用的是传统均衡算法和线性结构,消除码间干扰的能力受到了限制。近年来人工智能算法为这一问题的解决带来了可能,特别是深度学习算法的提出,因为其具有极好的非线性拟合能力。现有技术里最早使用多层感知器(mlp,multilayer perceptrons,)对非线性信道进行均衡,不过其结构比较简单,且仅能够处理多径信道数很少的情况。此外还有研究人员分别利用深度神经网络(dnn,deep neural network)、长短期记忆网络(long short-term memory,lstm)、卷积神经网络(cnn,convolutional neural network)对点对点正交频分复用(ofdm,orthogonal frequency division multiplex)系统中的信道均衡进行了研究,但这些方法在单载波条件下效果并不理想。

4.据调研所知,目前还没有基于深度学习的多分支合并与isi消除联合实现的研究出现。

技术实现要素:

5.本发明针对现有技术存在的缺点和不足,提出了一种能联合实现多分支的合并和码间干扰的消除,且由于结合深度学习算法,具备非线性能力,能取得更好的系统性能的用于协作通信的基于深度学习的多分支联合检测方法。

6.本发明通过以下措施达到:

7.一种用于协作通信的基于深度学习的多分支联合检测方法,应用于包含一个源节点s,一个目的节点d和一个中继节点r的协作通信系统,系统中继工作于解码转发模式,完成协作包括广播阶段和中继阶段,其中在广播阶段中,中继节点r接收到的信号r

sr

(n),目的节点d接收到的信号r

sd

(n)表示为下式:

8.r

sr

(n)=s(n)*h

sr

(n)+n

sr

(n)

ꢀꢀꢀ

(1)

9.r

sd

(n)=s(n)*h

sd

(n)+n

sd

(n)

ꢀꢀꢀ

(2)

10.其中s(n)为等概率不相关二进制相移键控(bpsk)信号,*表示卷积,n

sr

(n)和n

sd

(n)是均值为零,方差分别为n

0,r

、n

0,d

的加性高斯白噪声,h

sr

(n)、h

sd

(n)分别表示源节点s和中继节点r、源节点s和目的节点d之间信道的冲激响应;所有节点间的信道均假设为频率选择性信道,信道冲激响应由下式建模:

[0011][0012]

其中j∈{sr,sd,rd},lj表示信道冲激响应的长度,σ描述了信道延迟扩展时间情况,pr表示信道hj(n)多径成分的平均功率;

[0013]

在中继阶段,假设中继节点能完美恢复源节点发送的信息,则目的节点d接收到的来自于中继节点r的信号表示为:

[0014]rrd

(n)=s(n)*h

rd

(n)+n

rd

(n)

ꢀꢀꢀ

(4)

[0015]

其中h

rd

(n)表示中继节点r和目的节点d间信道的冲激响应,n

rd

(n)是均值为零,方差为n

r,d

的加性高斯白噪声;

[0016]

其特征在于,建立基于深度学习的多分支联合检测器,直接处理来自于源节点和中继节点的信号,其中所述基于深度学习的多分支联合检测器中,令dnn

sd

神经网络的输入层(第1层)的输入由c

sd(1)

表示,dnn

rd

神经网络输入层的输入表示为c

rd(1)

,则从r

sd

(n)和r

rd

(n)得出的c

sd(1)

和c

rd(1)

表达式由下式表示:

[0017]csd(1)

=[r

sd

(n),...,r

sd

(n-m

sd

+1)]

ꢀꢀꢀ

(5)

[0018]crd(1)

=[r

rd

(n),...,r

rd

(n-m

rd

+1)]

ꢀꢀꢀ

(6)

[0019]msd

和m

rd

分别表示dnn

sd

和dnn

rd

输入层的神经元数量的大小;

[0020]

假设两个分支的dnn的网络层数都为l层,设dnn

sd

的第l层(l=1,...,l-2)有n

l

个神经元,且第l层输出的向量为c

sd(l)

(该向量长度为n

l

),则第l+1层的输出为

[0021]csd(l+1)

=f

(l)

(c

sd(l)

)=f(θ

(l)csd(l)

+v

(l)

)

ꢀꢀꢀ

(7)

[0022]

其中,θ

(l)

为dnn

sd

第l层的权重矩阵,且(i=1,...,n

l+1

,j=1,...,n

l

),v

(l)

为dnn

sd

第l层的偏置向量,且(i=1,...,n

l

),f(

·

)为激活函数,采用双曲正切(tanh)函数,其定义如下式所示:

[0023][0024]

设dnn

rd

的第l层(l=1,...,l-2)具有n

l

个神经元,且第l层输出的向量为c

rd(l)

(该向量长度为n

l

),则第l+1层的输出为

[0025]crd(l+1)

=f

(l)

(c

rd(l)

)=f(λ

(l)crd(l)

+k

(l)

)

ꢀꢀꢀ

(9)

[0026]

其中,λ

(l)

为dnn

rd

第l层的权重矩阵,且(i=1,...,n

l+1

,j=1,...,n

l

),k

(l)

为dnn

rd

第l层的偏置向量,且(i=1,...,n

l

);

[0027]

dnn

sd

和dnn

rd

第l-1层(输出层的前一层)的输出分别表示为:

[0028]csd(l-1)

=f

(l-1)

(...f

(1)

(c

sd(1)

))

ꢀꢀꢀ

(10)

[0029]crd(l-1)

=f

(l-1)

(...f

(1)

(c

rd(1)

))

ꢀꢀꢀ

(11)。

[0030]

本发明为了减小计算量,需减少神经网络的规模,因此在每一次的训练中,从所有的训练样本中随机抽取若干组,而后完成一次训练,与单分支结构不同的是,这里是要对两

个分支的网络输出先进行合并处理后,再经激活函数f(

·

)处理得出检测器dl-mjd的总输出:

[0031][0032]

其中是一个长为n的向量,n表示每次训练的样本数。

[0033]

本发明中由估计的总输出,可构造基于深度学习的多分支联合检测器dl-mjd的代价函数为下式:

[0034][0035]

其中p(j)是对应估计值的已知训练数据,n=1,...,n,n为训练数据的数量多少,与每次训练的样本数大小相同。

[0036]

本发明中代价函数取值越小,则估计值越逼近于期望值s(n),因此,令代价函数最小化来优化神经网络:

[0037]

l(θ,v,λ,k)

opt

=minl(θ,v,λ,k)

ꢀꢀꢀ

(14)

[0038]

为了得出最小化代价函数的自适应算法,本发明基于梯度下降法来完成神经网络的自适应优化。与单分支方法不同,这里是对多分支信号进行处理,使用所有分支的总输出计算出总误差,来优化更新各分支的神经网络权值向量,使得代价函数(13)趋于最优值。根据梯度下降法,各分支网络参数的更新可由下式得出:

[0039][0040][0041][0042][0043]

其中,α表示学习率,

[0044]

对(15)式中的求导项,由于误差是反向传播,故首先推导第l-1层的偏导,结果如下式所示:

[0045][0046][0047]

其中,

⊙

表示哈达玛积,(

·

)

t

表示矩阵转置。

[0048]

为了方便求取(15)式中l其它值时(l=1,...,l-2)的偏导,将dnn

sd

第l-1层神经元的误差项δ

l-1

定义为:

[0049][0050]

类似地,经过推导,dnn

sd

的第l层神经元的误差项δ

l

(l=1,...,l-2)由下式得出:

[0051][0052]

由(19)式可得:

[0053][0054][0055]

此外,和表示为如下格式:

[0056][0057][0058][0059]

其中,为dnn

rd

的第l层神经元的误差项,将(20)、(21)、(23)和(24)代入(15)式,得dl-mjd的自适应算法为

[0060]

θ

(l)

=θ

(l)-αδ

l

(c

sdl-1

)

t

(l=1,...l-1)

[0061]v(l)

=v

(l)-αδ

l

(l=1,...l-1)

[0062][0063][0064]

与现有基于深度学习的单分支方法不同,本发明中提出的基于深度学习的多分支联合检测器能联合实现多分支的合并,且各分支抽头的调整是基于各分支的总输出,而后基于计算出的总误差来进行,能够有效实现码间干扰的消除。

附图说明:

[0065]

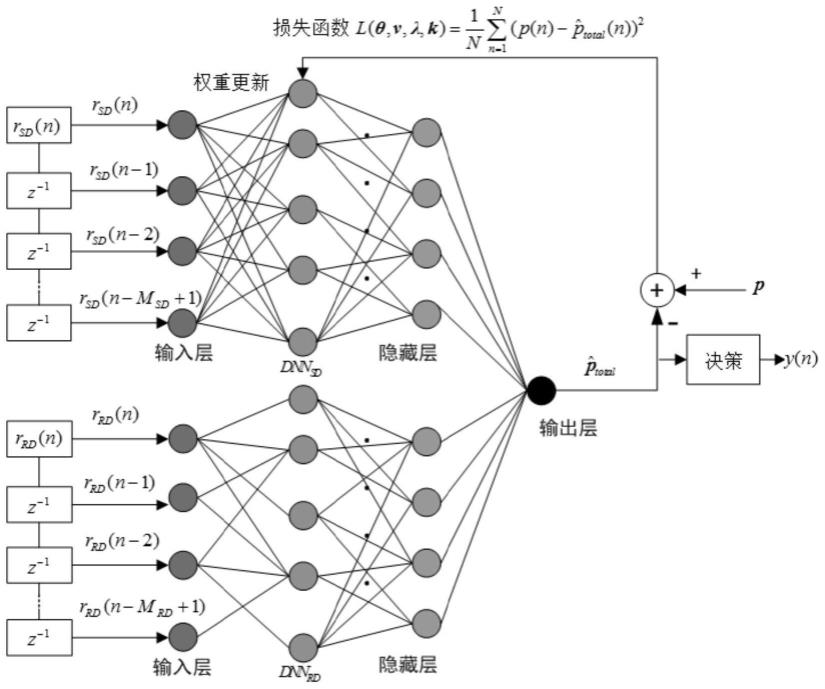

附图1是本发明中基于深度学习的多分支联合检测器dl-mjd的结构图。

[0066]

附图2是实施例1中dl-mjd在不同层数下的误码率性能,其中snr=12db。

[0067]

附图3是实施例1中不同算法的误码率性能比较曲线图。

具体实施方式:

[0068]

下面结合附图和实施例,对本发明作进一步的说明。

[0069]

本发明考虑包含一个源节点s,一个目的节点d和一个中继节点r的协作通信系统,研究中假定中继工作于解码转发模式(df,decode-and-forward)。

[0070]

完成协作需要两个阶段,第一为广播阶段,即源节点分别向中继节点和目的节点广播信号;第二为中继阶段,即中继节点通过放大转发的方式,将接收到的信号再转发给目的节点。

[0071]

在广播阶段中,中继节点r接收到的信号r

sr

(n),目的节点d接收到的信号r

sd

(n)可表示为下式:

[0072]rsr

(n)=s(n)*h

sr

(n)+n

sr

(n)

ꢀꢀꢀ

(1)

[0073]rsd

(n)=s(n)*h

sd

(n)+n

sd

(n)

ꢀꢀꢀ

(2)

[0074]

其中s(n)为等概率不相关二进制相移键控(bpsk)信号,*表示卷积,n

sr

(n)和n

sd

(n)是均值为零,方差分别为n

0,r

、n

0,d

的加性高斯白噪声,h

sr

(n)、h

sd

(n)分别表示源节点s和中继节点r、源节点s和目的节点d之间信道的冲激响应。在本发明中,所有节点间的信道均假设为频率选择性信道,信道冲激响应由下式建模:

[0075][0076]

其中j∈{sr,sd,rd},lj表示信道冲激响应的长度,σ描述了信道延迟扩展时间情况,pr表示信道hj(n)多径成分的平均功率。

[0077]

在中继阶段,中继节点接收到来自于源节点的信号后,首先对接收到的信号进行解码,而后再对解码后的信息,像源节点那样进行bpsk调制后,发送给目的节点。假设中继节点能完美恢复源节点发送的信息,则目的节点d接收到的来自于中继节点r的信号可表示为:

[0078]rrd

(n)=s(n)*h

rd

(n)+n

rd

(n)

ꢀꢀꢀ

(4)

[0079]

其中h

rd

(n)表示中继节点r和目的节点d间信道的冲激响应,n

rd

(n)是均值为零,方差为n

r,d

的加性高斯白噪声。

[0080]

鉴于深度学习的非线性逼近能力,本发明提出一种基于深度学习的多分支联合检测器(dl-mjd,deep learning-based multi-branch joint detector)。与现有基于深度学习的单分支方法不同,该检测器能联合实现多分支的合并,且各分支抽头的调整是基于各分支的总输出,而后基于计算出的总误差来进行的。

[0081]

所提出dl-mjd的结构如图1所示,该检测器将直接处理来自于源节点和中继节点的信号。令dnn

sd

神经网络的输入层(第1层)的输入由c

sd(1)

表示,dnn

rd

神经网络输入层的输入表示为c

rd(1)

,则从r

sd

(n)和r

rd

(n)得出的c

sd(1)

和c

rd(1)

表达式可由下式表示:

[0082]csd(1)

=[r

sd

(n),...,r

sd

(n-m

sd

+1)]

ꢀꢀꢀ

(5)

[0083]crd(1)

=[r

rd

(n),...,r

rd

(n-m

rd

+1)]

ꢀꢀꢀ

(6)

[0084]

其中m

sd

和m

rd

分别表示dnn

sd

和dnn

rd

输入层的神经元数量的大小。假设两个分支的dnn的网络层数都为l层,设dnn

sd

的第l层(l=1,...,l-2)有n

l

个神经元,且第l层输出的向量为c

sd(l)

(该向量长度为n

l

),则第l+1层的输出为

[0085]csd(l+1)

=f

(l)

(c

sd(l)

)=f(θ

(l)csd(l)

+v

(l)

)

ꢀꢀꢀ

(7)

[0086]

其中,θ

(l)

为dnn

sd

第l层的权重矩阵,且(i=1,...,n

l+1

,j=1,...,n

l

),v

(l)

为dnn

sd

第l层的偏置向量,且(i=1,...,n

l

),f(

·

)为激活函数,这里采用双曲正切(tanh)函数,其定义如下式所示:

[0087][0088]

同理,设dnn

rd

的第l层(l=1,...,l-2)具有n

l

个神经元,且第l层输出的向量为c

rd(l)

(该向量长度为n

l

),则第l+1层的输出为

[0089]crd(l+1)

=f

(l)

(c

rd(l)

)=f(λ

(l)crd(l)

+k

(l)

)

ꢀꢀꢀ

(9)

[0090]

其中,λ

(l)

为dnn

rd

第l层的权重矩阵,且(i=1,...,n

l+1

,j=1,...,n

l

),k

(l)

为dnn

rd

第l层的偏置向量,且(i=1,...,n

l

)。

[0091]

因此,dnn

sd

和dnn

rd

第l-1层(输出层的前一层)的输出可分别表示为:

[0092]csd(l-1)

=f

(l-1)

(...f

(1)

(c

sd(1)

))

ꢀꢀꢀ

(10)

[0093]crd(l-1)

=f

(l-1)

(...f

(1)

(c

rd(1)

))

ꢀꢀꢀ

(11)

[0094]

为了减小计算量,需减少神经网络的规模,因此在每一次的训练中,通常从所有的训练样本中随机抽取若干组,而后送入dl-mjd完成一次训练。与单分支结构不同的是,这里是要对两个分支的网络输出先进行合并处理后,再经激活函数f(

·

)处理得出检测器dl-mjd的总输出:

[0095][0096]

其中是一个长为n的向量,n表示每次训练的样本数。

[0097]

由估计的总输出,可构造dl-mjd的代价函数为下式:

[0098][0099]

其中p(j)是对应估计值的已知训练数据,n=1,...,n,n为训练数据的数量多少,与每次训练的样本数大小相同。

[0100]

明显地,代价函数取值越小,则估计值越逼近于期望值s(n)。因此,可令代价函数最小化来优化神经网络:

[0101]

l(θ,v,λ,k)

opt

=minl(θ,v,λ,k)

ꢀꢀꢀ

(14)

[0102]

为了得出最小化代价函数的自适应算法,本发明基于梯度下降法来完成神经网络的自适应优化。与现有的单分支方法不同,这里是对多分支信号进行处理,使用所有分支的总输出计算出总误差,来优化更新各分支的神经网络权值向量,使得代价函数(13)趋于最优值。根据梯度下降法,各分支网络参数的更新可由下式得出:

[0103][0104]

[0105][0106][0107]

其中,α表示学习率。

[0108]

对(15)式中的求导项,由于误差是反向传播,故首先推导第l-1层的偏导,结果如下式所示:

[0109][0110][0111]

其中,

⊙

表示哈达玛积,(

·

)

t

表示矩阵转置。

[0112]

为了方便求取(15)式中l其它值时(l=1,...,l-2)的偏导,我们将dnn

sd

第l-1层神经元的误差项δ

l-1

定义为:

[0113][0114]

类似地,经过推导,dnn

sd

的第l层神经元的误差项δ

l

(l=1,...,l-2)可由下式得出:

[0115][0116]

由(19)式可得:

[0117][0118][0119]

此外,和的计算与上面类似,可表示为如下格式:

[0120][0121][0122][0123]

其中,的第l层神经元的误差项。将(20)、(21)、(23)和

(24)代入(15)式,可得dl-mjd的自适应算法为

[0124]

θ

(l)

=θ

(l)-αδ

l

(c

sdl-1

)

t

(l=1,...l-1)

[0125]v(l)

=v

(l)-αδ

l

(l=1,...l-1)

[0126][0127][0128]

本节将通过仿真来说明提出的dl-mjd方案的性能。为了比较,在仿真中还给出了已有单分支检测器(sbd,single-branch detector)、多分支联合检测器(mjd,multi-branchjoint detector)和基于深度学习的单分支检测器(dl-sbd,deep learning-based single-branch detector)方法的仿真结果。

[0129]

在仿真中使用的信道模型为式(3)所示的模型,用于产生节点间的信道冲激响应。对神经网络dnn

sd

和dnn

rd

来说,仿真中使用的层数均是5层,第1层至第5层的神经元数量n

l

分别设为16、16、24、36和1。在仿真中,算法的学习率α设为0.005;每次训练选取的样本数n为128,每个样本采样点数(m

sd

和m

rd

)均为16,迭代次数为1000次;发送的数据包长度为2000个符号,其中前500个用于用作为训练序列。

[0130]

图2给出了在不同层数下,本发明所提出的dl-mjd的误码率性能。从图中可以看出层数的变化会影响dl-mjd的误码率性能,随着层数的增加,误码率趋于最优,但当层数进一步增加时,误码率反而有变差的趋势。这是因为层数的增加会使神经网络产生过拟合效应,这时再增加网络层数,无法提高网络的拟合效果,反而会带来不利的影响。由图2可知,当层数为5层时,dl-mjd能取得最优的误码率性能。在接下来的误码率性能比较中,也将设置dl-mjd的层数为5层。

[0131]

图3给出了所提dl-mjd与存在算法的误码率性能比较。相比于sbd和dl-sbd,mjd和所提出的dl-mjd能获得更好的误码率性能。这是因为对mjd和dl-mjd来说,中继节点的加入使得目的节点除了能收到源节点的信号,还能收到中继节点转发的信号,接收节点处理后能获得一定的分集增益。此外,还可以看到,dl-mjd能比mjd获得更好的误码率性能。这是因为dl-mjd算法基于深度学习算法实现,相比于线性结构的mjd,深度学习使得dl-mjd具有非线性拟合能力,从而能更有效地消除码间干扰效应。

[0132]

综上,本发明提出了一种基于深度学习的多分支联合检测器(dl-mjd,deep learning-based multi-branch joint detector)。该检测器能联合实现多分支信号的合并和各分支中的码间干扰消除。而且提出的方法基于深度学习算法实现,因而能取得更好的性能。仿真结果说明,提出的dl-mjd能获得比已有算法更好的性能。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1