一种基于多智能体深度强化学习的波束预测方法

1.本公开实施例涉及无线通讯技术领域,尤其涉及一种基于多智能体 深度强化学习的波束预测方法。

背景技术:

2.大规模多天线(massive multi-input multi-output,mimo)系统作为 5g移动通信的关键技术之一,通过部署大规模天线阵列获得高信道增 益,并结合精准波束成形等技术实现多用户空间复用以获得干扰抑制增 益,使得小区总频谱效率和边缘用户的频谱效率得到了极大的提升。

3.5g将频谱扩展到毫米波波段,在带来了极宽的带宽同时波束在大气 中的传播衰减十分严重;毫米波系统的用户高速移动时受多普勒效应影 响波束切换更加频繁,切换失败率更高。传统的波束预测方法通常为求 解一个基于模型的动态规划问题,这类问题通常为np-hard (non-deterministic polynomial-time hard),计算复杂度高且易陷入局部 最优解。另外,用户在移动过程中,信道难以通过单一模型来建模,使 用传统波束预测算法会导致预测误差较大,通信质量下降。

4.因此,有必要改善上述相关技术方案中存在的一个或者多个问题。

5.需要注意的是,本部分旨在为权利要求书中陈述的本公开的技术方 案提供背景或上下文。此处的描述不因为包括在本部分中就承认是现有 技术。

技术实现要素:

6.本公开实施例的目的在于提供一种基于多智能体深度强化学习的波 束预测方法,进而至少在一定程度上克服由于相关技术的限制和缺陷而 导致的一个或者多个问题。

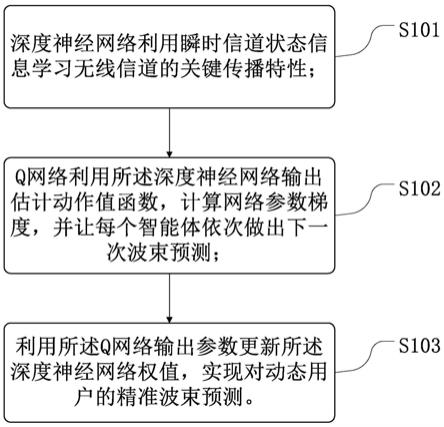

7.根据本公开实施例提供的一种基于多智能体深度强化学习的波束预 测方法,该方法包括:

8.深度神经网络利用瞬时信道状态信息学习无线信道的关键传播特 性;

9.q网络利用所述深度神经网络输出估计动作-值函数,计算网络参数 梯度,并让每个智能体依次做出下一次波束预测;

10.利用所述q网络输出参数更新所述深度神经网络权值,实现对动态 用户的精准波束预测。

11.本公开的一实施例中,所述瞬时信道状态信息获取为所述智能体根 据数字基带参数获取角度信息,并构建信道样本;

12.所述智能体设置m根天线,同时与k个单天线用户进行通信,所述 智能体与所述用户间的信道为:

13.h=[h1,h2,...hk]

ꢀꢀꢀ

(1)

[0014]

其中,hk,k∈{1,2,

…

,k}为所述用户与所述智能体间的信道,所述用户 与所述智能体间的信道公式为:

[0015][0016]

其中,表示导向向量,gk表示所述智能体与用户k之间的空间信 道向量;

[0017]

所述导向向量公式为:

[0018][0019]

其中,i为波束索引,γ表示波束索引集合,为波束方向;

[0020]

所述智能体与所述用户k之间的空间信道向量gk公式为:

[0021][0022]

其中,ρ

los

和分别表示视线传输(los)和非视线传输(nlos) 信道的增益系数;φ

los

和分别为视线传输(los)和非视线传输 (nlos)的离去角。

[0023]

本公开的一实施例中,将所述信道样本作为所述深度神经网络的输 入,得到接收信号功率,所述接收信号功率归一化满足其中e[

·

] 是期望运算符,i是单位矩阵;所述接收功率为||y||2,其中,y为用户接 收信号;

[0024]

用户接收信号公式为:

[0025]

y=hgpq+n

ꢀꢀꢀ

(5)

[0026]

其中,g为波束选择矩阵,所述波束选择矩阵g元素为0或1, 是具有独立同分布(i.i.d)的加性高斯白噪声,h为波束信 道矩阵,p为预编码矩阵,且||p||2=1,q为智能体向用户发送的下行信号。

[0027]

本公开的一实施例中,将信道矩阵和波束索引矩阵设置为同等大小, 同时设置适当的学习率,并用随机参数初始化动作-值函数和概率矩阵, 每个所述智能体的初始化参数都是相互独立的。

[0028]

本公开的一实施例中,根据目标函数寻得当前迭代的最优动作,以 概率1-ε执行,随机选择一个动作a

t

,并以概率ε执行,执行动作后得到 奖励函数r

t

,预测准确的波束会在每次迭代过程中强化动作;

[0029]

所述奖励函数为最大化用户和速率,公式为:

[0030][0031]

其中,σ2表示噪声的功率;

[0032]

所述智能体的转移概率ε公式为:

[0033]

[0034]

其中,1(

·

)为指示函数,为波束i的估计值。

[0035]

本公开的一实施例中,所述动作-值函数为所述智能体在状态s时采 取动作a的奖励;

[0036]

所述值函数公式为:

[0037][0038]

则所述动作-值函数公式为:

[0039][0040]

最优策略通过贝尔曼等式获得,所述最优策略公式为:

[0041][0042]

其中,π表示状态s

t

映射到动作a

t

的策略,s0为初始状态,γ

t

表示第t 步的折现系数,表示累计折现奖励。

[0043]

本公开的一实施例中,获得当前迭代的动作、状态和奖励函数后观察下一状态s

t+1

,将所有智能体数据保存在经验缓存池中。

[0044]

本公开的一实施例中,从所述经验缓存池中选取最小批尺寸的数据输入计算损失函数,并更新训练参数,在所述q网络训练 中,采用所述q网络估计动作-值函数;

[0045]

所述损失函数公式为:

[0046]

l(θ)=e{(y

t-q(s

t+1

,a;θ))2}

ꢀꢀꢀ

(11)

[0047]

其中,θ表示所述深度神经网络的参数;

[0048]

则第t次迭代的目标输出公式为:

[0049][0050]

其中,θ1和θ2分别表示两层所述深度神经网络的不同参数。

[0051]

本公开的一实施例中,基于所述损失函数,利用随机梯度下降法来 更新权值θ,所述损失函数的梯度表示为:

[0052][0053]

其中,l(θ)为所述损失函数。

[0054]

本公开的一实施例中,在下一迭代中选取动作a

t+1

,并和状态、训练 参数共同作为输入根据式(9)求解估计动作-值函数,同时依据式(10) 和功率约束条件其中p

threshold

表示智能体功率阈值,超 过该值表明移动用户需要进

行切换,得到最优策略(动作-值映射)和式 (13)后可得到权值并返回所述深度神经网络进行更新。

[0055]

本公开的实施例提供的技术方案可以包括以下有益效果:

[0056]

本公开的实施例中,通过上述方法,利用深度神经网络获取多个能 反映信道特征的关键值,使多天线(mimo)系统的波束预测更符合动态 用户信道的时变特性,提高波束切换成功率,减小大规模多天线(mimo) 系统的反馈开销,从而提高和速率。

附图说明

[0057]

此处的附图被并入说明书中并构成本说明书的一部分,示出了符合 本公开的实施例,并与说明书一起用于解释本公开的原理。显而易见地, 下面描述中的附图仅仅是本公开的一些实施例,对于本领域普通技术人 员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他 的附图。

[0058]

图1示出本公开示例性实施例中基于多智能体深度强化学习流程图;

[0059]

图2示出本公开示例性实施例中动态用户波束预测示意图;

[0060]

图3示出本公开示例性实施例中基于多智能体深度强化学习示意图。

具体实施方式

[0061]

现在将参考附图更全面地描述示例实施方式。然而,示例实施方式 能够以多种形式实施,且不应被理解为限于在此阐述的范例;相反,提 供这些实施方式使得本公开将更加全面和完整,并将示例实施方式的构 思全面地传达给本领域的技术人员。所描述的特征、结构或特性可以以 任何合适的方式结合在一个或更多实施方式中。

[0062]

此外,附图仅为本公开实施例的示意性图解,并非一定是按比例绘 制。图中相同的附图标记表示相同或类似的部分,因而将省略对它们的 重复描述。附图中所示的一些方框图是功能实体,不一定必须与物理或 逻辑上独立的实体相对应。

[0063]

本示例实施方式中首先提供了一种基于多智能体深度强化学习的波 束预测方法,参考图1中所示,该方法可以包括:步骤s101~步骤s103。

[0064]

步骤s101:深度神经网络利用瞬时信道状态信息学习无线信道的关 键传播特性;

[0065]

步骤s102:q网络利用所述深度神经网络输出估计动作-值函数,计 算网络参数梯度,并让每个智能体依次做出下一次波束预测;

[0066]

步骤s103:利用所述q网络输出参数更新所述深度神经网络权值, 实现对动态用户的精准波束预测。

[0067]

通过上述方法,利用深度神经网络获取多个能反映信道特征的关键 值,使多天线(mimo)系统的波束预测更符合动态用户信道的时变特性, 提高波束切换成功率,减小大规模多天线(mimo)系统的反馈开销,从 而提高和速率。

[0068]

下面,将参考图1至图3对本示例实施方式中的上述基于多智能体 深度强化学习的波束预测方法的各个步骤进行更详细的说明。

[0069]

在步骤s101中,深度神经网络利用瞬时信道状态信息学习无线信道 的关键传播特性;

[0070]

具体的,首先获取瞬时信道状态信息,每个基站根据各自的数字基 带参数获取角

度信息并构建信道样本 将其作为dnn的输入,接收信号功率为||y||2。

[0071]

考虑大规模mimo系统的下行通信,配备m根天线的基站(bs)同 时与k个单天线用户进行通信。在二维平面内,基站与用户间的信道可 以表示为:

[0072]

h=[h1,h2,...hk]

ꢀꢀꢀ

(1)

[0073]

其中,hk,k∈{1,2,

…

,k}为所述用户与所述智能体间的信道,所述用户 与所述智能体间的信道公式为:

[0074][0075]

其中,表示导向向量,gk表示所述智能体与用户k之间的空间信 道向量;

[0076]

所述导向向量公式为:

[0077][0078]

其中,i为波束,j表示与第k个用户之外的其他用户索引,γ表示波 束索引集合,为波束方向;

[0079]

所述智能体与所述用户k之间的空间信道向量gk公式为:

[0080][0081]

其中,ρ

los

和分别表示视线传输(los)和非视线传输(nlos) 信道的增益系数;φ

los

和分别为视线传输(los)和非视线传输 (nlos)的离去角。

[0082]

假设信号功率归一化满足其中e[

·

]是期望运算符,i是单 位矩阵,则用户接收信号y表示为:

[0083]

y=hgpq+n

ꢀꢀꢀ

(5)

[0084]

其中,g为波束选择矩阵,所述波束选择矩阵g元素为0或1, 是具有独立同分布(i.i.d)的加性高斯白噪声,h为波束信 道矩阵,p为预编码矩阵,且||p||2=1,q为智能体向用户发送的下行信号, 接收信号功率为||y||2。

[0085]

步骤s102中,q网络利用所述深度神经网络输出估计动作-值函数, 计算网络参数梯度,并让每个智能体依次做出下一次波束预测;

[0086]

具体的,将信道矩阵和波束索引矩阵设置为同等大小,同时设置适 当的学习率,并用随机参数初始化动作-值函数q

π

(s,a)和概率矩阵,每个 基站的初始化参数都是相互独立的;对于多智能体深度强化学习,本发 明视基站为智能体,其状态用s

t

表示,状态空间s可以表示为波束信道矩 阵h和波束索引矩阵组成的张量并用1或0分别表示信道的好坏。智能 体的动作a

t

为选择波束的过程,动作空间a可以表示为在波束选择矩阵中 选择具有最大接收功率的波束,并且每次迭代时最多只选择一个波束。

[0087]

根据目标函数寻得当前迭代的最优工作,以概率a

t

执行,随机选择 一个动作a

t

,并以概率ε执行。执行动作后得到奖励函数r

t

,预测准确的 波束会在每次迭代过程中强化动

作。

[0088]

奖励函数r

t

为最大化用户和速率,公式为:

[0089][0090]

其中,j表示与第k个用户之外的其他用户索引,σ2表示噪声的功率;

[0091]

所述智能体的转移概率ε公式为:

[0092][0093]

其中,1(

·

)为指示函数,为波束i的估计值。

[0094]

所述动作-值函数为所述智能体在状态s时采取动作a的奖励;

[0095]

所述值函数公式为:

[0096][0097]

其中,π表示状态s

t

到动作a

t

的策略,s0为初始状态,γ

t

表示第t步的 折现系数,表示累计折现奖励;

[0098]

则所述动作-值函数公式为:

[0099][0100]

最优策略通过贝尔曼等式获得,所述最优策略公式为:

[0101][0102]

步骤s103:利用所述q网络输出参数更新所述深度神经网络权值, 实现对动态用户的精准波束预测。

[0103]

具体的,先获得当前迭代的动作、状态和奖励函数后观察下一状态 s

t+1

,将所有基站数据保存在经验缓存池(experience buffer replay)中;

[0104]

从经验缓存池中选取最小批尺寸的数据输入计算损失函 数,并更新训练参数θ。在线训练阶段中,采用深度q网络估计动作-值 函数;q网络旨在最小化损失函数:

[0105]

l(θ)=e{(y

t-q(s

t+1

,a;θ))2}

ꢀꢀꢀ

(11)

[0106]

其中,θ表示所述深度神经网络的参数;

[0107]

则第t次迭代的目标输出公式为:

[0108][0109]

其中,θ1和θ2分别表示两层所述深度神经网络的不同参数。

[0110]

基于所述损失函数l(θ),利用随机梯度下降法来更新权值θ,所述损 失函数的梯度可以表示为:

[0111][0112]

然后在下一迭代中选取动作a

t+1

,并和状态、训练参数共同作为输入 根据式(9)求解估计动作-值函数,同时依据式(10)和功率约束条件 其中p

threshold

表示基站功率阈值,超过该值表明移动用 户需要进行切换;得到最优策略(动作-值映射)和式(13)后可得到权 值并返回dnn进行更新。

[0113]

通过上述方法,利用深度神经网络获取多个能反映信道特征的关键 值,使多天线(mimo)系统的波束预测更符合动态用户信道的时变特性, 提高波束切换成功率,减小大规模多天线(mimo)系统的反馈开销,从 而提高和速率。

[0114]

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、

ꢀ“

具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体 特征、结构、材料或者特点包含于本公开的至少一个实施例或示例中。在 本说明书中,对上述术语的示意性表述不必须针对的是相同的实施例或示 例。而且,描述的具体特征、结构、材料或者特点可以在任何的一个或多 个实施例或示例中以合适的方式结合。此外,本领域的技术人员可以将本 说明书中描述的不同实施例或示例进行接合和组合。

[0115]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想 到本公开的其它实施方案。本技术旨在涵盖本公开的任何变型、用途或 者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原 理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说 明书和实施例仅被视为示例性的,本公开的真正范围和精神由所附的权 利要求指出。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1