海量终端URLLC下网络辅助全双工模式优化方法

海量终端urllc下网络辅助全双工模式优化方法

技术领域

1.本发明涉及一种适用于海量终端高可靠低时延通信(urllc)场景下基于负载感知的网络辅助全双工无蜂窝大规模mimo场景下具有可扩展性的双工模式优化方法,属于移动通信技术领域。

背景技术:

2.全双工(fd)技术有助于提高系统吞吐量和减少系统的延时,这在高可靠和低延迟通信(urllc)场景下非常重要。无蜂窝分布式大规模mimo系统架构下网络辅助全双工(nafd)技术是一项灵活的新型双工技术,系统内包含一个中央处理单元,多个远端天线单元以及多个用户。每个rau(remote antenna unit,远端天线单元)可以进行上行接收或者下行发送,具体选择何种传输模式由cpu决定。和传统的时分双工相比,nafd能够提供低时延的服务;和传统的频分双工相比,nafd能够在不降低频谱利用率的情况下支持非对称业务。nafd的灵活双工技术可支撑实现海量终端的urllc通信,并且通过cpu调度远端天线单元(rau)的上行或者下行模式,可减少在urllc中免授权接入带来的碰撞延时并保证用户接入的可靠性,nafd没有rau的自干扰,还可以降低传统双工中的自干扰消除延时。

3.随着移动终端用户数量的爆炸性增长,海量终端带来的系统资源利用率的问题和可靠快速的接入机制还有待研究。在海量终端的urllc场景下,nafd灵活双工中节点模式选择机制与urllc中特有的短包传输、误码率约束等因素的作用机制关联有待研究。海量终端以及实际系统中对算法理论上的可扩展性要求有待研究。

技术实现要素:

4.技术问题:本发明针对适用于海量终端urllc场景下基于负载感知的网络辅助全双工模式优化技术使系统的资源利用率最大的问题,提出一种海量终端urllc下网络辅助全双工模式优化方法。

5.技术方案:本发明的一种海量终端urllc下网络辅助全双工模式优化方法具体如下:

6.该方法采用基于wolf-phc的智能算法进行优化,包括以下步骤:

7.步骤1:定义针对每个用户i的负载感知效用函数:

[0008][0009]

其中,ui是负载感知的效用函数,用来表征系统的资源利用率,用来表征系统的资源利用率;k为每个远端天线单元rau具有的可分配的总资源块的数量,k为用户总数,n

m,i

是第m个远端天线单元rau分配给用户i的资源块数量,n

m,a

是第m个rau分配给用户a的资源块数量,则求和项是第m个远端天线单元rau分配给所有用户的资源块数量总和,第m个

远端天线单元rau简称rau m,可由下式计算得到:

[0010][0011][0012]

其中,是用户i根据自身服务质量qos所需要的使用带宽,b是每个资源块所占的带宽,γi是用户i的信干噪比sinr,ri是urllc场景下的短包可达速率,v(γi)是用户信道的离差,m是短包块的长度,q-1

(

·

)为q函数取逆,ε0为错误译码概率dep,e为自然对数,意为向上取整;

[0013]

步骤2:优化目标是基于负载感知最大化用户的资源效用函数:

[0014][0015]

其中,u

u,i

为上行链路的负载感知效用函数值,u

d,j

为下行链路的负载感知效用函数值,ku为上行链路中的用户数,kd为下行链路中的用户数;u、d分别为上行链路、下行链路的标识,i、j分别为第i个上行链路用户和第j个下行链路用户;为了确定每个远端天线单元rau应该以哪种模式运行,定义两个二进制分配向量xu,xd∈{0,1}m×1,m为rau的总数量,如果rau用于上行链路或下行链路则第i个上行rau的二进制分配向量或第j个下行rau的二进制分配向量取值为1,否则取值为0;上下行链路的有效的负载感知效用函数值可分别用式(5)和(6)表示:

[0016][0017][0018]

其中,定义xu=diag(xu),xd=diag(xd),diag(a)表示用元素a构成对角矩阵;mu是上行rau的数目,md是下行rau的数目,k

u,m

是上行rau m可供分配的资源块数目,k

d,m

是下行raum可供分配的资源块数目,n

m,i

是raum在满足上行用户i的qos的要求的情况下分配给上行用户i的资源块数量,n

m,j

是raum在满足下行用户j的qos的要求的情况下分配给下行用户j的资源块数量;

[0019]

步骤3:用智能算法对资源效用函数进行优化,保存算法最后的状态集和奖励,作为最优的rau双工模式和最大化的资源利用效率。

[0020]

其中:

[0021]

所述的基于wolf-phc的智能算法为:

[0022]

wolf是指,当智能体做的比期望值好的时候小心缓慢的调整参数,当智能体做的比期望值差的时候,加快步伐调整参数;

[0023]

phc是一种单智能体在稳定环境下的一种学习算法,该算法的核心就是通常强化学习的思想,增大能够得到最大累积期望的动作的选取概率,该算法能够收敛到最优策略;

[0024]

wolf-phc智能算法是一种适用于多智能体的分布式执行的可扩展性算法,将wolf与phc算法结合,使得智能体获得的奖励在比预期差时,能够快速调整适应其他智能体策略变化,当比预期好时谨慎学习,给其他智能体适应策略变化的时间;并且wolf-phc算法能够收敛到纳什均衡策略,当其他智能体采用某个固定策略时,其也能收敛到一个目前状况下的最优策略而不是收敛到一个可能效果不好的纳什均衡策略处;wolf-phc算法不用观测其他智能体的策略、动作及奖励值,需要更少的空间去记录q值,并且wolf-phc算法是通过phc算法进行学习改进策略的,所以不需要使用线性规划或者二次规划求解纳什均衡,算法速度得到了提高;在海量终端urllc场景下,分布式操作可以使算法具有逻辑意义上的可扩展性。

[0025]

所述的wolf-phc算法,其中的平均估计策略的更新遵循下式:

[0026][0027]

其中,πi(s,ai)为在特定状态-动作对下所采取的策略,c(s)为状态s出现的次数,πi(s,ai)的更新如式:

[0028][0029][0030][0031][0032]

其中,q(s,a)表示在状态s下采取动作a所得到的价值函数,q值更新更新公式参考式(8);为用于更新策略的增量或者减量,当目前选取的动作ai不是使q值最大的动作时,用减量进行更新,如果目前选取的动作ai是使q值最大的动作时,用增量进行更新;δ

sa

的值又取决于估计策略πi(s,ai)与式子中的较小值,δ为更新的辅助参量,|ai|为动作空间的大小,δ的具体取值如(5)所示;δw为智能体获得的奖励在比预期好时,采取的正向更新辅助参量,δ

l

为智能体获得的奖励在比预期差时,采取的负向更新辅助参量;

[0033]

在基于wolf-phc的智能算法中,系统中的每个远端天线单元rau都单独视为一个智能体,在本地进行数据检测与节点模式的选择,不需要上传到中央处理中心cpu进行集中计算;对每一个智能体,状态空间只有两个状态s

t

={s1,s2},s1表此rau工作模式为上行接收,s2表示此rau工作模式为下行传输,动作空间设置为只有两个动作a

t

={a1,a2},a1表示

rau改变原先的工作模式,a2表示rau保持原先的工作模式不变,因此q表的大小为2

×

2,若rau的总数为m,则总的用于存储q值的空间只需要m

×2×

2,远小于上传到cpu处集中式处理所需要的2m×

m的q表的存储空间,且复杂度更低。

[0034]

所述的rau是上行接收,则奖励如下式:

[0035][0036]

当rau是下行传输,则奖励如下式:

[0037][0038]

所述的q值更新,公式如下:

[0039][0040]

其中,α是学习率,s

t

和a

t

分别为t时刻的状态和动作,奖励r

t+1

是在时间t时,智能体在状态s

t

下采取行动a

t

之后,获得的来自环境的反馈,折扣因子γ定义了未来奖励的重要性,值为0意味着只考虑短期奖励,值为1的值更重视长期奖励。

[0041]

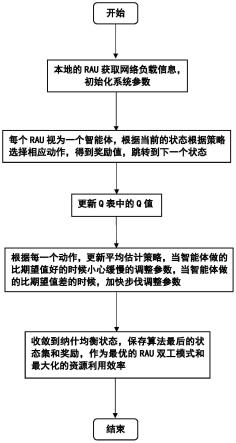

所述的wolf-phc算法的具体步骤如下:

[0042]

步骤1,m为rau的总数,生成m张大小为2

×

2的全是零值的q表,初始化其中,表示所有下行链路rau与接收信号的下行用户j之间的信道向量,为下行预编码向量,g

i,j

表示第i个上行用户和第j个下行用户之间的信道向量,表示第i个上行用户与所有上行raus之间信道,gi是下行raus和上行raus之间真实的干扰信道矩阵,初始化学习率α与衰减因子γ,初始化正向更新辅助参量δw和负向更新辅助参量δ

l

;初始化策略初始化平均估计策略|ai|是动作空间的大小,初始化动作s出现的次数c(s)=0;

[0043]

步骤2,如果rau的状态此时为上行接收,根据策略选择动作后,根据式(6)计算奖励,如果rau的状态此时为下行传输,根据策略选择动作后,根据式(7)计算奖励,

[0044]

步骤3,当前的状态根据所选动作跳转到下一状态;

[0045]

步骤4,根据(8)式更新q表里的q值;

[0046]

步骤5,针对每一个动作,根据式(1)更新平均估计策略;

[0047]

步骤6,根据q值和每一个动作,根据式(2-5)更新策略;

[0048]

步骤7,返回步骤2进行学习训练,直至策略和q表里的值收敛;

[0049]

步骤8,返回每个智能体最优解的状态和奖励,对应每个rau的上行和下行模式以及最大的用户资源效用函数值。

[0050]

有益效果:本发明考虑了一种适用于海量终端高可靠低时延通信(urllc)场景下

基于负载感知的网络辅助全双工无蜂窝大规模mimo场景下具有可扩展性的双工模式优化方法,该发明针对无蜂窝大规模mimo场景下网络辅助全双工的上下行链路的资源利用效率最大化的问题,提出了一种多智能体分布式操作的具有强可扩展性的wolf-phc智能算法。其中,逻辑上的可扩展性体现在每个rau视为一个智能体,都包含一个本地处理器,可以执行与其自身相关的数据处理任务并根据其他rau的决策去优化本地的性能指标。当在系统中加入新的远端天线单元(rau)时,无需升级cpu的计算能力,无需在cpu处重新训练所有rau传输过来的数据信息,这种分布式执行操作使得系统算法具有可扩展。本发明提出的智能分布式操作算法更适合海量终端urllc动态场景,复杂度较低,比传统的集中式q-learning算法具有更低的存储空间要求。

附图说明

[0051]

附图为实例问题中搭建的场景、所提出的基于wolf-phc算法与其他算法的资源效用函数比较图。

[0052]

图1是均匀分布的rau和随机分布的上下行用户的位置分布图;

[0053]

图2是不同算法下的资源效用函数的cdf的比较图。

[0054]

图3是本发明的流程示意图。

具体实施方式

[0055]

下面结合实例,对本发明进行详细的描述:

[0056]

假设一个处于一个圆内的无蜂窝大规模mimo的场景,m个rau均匀分布在一个半径为600m的圆内。系统里包含了k个随机分布的用户,包括ku个上行用户,和kd个下行用户。这k个上下行用户是随机分布在一个半径为1000m的圆内。我们假设m=6,ku=20,kd=20,具体的场景分布图见说明书附图中的图1。噪声的功率设为-90dbm,上行链路的发送功率为30dbm,下行链路的发送功率为23dbm,路径损耗为128.1+37.6log10(d)。

[0057]

本发明在该系统的实现方法具体如下:

[0058]

(1)定义针对每个用户i的负载感知效用函数:

[0059][0060]

其中,ui是负载感知的效用函数,用来表征系统的资源利用率。k为每个远端天线单元(rau)具有的可分配的总资源块的数量,k为用户总数。n

m,i

是rau m分配给用户i的资源块数量,可由下式计算得到:

[0061][0062][0063]

其中,是用户i根据自身服务质量(qos)所需要的使用带宽。b是每个资源块所占的带宽,γi是用户i的信干噪比sinr,ri是urllc场景下的短包可达速率,v(γi)是用户信

道的离差,m是短包块的长度,q-1

(

·

)为q函数取逆,ε0为错误译码概率(dep),e为自然对数。意为向上取整。根据对数函数的性质,当整个网络负载过大时,在保证能满足用户自身服务质量的前提下,用户会优先选择需要分配给他资源块数量较少的rau,从而提高系统整体的资源块的利用率。随着网络整体负载的增加,用户的负载感知效用函数的值会下降。此外,随着rau所拥有的可供分配的资源块数量的增加,负载感知效用函数的值也会上升。如果rau不能保证满足用户i的服务质量,则此rau不会为用户i提供资源块此时,ui=0。因此ui作为负载感知的效用函数,可以用来表征系统的资源利用率。

[0064]

(2)优化目标是基于负载感知最大化用户的资源效用函数:

[0065][0066]

其中,u

u,i

为上行链路的负载感知效用函数值,u

d,j

为下行链路的负载感知效用函数值,ku为上行链路中的用户数,kd为下行链路中的用户数;u、d分别为上行链路、下行链路的标识,i、j分别为第i个上行链路用户和第j个下行链路用户;为了确定每个远端天线单元rau(remote antennaunit)应该以哪种模式运行,定义两个二进制分配向量xu,xd∈{0,1}m×1,m为rau的总数量,如果rau用于上行链路或下行链路则第i个上行rau的二进制分配向量或第j个下行rau的二进制分配向量取值为1,否则取值为0;上下行链路的有效的负载感知效用函数值可分别用式(5)和(6)表示:

[0067][0068][0069]

其中,定义xu=diag(xu),xd=diag(xd),diag(a)表示用元素a构成对角矩阵;mu是上行rau的数目,md是下行rau的数目,k

u,m

是上行raum可供分配的资源块数目,k

d,m

是下行raum可供分配的资源块数目,n

m,i

是raum在满足上行用户i的qos的要求的情况下分配给上行用户i的资源块数量,n

m,j

是raum在满足下行用户j的qos的要求的情况下分配给下行用户j的资源块数量。

[0070]

(3)用智能算法对资源效用函数进行优化,保存算法最后的状态集和奖励,作为最优的rau双工模式和最大化的资源利用效率。

[0071]

为了实现适用于海量终端urllc场景下基于负载感知的网络辅助全双工模式优化技术,提出一种基于wolf-phc q-learning的智能算法:

[0072]

wolf是指,当智能体做的比期望值好的时候小心缓慢的调整参数,当智能体做的比期望值差的时候,加快步伐调整参数。

[0073]

phc是一种单智能体在稳定环境下的一种学习算法。该算法的核心就是通常强化学习的思想,增大能够得到最大累积期望的动作的选取概率。该算法具有合理性,能够收敛到最优策略。

[0074]

wolf-phc智能算法是一种适用于多智能体的分布式执行的可扩展性算法。将wolf与phc算法结合,使得智能体获得的奖励在比预期差时,能够快速调整适应其他智能体策略变化,当比预期好时谨慎学习,给其他智能体适应策略变化的时间。并且wolf-phc算法能够收敛到纳什均衡策略,当其他智能体采用某个固定策略时,其也能收敛到一个目前状况下的最优策略而不是收敛到一个可能效果不好的纳什均衡策略处。wolf-phc算法不用观测其他智能体的策略、动作及奖励值,需要更少的空间去记录q值,并且wolf-phc算法是通过phc算法进行学习改进策略的,所以不需要使用线性规划或者二次规划求解纳什均衡,算法速度得到了提高。在海量终端urllc场景下,分布式操作可以使算法具有逻辑意义上的可扩展性。其中,平均估计策略的更新遵循下式:

[0075][0076]

其中,πi(s,ai)为在特定状态-动作对下所采取的策略,c(s)为状态s出现的次数。πi(s,ai)的更新如式:

[0077][0078][0079][0080][0081]

其中,q(s,a)表示在状态s下采取动作a所得到的价值函数,更新公式参考式(14)。

[0082]

在wolf-phc算法中,系统中的每个rau都单独视为一个智能体,在本地进行数据检测与节点模式的选择,不需要上传到中央处理中心(cpu)进行集中计算。对每一个智能体,状态空间只有两个状态s

t

={s1,s2},s1表此rau工作模式为上行接收,s2表示此rau工作模式为下行传输,动作空间设置为只有两个动作a

t

={a1,a2},a1表示rau改变原先的工作模式,a2表示rau保持原先的工作模式不变,因此q表的大小为2

×

2,若rau的总数为m,则总的用于存储q值的空间只需要m

×2×

2,远小于上传到cpu处集中式处理所需要的2m×

m的q表的存储空间,且复杂度更低。为当rau是上行接收模式,则奖励如下式:

[0083][0084]

当rau是下行传输模式,则奖励如下式:

[0085]

[0086]

q值的更新公式如下:

[0087][0088]

其中,α是学习率,s

t

和a

t

分别为t时刻的状态和动作,奖励r

t+1

是在时间t时,智能体在状态s

t

下采取行动a

t

之后,获得的来自环境的反馈,折扣因子γ定义了未来奖励的重要性,值为0意味着只考虑短期奖励,值为1的值更重视长期奖励。算法的具体步骤如下:

[0089]

①

m为rau的总数,生成m张大小为2

×

2的全是零值的q表,初始化其中,表示所有下行链路rau与接收信号的下行用户j之间的信道向量,为下行预编码向量,g

i,j

表示第i个上行用户和第j个下行用户之间的信道向量,表示第i个上行用户与所有上行raus之间信道,gi是下行raus和上行raus之间真实的干扰信道矩阵,初始化策略初始化平均估计策略|ai|是动作空间的大小,初始化c(s)=0;

[0090]

②

如果rau的状态此时为上行接收,根据策略选择动作后,根据式(12)计算奖励,如果rau的状态此时为下行传输,根据策略选择动作后,根据式(13)计算奖励,

[0091]

③

当前的状态根据所选动作跳转到下一状态;

[0092]

④

根据(14)式更新q表里的q值;

[0093]

⑤

针对每一个动作,根据式(7)更新平均估计策略;

[0094]

⑥

根据q值和每一个动作,根据式(8-11)更新策略;

[0095]

⑦

返回步骤

②

进行学习训练,直至策略和q表里的值收敛;

[0096]

⑧

返回每个智能体最优解的状态和奖励,对应每个rau的上行和下行模式以及最大的用户资源效用函数值。

[0097]

图2显示出了本发明中提出的适用于海量终端高可靠低时延通信(urllc)场景下基于负载感知的网络辅助全双工无蜂窝大规模mimo场景下具有可扩展性的双工模式优化方法比固定模式的均分上下行rau方案以及时分全双工tdd的方案要高,且靠近性能理论上最佳的穷举算法,因为部分情况下收敛到纳什均衡策略,因此性能略低于网络系统层面上可以达到最优的集中式q-learning算法,而本发明提出的算法的复杂度比穷举法低很多,相较于集中式q-learning拥有更小的计算存储空间以及更高的可扩展性,更适用于海量终端高可靠低时延通信(urllc)场景。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1