一种AI智能语音通话录音留存及通话控制方法和装置与流程

一种ai智能语音通话录音留存及通话控制方法和装置

技术领域

1.本发明运用于通话数据处理技术领域,具体涉及为一种ai智能语音通话录音留存及通话控制方法和装置。

背景技术:

2.随着人工智能与语音交互技术的发展与成熟,呼出类型业务越来越成为市场主流业务,主动给客户拨打电话进行电话营销和市场调查,也成为市场更受欢迎的竞争手段之一。ai机器人外呼既提高了推广效率又节省了外呼推广成本,针对机动性不强的业务,企业也越来越更倾向与使用机器人外呼。

3.从外呼中心的角度出发,因需要多方采购不同厂商的ai外呼系统,不便于管理,导致人力流程成本增加,同时无法实现规则任务的控制,究其原因,即各个厂商入参格式不统一,现有的解决办法是必须提供带入参的sip呼入的服务器以将各ai智能机器人通过sip服务器入参至外呼中心,以通过此种增加服务器成本的方式解决此技术问题,但也仍然存在无法任务规则的控制。

4.《cn202110747640》一种智能云呼叫中心调用多厂商ai能力的调度方法,中通过步骤,s1、提取一定条件厂商数据,并对厂商流程标注;s2、发起智能外呼,根据对象数据标记和算法模型,获取智能呼叫流程最大总评分,根据智能呼叫服务流程,发起呼叫;s3、针对历史服务数据,反向计算流程服务质量,并作数据标记;s4、根据步骤s2和步骤s3实现智能呼叫多厂商间多资源调度,选取最佳厂商路由。通过迭代式算法,提高了智能外呼多厂商资源调度的灵活性,避免了固定参数算法带来的资源浪费瓶颈问题,同时也提高了智能呼叫多厂商资源调度的效率。

5.本发明旨在通过卷积神经网络和损失迭代算法,减少参数运算量,以实现在人工重新接入ai语音时的反应速度,和对于录音的存留。

技术实现要素:

6.本发明旨在通过卷积神经网络和损失迭代算法,减少参数运算量,以实现在人工重新接入ai语音时的反应速度,和对于录音的存留,提供一种ai智能语音通话录音留存及通话控制方法和装置。

7.本发明为解决技术问题采用如下技术手段:

8.本发明提供一种ai智能语音通话录音留存及通话控制方法,包括:

9.获取用于ai语音系统厂家入参的第一内接数据;

10.将所述第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据;

11.将所述第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口,所述通话接入端口包括始端接口、读秒端接口、指令端接口和末端接口;

12.监听所述始端接口是否激活,若是则调用预设的录音指令,并根据所述录音指令

存留从始端接口至末端接口时间段的第一语音信息;

13.判断所述指令端接口是否获取到输入的人工通话信号,若是,则将所述指令端接口与人工外接端口进行对接;

14.判断所述读秒端接口是否启用,若是,则继续判断从所述始端接口至读秒端接口的语音沟通时间段内是否存在预设的读秒接入信息,若存在,则通过所述读秒接入信息将所述读秒端接口与人工外接端口进行对接。

15.进一步地,所述将第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据的步骤,包括:

16.特征值归一化,将所述第一内接数据进行最大化分类,获得所述第一内接数据经过分类后的多类归一集合内的特征值集合;

17.归一化特征显著性融合,根据所述特征值集合中的各类别入参数据进行对标至预设的卷积神经网络输入门通道,并将所述特征值集合中的各类别入参数据输入至卷积神经网络;

18.损失计算和入参补全,对所述特征值集合中无法直接对标输入门的各类别入参数据进行损失计算,以得到计算后的损失结果,最终将损失结果套入至统一性模板中做入参补全,得到补全数据并导入至卷积神经网络。

19.3、根据权利要求2所述的ai智能语音通话录音留存及通话控制方法,其特征在于,所述将第一内接数据进行最大化分类,获得所述第一内接数据经过分类后的多类归一集合内的特征值集合的步骤中,所述特征值集合为:

20.fi=(f

ξapl1

,f

ξapl2,fξapl3

,

···

,f

ξapln

);

21.其中,fi为将第一内接数据进行多类归一集合内的特征值集合,f1至fn为特征值集合中各个入参函数类别、对接接口或链接协议,ξapl为预设的分类别准。

22.进一步地,所述对特征值集合中无法直接对标输入门的的各类别入参数据进行损失计算,以得到计算后的损失结果,最终将损失结果套入至统一性模板中做入参补全的步骤中,包括:

23.所述损失计算的算法包括:

24.所述入参补全的算法包括:passwmax=g(fi)+maxξ

·

wh

25.其中,g(fi)为对特征值集合中的无法直接对标输入门的各类别入参数据进行损失计算后的特征值,wh为无法直接对标输入门的各类别入参数据在特征值集合中的位置信息,为特征值集合中的查验算法;

26.passwmax为对标卷积神经网络输入门的通道接口数值,maxξ为统一入参格式协议的指定阈值。

27.进一步地,所述将第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程的步骤中,包括:

28.搭建一个轻度级深度卷积神经网络,其结构依次为:输入门、第1卷积层、深度可分离卷积模块组合、特征空间融合模块、第2卷积层和输出门;所述深度可分离卷积模块组合由4个结构相同的深度可分离卷积模块串联组成,每个深度可分离卷积模块结构依次为:第1逐点卷积层

→

深度卷积层

→

第2逐点卷积层;所述特征空间融合模块由逐点卷积层和平均

池化层串联组成;

29.设置网络参数,并初始化所述轻量级深度卷积神经网络;

30.生成训练集和验证集;

31.通过所述训练集和验证集训练轻量级深度卷积神经网络;

32.设计现场可编程逻辑门阵列fpga中轻量级卷积神经网络的基本组成器件,并在现场可编程逻辑门阵列fpga中实现训练好的轻量级深度卷积神经网络。

33.进一步地,所述将第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口的步骤中,包括:

34.轻量级深度卷积神经网络获取第二内接数据,并将所述第二内接数据中的入参数据拉入至预设的通话导轨中;

35.对所述通话导轨设置四个节点,进而创建所述始端接口、读秒端接口、指令端接口和末端接口。

36.进一步地,所述设置网络参数,并初始化所述轻量级深度卷积神经网络的步骤,包括:

37.将第1卷积层和第2卷积层的卷积核大小分别设置为3

×3×

3和1

×1×

1536,卷积核个数分别设置为32和4,卷积步进分别设置为2和1;

38.将第1深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

32、3

×3×

1和1

×1×

96,卷积核的个数分别设置为96、96和64,卷积步长分别设置为1、2和1;

39.将第2深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

64、3

×3×

1和1

×1×

192,卷积核的个数分别设置为192、192和128,卷积步长分别设置为1、2和1;

40.将第3深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

128、3

×3×

1和1

×1×

384,卷积核的个数分别设置为384、384和256,卷积步长分别设置为1、2和1;

41.将第4深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

256、3

×3×

1和1

×1×

768,卷积核的个数分别设置为768、768和512,卷积步长设置分别为1、2和1;

42.将特征空间融合模块中的逐点卷积层卷积核大小设置为1

×1×

512,卷积核个数设置为1536,卷积步长设置为1;

43.将特征空间融合模块中的平均池化层的运算核大小设置为16

×

16

×

1,运算核个数为1536,运算步长设置为1;

44.使用random_normal_initializer函数将轻量级深度卷积神经网络中所有的卷积层、逐点卷积层和深度卷积层的权重初始化为满足正态分布的随机值;所述正态分布的标准差为0。

45.进一步地,所述生成训练集和验证集的步骤,包括:

46.获取若干ai厂家的不同入参数据类型;

47.随机调取不同的入参数据类型,并判定其被调用次数和匹配重复度;

48.若所述调用次数和匹配重复度均高于预设阈值,则选用其入参数据类型并重新执

行步骤。

49.进一步地,所述通过所述训练集和验证集训练轻量级深度卷积神经网络的步骤中,包括:

50.(1)从训练集和验证集中分别选取未选取过的入参数据类型;

51.(2)将所选取的入参数据类型输入到轻量级深度卷积神经网络中,输个入参数据类型的训练特征向量,利用轻量级深度卷积神经网络训练集损失函数,计算所选训练集的损失;

52.(3)将所选取的验证集的入参数据类型分别输入到轻量级深度卷积神经网络中,输出每个入参数据类型的验证集特征向量,利用轻量级深度卷积神经网络验证集损失函数,计算所选验证集入参数据类型对应的验证集损失;

53.(4)判断从训练集和验证集中分别选取入参数据类型的次数是否等于10,若是,则执行下一步(5),否则,重新执行步骤(1);

54.(5)分别将10个训练集损失和10个验证集损失按读取次序排列,得到训练集损失的变化趋势和验证集损失的变化趋势,判断训练集损失的变化趋势和验证集损失的变化趋势是否均为逐渐下降,若是,则执行步骤(4),否则,执行步骤(6);

55.(6)判断训练集损失的变化趋势和验证集损失的变化趋势是否均为保持不变,若是,则执行步骤(7),否则,采用与步骤(3)相同的方法重新生成另一组训练集和验证集后执行步骤(1);

56.(7)读取最后1个得到的训练集损失,利用梯度下降法计算轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层的每个卷积核的所有梯度;

57.(8)读取轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层的每个卷积核的所有梯度,使用adam优化器迭代更新轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层中每个卷积核的所有权重;所述adam优化器的初始学习率为0.0001;

58.(9)读取最后1个得到的验证集损失,判断是否最后1个得到的训练集损失大于0.1或最后1个得到的验证集损失大于0.4,若是,则执行步骤(1),否则,完成轻量级深度卷积神经网络的训练,得到训练好的轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层中每个卷积核的所有权重,保存为训练好的轻量级深度卷积神经网络各层权重参数,使用session.save函数保存训练好的轻量级深度卷积网络的网络模型。

59.进一步地,本发明还包括一种ai智能语音通话录音留存及通话控制装置,所述装置包括:

60.第一获取单元,获取用于ai语音系统厂家入参的第一内接数据;

61.损失算法单元,将所述第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据;

62.卷积网络单元,将所述第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口,所述通话接入端口包括始端接口、读秒端接口、指令端接口和末端接口;

63.监听单元,监听所述始端接口是否激活,若是则调用预设的录音指令,并根据所述录音指令存留从始端接口至末端接口时间段的第一语音信息;

64.第一判断单元,判断所述指令端接口是否获取到输入的人工通话信号,若是,则将所述指令端接口与人工外接端口进行对接;

65.第二判断单元,判断所述读秒端接口是否启用,若是,则继续判断从所述始端接口至读秒端接口的语音沟通时间段内是否存在预设的读秒接入信息,若存在,则通过所述读秒接入信息将所述读秒端接口与人工外接端口进行对接。

66.本发明提供了ai智能语音通话录音留存及通话控制方法和装置,具有以下有益效果:

67.通过外呼中心获取用于ai语音系统厂家入参的第一内接数据;将所述第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据;将所述第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口,所述通话接入端口包括始端接口、读秒端接口、指令端接口和末端接口;监听所述始端接口是否激活,若是则调用预设的录音指令,并根据所述录音指令存留从始端接口至末端接口时间段的第一语音信息;判断所述指令端接口是否获取到输入的人工通话信号,若是,则将所述指令端接口与人工外接端口进行对接;判断所述读秒端接口是否启用,若是,则继续判断从所述始端接口至读秒端接口的语音沟通时间段内是否存在预设的读秒接入信息,若存在,则通过所述读秒接入信息将所述读秒端接口与人工外接端口进行对接;实现通过卷积神经网络和损失迭代算法,减少参数运算量,以实现在人工重新接入ai语音时的反应速度,和对于录音的存留的技术效果。

附图说明

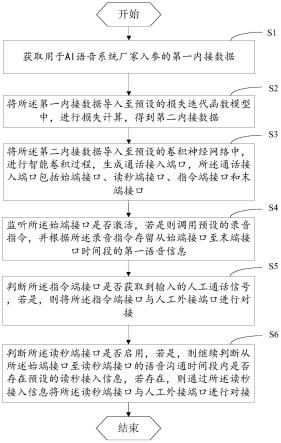

68.图1为本发明ai智能语音通话录音留存及通话控制方法和装置一个实施例的流程示意图;

69.本发明为目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

70.应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

71.下面将结合本发明的实施例中的附图,对本发明的实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明的一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

72.参考附图1,为本发明一实施例中的ai智能语音通话录音留存及通话控制方法的流程示意图;

73.本发明提出的一种ai智能语音通话录音留存及通话控制方法,包括:

74.s1,获取用于ai语音系统厂家入参的第一内接数据;

75.s2,将所述第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据;

76.s3,将所述第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口,所述通话接入端口包括始端接口、读秒端接口、指令端接口和末端接口;

77.s4,监听所述始端接口是否激活,若是则调用预设的录音指令,并根据所述录音指

令存留从始端接口至末端接口时间段的第一语音信息;

78.s5,判断所述指令端接口是否获取到输入的人工通话信号,若是,则将所述指令端接口与人工外接端口进行对接;

79.s6,判断所述读秒端接口是否启用,若是,则继续判断从所述始端接口至读秒端接口的语音沟通时间段内是否存在预设的读秒接入信息,若存在,则通过所述读秒接入信息将所述读秒端接口与人工外接端口进行对接。

80.在一个实施例中,所述将第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据的步骤,包括:

81.特征值归一化,将所述第一内接数据进行最大化分类,获得所述第一内接数据经过分类后的多类归一集合内的特征值集合;

82.归一化特征显著性融合,根据所述特征值集合中的各类别入参数据进行对标至预设的卷积神经网络输入门通道,并将所述特征值集合中的各类别入参数据输入至卷积神经网络;

83.损失计算和入参补全,对所述特征值集合中无法直接对标输入门的各类别入参数据进行损失计算,以得到计算后的损失结果,最终将损失结果套入至统一性模板中做入参补全,得到补全数据并导入至卷积神经网络。

84.在一个实施例中,所述将第一内接数据进行最大化分类,获得所述第一内接数据经过分类后的多类归一集合内的特征值集合的步骤中,所述特征值集合为:

85.fi=(f

ξapl1

,f

ξapl2,fξapl3

,

···

,f

ξapln

);

86.其中,fi为将第一内接数据进行多类归一集合内的特征值集合,f1至fn为特征值集合中各个入参函数类别、对接接口或链接协议,ξapl为预设的分类别准。

87.在一个实施例中,所述对特征值集合中无法直接对标输入门的的各类别入参数据进行损失计算,以得到计算后的损失结果,最终将损失结果套入至统一性模板中做入参补全的步骤中,包括:

88.所述损失计算的算法包括:

89.所述入参补全的算法包括:passwmax=g(fi)+maxξ

·

wh

90.其中,g(fi)为对特征值集合中的无法直接对标输入门的各类别入参数据进行损失计算后的特征值,wh为无法直接对标输入门的各类别入参数据在特征值集合中的位置信息,为特征值集合中的查验算法;

91.passwmax为对标卷积神经网络输入门的通道接口数值,maxξ为统一入参格式协议的指定阈值。

92.在一个实施例中,所述将第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程的步骤中,包括:

93.搭建一个轻度级深度卷积神经网络,其结构依次为:输入门、第1卷积层、深度可分离卷积模块组合、特征空间融合模块、第2卷积层和输出门;所述深度可分离卷积模块组合由4个结构相同的深度可分离卷积模块串联组成,每个深度可分离卷积模块结构依次为:第1逐点卷积层

→

深度卷积层

→

第2逐点卷积层;所述特征空间融合模块由逐点卷积层和平均池化层串联组成;

94.设置网络参数,并初始化所述轻量级深度卷积神经网络;

95.生成训练集和验证集;

96.通过所述训练集和验证集训练轻量级深度卷积神经网络;

97.设计现场可编程逻辑门阵列fpga中轻量级卷积神经网络的基本组成器件,并在现场可编程逻辑门阵列fpga中实现训练好的轻量级深度卷积神经网络。

98.在一个实施例中,所述将第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口的步骤中,包括:

99.轻量级深度卷积神经网络获取第二内接数据,并将所述第二内接数据中的入参数据拉入至预设的通话导轨中;

100.对所述通话导轨设置四个节点,进而创建所述始端接口、读秒端接口、指令端接口和末端接口。

101.在一个实施例中,所述设置网络参数,并初始化所述轻量级深度卷积神经网络的步骤,包括:

102.将第1卷积层和第2卷积层的卷积核大小分别设置为3

×3×

3和1

×1×

1536,卷积核个数分别设置为32和4,卷积步进分别设置为2和1;

103.将第1深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

32、3

×3×

1和1

×1×

96,卷积核的个数分别设置为96、96和64,卷积步长分别设置为1、2和1;

104.将第2深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

64、3

×3×

1和1

×1×

192,卷积核的个数分别设置为192、192和128,卷积步长分别设置为1、2和1;

105.将第3深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

128、3

×3×

1和1

×1×

384,卷积核的个数分别设置为384、384和256,卷积步长分别设置为1、2和1;

106.将第4深度可分离卷积模块中第1逐点卷积层、深度卷积层和第2逐点卷积层的卷积核大小分别设置为1

×1×

256、3

×3×

1和1

×1×

768,卷积核的个数分别设置为768、768和512,卷积步长设置分别为1、2和1;

107.将特征空间融合模块中的逐点卷积层卷积核大小设置为1

×1×

512,卷积核个数设置为1536,卷积步长设置为1;

108.将特征空间融合模块中的平均池化层的运算核大小设置为16

×

16

×

1,运算核个数为1536,运算步长设置为1;

109.使用random_normal_initializer函数将轻量级深度卷积神经网络中所有的卷积层、逐点卷积层和深度卷积层的权重初始化为满足正态分布的随机值;所述正态分布的标准差为0。

110.在一个实施例中,所述生成训练集和验证集的步骤,包括:

111.获取若干ai厂家的不同入参数据类型;

112.随机调取不同的入参数据类型,并判定其被调用次数和匹配重复度;

113.若所述调用次数和匹配重复度均高于预设阈值,则选用其入参数据类型并重新执行步骤。

114.在一个实施例中,所述通过所述训练集和验证集训练轻量级深度卷积神经网络的步骤中,包括:

115.(1)从训练集和验证集中分别选取未选取过的入参数据类型;

116.(2)将所选取的入参数据类型输入到轻量级深度卷积神经网络中,输个入参数据类型的训练特征向量,利用轻量级深度卷积神经网络训练集损失函数,计算所选训练集的损失;

117.(3)将所选取的验证集的入参数据类型分别输入到轻量级深度卷积神经网络中,输出每个入参数据类型的验证集特征向量,利用轻量级深度卷积神经网络验证集损失函数,计算所选验证集入参数据类型对应的验证集损失;

118.(4)判断从训练集和验证集中分别选取入参数据类型的次数是否等于10,若是,则执行下一步(5),否则,重新执行步骤(1);

119.(5)分别将10个训练集损失和10个验证集损失按读取次序排列,得到训练集损失的变化趋势和验证集损失的变化趋势,判断训练集损失的变化趋势和验证集损失的变化趋势是否均为逐渐下降,若是,则执行步骤(4),否则,执行步骤(6);

120.(6)判断训练集损失的变化趋势和验证集损失的变化趋势是否均为保持不变,若是,则执行步骤(7),否则,采用与步骤(3)相同的方法重新生成另一组训练集和验证集后执行步骤(1);

121.(7)读取最后1个得到的训练集损失,利用梯度下降法计算轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层的每个卷积核的所有梯度;

122.(8)读取轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层的每个卷积核的所有梯度,使用adam优化器迭代更新轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层中每个卷积核的所有权重;所述adam优化器的初始学习率为0.0001;

123.(9)读取最后1个得到的验证集损失,判断是否最后1个得到的训练集损失大于0.1或最后1个得到的验证集损失大于0.4,若是,则执行步骤(1),否则,完成轻量级深度卷积神经网络的训练,得到训练好的轻量级深度卷积神经网络每个卷积层、每个逐点卷积层和每个深度卷积层中每个卷积核的所有权重,保存为训练好的轻量级深度卷积神经网络各层权重参数,使用session.save函数保存训练好的轻量级深度卷积网络的网络模型。

124.本发明还提出一种ai智能语音通话录音留存及通话控制装置,所述装置包括:

125.第一获取单元,获取用于ai语音系统厂家入参的第一内接数据;

126.损失算法单元,将所述第一内接数据导入至预设的损失迭代函数模型中,进行损失计算,得到第二内接数据;

127.卷积网络单元,将所述第二内接数据导入至预设的卷积神经网络中,进行智能卷积过程,生成通话接入端口,所述通话接入端口包括始端接口、读秒端接口、指令端接口和末端接口;

128.监听单元,监听所述始端接口是否激活,若是则调用预设的录音指令,并根据所述录音指令存留从始端接口至末端接口时间段的第一语音信息;

129.第一判断单元,判断所述指令端接口是否获取到输入的人工通话信号,若是,则将所述指令端接口与人工外接端口进行对接;

130.第二判断单元,判断所述读秒端接口是否启用,若是,则继续判断从所述始端接口至读秒端接口的语音沟通时间段内是否存在预设的读秒接入信息,若存在,则通过所述读秒接入信息将所述读秒端接口与人工外接端口进行对接。

131.尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1