一种边缘计算下的轻量级联邦学习隐私保护方法与流程

本发明涉及边缘计算下的隐私保护领域,特别是涉及边缘计算下的一种边缘计算下的轻量级联邦学习隐私保护方法。

背景技术:

1、随着边缘计算的不断发展,联邦学习作为一种能完美契合边缘计算模式,还能将数据保留在终端设备上,降低数据泄露风险,很好解决数据孤岛问题的方法得到了广泛的应用,但随着梯度泄露攻击、共谋攻击等攻击手段的兴起以及传统联邦计算存在通信时延高的问题,众多研究者也在联邦学习框架下进行了诸多针对性优化,提出了任务卸载等方案解决上述问题,但是现有的方法大多无法降低进行隐私保护带来的大量通信成本,在边缘计算场景下存在较大的局限性。

2、综上所述,现有联邦学习改进方案存在如下缺点:

3、1)现有的降低联邦学习通信时延的方案,在数据从终端设备上传到边缘服务器的过程中存在隐私泄露的风险。

4、2)现有的解决联邦学习过程中隐私泄露的风险的方案,需消耗大量的时间和空间,耗费大量的通信成本,不适用于边缘计算下实时性的应用场景。

5、上述现有技术存在的缺点会影响联邦学习实现可信的隐私保护与高效的数据通信,使其无法满足边缘计算场景中高效低成本的传输需求,所以本发明提出一种边缘计算下的轻量级联邦学习隐私保护方案。

技术实现思路

1、本发明的目的在于解决联邦学习过程中隐私泄露的风险的方案,需消耗大量的时间和空间,耗费大量的通信成本,不适用于边缘计算下实时性的应用场景的问题。

2、本发明为了实现上述目的采用以下技术手段:

3、一种边缘计算下的轻量级联邦学习隐私保护方案,包括以下步骤:

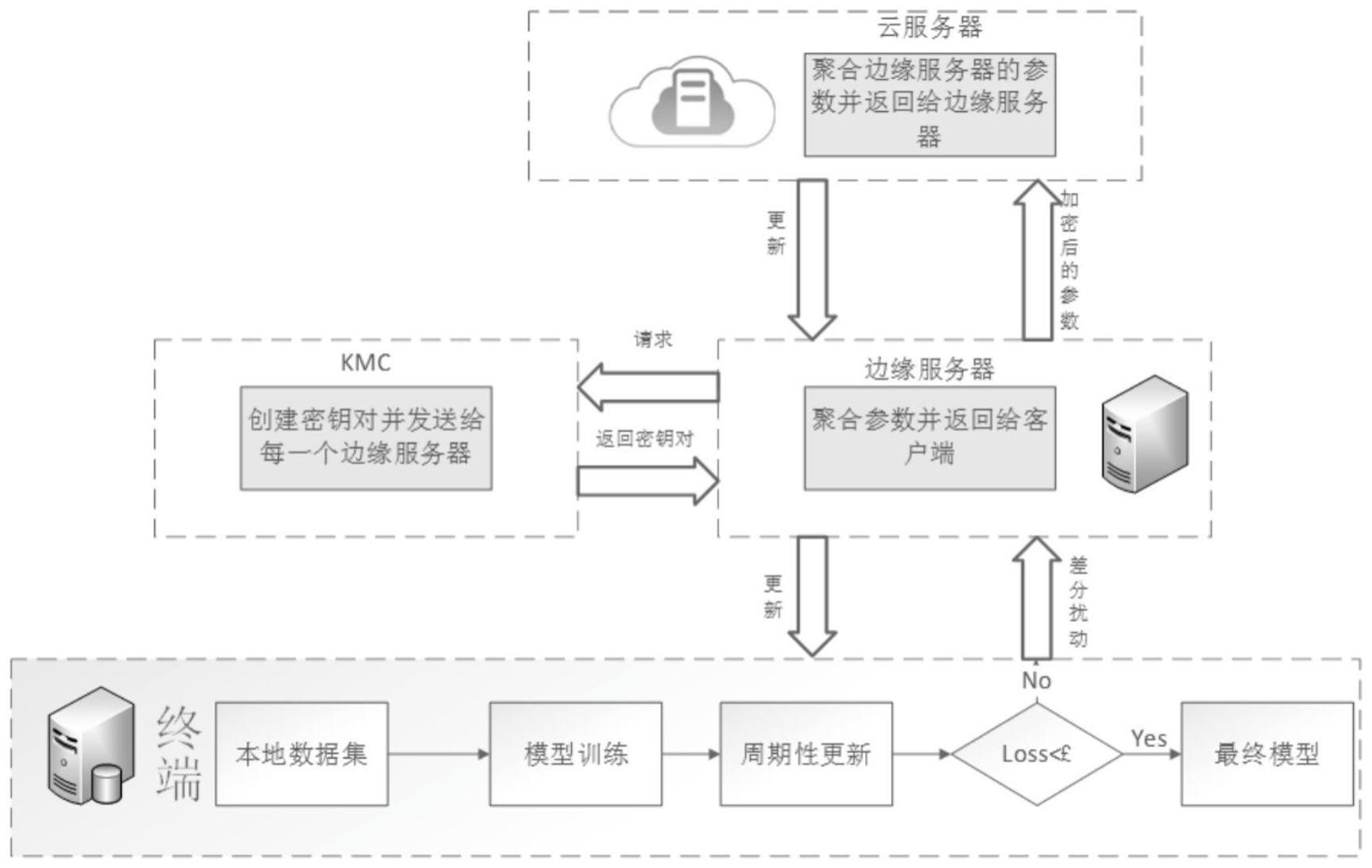

4、s1:建立云-边-端分层的联邦学习架构:采用不同的终端设备负责进行神经网络模型训练,而边缘服务器和云服务器进行神经网络模型参数聚合;

5、s2:采用基于差分隐私和同态加密的两层隐私保护方案:在终端设备训练得到神经网络模型参数后,对其进行差分扰动,再上传给边缘服务器,边缘服务器迭代训练得到神经网络模型参数后,对神经网络模型参数进行同态加密后传输到云服务器进行聚合;

6、s3:实施在本地和边缘服务器端多次迭代更新的策略:在终端设备上设置训练轮数阈值,当更新次数达到阈值,将本地模型上传到边缘服务器,同时在边缘服务器设置另一个阈值,当训练次数达到阈值时,将神经网络模型参数上传到云服务器进行聚合更新。

7、上述技术方案中,s1中云-边-端分层联邦学习架构的详细描述如下:

8、s11:终端设备负责数据采集和预处理,从边缘服务器获取神经网络模型框架,终端设备在本地对神经网络模型进行周期性更新,得到本地模型参数,并向边缘服务器上传本地模型参数;

9、s12:边缘服务器从云端获取需要训练的神经网络框架,将其发送给参与训练的终端设备,对终端设备上传的神经网络模型参数进行聚合,聚合后得到局部模型参数,即边缘服务器上的模型参数;

10、s13:中央云服务器聚合各个边缘服务器上传的局部模型参数,得到全局模型参数,并将聚合后的全局模型参数发送到边缘服务器,得到新的神经网络模型框架,边缘服务器发送全局模型参数给终端设备,终端设备用参数更新设备上的神经网络模型,进行下一轮训练。

11、根据权利要求1所述的一种边缘计算下的轻量级联邦学习隐私保护方案,其特征在于,s2中,基于差分隐私的模型参数保护机制的详细描述如下。

12、s211:终端设备di拥有数据集di,数据集di包括数据xi和标签ti,将数据集di按照7∶3的比例划分为训练集dtrain和测试集dtest,然后将训练集dtrain作为终端设备上的神经网络模型的输入进行模型训练,设终端设备上的神经网络模型的输出为y,则:

13、y=f(xi) (1)

14、s212:在每一轮训练完成之后,将测试集dtest输入到终端设备上的神经网络模型中,对比y和标签ti计算损失值为f(xi)-ti:

15、终端设备di上的第t轮神经网络模型的梯度算公式如下:

16、

17、其中是通过损失值对模型参数进行求导;

18、对神经网络模型梯度进行裁剪,裁剪公式如下:

19、

20、s213:设k次训练的终端设备上的神经网络模型参数为数据集di到神经网络模型参数的映射函数为h,第k次训练时划分的训练数据集为dk,终端设备上的神经网络模型参数与训练数据集dk的映射公式如下:

21、

22、s214:神经网络模型参数被攻击者窃取的概率为p,根据数据集与终端设备上的神经网络模型参数的映射关系,令隐私预算对第k次训练的模型参数添加加性噪声,噪声添加如下:

23、

24、其中lap为拉普拉斯分布,δg为查询敏感度,将神经网络模型参数进行差分扰动后,上传给边缘服务器,是终端设备i用数据集di在第t轮训练后得到的模型参数;是指终端设备i在用另一个数据集d′i训练t轮后得到的模型参数。上述技术方案中,s2中,面向边云模型传输的同态加密机制的详细描述如下:

25、s221:密钥管理中心(kmc)收到来自边缘服务器的请求之后,创建密钥对并分发给边缘服务器,密钥生成采用满足加法同态的paillier算法,密钥生成与分配算法如下所示:

26、输入边缘服务器集合e

27、for j in e:

28、1.随机选取大素数p和q且满足p*q和(p-1)*(q-1)的最大公因数为1

29、2.令p*q为n,(p-1)和(q-1)的最小公倍数为λ;

30、3.随机选取g且满足g的阶(mod n2)为n的倍数;

31、4.生成公私钥对,公钥为(n,g),私钥为λ;

32、5.将公私钥对发送给边缘服务器j;

33、s222:使用同态加密算法来加密上传的参数,模型更新公式如下所示:

34、

35、e()是同态加密是边缘服务器j在第t轮训练中迭代聚合k次后的参数是终端设备i在第t轮训练中迭代k次训练后得到的模型参数d是终端设备的总数量e是边缘服务器的总数量;

36、s223:关于模型参数具体的加密算法如下所示:

37、ωt是第t轮迭代完成后聚合得到的模型参数

38、输入:模型参数ωt,ωt是第t轮迭代完成后聚合得到的模型参数;

39、使用random()生成随机向量r

40、计算密文

41、计算

42、解密

43、上述技术方案中,s3中,本地和边缘服务器端多次迭代更新的策略的详细描述如下:

44、s31:得到第k次训练的模型梯度后,判断k是否小于k1,若k小于阈值k1,则在本地对模型参数进行更新,更新公式如下:

45、

46、η表示学习率,若k等于k1,则将模型参数发送给边缘服务器进行聚合:

47、s32:在边缘服务器进行模型参数聚合与更新时,k1表示在每轮训练中,终端设备上迭代次数的阈值,k2表示在边缘服务器上迭代次数的阈值,当训练轮数t中,当迭代次数未到达k1*k2次时,边缘服务器对d个终端设备上传的模型参数进行聚合并进行同态加密得到当迭代次数达到k1*k2次时,则将边缘服务器解密得到的模型参数更新,同时进行下一轮训练。

48、由于采用了上述技术方案,本发明的有益效果是:

49、1.本发明一种边缘计算下的轻量级联邦学习隐私保护方案,建立了云-边-端分层联邦学习架构,允许多个边缘服务器执行部分模型聚合,避免了服务器访问客户端数量有限的问题,更好的实现了通信-计算权衡,大大缩短了通信时延。

50、2.本发明一种边缘计算下的轻量级联邦学习隐私保护方案,创新性的差分隐私技术和同态加密算法引入到模型参数的上传中,在本地训练的模型参数中添加拉普拉斯噪声来进行隐私保护,在边缘服务器与中心云服务器进行模型参数聚合时进行同态加密,既减少了加密次数,又能保证模型参数的隐私性,实现了本地数据集和模型参数的隐私保护。

51、3.本发明一种边缘计算下的轻量级联邦学习隐私保护方案,在终端设备上采用周期性更新策略,在一轮训练中进行多次更新,避免传统同步联邦学习因终端设备算力不同造成的资源浪费;同时在边缘服务器进行局部聚合时也采用多次聚合更新,更加高效地进行模型更新,实现了更快地收敛模型。

- 还没有人留言评论。精彩留言会获得点赞!