一种基于深度强化学习的无线体域网任务卸载与资源分配方法

本发明涉及一种基于深度强化学习的无线体域网任务卸载和资源分配方法,属于无线通信技术范畴。

背景技术:

1、为了让患者和临床医生尽可能获得最好的治疗,实时医疗保健监控必不可少且至关重要。图2描绘的是无线体域网与边缘服务器构成的系统模型图。无线体域网(wirelessbody area network,wban)是一种以人体为中心,由若干个可穿戴或植入的生理传感器组成。通过感知与人体相关的生理参数,如体温、血压、心电图(ecg)信号、脑电图(eeg)信号等。这有助于推进电子医学。但是,受限于wban的有限的电池容量和数据处理能力,这可能会导致完成任务的延迟增加、不可靠,甚至失败,这是不可接受的,因为这些任务(例如生理数据传输、健康状况评估等)与生活有关。因此,wban相关研究面临的一个挑战是如何为用户提供电池寿命长、数据可靠性高、支持个性化定制的服务。

2、此外,移动边缘计算(mec)作为研究主题也越来越受欢迎。mec在移动网络边缘部署分布式计算能力,利用无线接入网络为用户提供计算和信息技术服务。基于mec技术,wban通过将部分高计算密度的计算任务从wban设备卸载至计算资源丰富且物理位置上更靠近wban的边缘服务器上执行,以降低执行时延和能量损耗。从而提高wban设备的续航时间、数据处理能力和用户的使用体验。基于mec的wban应用的主要挑战是如何制定一个最优的wban卸载策略,以在不同的网络环境和限制下充分利用网络资源。

3、目前的研究大多集中在优化延迟和能耗上,这对wban的应用尤为重要。但是,很少有算法考虑到wban和mec之间的干扰,这在实际的wban应用场景中是不可避免的。

技术实现思路

1、本发明的目的是提供一种基于深度强化学习的无线体域网任务卸载与资源分配方法。将边缘服务器和无线体域网作为一个整体系统来优化执行延迟和系统能量为目标,以提高无线体域网数据处理的时效性和可靠性。

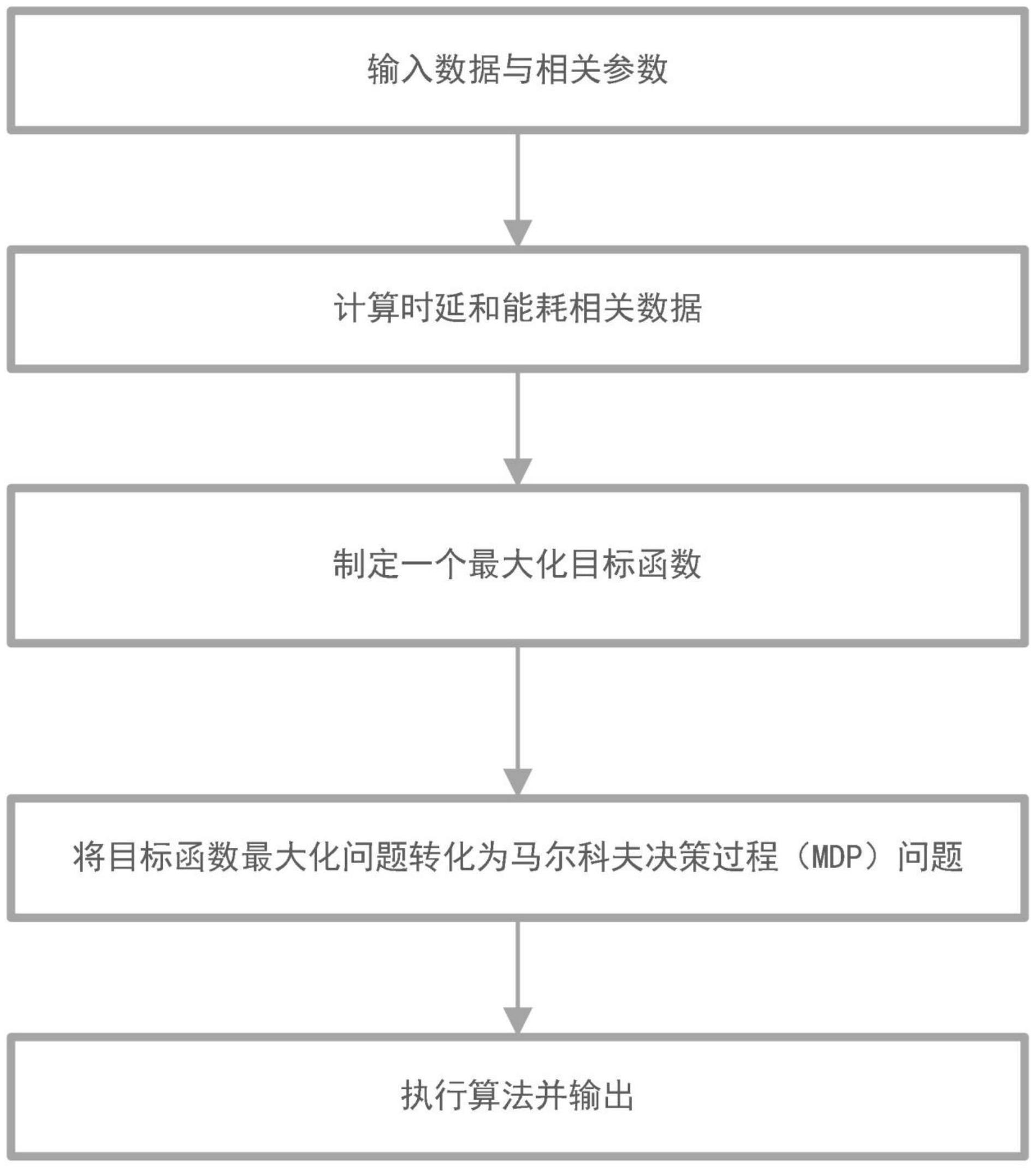

2、为解决上述技术问题,本发明提供的一种基于深度强化学习的无线体域网任务卸载与资源分配方法,具体技术方案如下:

3、步骤1:输入无线体域网设备的数据和相关参数。

4、步骤2:计算任务完成的总时间和总能耗:计算信干噪比(signal-to-interference-to-noise ratio,sinr);计算任务数据传输速率;计算无线体域网设备任务处理的时间与能耗;计算边缘服务器任务处理的时间与能耗;计算处理任务的传输时间与能耗,并汇总计算时间与能耗数据。

5、步骤3:制定一个最大化目标函数:根据sinr,总时延和总能耗。引入时延因子,能耗因子和sinr因子表示延迟,能耗和sinr占比。

6、步骤4:将目标函数最大化的问题转化为马尔可夫决策过程(mdp)问题;

7、步骤5:执行算法并输出,得到任务的最优卸载决策。

8、进一步地,,所述步骤1的包括输入传输数据大小dn、无线体域网设备和边缘服务器的相关参数等。构建一个用于通信任务卸载的无线体域网(wireless body areanetwork,wban)集合,包括n个wban和m个mec。

9、进一步地,所述步骤2如下具体步骤:

10、步骤2-1,计算系统中的信干噪比其中表示wbann的传输功率,表示wbann的信道增益,表示来自同一个边缘服务器上的其他wban引起的干扰,表示来自其他边缘服务器上的wban引起的干扰,σ2表示为高斯白噪声。

11、步骤2-2:计算任务数据传输速率其中表示wban到边缘服务器mec的信道带宽。

12、步骤2-3,当卸载率不等于1时,计算任务需要留在wban执行时间与能耗其中表示无线体域网的卸载率,表示任务执行需要的wban cpu周期,为wban的cpu频率。其中是wban的执行功率。

13、步骤2-4,当时,计算任务传输的时间与能耗本发明假设mec服务器具有足够的计算资源。一旦服务器从wban收到卸载任务就立马处理它,因此无需排队等待。

14、步骤2-5,计算任务在mec处理的时间与能耗其中,表示在mec服务器中处理一比特数据所需的cpu周期数,其中更高的ξ(k)会导致更高的由于mec服务器具有足够的供电容量,因此忽略了其能耗

15、步骤2-6,汇总任务的计算时间与能耗

16、

17、

18、

19、进一步地,所述步骤3如下具体步骤:

20、考虑到wban对延迟非常敏感且能量有限,同时还会受到干扰攻击。本发明将mec系统的卸载和资源分配视为一个优化问题。将原本无线体域网任务卸载与资源分配的决策的问题转化为求解系统收益最大化问题。该问题具体数学表达是:其中,λ1、λ2和λ3分别为和对应的常数项。根据当时系统的状况,不同的任务可能具有不同的权重。例如,如果节点电池容量较低,则应更改能耗系数以节省更多能量。如果任务延迟要求是敏感的,应调整延迟因子来减少延迟。在高干扰环境中调整sinr的加权因子来减少干扰。

21、进一步地,所述步骤4如下具体步骤:

22、本发明创建马尔可夫决策过程来解决目标函数优化问题。一个mdp由四部分组成,写成mdp={s,a,p,r},其中s表示状态空间,a表示动作空间,p表示状态转移概率,r表示奖励函数。在k时刻,wban根据当前系统状态s(k)创建动作a(k)。在执行该操作后,状态将更改为s(k+1)。然后,获得一个奖励r(k)。

23、步骤4-1,状态空间:其中,和由mec分配,其他由wban的协调器观察得到。

24、步骤4-2,动作空间:其中mecm表示为边缘节点的选择,表示为传输功率,表示为卸载率。

25、步骤4-3,状态转移概率:如果随机过程表现为mdp,则其未来状态独立于任何先前状态,仅取决于其当前状态。因此,状态转移概率p(s(k+1)|s(k),a(k))表示给定s(k)和a(k)的s(k+1)的概率分布。由于wban没有关于p(s(k+1)|s(k),a(k))的先验知识,因此状态转移概率只能由环境来决定。

26、步骤4-4,奖励函数:奖励函数表示在当前的状态s(k)中选择动作a(k)时的奖励。旨在减少计算延迟,减少能源消耗,增加卸载传输的sinr。

27、进一步地,所述步骤5如下具体步骤:

28、为了优化上述的mdp问题,本节提出了一种基于深度强化学习的无线体域网任务卸载与资源分配方法。该算法的详细信息如下。

29、步骤5-1,首先定义策略μ和值函数qμ(s(k),a(k))。根据bellman方程计算值函数qμ(s(k),a(k)):qμ(s(k),a(k))=e[r(k)+gq(s(k+1),μ(s(k+1)))];其中a(k)=μ(s(k+1))表示策略μ是从状态到动作的映射。

30、步骤5-2,为了提高批评网络对q值的近似精度,通过adam算法对参数进行更新,以最小化损失函数l(qq):l(qq)=e[(q(s(k),a(k)|qq)-y(k))2];其中y(k)=r(k)+gq'(s(k+1),μ'(s(k+1)|qμ')|qq')。

31、步骤5-3,wban在选择a(k)后将得到r(k),并且当前状态将从s(k)变更为下一个状态s(k+1)。然后,将元组{s(k)、a(k)、r(k)、s(k+1)}存储在重放内存缓冲区rmb中。同时,从rmb中随机抽取v个数据量来训练评价网络。因此,根据步骤5-2的公式l(qq)计算方法,计算损失函数:

32、步骤5-4,在决策机制中引入随机噪声来探索可能的策略μ。动作策略η的公式表示:η=μ(s(k)|qμ)+ρ(k);其中ρ(k)为均值为零的高斯噪声。

33、步骤5-5,将动作网络的目标函数设为jh(μ):jh(μ)=eρh[qμ(s(k),μ(s(k)|qμ))];其中,ρh是基于不同动作策略η的状态概率分布函数。为了使jh(μ)最大化,必须通过改变梯度来训练参数qμ。

34、步骤5-6,为了使批评网络的输出更加稳定,本发明分别从参与者网络和批评网络中复制了两个目标网络。更新这两个目标网络的参数的计算公式表示:其中,τ为限制目标值的变化速率,这可以增加神经网络训练的稳定性。

35、本发明提出基于深度强化学习的无线体域网任务卸载与资源分配方法具有以下优点:本发明将卸载决策技术运用在无线体域网中,wban将部分计算任务卸载至边缘服务器上执行,缓解了对无线体域网中心节点的计算压力,缓解了因无线体域网硬件资源的限制而造成的数据处理的高时延低效率问题;本发明引进sinr,解决了真实数据可靠传输的干扰问题;通过选择最优的卸载策略,使得所有无线体域网的数据任务能够尽快处理,减少时延和能耗,并实现边缘服务器的负载均衡,从而提高整个无线体域网的容量和通信效率。

36、

- 还没有人留言评论。精彩留言会获得点赞!