一种基于RIS辅助的NOMA边缘计算动态任务传输功率分配方法

本发明属于边缘计算,具体涉及一种基于ris辅助的noma边缘计算动态任务传输功率分配方法。

背景技术:

1、6g无线峰会的愿景宣言概括了6g的精髓,即“无线智能无处不在”。应用程序的激增预计将导致大量需要计算的任务,如人脸识别、虚拟/增强现实和在线人工智能等。然而,设备有限的计算资源可能会导致用户体验质量下降。

2、将所有本地数据传输到云端进行培训和处理是不可行的。为了解决这个问题,移动边缘计算(mec)通过增强无线接入网络(ran)的计算能力,为执行低延迟、低能耗要求的任务提供了新的机会。

3、此外,在6g的新兴技术中,可重构智能表面(ris)已成为未来通信系统的创新技术。ris是一种新型的人工电磁表面,可以提高频谱空间效率,显著改变mec系统的信道条件。此外,非正交多址(noma)被认为是即将到来的6g时代的关键无线电接入技术,使用户能够重复使用相同的频域资源,从而节省能源和频谱资源。基于noma的mec系统在有效延迟和节能方面优于基于正交多址(oma)的mec系统。

4、然而,现有研究并没有考虑到传输问题的动态性,即任务到达的随机性,在功耗和缓冲延迟方面并未最小化长期平均网络计算成本。

技术实现思路

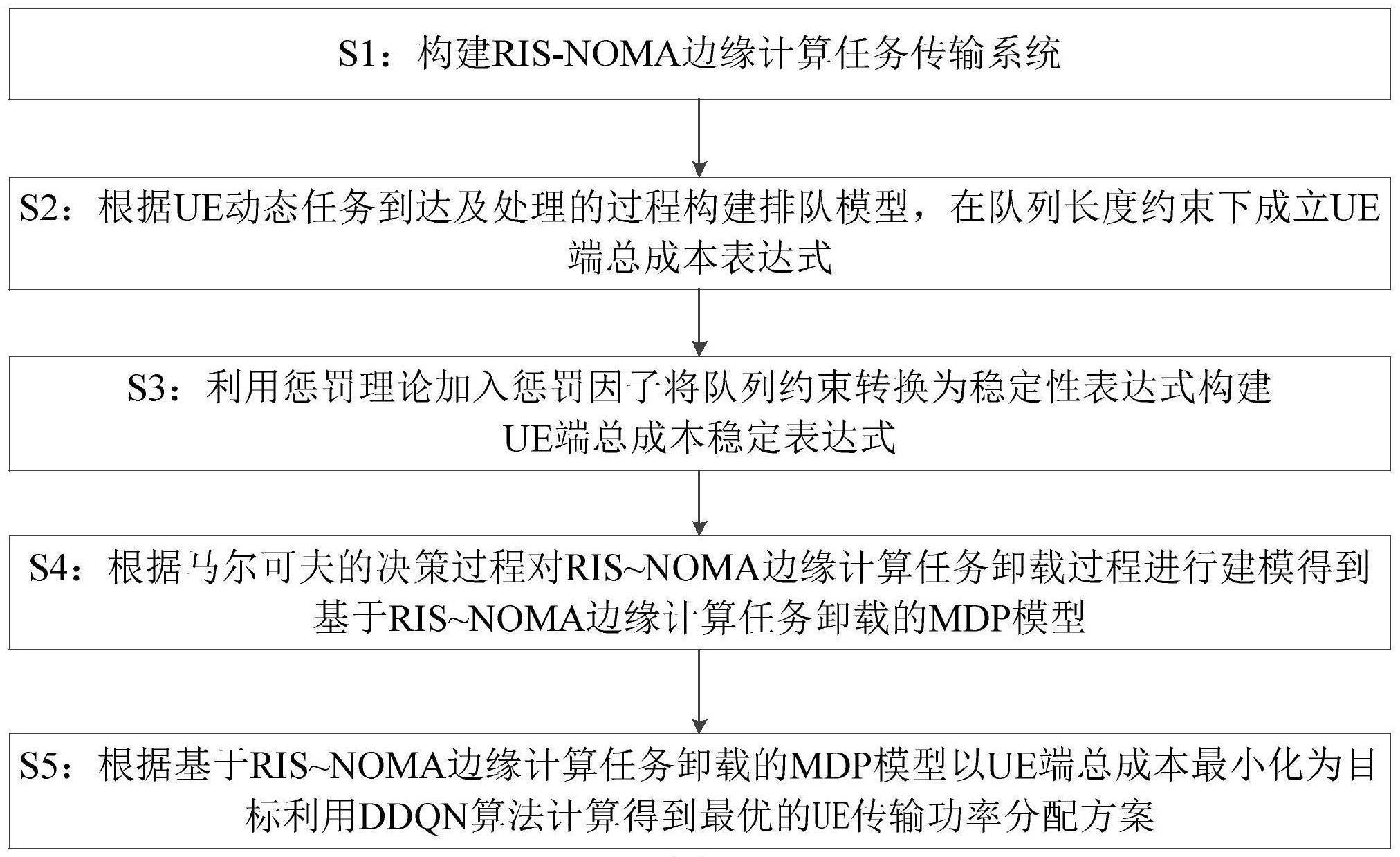

1、为了解决背景技术中存在的问题,本发明提供一种基于ris辅助的noma边缘计算动态任务传输功率分配方法,在基于ris辅助的noma边缘计算动态任务传输场景中,考虑用户任务队列约束的动态任务传输功率分配方案,以最小化系统用户总成本,包括如下步骤:

2、s1:构建ris-noma边缘计算任务传输系统,该系统包括:配备m根天线和mec服务器的ap、k个单天线的ue、以及具有n个反射元件的ris;通过控制ris的相移改变ap和每个ue之间的信道增益;每个ue将计算任务划分为本地计算任务和边缘计算任务;每个ue采用上行noma分别通过ue-ris-ap链路和ue-ap链路同时将边缘计算任务传输到ap,ap接收到叠加信号,利用sic技术进行解码并进行边缘计算;

3、s2:根据ue动态任务到达及处理的过程构建排队模型,在队列长度约束下成立ue端总成本表达式;

4、s3:利用惩罚理论加入惩罚因子将队列约束转换为稳定性表达式构建ue端总成本稳定表达式;

5、s4:根据马尔可夫的决策过程对ris-noma边缘计算任务传输过程进行建模得到基于ris-noma边缘计算任务传输的mdp模型;

6、s5:根据基于ris-noma边缘计算任务传输的mdp模型以ue端总成本最小化为目标利用ddqn算法计算得到最优的ue传输功率分配方案。

7、进一步地,所述ap接收到叠加信号包括:

8、

9、其中,为第k个ue的传输功率,为均值和单位方差为零的传输信号,为以σ2为噪声功率的ap端的加性高斯白噪声,im是一个m×m的单位向量矩阵,表示表示第k个ue到ris的信道增益系数,表示第k个ue到ap的信道增益系数,g表示ris到ap的信道增益系数,θt表示ris的反射系数矩阵。

10、进一步地,所述构建排队模型包括:

11、s21:调整ue端芯片的电压控制ue端的cpu频率;

12、

13、其中,g为有效的开关电容,表示第k个ue的本地计算功率;

14、s22:根据ue端的cpu频率和ue端处理一bit任务数据所需的cpu周期数量计算ue端在单个时隙内本地计算的任务bit数量;

15、

16、其中,表示第k个ue端在第t个时隙内本地计算的任务bit数量,lk表示第k个ue端处理一bit任务数据所需的cpu周期数量,τ0表示单个时隙的长度,表示用户k的cpu频率

17、s23:根据ue在ris-noma边缘计算任务传输系统中的数据传输速率计算ue端在单个时隙内传输到ap端的任务bit数量;

18、

19、其中,表示第k个ue端的数据传输速率,表示第k个ue端在第t个时隙内传输到ap端的任务bit数量;

20、s24:根据ue端在单个时隙内本地计算的任务bit数量和传输到ap端的任务bit数量构建排队模型。

21、进一步地,所述排队模型包括:

22、

23、

24、其中,表示第t+1个时隙任务队列的长度,,表示在时隙t期间到达用户k的任务bit数,表示在时隙t期间处理的总任务bit数。

25、进一步地,所述ue在ris-noma边缘计算任务传输系统中的数据传输速率包括:

26、

27、

28、

29、其中,b表示系统的带宽,表示第k个ue在时隙t内的信噪比,为波束赋形向量,σ2为噪声功率,为第k个ue的传输功率,为第k个ue在t时隙内的总信道增益。

30、进一步地,所述ue端总成本表达式包括:

31、

32、

33、其中,ω1∈[0,1]和ω2∈[0,1]为非负权重系数且满足ω1+ω2=1,t表示时隙最大值,即t∈{1,...,t},ck表示ue端总成本表达式,表示预定义的平均队列长度值,对于所有的ue,其平均队列长度不超过为第k个ue的传输功率,表示第k个ue的本地计算功率。

34、进一步地,所述ue端总成本稳定表达式包括:

35、

36、

37、其中,v1表示为加权参数,用于控制队列稳定性的影响程度。表示虚拟队列,虚拟队列的平均速率稳定性等价于满足队列长度约束程度。

38、进一步地,所述基于ris-noma边缘计算任务传输的mdp模型ξ包括:其中,象征状态空间,为动作空间,表示奖励,为状态转移概率;

39、状态空间

40、

41、其中,表示信道状态,表示用户队列任务数据bit数;

42、动作空间

43、

44、其中,表示本地计算功率集合表示任务传输发射功率集合表示无源相移器的相移集合

45、奖励

46、

47、其中,c′k表示ue端总成本稳定表达式;

48、状态转移概率:设表示状态转移概率,即给定状态st和所选择的动作at后到达状态st+1的概率分布。

49、进一步地,所述利用ddqn算法计算得到最优的用户功率分配方案包括:

50、s51:指定奖励衰减因子γ,随机初始化q网络的参数,构建ddqn方法所需的目标网络q',目标网络q'网络的网络结构及网络参数与q网络相同,指定目标网络q'网络的更新步长j;指定经验回放梯度批量下降的每批次采样样本数w,清空经验回放合集d;指定探索率ε;

51、s52:初始化系统环境,将初始化环境状态向量赋值给当前环境状态st;

52、s53:将当前环境状态st作为输入向量输入q网络,得到所有对应的输出q(st,a);使用ε-greedy策略在输出中选择动作at,ε-greedy策略:

53、

54、π表示策略函数;

55、s54:在当前环境状态的变量st下执行动作at,转换环境状态,得到动作执行后状态st与动作执行过程中的奖励反馈rt,将过度序列(st,at,rt,st+1)存入经验回放合集d;

56、s55:使用均方差损失函数,采用随机梯度下降法更新q神经网络参数;

57、s56:根据ddqn方法流程,每经过j轮迭代,更新目标网络q'网络为q网络,即更新网络参数;

58、s57:将动作执行后状态st+1赋值给当前环境状态st,转至步骤s53进行下一轮迭代。

59、进一步地,所述均方差损失函数如下:

60、

61、其中,loss(θ)表示损失函数,θt表示q神经网络参数,θt-表示目标网络q'网络的网络参数,表示在q网络中与状态st的q最大值相关联的动作。

62、本发明至少具有以下有益效果

63、本发明的最终目标是在加入ris与noma技术的场景中,提供考虑用户任务队列约束的动态任务传输功率分配方案,以最小化系统用户总成本。所提出的方案以ddqn框架为基础,结合了拥有ris-noma特性的环境,通过迭代训练更新神经网络参数,最终能在不同情况下获得最优功率分配策略指导任务传输。

64、本发明与现有技术相比,其显著优点为:1)利用ris与noma技术的互补特性,改善了mec系统中的通信链路不完善问题;2)将任务队列进行建模,考虑了边缘计算场景中的动态性,使方法更接近实际最优解;3)提出基于ddqn的任务传输功率分配算法,不仅具有较高的收敛精度且稳定性强,更容易找到使用户成本最小化的全局最优解。

- 还没有人留言评论。精彩留言会获得点赞!