基于深度强化学习的智能服务功能链部署方法及系统与流程

本发明涉及服务功能链部署领域,具体来说,涉及了一种基于深度强化学习的智能服务功能链部署方法及系统。

背景技术:

1、5g作为当前的核心通信技术,其通过采用网络功能虚拟化(network functionsvirtualization,nfv)、软件定义网络(software defined networking,sdn)等先进技术支持更多的应用场景,旨在增强网络的灵活性与可扩展性,为大量用户提供更加高速率、低时延以及定制化的网络服务。根据不同场景下业务需求的差异性,5g将应用场景分为增强移动带宽(embb)、海量机器类通信(mmtc)以及高可靠低时延(urllc)三大类。对于同一指标而言,这些场景下的用户的网络质量(quality of service,qos)需求也存在明显差异化。如车联网场景需要实时感知车辆以及道路情况,因此其对时延要求较高,要小于1ms;而在视频会议和4k/8k视频场景下时延要求相对宽裕,分别小于10ms和100ms即可。

2、在nfv和sdn使能的5g网络中,原本必须用专业硬件支持的功能成为能在通用设备上运行的虚拟网络功能(virtualized network functions,vnf),这大幅度降低了5g网络的成本和运营支出,增加了网络的灵活性及可扩展性。具体而言,当用户发出服务请求后,服务运营商会将用户请求所需要的若干vnf组成一条服务功能链(service functionchaining,sfc),并依据智能算法把sfc中的每个vnf按照顺序部署在服务器上运行。部署过程中网络服务器和链路的资源需要满足运行和传输vnf的需求(如计算资源、带宽等),这一资源分配问题也被称为sfc编排问题,这一问题已被证明是np难问题。

3、在sfc编排过程中,满足vnfs的时延和负载均衡是保证最佳性能和用户体验的关键。具体而言,由于不同的业务需求对时延的要求不同,如何在有效时间内放置具有时延差异的vnfs是运营商为用户提供满意服务的基础。此外,在网络请求数量剧增的当下,如何均衡各台服务器所承载业务,有效防止服务器负载过大而导致的网络崩溃也是sfc编排所面临的具体挑战之一。

4、随着智能算法的不断发展,sfc编排问题已经在单目标优化算法方面取得较大进展。liu等人以优化端到端时延为目标,提出了一种基于深度强化学习(deepreinforcement learning,drl)的sfc-dop算法部署用户请求,但其忽略了节点的负载均衡能力。以提高sfc接受率为目标,li等人提出了一种基于禁忌搜索的vnf映射调度算法,但其没有考虑整体网络环境下用户请求的多样性。考虑到用户请求的实时性与随机性,fan等人利用图卷积神经网络在线学习底层网络环境特征,同时利用启发式算法和drl优化sfc编排模型,但没有解决在线编排过程中的时延和负载均衡问题。hurmat等人将sfc部署问题建模为马尔可夫决策过程,并以增大供应商效益为目标,通过多个drl代理同时处理多条sfc放置问题。然而,这类算法在解决部署问题时存在巨大的局限性,这是由于传统的单目标优化算法没有考虑不同场景下qos的多样性。因此,如何从多个目标出发满足不同场景下用户的qos需求至今仍是一个难题。

技术实现思路

1、本发明的目的是针对现有技术的不足,提供一种基于深度强化学习的智能服务功能链部署方法及系统。与其他只关注同场景下的sfc编排方法不同,本发明针对不同场景下的sfc编排问题,利用深度强化学习来构建帕累托最优解集,在满足场景所需要时延等要求的同时,尽量使负载均衡。

2、为了实现上述目的,本发明所采用的技术方案是:

3、本发明第一方面提供一种基于深度强化学习的智能服务功能链部署方法,包括:

4、搭建用于预测sfc中vnfs占用的服务器和链路的神经网络预测模型;

5、训练所述神经网络预测模型;

6、利用已经训练好的神经网络预测模型来编排sfc。

7、基于上述,所搭建的用于预测sfc中vnfs占用的服务器和链路的神经网络预测模型,在进行预测时,先预测占用的服务器,再计算连接服务器间推荐的路径。

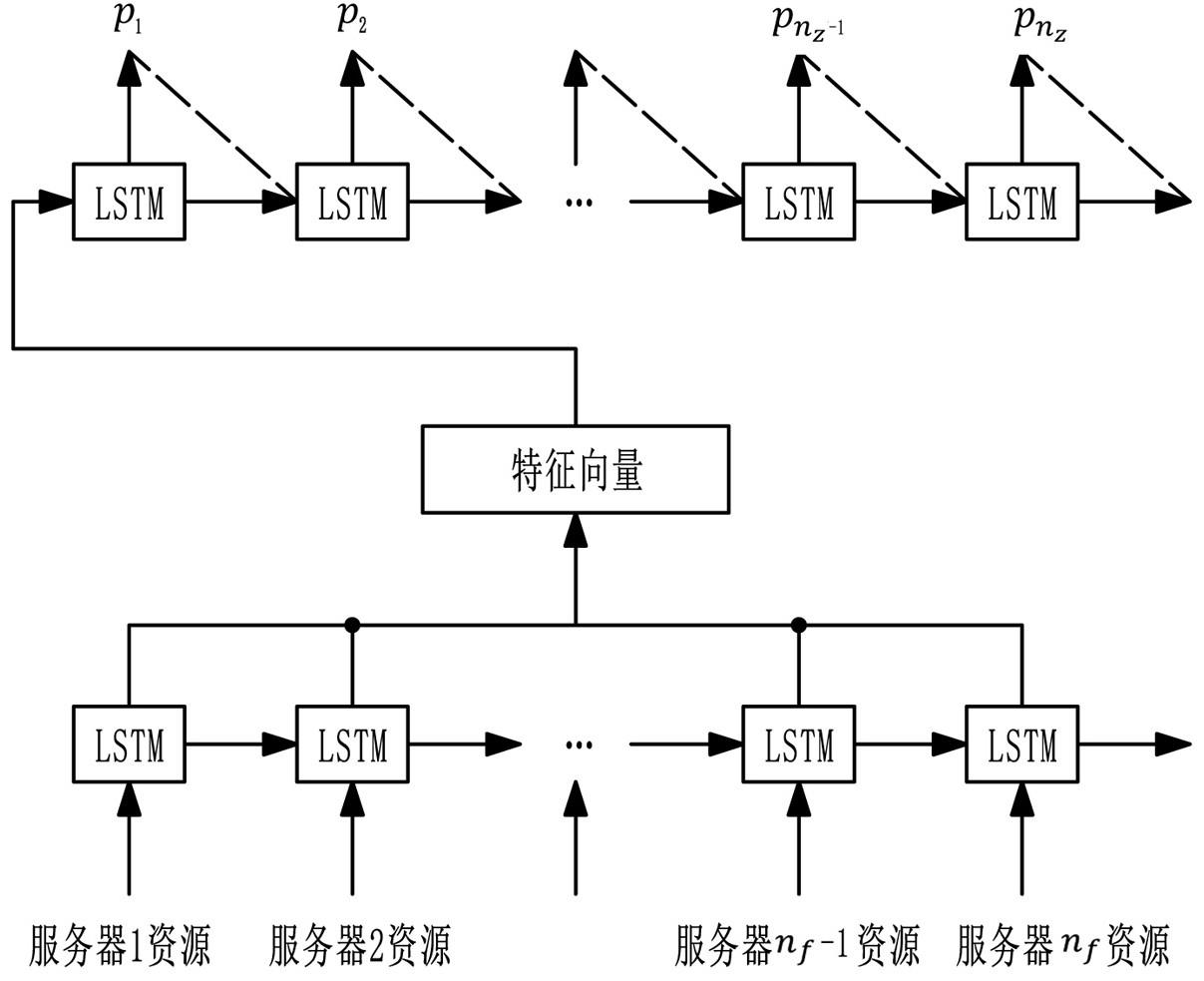

8、基于上述,所述神经网络预测模型中用于预测占用的服务器的模型由多个相同结构的神经网络模型组成;

9、所述神经网络模型包括输入层、编码器、解码器和输出层;

10、所述输入层,用于对底层网络中服务器的计算资源、度和相连链路的带宽资源数据进行处理并归一化为一个3×nf的特征矩阵,其中nf为底层网络中服务器的数量;

11、所述编码器,由多个长短期记忆递归神经网络lstm组成,lstm通过三个门结构提取底层网络最终的隐藏状态ct,t=1,2,…,nf;

12、所述解码器,由多个lstm组成,输入是所述编码器最后的隐藏状态经过一系列lstm运算后输出最终的其中,为选择第t个服务器的概率;

13、所述输出层,采用抽样函数,用于对所述解码器中的输出概率进行抽样,获得占用的服务器。

14、基于上述,长短期记忆递归神经网络lstm通过三个门结构提取底层网络最终的隐藏状态ct的方法为:

15、第一个门结构设置为遗忘门,将此节点的特征xt和上一个lstm的输出ht-1做一个非线性映射,输出一个向量ft=σ(θf(hf-1+xt)+bf),其中,θf和bf是遗忘门结构的权重和偏移,ft的值域在[0,1]间,代表了不同的保留程度,0为完全不保留,1为完全保留;

16、第二个门结构设置为输入门,首先决定要更新的值it=σ(θi(ht-1+xt)+bi),然后生成加入状态的候选向量最后更新细胞状态其中,θi和bi是输入门结构的权重和偏移,θc和bc是tanh结构的权重和偏移;

17、第三个门结构设置为输出门,用于最终输出值ht=σ(θ0(ht-1+xt)+b0)tanh(ct)的输出,其中,θ0和b0是输出门结构的权重和偏移;

18、基于上述,所述神经网络预测模型中的推荐路径算法为:

19、第一步,选择起点服务器pi与终点服务器pi+1,刚开始i为1;

20、其中,i=1,2,…,nz;为预测出的所有占用的服务器;

21、第二步,将起点服务器pi加入已知集合,设置标志位为真,表示已确定该点到源点的最短路径,并将其他各服务器pm加入未知集合;

22、第三步,更新起点服务器pi与其他各服务器pm的耗费dis(pi,pm);

23、第四步,在未知集合中,选择dis(pi,pm)中值最小的服务器px,将服务器px加入已知集合;

24、第五步,剩余服务器中,计算dis(pi,pm)>dis(pi,px)+dis(px,pm);

25、如果这个不等式成立,则dis(pi,pm)=dis(pi,px)+dis(px,pm),此时pi与pm路径经过px;

26、循环直至pi+1点加入已知集合,取得的dis(pi,pi+1)即为最短距离;

27、第六步,取得两服务器间的最短距离后,令i=i+1,并回到第一步选择新的起点服务器和终点服务器,直到计算完所有服务器间的最短路径。

28、基于上述,设所有神经网络模型均基于目标函数f;

29、f=a×la+(1-a)×lo+pe;

30、其中,其中,la为提供服务的时延;lo为编排后的负载均衡评分;pe为sfc编排失败的惩罚,当sfc编排成功时为0,失败时为10;a的值域为[0,1],表示对时延和负载均衡的重视程度;当a为1时表示只关注时延不关注负载均衡,a为0时表示只关注负载均衡不关注时延;ns个所述神经网络模型中,相邻的两个神经网络模型之间的a值差值为1/ns;每个所述神经网络模型的目标函数是不同的;

31、在训练相邻的神经网络模型时,初始的神经网络模型的参数使用上一个训练好的神经网络模型的参数;

32、每个所述神经网络模型都采用策略梯度算法进行训练,过程如下:

33、第一步,收集运营商过往的业务数据,并根据这些真实数据模拟现实生活中底层网络资源和sfc请求情况;

34、第二步,设置所述神经网络模型的数量为ns,每个所述神经网络模型需要训练的轮数为batch,学习率lr=0.001,每处理m个sfc请求就更新神经网络参数;

35、第三步,初始化当前神经网络模型中的参数θk,y,如果不是第一个神经网络模型则使用上一个已经训练好的神经网络模型的参数;k=0,1,…,(ns-1);y=1,2,…,batch;

36、设置神经网络模型的目标函数f=a×la+(1-a)×lo+pe,如果是第一轮,a为1;

37、第四步,当有sfc请求时,循环进行此步操作:

38、将此时底层网络资源信息输入到所述神经网络预测模型,得到放置的位置和占用的链路;

39、对这个占用方案通过目标函数进行评估,得到此编排方案的时延la,服务器和链路的负载均衡评分lo,其中负载均衡的情况用各个服务器和链路占有资源比例的方差表示;

40、再判断是否编排成功,即底层网络中的计算资源和带宽资源能否满足sfc的需要;

41、将解码器预测输出的服务器概率prej和评估结果fj存入缓存,当处理sfc的请求等于m时,进入第五步;j=0,1,…,m。

42、第五步,更新当前训练的神经网络模型的参数θk,y;

43、

44、其中,lr为当前训练的神经网络模型的学习率;

45、第六步,清空缓存,返回第三步继续训练;

46、第七步,当训练轮数大于batch时,保存当前训练的神经网络模型;更改神经网络模型的目标函数f中的参数a=a-1/ns,再返回第三步训练,直到ns个神经网络模型均训练完成。

47、基于上述,编排sfc时,先进行底层网络资源收集,再通过收集的信息构建帕累托前沿面,最后进行贪婪选择。

48、基于上述,编排sfc的方法为:

49、第一步,当收到sfc请求后,收集当前时间片的底层网络资源信息,并将这些信息处理成方便所述神经网络预测模型计算的数据;

50、第二步,将收集到的底层网络资源数据输入到所述神经网络预测模型构建此问题的帕累托最优解集:

51、同时将底层网络资源数据输入到所述神经网络预测模型的ns个神经网络模型中,得出ns种编排方法,这ns种编排方法就是此问题的帕累托最优解集;

52、第三步,遍历所述帕累托最优解集中的每一种编排方案,找到符合la≤l下min(lo)的方案,其中l为用户的最大允许时延。

53、本发明第二方面提供一种基于深度强化学习的智能服务功能链部署系统,包括:

54、存储器;以及

55、耦接至所述存储器的处理器,所述处理器被配置为基于存储在所述存储器中的指令执行所述的基于深度强化学习的智能服务功能链部署方法。

56、本发明第三方面提供一种非瞬时性计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现所述的基于深度强化学习的智能服务功能链部署方法。

57、本发明相对现有技术具有突出的实质性特点和显著进步,具体的说:

58、与其他单一场景的方法不同,本专利可以在满足不同场景用户所需网络质量的同时,尽量使网络的负载均衡,提高了整体网络的稳定性,防止发生网络拥塞。

- 还没有人留言评论。精彩留言会获得点赞!