一种基于深度强化学习的无线网络分布式实时调度方法

本发明涉及信息技术,具体来说涉及信息技术中路由网络信息调度,更具体地说,涉及一种基于深度强化学习的无线网络分布式实时调度方法。

背景技术:

1、随着实时无线网络的日益普及,它们被应用于各种需要严格时延约束的应用中。这类应用包括例如网络物理系统(cps)和实时视频流传输的多媒体通信。这些系统需要确保数据包在实时无线网络中按照指定的截止时间送达,否则数据包会过期,会变为对系统没有价值而被丢弃。衡量这些系统的一个重要指标是及时吞吐量,即被目的节点成功接收的数据包数量与网络中产生的数据包数量的总和的比值。

2、在一个无线网络中,存在多个彼此通信的无线节点,这些无线节点之间收发数据时彼此可能产生干扰,从而对网络的即时吞吐量造成影响。

3、近年来,如何调度实时数据流从而更好地满足即时吞吐量要求受到了广泛的关注,然而这一领域的大多数研究集中在帧同步的流量模式上,假设所有流量在每个t个时隙(t为帧长度)的开始时同时到达,并且所有这些数据包在t个时隙的相同截止时间之后都会过期。这种假设无法准确地模拟移动多媒体视频会议等实际场景,该场景下时延通常要比帧生成周期短得多。在这种情况下,上面提到的调度方法难以满足此类实时数据流的截止时间要求。

4、对于通用流量模型的调度算法的研究,其往往因为计算复杂度过高或无法保证性能而在现实场景中无法取得很好的效果。

5、对于随机的调度策略,会忽视无线信道衰落的影响,并且默认链路传输是始终可靠的,并不符合现实中的场景。

6、此外,传统的调度方法(如贪心算法、动态规划)等无法自适应动态的网络环境。

7、因此,以上研究工作无法提供高效、稳定、自适应的实时无线网络调度策略。对此,发明人曾提出一种基于深度强化学习的实时分布式无线网络调度方法(参见申请公布号为cn114173418a的文献),该方法是基于集中式训练分布式执行的框架;首先,在同一个节点收集不同节点的数据训练出一个集中式模型(专家网络),该模型具有全网最优调度策略,然后在训练阶段,利用该节点的集中式模型输出的预测结果作为真值,通过监督学习机制去训练部署在各个节点的分布式模型。但是,该方法在训练期间分布式模型不可使用,且在真实环境中,想通过集中式节点收集全局数据较困难,因此很难去设置一个集中式节点。

技术实现思路

1、因此,本发明的目的在于克服上述现有技术的缺陷,提供一种无线网络中数据流的分布式调度方法。

2、本发明的目的是通过以下技术方案实现的:

3、根据本发明的第一方面,提供一种无线网络中数据流的分布式调度方法,所述无线网络包括预定范围内的多个节点,所述节点为接入点或者移动用户节点,所述方法包括:在每个节点中分别执行预设的分布式调度协议,基于所述协议为本节点的每条数据流建立一个调度组件以调度发送数据的数据流,其中,每个数据流的调度组件被配置为:为该数据流维护用于描述其流量特征的流量模型,并且在所述流量特征改变导致流量模型更新时,将最新的流量模型广播给所述无线网络中的各数据流的调度组件;监测每个时隙中该数据流对应的状态集合和历史观测信息,其中,该数据流对应的状态集合包括根据自身以及其他流量模型在本地分别确定的各数据流状态,所述历史观测信息是其他数据流在邻近的多个连续历史时隙的历史调度结果构成的向量;为该数据流部署专属的强化学习模型,其用于根据该数据流在当前时隙对应的状态集合和历史观测信息预测动作,所述动作指示当前时隙是否调度该数据流工作;和至少基于所述强化学习模型预测的动作确定当前时隙的实际动作,以及收集执行所述当前时隙的实际动作后的样本放入本地经验回放池,以优化强化学习模型。

4、可选的,所述本地经验回放池包括:调度智能体经验回放池,其用于存放当前的环境下收集的样本,并且在任意流量模型更新而导致环境改变时,即时清空调度智能体经验回放池并重新收集样本;探索智能体经验回放池,其用于存储历史的各环境的样本。

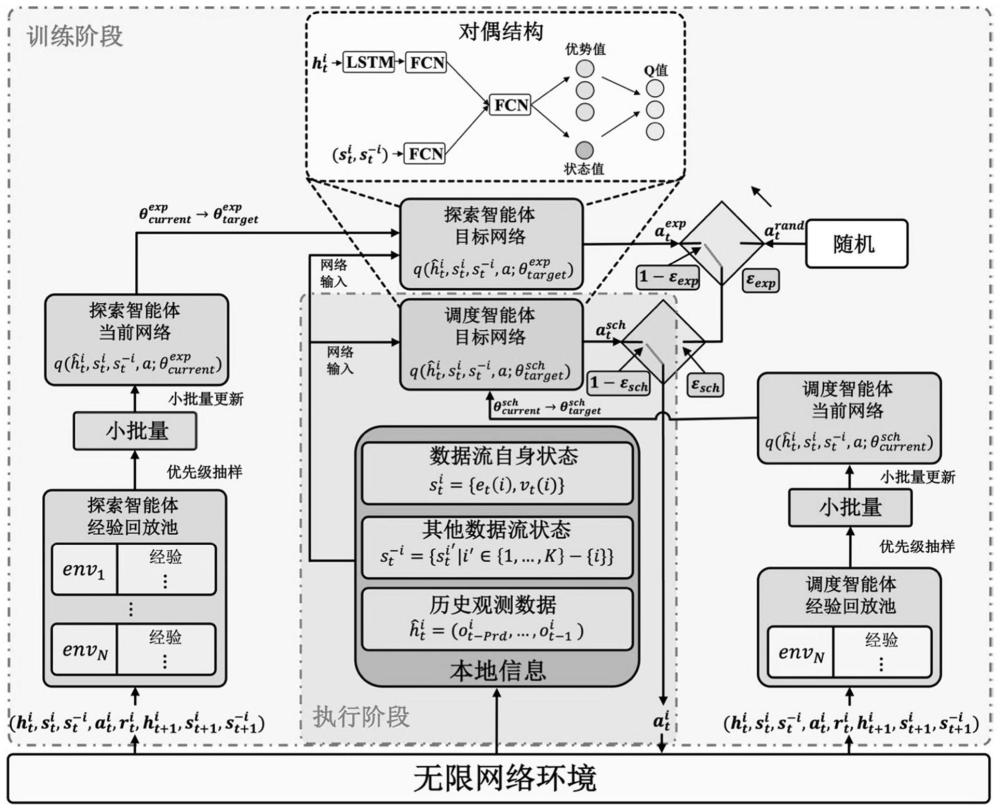

5、可选的,所述强化学习模型包括:基于所述调度智能体经验回放池,以强化学习方式更新的调度智能体当前网络和调度智能体目标网络;基于所述探索智能体经验回放池,以强化学习方式更新的探索智能体目标网络和探索智能体当前网络;每当环境改变后的前期,每次以预设方式分别从探索智能体目标网络预测的动作、调度智能体目标网络预测的动作和随机确定的动作中选择一个动作作为所述实际动作,以通过探索智能体目标网络和随机动作在前期指导调度智能体当前网络和调度智能体目标网络的参数进行优化。

6、可选的,所述调度组件还被配置为:当调度智能体目标网络被优化至收敛时,视为当前环境下的所述前期结束,进入当前环境下的后期;在当前环境下的后期,仅使用调度智能体目标网络预测的动作作为所述实际动作。

7、可选的,按照以下强化学习方式更新调度智能体当前网络和调度智能体目标网络:一次或者多次从同一个环境下采集的调度智能体经验回放池中抽取小批量样本,用于训练更新调度智能体当前网络的参数;每隔预设个数的时隙后,根据最新训练的调度智能体当前网络的参数更新当前的调度智能体目标网络的参数。

8、可选的,按照以下强化学习方式更新探索智能体目标网络和探索智能体当前网络:一次或者多次从历史的各环境下采集的探索智能体经验回放池中抽取小批量样本,用于训练更新探索智能体当前网络的参数;每隔预设个数的时隙后,根据最新训练的探索智能体当前网络的参数更新当前的探索智能体目标网络的参数。

9、可选的,在所述前期,所述预设方式包括:分别为三种方式确定动作设定被选中的概率,所述三种方式确定动作指所述探索智能体目标网络预测的动作、调度智能体目标网络预测的动作和随机确定的动作;根据所设定的被选中的概率,从探索智能体目标网络预测的动作、调度智能体目标网络预测的动作和随机确定的动作选择所述实际动作。

10、可选的,所述预设方法还包括:在所述前期,开始时为所述探索智能体目标网络预测的动作所设定的被选中的概率大于为所述调度智能体目标网络预测的动作所设定的被选中的概率;在所述前期,随着所述调度智能体目标网络不断优化,为所述调度智能体目标网络预测的动作所设定的被选中的概率逐渐增大,为所述探索智能体目标网络预测的动作所设定的被选中的概率逐渐减小。

11、可选的,每个所述样本包括以下构成元素:

12、

13、其中,表示t时隙当前数据流i对应的历史观测信息,表示t时隙数据流i对应的状态集合,表示t时隙数据流i采取的实际动作,表示t时隙数据流i采取动作后获得的奖励,表示采取动作后的t+1时隙数据流i对应的历史观测信息,表示采取动作后的t+1时隙数据流i对应的状态集合。

14、可选的,所述调度智能体当前网络、调度智能体目标网络、探索智能体目标网络和探索智能体当前网络均采用包括以下模块的对决网络:第一分支特征模块,其利用依次连接的lstm和第一全连接网络从输入的历史观测信息提取历史观测特征;第二分支特征模块,其利用第二全连接网络从输入的状态集合提取状态特征;特征融合模块,其获取所述历史观测特征和所述状态特征的拼接特征,并利用第三全连接网络从拼接特征中提取融合特征;优势头模块,其用于根据所述融合特征分别确定调度对应数据流工作的第一优势值和不调度对应数据流工作的第二优势值;状态价值头模块,其用于根据所述融合特征确定状态价值;动作价值模块,其用于根据所述第一优势值、所述第二优势值和所述状态价值分别确定调度和不调度对应数据流工作的动作价值,并选取其中价值最高的作为预测动作。

15、可选的,在强化学习时,所述调度智能体当前网络或者所述探索智能体当前网络中任意的一个当前网络按照以下方式更新参数:从当前网络对应的经验回放池按优先级抽样,抽取小批量样本;将小批量样本所含的每个样本中的t时隙数据流i对应的历史观测信息和t时隙数据流i对应的状态集合作为输入,训练当前网络根据输入的历史观测信息和状态集合确定调度和不调度对应数据流工作的动作价值;根据每个样本中历史观测信息状态集合和奖励确定t时隙的最优动作的目标价值;根据每个样本的动作价值与对应目标价值的偏差确定每个样本的子损失;根据所有样本的子损失确定损失,根据所述损失更新当前网络的参数。

16、根据本发明的第二方面,提供一种电子设备,包括存储器和处理器,在所述存储器上存储有能够在处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时以实现第一方面所述方法的步骤。

- 还没有人留言评论。精彩留言会获得点赞!