一种基于机器学习算法的阿尔茨海默病预测方法与流程

1.本发明涉及计算机技术领域,特别涉及一种基于机器学习算法的阿尔茨海默病预测方法。

背景技术:

2.阿尔茨海默病是发生于老年和老年前期、以进行性认知功能障碍和行为损害为特征的神经系统疾病,主要表现为记忆障碍、失语、失用、失认、视空间能力损害、抽象思维和计算能力损害、人格和行为改变等,可通过药物治疗改善,目前尚不能治愈。

3.随着人口老龄化程度越来越高,逐渐步入老龄化社会,阿尔茨海默病患者逐年增多。作为一种中枢神经系统变性病,它有着起病隐袭、病症进行缓慢等特点,严重威胁老年人身心健康。找出阿尔茨海默病的诱因,对于有效降低阿尔茨海默病的患病率,具有重要意义。

技术实现要素:

4.为解决上述问题,本发明提供了一种基于机器学习算法的阿尔茨海默病预测方法,该预测方法通过机器学习算法有助于找出阿尔茨海默病的诱因,对于有效降低阿尔茨海默病的患病率,具有重要意义。

5.本发明采用以下技术方案:

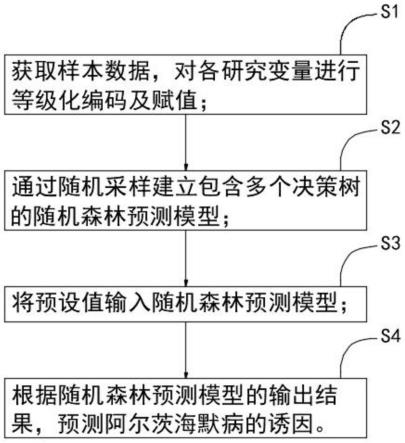

6.一种基于机器学习算法的阿尔茨海默病预测方法,具体包括如下步骤:

7.s1、获取样本数据,对各研究变量进行等级化编码及赋值;

8.s2、通过随机采样建立包含多个决策树的随机森林预测模型;

9.s3、将预设值输入随机森林预测模型;

10.s4、根据随机森林预测模型的输出结果,预测阿尔茨海默病的诱因。

11.优选地,步骤s1中所述研究变量包括烟龄、饮酒史、体育锻炼、蔬菜水果食用。

12.优选地,步骤s2的具体过程如下:

13.s21、对样本数据进行t次的随机采样,并依据分类树分类规则生成t个训练集,每个训练集包含m个训练集样本;

14.s22、在m个训练集样本中,对决策树训练样本基于抽样聚合方法进行采样,得到若干自主训练集,并依据自主训练集构建cart决策树作为弱分类器;

15.s23、随机选择决策树分类特征,生成足够数量的决策树弱分类器;

16.s24、确定决策树分类节点数量mtry和决策树数量ntree;

17.s25、运用已经构建完成的各决策树弱分类器对新的特征向量进行分类,并依据分类结果基于bagging算法合成强分类器,再基于强分类器的分类结果,完成对特征向量的预测与判别;

18.s26、基于随机森林分类中各特征属性的oob误差,对各特征属性对ad影响程度进行评估。

19.优选地,步骤s23的具体过程如下:

20.s231、在已选取的m个训练集样本中,选取样本的n个属性变量,作为决策树分类标准;

21.s232、判别n个属性特征各自的gini指数,再将gini指数最大的特征属性作为决策树的分类节点,并采取固定浅层模式避免剪枝过程,建立决策树弱分类器;

22.s233、重复步骤s231和s232,直至生成足够数量的决策树弱分类器。

23.优选地,步骤s232建立决策树弱分类器的具体过程为:样本中的每个属性都要遍历所有可能的分割方法,得到一个最小的ginsplit,该分割就作为此节点处的分裂标准,再按分割对应的属性值来进行分裂,并根据不同的属性值创建树枝;进一步向下划分,事先确定一个叶节点纯度阈值,大于或等于该阈值时则停止划分。

24.优选地,步骤s24的具体过程如下:控制ntree取值保持恒定,逐步对mtry进行调节,依此判定mtry的最佳值;控制各mtry保持恒定,逐步对ntree进行条件,当模型泛化误差较小且趋于稳定时则认为ntree为最佳。

25.优选地,步骤s24中决策树分类节点数量mtry为4,决策树数量ntree为80。

26.优选地,步骤s1中样本数据选自年龄在65岁及以上的老年人,性别不限。

27.采用上述技术方案后,本发明与背景技术相比,具有如下优点:

28.本发明的样本数据选自年龄在65岁及以上的老年人,对各研究变量进行等级化编码及赋值后,通过随机采样建立包含多个决策树的随机森林预测模型,再将预设值输入随机森林预测模型,可根据随机森林预测模型的输出结果,预测阿尔茨海默病的诱因,对于有效降低阿尔茨海默病的患病率,具有重要意义。

附图说明

29.图1为本发明的流程框图。

具体实施方式

30.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

31.实施例

32.如图1所示,一种基于机器学习算法的阿尔茨海默病预测方法,具体包括如下步骤:

33.s1、获取样本数据,样本数据选自年龄在65岁及以上的老年人,性别不限,抽取1038份样本数据,对各研究变量进行等级化编码及赋值;所述研究变量包括烟龄、饮酒史、体育锻炼、蔬菜水果食用;各研究变量的赋值情况如表1所示;

34.表1各研究变量的赋值情况

[0035][0036]

s2、通过随机采样建立包含多个决策树的随机森林预测模型;

[0037]

步骤s2的具体过程如下:

[0038]

s21、对样本数据进行t次的随机采样,并依据分类树分类规则生成t个训练集,每个训练集包含m个训练集样本;

[0039]

s22、在m个训练集样本中,对决策树训练样本基于抽样聚合方法进行采样,得到若干自主训练集,并依据自主训练集构建cart决策树作为弱分类器;

[0040]

对于一个样本随机选取,它在某一次含m个样本的训练集的随机采样中,每次被采集的概率是不被采集到的概率为如果m次采样都没有被采集中的概率是当

[0041][0042]

即在bagging的每轮随机采样中,训练集中大约有36.8%的数据没有被采样集采集中。对于这部分没有被采样到的数据,称之为袋外数据(out of bag,简称oob)。通过随机生成不同的训练集降低了分类器之间的相关性,提高了随机森林的泛化能力;

[0043]

s23、随机选择决策树分类特征,生成足够数量的决策树弱分类器;

[0044]

步骤s23的具体过程如下:

[0045]

s231、在已选取的m个训练集样本中,选取样本的n个属性变量,作为决策树分类标准;

[0046]

s232、判别n个属性特征各自的gini指数,再将gini指数最大的特征属性作为决策树的分类节点,并采取固定浅层模式避免剪枝过程,建立决策树弱分类器;

[0047]

建立决策树弱分类器的过程中,假设训练样本特征的个数为n,随机森林算法随机地去选择特征对分类树的内部节点进行属性分裂。分类树以基尼指数作为分类标准,该标准能够选出降低数据无序度的属性。每棵树都一直这样分裂下去,直到该节点的所有训练样例都属于同一类。在决策树的分裂过程中不需要剪枝,基尼指数为:

[0048][0049]

pi是样本属于i类的概率。gini指数越小表示集合中被选中的样本被分错的概率越小,也就是说集合的纯度越高。如果集合分为l个部分,则gini指数为

[0050][0051]

其中ni是子节点在i处的样本个数,n是在母节点处的样本个数,是决策树中子节点个数。样本中的每个属性都要遍历所有可能的分割方法,得到一个最小的ginsplit,该分割就作为此节点处的分裂标准,再按分割对应的属性值来进行分裂,并根据不同的属性值创建树枝;进一步向下划分,事先确定一个叶节点纯度阈值,大于或等于该阈值时则停止划分;

[0052]

s233、重复步骤s231和s232,直至生成足够数量的决策树弱分类器;

[0053]

s24、确定决策树分类节点数量mtry和决策树数量ntree;

[0054]

步骤s24的具体过程如下:控制ntree取值保持恒定,逐步对mtry进行调节,依此判定mtry的最佳值;控制各mtry保持恒定,逐步对ntree进行条件,当模型泛化误差较小且趋于稳定时则认为ntree为最佳;

[0055]

s25、运用已经构建完成的各决策树弱分类器对新的特征向量进行分类,并依据分类结果基于bagging算法合成强分类器,再基于强分类器的分类结果,完成对特征向量的预测与判别;

[0056]

s26、基于随机森林分类中各特征属性的oob误差,对各特征属性对ad影响程度进行评估;

[0057]

本实施例随机抽取65%的数据作为样本,即692个样本,ntree=80,mtry=4,基于此参数设置对测试集数据进行分类,得到分类正确率为99.3%。随机运行100次,误差集中在0.01附近小幅波动,平均误差为99.1%,结果证明随机森林具有较高的分类正确率及良好的稳定性。

[0058]

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应该以权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1