基于视、触觉融合的机器人精密装配控制方法及系统

1.本发明一般涉及基于机器人的装配控制方法及系统,尤其涉及基于视、触觉融合的机器人精密装配控制方法及系统。本发明属于机器人技术领域。

背景技术:

2.在消费电子产品的批量化生产线中,尽管大多数对精度要求不高的装配任务已经由工业机器人实现全自动化,但仍有很多精密装配和柔顺装配工作需要工人手动完成。因此,对于工业机器人实现高精度、高速度、高柔顺度、高成功率的装配任务的研究一直受到广泛关注且具有较大的技术挑战。

技术实现要素:

3.本发明提供基于机器人的装配控制方法及系统,旨在至少解决现有技术中存在的技术问题之一。

4.本发明的技术方案基于的机器人末端的夹持执行器上设有触觉传感器,并且所述夹持执行器的装配区域被视觉设备拍摄。

5.本发明的技术方案一方面涉及一种基于机器人的装配控制方法,包括以下步骤:

6.s10、提供多个神经网络模型,所述多个神经网络模型至少包括强化学习网络模型和张量融合网络模型,其中的训练数据包含来自所述视觉设备的视觉数据、来自所述触觉传感器的触觉数据、所述机器人的动作反馈数据和力矩反馈数据;

7.s20、通过机器人控制器带动所述夹持执行器从装配初始点开始装配动作,然后通过视觉设备和触觉传感器实时采集与所述装配区域对应的视觉数据及触觉数据,并且执行压缩和/或滤波处理,以转换成相应的视觉数据表征向量和触觉数据表征向量;

8.s30、将所述视觉数据表征向量和所述触觉数据表征向量拼接融合,并输入至所述强化学习网络模型,以输出所述机器人的预测的动作控制数据;

9.s40、将所述视觉数据表征向量和所述触觉数据表征向量输入至所述张量融合网络模型,并通过多层感知机组成的阻尼点预测器,判断所述夹持执行器是否运到装配阻尼节点;

10.s50、根据所述机器人的预测的动作控制数据以及所述夹持执行器是否运到装配阻尼节点的预测结果,通过机器人控制器实施位置控制和力控制,以计算下一个装配运动节点的位姿数据和调整所述夹持执行器的装配力度;

11.其中,所述视觉数据包括rgb图像数据和深度图像数据。

12.进一步,所述步骤s10包括,

13.s11、读取机器人末端的实时六维笛卡尔空间位姿,并输入强化学习网络模型对其进行训练,同时采集装配区域在每个装配动作步的rgb图片、深度图片和触觉数据;

14.s12、当夹持执行器与装配终点的距离越近时、或夹持执行器插入装配零件中的深度越深时,所述强化学习网络模型的奖励函数相应增加。

15.进一步,所述步骤s20包括:

16.s21、所述触觉数据通过卡尔曼滤波器进行滤波,并使用光流法得到机器人沿装配动作方向的触觉流数据。

17.进一步,所述步骤s20还包括:

18.s22、将采集的rgb图像数据转换成灰度图,然后对于所述夹持执行器每个装配动作步中最后一个路点,将所述rgb图像数据通过rgb图片编码器压缩输出rgb表征向量,然后所述rgb表征向量通过rgb图片解码器裁剪输出128像素

×

128像素已处理的灰度图;

19.s23、将采集的深度图像数据转换成灰度图,然后对于所述夹持执行器每个装配动作步中最后一个路点,将所述深度图像数据通过深度图片编码器压缩输出深度表征向量,然后所述深度表征向量通过深度图片解码器裁剪输出128像素

×

128像素已处理的深度图片。

20.进一步,所述步骤s20还包括:

21.s24、提供变分自编码器,分别多次输入已处理的灰度图、已处理的深度图片到所述变分自编码器进行训练,分别输出rgb表征向量的维度为16

×

1、输出深度表征向量的维度为16

×

1。

22.进一步,所述步骤s21还包括:所述触觉流数据通过高斯卷积降维的维度为9个触觉检测点

×

1个触觉检测点得到处理后的触觉数据。

23.进一步,所述机器人的活动关节的扭矩通过以下雅可比矩阵求解:

[0024][0025]

其中,k

p

,kv,k

fp

和k

fi

是控制参数,s为判别矩阵。

[0026]

进一步,所述机器人控制器通过比例微分控制算法实施位置控制;所述机器人控制器通过比例积分控制算法实施力控制。

[0027]

本发明的技术方案还涉及一种计算机可读存储介质,其上储存有程序指令,所述程序指令被处理器执行时实施上述的方法。

[0028]

本发明的技术方案还涉及一种基于机器人的装配控制系统,其包括:在机器人移动部分末端设置的夹持执行器,所述夹持执行器的夹持内侧从内到外依次设置触觉传感器及软胶垫;与机器人配套的视觉设备,所述视觉设备用于收集装配配件及其周边的视觉数据;计算机装置,所述计算机装置包括所述的计算机可读存储介质。

[0029]

本发明的有益效果如下。

[0030]

1、本发明利用触觉信号的变化来间接得到其他维度的外力信息,并将其与视觉信息相融合,得到多模态表征。这一表征向量能够用于生成合适的机器人动作指令,也用于预判装配件是否到达阻尼点,从而灵活调整插装力以完成装配。

[0031]

2、本发明使用多个神经网络模型,使装配作业的视觉数据及触觉数据具有强化学习的效果,显著提高小型部件的精密装配的成功率和准确度。

附图说明

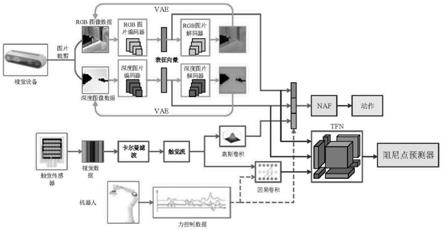

[0032]

图1是根据本发明方法的流程框架图。

[0033]

图2是根据本发明方法中的机器人运动控制部分的细节框图。

[0034]

图3是根据本发明实施例中的夹持执行器的布置示意图。

[0035]

图4是根据本发明实施例中的机器人和装配控制系统的硬件平台。

[0036]

图5及图6是根据本发明方法中的强化学习结果的曲线示意图。

具体实施方式

[0037]

以下将结合实施例和附图对本发明的构思、具体结构及产生的技术效果进行清楚、完整的描述,以充分地理解本发明的目的、方案和效果。

[0038]

需要说明的是,如无特殊说明,当某一特征被称为“固定”、“连接”在另一个特征,它可以直接固定、连接在另一个特征上,也可以间接地固定、连接在另一个特征上。此外,除非另有定义,本文所使用的所有的技术和科学术语与本技术领域的技术人员通常理解的含义相同。本文说明书中所使用的术语只是为了描述具体的实施例,而不是为了限制本发明。本文所使用的术语“和/或”包括一个或多个相关的所列项目的任意的组合。

[0039]

本发明的技术方案是基于机器人的基础硬件来实施,例如在现有的机器人上附加配置硬件和软件来实施。参照图3和图4,在一些实施例中,根据本发明的装配系统包括:在机器人移动部分末端设置的夹持执行器1;设置在所述夹持执行器1的夹爪内侧的触觉传感器2;布置成拍摄所述夹持执行器的装配区域的视觉设备;以及与机器人运动控制器、夹持执行器1、触觉传感器2和视觉设备通信连接的计算机装置(附图未视出)。

[0040]

参照图3所示,在本发明的典型装配应用实例中,根据本发明的装配系统能够满足卡扣形式的插孔装配。在优选的实施例中,触觉传感器2可以选用5

×

5的点阵式压感触觉传感器。为了更好的测量被夹持零部件4在外力作用下的“预滑移”,可以在夹持执行器1的指尖和触觉传感器2之间间隔了一个由软胶制成的软胶垫3(约5mm厚),并在触觉传感器的另一侧(即与被夹持零部件4接触一侧)贴敷了一层橡皮膜。参照图4,视觉设备可以采用rgb-d相机,能同时输出rgb图片和深度图片数据。机器人采用串联式多关节机器人,其在末端安装所述夹持执行器1。计算机装置可以独立于机器人控制器,也可以整合到机器人控制器,以执行根据本发明的方法。

[0041]

参照图1及图2,在一些实施例中,根据本发明的方法包括以下步骤:

[0042]

s10、提供多个神经网络模型,所述多个神经网络模型至少包括强化学习网络模型和张量融合网络模型,其中的训练数据包含来自所述视觉设备的视觉数据、来自所述触觉传感器的触觉数据、所述机器人的动作反馈数据和力矩反馈数据;

[0043]

s20、通过机器人控制器带动所述夹持执行器从装配初始点开始装配动作,然后通过视觉设备和触觉传感器实时采集与所述装配区域对应的视觉数据及触觉数据,并且执行压缩和/或滤波处理,以转换成相应的视觉数据表征向量和触觉数据表征向量;

[0044]

s30、将所述视觉数据表征向量和所述触觉数据表征向量拼接融合,并输入至所述强化学习网络模型,以输出所述机器人的预测的动作控制数据;

[0045]

s40、将所述视觉数据表征向量和所述触觉数据表征向量输入至所述张量融合网络模型,并通过多层感知机组成的阻尼点预测器,判断所述夹持执行器是否运到装配阻尼节点;

[0046]

s50、根据所述机器人的预测的动作控制数据以及所述夹持执行器是否运到装配

阻尼节点的预测结果,通过机器人控制器实施位置控制和力控制,以计算下一个装配运动节点的位姿数据和调整所述夹持执行器的装配力度;

[0047]

其中,所述视觉数据包括rgb图像数据和深度图像数据。

[0048]

下面,通过具体的3c部件的装配实例来描述上述步骤的具体实施例。在这些实例中,将usb-c充电线插头插装在插口的装配过程:夹持执行器2夹持usb-c充电线插头,usb-c插口被固定,触觉传感器收集夹持执行器2夹持usb-c充电线插头的压力触觉数据,视觉设备收集usb-c充电线插头(下称插头)及usb-c插口(下称插口)的视觉数据。

[0049]

对于步骤s10的具体实施方式

[0050]

训练数据包含来自视觉设备的视觉数据,该实施例的视觉设备为相机,该相机获取插头及插口的视觉数据图片,即是插头与插口的共在的rgb图像数据及深度图像数据。结合图1结合图3所示,来自所述触觉传感器的触觉数据,该实施例为5

×

5的点阵式压感触觉传感器,收集夹持执行器夹持插头的压力触觉数据。

[0051]

步骤s10还具体包括以下步骤:

[0052]

s11、读取机器人末端的实时六维笛卡尔空间位姿,并输入强化学习网络模型对其进行训练,同时采集装配区域在每个装配动作步的rgb图片、深度图片和触觉数据。实施例的机器人末端的夹持执行器的实时笛卡尔空间位姿作为状态输入,插头及插口的共在的rgb图像数据、深度图像数据及夹持插头的压力触觉数据在多个动作位置被收集后,输入强化学习网络模型对其进行训练。

[0053]

s12、当夹持执行器与装配终点的距离越近时、或夹持执行器插入装配零件中的深度越深时,所述强化学习网络模型的奖励函数相应增加。实施例中强化学习网络模型的奖励函数根据插头与插口的接近程度、插头插入插口的深度的增加而相应增加。

[0054]

步骤s10中,结合机器人平台的强化学习网络模型训练过程还包括以下步骤:

[0055]

s11’、当所述夹持执行器运到装配阻尼节点前,通过机器人控制器实施位置控制和力控制,所述夹持执行器沿装配阻尼节点方向的装配力度为m牛;当所述夹持执行器运到装配阻尼节点后,通过机器人控制器实施位置控制和力控制,所述夹持执行器沿装配阻尼节点方向的装配力度为n牛,其中,n>m。

[0056]

s12’、将所述动作反馈数据和力矩反馈数据向机器人控制器输入,机器人控制器输出的动作反馈增益及力矩反馈增益,计算出机器人下一个装配运动节点的装配力度。

[0057]

如图2,结合上述实施例,采用力/位混合控制方法来控制机器人的运动,即把沿插头与插口装配的方向(即图3和图4中的竖直方向或z轴方向)的运动解耦并采用力控制,机器人的五个自由度(x,y,r,p,y)的运动采用位置控制。在插头到达卡扣阻尼点之前,机器人带动夹持执行器沿z轴装配力度为m=2牛;在插头到达阻尼点之后,机器人带动夹持执行器沿z轴装配力度为增大至n=12牛。对于位置控制的5个维度,该系统的反馈增益较大来保证精度;而对于力控制的1个维度,该系统的反馈增益较小,从而保证部件装配的柔顺性。

[0058]

s13’、当所述夹持执行器运到装配阻尼节点前至装配阻尼节点之间的路径分为50个动作步,每个动作步设置多个数据采集点,每个所述数据采集点采集一次视觉数据及触觉数据。

[0059]

s14’、当所述夹持执行器移动50个动作步未到装配阻尼节点时,所述机器人控制器带动所述夹持执行器到装配初始点复位,重新开始装配动作。

[0060]

s15’、所述动作步分成10段,共计设置11个数据采集点。

[0061]

结合上述实施例,针对步骤s13’至s15’,机器人的一次完整的插口试验称为一个“回合”,每个回合由不超过50个“动作步”组成。如果机器人走满50个动作步依然没有完成插孔任务,即判定失败并复位至初始点。每个动作步又分成10段,共计11个“路点”。机器人带动夹持执行器将依次走过这些路点以完成一个动作步。对于插头及插口的rgb图像和深度图像,每个动作步采集一次数据;对于触觉数据,每个路点采集一次数据。

[0062]

对于步骤s20的具体实施方式

[0063]

在一个实施例中,夹持执行器携带插头位于插口正上方约1mm处,取该点为装配初始点,机器人通过本身的系统(比如ros系统)读取夹持执行器在这一初始点的笛卡尔空间六维位姿向量。

[0064]

步骤s20还具体包括以下步骤:

[0065]

s21、所述触觉数据通过卡尔曼滤波器进行滤波,并使用光流法(farneback方法)得到机器人沿装配动作方向的触觉流数据。如图1,结合上述实施例,利用卡尔曼滤波器将收集到的触觉信息滤波,并类比光流法,使用farneback方法计算每个动作步中夹持执行器x、y方向上的触觉流(维度为25(5

×

5个检测点)

×

2(x、y轴两个方向)

×

10(每两个连续路点的触觉信息计算出一个触觉流信息)。

[0066]

s22、将采集的rgb图像数据转换成灰度图,然后对于所述夹持执行器每个装配动作步中最后一个路点,将所述rgb图像数据通过rgb图片编码器压缩输出rgb表征向量,然后所述rgb表征向量通过rgb图片解码器裁剪输出128像素

×

128像素已处理的灰度图。

[0067]

s23、将采集的深度图像数据转换成灰度图,然后对于所述夹持执行器每个装配动作步中最后一个路点,将所述深度图像数据通过深度图片编码器压缩输出深度表征向量,然后所述深度表征向量通过深度图片解码器裁剪输出128像素

×

128像素已处理的深度图片。

[0068]

如图1,步骤s22及s23中,结合上述实施例,插头及插口通过相机输出的rgb图片和深度图片围绕装配区域裁剪成128

×

128的尺寸,并将rgb图像转换成灰度图,以减少数据量和处理时间。

[0069]

s24、提供变分自编码器,分别多次输入已处理的灰度图、已处理的深度图片到所述变分自编码器进行训练,分别输出rgb表征向量的维度为16

×

1、输出深度表征向量的维度为16

×

1。结合上述实施例,插头及插口装配的灰度图及深度图,采用变分自编码器(vae)训练这两种图片,从而将图片编码压缩成16

×

1的“表征向量”,并保证其中涵盖了原始图像的绝大部分信息。

[0070]

对于步骤s30和s40的具体实施方式

[0071]

将所述触觉数据表征向量和所述机器人的装配力度数据通过因果卷积降维后,然后输入至所述张量融合网络模型,并通过多层感知机组成的阻尼点预测器,判断所述夹持执行器是否运到装配阻尼节点。

[0072]

更加具体地,对于每个动作步,通过因果卷积网络将触觉流降维至(即维度25

×

2)的尺寸,再与步骤s20中两种图像的表征向量(即两个16

×

1的向量)通过张量融合网络模型(tfn)融合(即对每个模态向量的末端添加元素“1”后进行克罗内克积,所得到的结果将同时包含这三种模态的单一信息和任意组合信息),再将所得到的三维张量展平并输入由多

层感知机组成的阻尼点预测器中,用于预测插头是否到达插口中的卡扣阻尼点。

[0073]

结合上述实施例,插头及出口提取出每个动作步中最后一个路点的5动作检测点

×

5动作检测点的触觉数据,将其利用高斯卷积降维(即维度为9

×

1),与两种图像的表征向量直接拼接融合(即维度为16+16+9),将得到的表征向量(即维度为41

×

1)重新输入到强化学习网络,并生成夹持执行器的动作值(五个动作方向x,y,r,p,y)。

[0074]

对于步骤s50的具体实施方式

[0075]

在一些实施例中,如图4所示的机器人的6个活动关节的扭矩通过以下雅可比矩阵求解:

[0076][0077]

其中,k

p

,kv,k

fp

和k

fi

分别是比例微分(pd)和比例积分(pi)的控制参数,s为判别矩阵s=diags=diag(1,1,0,1,1,1),即位控维度对应的值为1,力控维度对应的值为0。

[0078]

所述机器人控制器通过pd控制算法实施位置控制;所述机器人控制器通过pi控制算法实施力控制。

[0079]

参照图5和图6所示的据本发明方法中的强化学习结果的曲线示意图,采用融合了rgb图像数据+深度图像数据+f/t力传感器数据+机器人力矩反馈数据所训练的网络模型,随着所测试的回合(episode)数更多的时候,能获得的报酬(reward)更多(即是成功完成预期装配效果的次数更多),并且装配操作的动作步(step)较少。即是说,融合视、触觉和强化学习网络模型所实现的装配方法,能达到更优的机器人精密装配效果。

[0080]

最终结果显示,依靠视觉和触觉融合的机器人usb-c插接成功率最高达到了99%,证明了根据本发明的装配方法的有效性。

[0081]

应当认识到,本发明实施例中的方法步骤可以由计算机硬件、硬件和软件的组合、或者通过存储在非暂时性计算机可读存储器中的计算机指令来实现或实施。所述方法可以使用标准编程技术。每个程序可以以高级过程或面向对象的编程语言来实现以与计算机系统通信。然而,若需要,该程序可以以汇编或机器语言实现。在任何情况下,该语言可以是编译或解释的语言。此外,为此目的该程序能够在编程的专用集成电路上运行。

[0082]

此外,可按任何合适的顺序来执行本文描述的过程的操作,除非本文另外指示或以其他方式明显地与上下文矛盾。本文描述的过程(或变型和/或其组合)可在配置有可执行指令的一个或多个计算机系统的控制下执行,并且可作为共同地在一个或多个处理器上执行的代码(例如,可执行指令、一个或多个计算机程序或一个或多个应用)、由硬件或其组合来实现。所述计算机程序包括可由一个或多个处理器执行的多个指令。

[0083]

进一步,所述方法可以在可操作地连接至合适的任何类型的计算平台中实现,包括但不限于个人电脑、迷你计算机、主框架、工作站、网络或分布式计算环境、单独的或集成的计算机平台、或者与带电粒子工具或其它成像装置通信等等。本发明的各方面可以以存储在非暂时性存储介质或设备上的机器可读代码来实现,无论是可移动的还是集成至计算平台,如硬盘、光学读取和/或写入存储介质、ram、rom等,使得其可由可编程计算机读取,当存储介质或设备由计算机读取时可用于配置和操作计算机以执行在此所描述的过程。此外,机器可读代码,或其部分可以通过有线或无线网络传输。当此类媒体包括结合微处理器

或其他数据处理器实现上文所述步骤的指令或程序时,本文所述的发明包括这些和其他不同类型的非暂时性计算机可读存储介质。当根据本发明所述的方法和技术编程时,本发明还可以包括计算机本身。

[0084]

计算机程序能够应用于输入数据以执行本文所述的功能,从而转换输入数据以生成存储至非易失性存储器的输出数据。输出信息还可以应用于一个或多个输出设备如显示器。在本发明优选的实施例中,转换的数据表示物理和有形的对象,包括显示器上产生的物理和有形对象的特定视觉描绘。

[0085]

以上所述,只是本发明的较佳实施例而已,本发明并不局限于上述实施方式,只要其以相同的手段达到本发明的技术效果,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明保护的范围之内。在本发明的保护范围内其技术方案和/或实施方式可以有各种不同的修改和变化。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1