模型训练方法和装置、策略优化方法、设备及介质

1.本发明涉及模型训练的技术领域,尤其是涉及一种模型训练方法和装置、策略优化方法、设备及介质。

背景技术:

2.机械臂是一种强非线性系统,其动力学模型往往具有非线性、耦合度高等特点,因此建立一个精确度高的机械臂动力学模型非常困难,而且机械臂系统的非线性特征导致了策略学习的子过程计算量大,学习机理表征不足,因此如何构建有效表征机械臂动力学特征的模型是目前亟待解决的问题。

技术实现要素:

3.本发明旨在至少解决现有技术中存在的技术问题之一。为此,本发明提出一种模型训练方法,能够使得目标机械臂模型构建简易,提高机械臂的强化学习的效率。

4.本发明还提出一种策略优化方法。

5.本发明还提出一种模型训练装置。

6.本发明还提出一种电子设备。

7.本发明还提出一种计算机可读存储介质。

8.第一方面,本发明的一个实施例提供了一种模型训练方法,所述方法包括:

9.获取机械臂的训练数据集合;其中,所述训练数据集合包括:电压训练数据、位姿训练数据、训练策略,所述电压训练数据作为强化学习的环境,所述训练策略作为强化学习的动作;

10.根据预设的动力学分析算法对所述训练数据集合进行模型构建,得到原始机械臂模型;

11.将所述原始机械臂模型输入预设的神经网络模型进行线性变换处理,得到初始机械臂模型;

12.根据预设的奖励函数对所述初始机械臂模型进行更新处理,得到目标机械臂模型。

13.本发明实施例的基于强化学习的模型训练方法至少具有如下有益效果:通过获取电压训练数据、位姿训练数据和训练策略构建训练数据集合,然后根据预设的动力学分析算法对训练数据集合进行模型构建以得到原始机械臂模型,然后再根据预设的神经网络模型对原始机械臂模型转换为线性的初始机械臂模型,最后根据预设的奖励函数对初始机械臂模型进行更新参考轨迹和策略以得到目标机械臂模型,因此使得目标机械臂模型构建简易,提高机械臂的强化学习的效率。

14.根据本发明的另一些实施例的基于强化学习的模型训练方法,所述动力学分析算法为koopman算法,所述根据预设的动力学分析算法对所述训练数据集合进行模型构建,得到原始机械臂模型,包括:

15.根据所述koopman算法对所述电压训练数据、所述位姿训练数据和所述训练策略进行模型构建,得到所述原始机械臂模型;其中,所述原始机械臂模型具体如下:

16.z

k+1

=azk+buk17.zk=ψ(xk)

[0018][0019]

式中,为电压训练数据,zk=ψ(xk)表示升维函数,uk表示训练策略,为位姿训练数据。

[0020]

根据本发明的另一些实施例的基于强化学习的模型训练方法,所述神经网络模型包括:编码器、解码器;

[0021]

所述将所述原始机械臂模型输入预设的神经网络模型进行线性变换处理,得到初始机械臂模型,包括:

[0022]

通过所述编码器根据所述奖励函数对所述原始机械臂模型进行编码处理,得到解码数据;

[0023]

通过所述解码器根据所述解码数据进行模型重构处理,得到所述初始机械臂模型;其中,所述初始机械臂模型为线性模型。

[0024]

根据本发明的另一些实施例的基于强化学习的模型训练方法,所述编码器包括:第一全连接层、第一激活层、第二全连接层、第二激活层、第三全连接层和第三激活层;所述解码器包括:第四全连接层、第四激活层、第五全连接层、第五激活层、第六激活层和第六全连接层,所述第一激活层、所述第二激活层、所述第五激活层和所述第六激活层为prelu层,所述第三激活层和所述第四激活层为tanh层。

[0025]

第二方面,本发明的一个实施例提供了基于强化学习的策略优化方法,所述方法包括:

[0026]

获取电压预测数据,并将所述电压预测数据输入至所述目标机械臂模型,得到初始控制策略;其中,所述目标机械臂模型如第一方面所述的训练方法训练得到;

[0027]

根据预设优化算法对所述初始控制策略进行优化处理,得到目标控制策略。

[0028]

本发明实施例的基于强化学习的策略优化方法至少具有如下有益效果:通过目标机械臂模型得到初始控制策略,由于目标机械臂模型由上述训练得到,所以所得到的初始控制策略能够控制机械臂准确抓取目标位置的物品,但是为了进一步提高机械臂抓取的优化,根据优化算法对初始控制策略进行优化得到目标控制策略,既能够保证机械臂抓取又能够简化策略。

[0029]

根据本发明的另一些实施例的基于强化学习的策略优化方法,所述目标机械臂模型包括:目标强化模型和目标动力学模型;所述获取电压预测数据,并将所述电压预测数据输入至所述目标机械臂模型,得到初始控制策略,包括:

[0030]

获取电压预测数据,并将所述电压预测数据输入所述目标强化模型,得到预测位姿数据;

[0031]

将所述预测位姿数据输入至所述目标动力学模型,得到目标控制策略。

[0032]

根据本发明的另一些实施例的基于强化学习的策略优化方法,所述预设优化算法包括:预设代价算法和递归微分算法;所述根据预设优化算法对所述初始控制策略进行优

化处理,得到目标控制策略,包括:

[0033]

根据所述预设代价算法对所述初始控制策略进行构建,得到代价方程;

[0034]

根据所述递归微分算法对所述代价方程进行求解处理,得到所述目标控制策略。

[0035]

第三方面,本发明的一个实施例提供了基于强化学习的模型训练装置,所述装置包括:

[0036]

获取模块,用于获取机械臂的训练数据集合;其中,所述训练数据集合包括:电压训练数据、位姿训练数据、训练策略,所述电压训练数据作为强化学习的环境,所述训练策略作为强化学习的动作;

[0037]

构建模块,用于根据预设的动力学分析算法对所述训练数据集合进行模型构建,得到原始机械臂模型;

[0038]

变换模块,用于将所述原始机械臂模型输入预设的神经网络模型进行线性变换处理,得到初始机械臂模型;

[0039]

调整模块,用于根据预设的奖励函数对所述初始机械臂模型进行更新处理,得到目标机械臂模型。

[0040]

本发明实施例的基于强化学习的模型训练装置至少具有如下有益效果:通过获取电压训练数据、位姿训练数据和训练策略构建训练数据集合,然后根据预设的动力学分析算法对训练数据集合进行模型构建以得到原始机械臂模型,再根据预设的神经网络模型对原始机械臂模型转换为线性的初始机械臂模型,最后根据预设的奖励函数对初始机械臂模型进行更新参考轨迹和策略以得到目标机械臂模型,因此使得目标机械臂模型构建简易,提高机械臂的强化学习的效率。

[0041]

第四方面,本发明的一个实施例提供了电子设备,包括:

[0042]

至少一个处理器,以及,

[0043]

与所述至少一个处理器通信连接的存储器;其中,

[0044]

所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行如第一方面所述的模型训练方法,或如第二方面所述的策略优化方法。

[0045]

第五方面,本发明的一个实施例提供了计算机可读存储介质,所述计算机可读存储介质存储有计算机可执行指令,所述计算机可执行指令用于使计算机执行如第一方面所述的模型训练方法,或如第二方面所述的策略优化方法。

[0046]

本技术的其它特征和优点将在随后的说明书中阐述,并且,部分地从说明书中变得显而易见,或者通过实施本技术而了解。本技术的目的和其他优点可通过在说明书以及附图中所特别指出的结构来实现和获得。

附图说明

[0047]

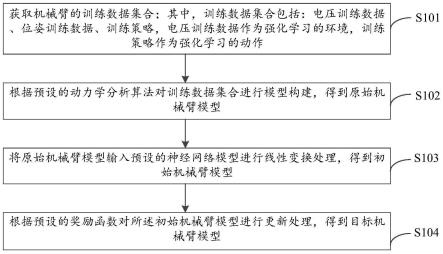

图1是本发明实施例中模型训练方法的一具体实施例流程示意图;

[0048]

图2是图1中步骤s102的一具体实施例流程示意图;

[0049]

图3是图1中步骤s103的一具体实施例流程示意图;

[0050]

图4是本发明实施例中模型训练方法中编码器和解码器的一具体实施例结构示意图;

[0051]

图5是本发明实施例中策略优化方法的一具体实施例流程示意图;

[0052]

图6是图5中步骤s501的一具体实施例流程示意图;

[0053]

图7是图5中步骤s502的一具体实施例流程示意图;

[0054]

图8是本发明实施例中模型训练装置的一具体实施例模块框图;

[0055]

图9是本发明实施例中电子设备的一具体实施例模块框图。

具体实施方式

[0056]

为了使本技术的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本技术进行进一步详细说明。应当理解,此处所描述的具体实施例仅用以解释本技术,并不用于限定本技术。

[0057]

需要说明的是,虽然在装置示意图中进行了功能模块划分,在流程图中示出了逻辑顺序,但是在某些情况下,可以以不同于装置中的模块划分,或流程图中的顺序执行所示出或描述的步骤。说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。

[0058]

除非另有定义,本文所使用的所有的技术和科学术语与属于本技术的技术领域的技术人员通常理解的含义相同。本文中所使用的术语只是为了描述本技术实施例的目的,不是旨在限制本技术。

[0059]

首先,对本技术中涉及的若干名词进行解析:

[0060]

人工智能(artificial intelligence,ai):是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学;人工智能是计算机科学的一个分支,人工智能企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,该领域的研究包括机器人、语言识别、图像识别、自然语言处理和专家系统等。人工智能可以对人的意识、思维的信息过程的模拟。人工智能还是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。

[0061]

koopman算法:koopman算法的基本思想是将非线性系统升维到一个线性维度空间下,并且这个线性空间在理论上来讲是无限维的。这样就能够得到原动力系统非线性特性的同时保证系统不会丢失任何信息,利用这个理论可以对非线性动力系统进行全局线性化,且只需要利用系统的实验或仿真数据而不用对系统进行数学建模。这种做法是把原非线性系统升维到一个线性的无穷维空间下,即用无穷的维度来换取线性特性,但是由于无穷维koopman算法的复杂性,使其在实践应用中十分困难。

[0062]

encoder网络:input data通过一个encoder神经网络得到一个维度的较低的向量,称这个向量为code,encoder网络的作用是用来发现给定数据的压缩表示。

[0063]

decoder网络:code经过一个decoder神经网络后输出一个output data,decoder网络使原始输入的尽可能地相同的重建的表示。

[0064]

线性二次型调节器(lqr,linear quadratic regulator):lqr可得到状态线性反馈的最优控制规律,易于构成闭环最优控制。lqr最优控制利用廉价成本可以使原系统达到较好的性能指标(事实也可以对不稳定的系统进行整定),而且方法简单便于实现,同时利用matlab强大的功能体系容易对系统实现仿真。

[0065]

机械臂系统的非线性特性导致了其策略学习的子过程计算量大,学习机理表征不足,非线性凸优化问题难以解决,限制了机械臂强化学习任务在实际场景下的应用。由于机械臂强化学习存在一定局限性,绝大部分的研究工作需要精确的动力学模型,非线性系统的策略学习子过程计算量庞大,调参工作繁重,对于策略学习在内在机理缺乏可解释性,且目前大多数算法对于系统本身的数据得不到充分利用,往往难以获取最优策略。

[0066]

基于此,本技术通过预设的动力学分析算法对训练数据集合进行模型构建得到原始机械臂模型,再根据神经网络模型对原始机械臂模型进行线性变换得到初始机械臂模型,根据预设奖励函数的交互对初始机械臂模型进行更新以得到目标机械臂模型,使得机械臂的强化学习计算简易,提高机械臂强化学习的效率,且根据目标机械臂模型可以得到最优策略,使得最优策略计算简易。

[0067]

本技术实施例提供的模型训练方法和装置、策略优化方法、设备及介质,具体通过如下实施例进行说明,首先描述本技术实施例中的模型训练方法。

[0068]

本技术实施例可以基于人工智能技术对相关的数据进行获取和处理。其中,人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。

[0069]

人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术主要包括计算机视觉技术、机器人技术、生物识别技术、语音处理技术、自然语言处理技术以及机器学习/深度学习等几大方向。

[0070]

本技术实施例提供的策略优化方法,涉及人工智能技术领域。本技术实施例提供的策略优化方法可应用于终端中,也可应用于服务器端中,还可以是运行于终端或服务器端中的软件。在一些实施例中,终端可以是智能手机、平板电脑、笔记本电脑、台式计算机等;服务器端可以配置成独立的物理服务器,也可以配置成多个物理服务器构成的服务器集群或者分布式系统,还可以配置成提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、cdn以及大数据和人工智能平台等基础云计算服务的云服务器;软件可以是实现策略优化方法的应用等,但并不局限于以上形式。

[0071]

本技术可用于众多通用或专用的计算机系统环境或配置中。例如:个人计算机、服务器计算机、手持设备或便携式设备、平板型设备、多处理器系统、基于微处理器的系统、置顶盒、可编程的消费电子设备、网络pc、小型计算机、大型计算机、包括以上任何系统或设备的分布式计算环境等等。本技术可以在由计算机执行的计算机可执行指令的一般上下文中描述,例如程序模块。一般地,程序模块包括执行特定任务或实现特定抽象数据类型的例程、程序、对象、组件、数据结构等等。也可以在分布式计算环境中实践本技术,在这些分布式计算环境中,由通过通信网络而被连接的远程处理设备来执行任务。在分布式计算环境中,程序模块可以位于包括存储设备在内的本地和远程计算机存储介质中。

[0072]

图1是本技术实施例提供的基于强化学习的模型训练方法的一个可选的流程图,图1中的方法可以包括但不限于包括步骤s101至步骤s104。

[0073]

步骤s101,获取机械臂的训练数据集合;其中,训练数据集合包括:电压训练数据、位姿训练数据、训练策略,电压训练数据作为强化学习的环境,训练策略作为强化学习的动

作;

[0074]

步骤s102,根据预设的动力学分析算法对训练数据集合进行模型构建,得到原始机械臂模型;

[0075]

步骤s103,将原始机械臂模型输入预设的神经网络模型进行线性变换处理,得到初始机械臂模型;

[0076]

步骤s104,根据预设的奖励函数对所述初始机械臂模型进行更新处理,得到目标机械臂模型。

[0077]

本技术实施例所示意的步骤s101至步骤s104,通过获取电压训练数据、位姿训练数据和训练策略构建训练数据集合,然后根据预设的动力学分析算法对训练数据集合进行模型构建以得到原始机械臂模型,然后再根据预设的神经网络模型对原始机械臂模型进行线性比变换得到初始机械臂模型,并通过预设的奖励函数交互以更新初始机械臂模型以得到目标机械臂模型,使得目标机械臂模型构建简易且更加准确,提高机械臂的强化学习的效率。

[0078]

在一些实施例的步骤s101中,通过对机械臂的输入输出数据进行采集,以对输入的电压数据采集以得到电压训练数据,再对输出的位姿数据采集以得到位姿训练数据,同时采集机械臂的控制策略以得到训练策略。其中,位姿数据通过深度摄像头等传感器捕抓机械臂的动力学特征以得到位姿数据。然后将电压训练数据作为强化学习的环境,训练策略作为强化学习的动作,并根据训练策略知晓位姿参考数据,以根据位姿参数数据和位姿训练数据确定奖励函数,以根据奖励函数作为强化学习的评价。

[0079]

需要说明的是,在采集数据时,根据机械臂数据的特点,选择符合机械臂数据特点的电压训练数据、位姿训练数据和训练策略。

[0080]

在一些实施例的步骤s102中,通过预设的动力学分析算法根据训练数据集合进行模型构建以得到原始机械臂模型。例如,若位姿训练数据为y,电压训练数据为x,训练策略为u,基于x,y,u训练数据集合进行动力学分析以建立原始机械臂模型。其中,原始机械臂模型通过电压训练数据后能获得当前位置和下个时刻的位姿训练数据。

[0081]

在一些实施例的步骤s103中,由于原始机械臂模型为非线性模型,因此通过预设的神经网络模型将原始机械臂模型进行线性变换,以得到线性模型的初始机械臂模型,以便于后续根据预设的奖励函数对初始机械臂模型进行强化学习和策略学习的更新与优化。

[0082]

在一些实施例的步骤s104中,预设的奖励函数作为强化学习的评价,则根据预设的奖励函数对初始机械臂模型进行更新,以通过将训练策略中的当前策略输入初始机械臂模型得到动作和环境的交互,并根据动作和环境的交互确定对应的奖励函数,以根据奖励函数不断更新初始机械臂模型,以获取训练集合中奖励函数最低的初始机械臂模型作为目标机械臂模型,以更新初始机械臂模型,实现机械臂模型的强化学习和优化。因此,目标机械臂模型的构建简易且更加准确,使得机械臂强化学习的效率提高。其中,目标机械臂模型为机械臂观测和动作的高维线性动力学方程。

[0083]

请参照图2,在一些实施例中,动力学分析算法为koopman算法,步骤s102可以包括但不限于包括步骤s201。

[0084]

步骤s201,根据koopman算法对电压训练数据、位姿训练数据和训练策略进行模型构建,得到原始机械臂模型;其中,原始机械臂模型具体如公式(1)所示:

[0085][0086]

式中,为电压训练数据,zk=ψ(xk)表示升维函数,uk表示训练策略,为位姿训练数据。

[0087]

需要说明的是,通过koopman算法对采集的训练数据集合构建出原始机械臂模型。通过公式(1)可知,将电压训练数据输入公式(1)后能够得到当前位置和下一时刻位置的预测位姿数据,然后即可将训练位姿数据和预测位姿数据进行比对,以确定奖励函数。其中,原始机械臂模型中的系数a、b、c,且系数a、b、c为系数矩阵。因此通过求解出系数矩阵a、b、c即可确定目标机械臂模型,以根据目标机械臂模型求出机械臂的控制策略。

[0088]

请参照图3,在一些实施例中,神经网络模型包括:编码器、解码器,步骤s103可以包括但不限于包括步骤s301和步骤s302。

[0089]

步骤s301,通过编码器根据奖励函数对原始机械臂模型进行编码处理,得到编码数据;

[0090]

步骤s302,通过解码器根据编码数据进行模型重构处理,得到初始机械臂模型;其中,初始机械臂模型为线性模型。

[0091]

在一些实施例的步骤s301中,神经网络模型为deep-edmd网络,其中,edmd为exteneded dynamic mode decomposition,以通过deep-edmd网络求解系数a、b、c。其中,deep-edmd网络由解码器和编码器组成,因此通过编码器对原始机械臂模型进行编码处理。其中,训练的损失函数如公式(2)所示:

[0092][0093]

其中,x

lift

=[ψ(x1),

…

,ψ(xk)],y

lift

=[ψ(x2),

…

,ψ(x

k+1

)]。

[0094]

在一些实施例的步骤s302中,通过解码器根据所述编码数据进行模型重构处理也即根据公式(2)求解系数矩阵a、b、c,以将系数输入原始机械臂模型以得到线性的初始机械臂模型。由于ψ(x)=[x

t

,φ

n+1

(x),

…

,φn(x)]

t

,前n维由系统自身状态组成,φi是非线性函数,所得的解析解为:

[0095][0096][0097]

因此,通过编码器和解码器对原始机械臂模型进行编码和解码处理,以得到线性模型的初始机械臂模型,以便于构建线性初始机械臂模型进行后续的强化学习和更新。

[0098]

请参照图4,在一些实施例中,编码器包括:第一全连接层、第一激活层、第二全连接层、第二激活层、第三全连接层和第三激活层;解码器包括:第四全连接层、第四激活层、第五全连接层、第五激活层、第六激活层和第六全连接层,第一激活层、第二激活层、第五激活层和第六激活层为prelu层,第三激活层和第四激活层为tanh层。

[0099]

需要说明的是,第一全连接层连接带有参数的prelu层,然后prelu层连接第二全连接层,第二全连接层再连接另一个prelu层,另一个prelu层再连接第三全连接层,第三全连接层连接tanh层,然后通过tanh层输出。因此,通过将原始机械臂模型输入第一全连接

层、第一激活层、第二全连接层、第二激活层、第三全连接层和第三激活层,以对原始机械臂模型进行编码处理以得到编码数据。其中,将原始机械臂模型转换为编码数据,也即将原始机械臂模型按照预设的参考模型进行映射,以得到与参考模型类型对应的编码数据。第四全连接层连接带有参数的prelu层,prelu层连接第五全连接层,第五全连接层连接另一prelu层,另一prelu层连接第六全连接层,第六全连接层连接tanh层。因此,通过将初始机械臂模型输入第四全连接层、第四激活层、第五全连接层、第五激活层、第六激活层和第六全连接层进行解码处理,也即进行模型重建,以得到线性的初始机械臂模型。因此,通过线性变换得到用于强化学习的初始机械臂模型。

[0100]

需要说明的是,得到了线性的机械臂模型后,根据预设的奖励函数对初始机械臂模型进行更新,其中,预设的奖励函数也即上述公式(2)的奖励函数,以不断更新奖励函数,实现强化学习的动作和环境交互,进而不断更新初始机械臂模型的系数以优化初始机械臂模型,也即根据奖励函数更新策略进行下一次交互,最终得到机械臂强化学习的最优策略,也即构建更加符合实际机械臂操控的目标机械臂模型,使得目标机械臂模型构建更加准确,通过目标机械臂模型进行策略预测也更加准确。

[0101]

请参照图5,本技术实施例还提供了一种策略优化方法,策略优化方法可以包括但不限于包括步骤s501至步骤s502:

[0102]

步骤s501,获取电压预测数据,并将电压预测数据输入至目标机械臂模型,得到初始控制策略;其中,目标机械臂模型如上述的训练方法训练得到;

[0103]

步骤s502,根据预设优化算法对初始控制策略进行优化处理,得到目标控制策略。

[0104]

本技术实施例所示意的步骤s501至步骤s502,当需要进行机械臂的控制策略优化时,先将电压预测数据输入上述得到的目标机械臂模型,以通过目标机械臂模型得到初始控制策略,由于目标机械臂模型由上述训练得到,所以得到的初始控制策略能够控制机械臂准确抓取目标位置的物品,但是为了进一步提高机械臂抓取的优化,既能够保证机械臂抓取又能够简化策略,则通过预设优化算法对初始控制策略进行优化以得到目标控制策略,使得机械臂的操控即准确又简易,从而提高机械臂强化学习的效率。

[0105]

在一些实施例的步骤s501中,当需要进行策略优化时,利用上述得到的目标机械臂模型输入电压预测数据以得到初始控制策略,使得机械臂的控制策略计算简易。

[0106]

在一些实施例的步骤s502中,预设优化算法为代价方程,通过最优控制的代价方程来对初始控制策略进行优化,以优化机械臂的控制策略,使得机械臂操控更加简易且准确。

[0107]

请参照图6,在一些实施例中,目标机械臂模型包括:目标强化模型和目标动力学模型;其中,目标强化模型用于根据电压数据输出对应的位姿数据,目标动力学模型则根据位姿数据得到控制策略。步骤s501可以包括但不限于包括步骤s601和步骤s602。

[0108]

步骤s601,获取电压预测数据,并将电压预测数据输入目标强化模型,得到预测位姿数据;

[0109]

步骤s602,将预测位姿数据输入至目标动力学模型,得到目标控制策略。

[0110]

在一些实施例的步骤s601中,通过将电压预测数据输入目标强化模型,能够得到当前位置和下一时刻的位姿数据,以获取下一时刻的位姿数据作为预测位姿数据,以根据下一时刻的位姿数据进行机械臂的控制策略的预测,则根据初始控制策略控制机械臂运

行,以使机械臂抓取下一时刻位置的物品,实现机械臂的精准控制。

[0111]

在一些实施例的步骤s602中,目标动力学模型的具体公式如公式(3)所示:

[0112][0113]

式中,表示坐标系下的位姿数据,u为控制策略。因此,通过目标强化模型先得到的预测位姿数据,并将预测位姿数据输入公式(3)以得到初始控制策略,使得机械臂的控制策略计算简易。

[0114]

请参照图7,在一些实施例中,预设优化算法包括:预设代价算法和递归微分算法。步骤s502可以包括但不限于步骤s701和步骤s702。

[0115]

步骤s701,根据预设代价算法对初始控制策略进行构建,得到代价方程;

[0116]

步骤s702,根据递归微分算法对代价方程进行求解处理,得到目标控制策略。

[0117]

在一些实施例的步骤s701中,通过预设代价算法对初始控制策略进行代价方程构建,以将最优策略学习问题转化为最优控制问题。因此,构建代价方程如公式(4)所示:

[0118][0119]

式中,c(x

t

,u

t

)即为代价方程,u为初始控制策略,x为电压预测数据。

[0120]

其中,代价方程具体计算公式如公式(5)所示:

[0121][0122]

式中,φ

θ

(x

t

)即为上述zk,a,b由公式(2)求得。而φ

θ

(x

τ

)表示由最优参考轨迹s

′

经过升维变换之后的参考轨迹。

[0123]

在一些实施例的步骤s702中,根据递归微分算法对代价方程进行求解上述公式(5),以优化初始控制策略得到目标控制策略。其中,根据递归微分算法对代价方程进行求解具体如公式(6)所示:

[0124][0125]

其中,k

t

=(r+b

t

p

t+1

b)-1bt

p

t+1

az,k

t

=(b

t

p

t+1

b+r)-1bt

p

t+1

分表代表了目标机械臂模型中的反馈项和前馈项,其中p

t

=a

t

p

t+1

(a-bk

t

)+q,递归微分算法为递归riccati方程,p

t

=(a-bk

t

)

t

p

t+1

+qxr可由递归riccati方程求得,其过程如下所示:

[0126]

假设有离散系统:

[0127]

x

t+1

=ax

t

+bu

t

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0128]

对其进行lqr控制器设计,则有代价函数:

[0129][0130]

假设t时刻的状态为z,则在t时刻到n时刻的代价函数可表示为:

[0131][0132]

当t为n时有:将其代入上式可得:

[0133][0134]

其中,ω为最优策略,上式为关于ω的无约束凸优化问题,因此可直接求其极值:

[0135]

ω

*

=-(r+b

t

p

t+1

b)-1bt

p

t+1

az

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(11)

[0136]

将该最优策略带入t时刻至n时刻得代价函数中,得到:

[0137]

p

t

=q+a

t

p

t+1

a-a

t

p

t+1

b(r+b

t

p

t+1

b)-1bt

p

t+1aꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(12)

[0138]

上式即为递归riccati方程,同理可求得p

t

=(a-bk

t

)

t

p

t+1

+qxr。

[0139]

因此,通过公式(7)至(12)对代价方程进行求解以优化初始控制策略,从而得到目标控制策略,以根据目标控制策略求解出机械臂的相关控制量以形成控制信号,并将控制信号发送至机械臂,则机械臂根据控制信号进行操控,以准确抓取到目标位置上的物品,使得机械臂操控准确且简易。

[0140]

请参照图8,本技术实施例还提供一种模型训练装置,装置包括:

[0141]

获取模块801,用于获取机械臂的训练数据集合;其中,训练数据集合包括:电压训练数据、位姿训练数据、训练策略,电压训练数据作为强化学习的环境,训练策略作为强化学习的动作;

[0142]

构建模块802,用于根据预设的动力学分析算法对训练数据集合进行模型构建,得到原始机械臂模型;

[0143]

变换模块803,用于将原始机械臂模型输入预设的神经网络模型进行线性变换处理,得到初始机械臂模型;

[0144]

更新模块804,用于根据预设的奖励函数对所述初始机械臂模型进行更新处理,得到目标机械臂模型。

[0145]

该模型训练装置的具体实施方式与上述模型训练方法的具体实施例基本相同,在此不再赘述。

[0146]

请参阅图9,图9示意了另一实施例的电子设备的硬件结构,电子设备包括:

[0147]

处理器901,可以采用通用的cpu(centralprocessingunit,中央处理器)、微处理器、应用专用集成电路(applicationspecificintegratedcircuit,asic)、或者一个或多个集成电路等方式实现,用于执行相关程序,以实现本技术实施例所提供的技术方案;

[0148]

存储器902,可以采用只读存储器(readonlymemory,rom)、静态存储设备、动态存储设备或者随机存取存储器(randomaccessmemory,ram)等形式实现。存储器902可以存储操作系统和其他应用程序,在通过软件或者固件来实现本说明书实施例所提供的技术方案时,相关的程序代码保存在存储器902中,并由处理器901来调用执行本技术实施例的模型训练方法或者策略优化方法;

[0149]

输入/输出接口903,用于实现信息输入及输出;

[0150]

通信接口904,用于实现本设备与其他设备的通信交互,可以通过有线方式(例如usb、网线等)实现通信,也可以通过无线方式(例如移动网络、wifi、蓝牙等)实现通信;

[0151]

总线905,在设备的各个组件(例如处理器901、存储器902、输入/输出接口903和通信接口904)之间传输信息;

[0152]

其中处理器901、存储器902、输入/输出接口903和通信接口904通过总线905实现彼此之间在设备内部的通信连接。

[0153]

本技术实施例还提供了一种存储介质,存储介质为计算机可读存储介质,用于计算机可读存储,存储介质存储有一个或者多个程序,一个或者多个程序可被一个或者多个处理器执行,以实现上述的模型训练方法或者策略优化方法。

[0154]

存储器作为一种非暂态计算机可读存储介质,可用于存储非暂态软件程序以及非暂态性计算机可执行程序。此外,存储器可以包括高速随机存取存储器,还可以包括非暂态存储器,例如至少一个磁盘存储器件、闪存器件、或其他非暂态固态存储器件。在一些实施方式中,存储器可选包括相对于处理器远程设置的存储器,这些远程存储器可以通过网络连接至该处理器。上述网络的实例包括但不限于互联网、企业内部网、局域网、移动通信网及其组合。

[0155]

本技术实施例提供的模型训练方法和装置、策略优化方法、设备及介质,其通过预设的动力学分析算法对训练数据集合进行模型构建,再根据神经网络模型以预设奖励函数对原始机械臂模型进行求解得到目标系数,以根据目标系数调整原始机械臂模型的参数以得到目标机械臂模型,使得机械臂的强化学习计算简易,提高机械臂强化学习的效率,且根据目标机械臂模型可以得到最优策略,使得最优策略计算操作简易。

[0156]

本技术实施例描述的实施例是为了更加清楚的说明本技术实施例的技术方案,并不构成对于本技术实施例提供的技术方案的限定,本领域技术人员可知,随着技术的演变和新应用场景的出现,本技术实施例提供的技术方案对于类似的技术问题,同样适用。

[0157]

本领域技术人员可以理解的是,图1-7或图6-7,中示出的技术方案并不构成对本技术实施例的限定,可以包括比图示更多或更少的步骤,或者组合某些步骤,或者不同的步骤。

[0158]

以上所描述的装置实施例仅仅是示意性的,其中作为分离部件说明的单元可以是或者也可以不是物理上分开的,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本实施例方案的目的。

[0159]

本领域普通技术人员可以理解,上文中所公开方法中的全部或某些步骤、系统、设备中的功能模块/单元可以被实施为软件、固件、硬件及其适当的组合。

[0160]

本技术的说明书及上述附图中的术语“第一”、“第二”、“第三”、“第四”等(如果存在)是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便这里描述的本技术的实施例能够以除了在这里图示或描述的那些以外的顺序实施。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,例如,包含了一系列步骤或单元的过程、方法、系统、产品或设备不必限于清楚地列出的那些步骤或单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它步骤或单元。

[0161]

应当理解,在本技术中,“至少一个(项)”是指一个或者多个,“多个”是指两个或两个以上。“和/或”,用于描述关联对象的关联关系,表示可以存在三种关系,例如,“a和/或b”可以表示:只存在a,只存在b以及同时存在a和b三种情况,其中a,b可以是单数或者复数。字

符“/”一般表示前后关联对象是一种“或”的关系。“以下至少一项(个)”或其类似表达,是指这些项中的任意组合,包括单项(个)或复数项(个)的任意组合。例如,a,b或c中的至少一项(个),可以表示:a,b,c,“a和b”,“a和c”,“b和c”,或“a和b和c”,其中a,b,c可以是单个,也可以是多个。

[0162]

在本技术所提供的几个实施例中,应该理解到,所揭露的装置和方法,可以通过其它的方式实现。例如,以上所描述的装置实施例仅仅是示意性的,例如,上述单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。另一点,所显示或讨论的相互之间的耦合或直接耦合或通信连接可以是通过一些接口,装置或单元的间接耦合或通信连接,可以是电性,机械或其它的形式。

[0163]

上述作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本实施例方案的目的。

[0164]

另外,在本技术各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

[0165]

集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括多指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本技术各个实施例的方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(read-only memory,简称rom)、随机存取存储器(random access memory,简称ram)、磁碟或者光盘等各种可以存储程序的介质。

[0166]

以上参照附图说明了本技术实施例的优选实施例,并非因此局限本技术实施例的权利范围。本领域技术人员不脱离本技术实施例的范围和实质内所作的任何修改、等同替换和改进,均应在本技术实施例的权利范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1