一种基于卷积神经网络的深度图置信度估计方法与流程

1.本发明涉及计算机视觉与深度学习领域,具体是一种利用卷积神经网络对多视立体匹配中的中间结果进行特征提取及置信度预测,以完成对深度图的质量评估。

背景技术:

2.深度图质量评估是计算机视觉领域的一个基本课题,目前基于深度学习的方法基于单目或双目立体匹配输出的深度图和原始彩色图,构建卷积神经网络预测得到置信度图,这种方法无法充分利用多目立体匹配得到的多模态数据,并且由于网络结构简单而产生较低的精度。

技术实现要素:

3.本发明的目的是为了解决现有技术的不足,提供一种基于卷积神经网络的深度图置信度估计方法,从多视立体匹配算法所估计的中间结果中提取特征并预测深度图置信度的技术问题。

4.为了实现以上目的,本发明所述的一种基于卷积神经网络的深度图置信度估计方法,该方法的具体步骤如下:

5.一种基于卷积神经网络的深度图置信度估计方法,该方法的具体步骤如下:

6.由多目立体匹配算法生成的深度图计算截断符号距离函数图和法线图;

7.利用u型网络结构对所述截断符号距离函数图、法线图和彩色图进行特征提取,得到特征图;

8.使用卷积长短时记忆结构、预测模块、和细化模块由所述特征图预测深度图的置信度并通过多监督方法细化估计结果。

9.进一步地,所述由多目立体匹配算法生成的深度图计算截断符号距离函数图和法线图,包括:

10.像素和其4

‑

邻域构成局部窗口,假设窗口内的点所对应的三维点在同一个平面上,则从所述三维点构成的向量中,任选两个不在同一平面的向量进行叉乘,即得到所述像素对应的法线;

11.多目立体匹配的几何误差用三维点的z坐标与平面深度之差来表示,所述几何误差是三维点到平面的距离的近似,将几何误差映射到预设范围内,并加权处理,使用逆深度来计算截断符号距离函数图。

12.进一步地,所述u型网络结构提取图像的高层次语义信息,包括编码和解码两个部分,每个编码子模块包括卷积、批归一化、非线性激活和最大池化四个操作,每个解码子模块包括转置卷积、卷积、批归一化和非线性激活四个操作。

13.进一步地,所述利用u型网络结构对所述截断符号距离函数图、法线图和彩色图进行特征提取,得到特征图,包括:

14.(a)对输入图像进行编码:每个编码子模块的输入为前一个子模块的输出,经过每

个子模块后输出特征图的高和宽各缩小到输入的1/2,通道数增加到输入的2倍,保留每个子模块的卷积结果用于解码;

15.(b)对编码模块的输出进行解码:每个解码子模块的输入为前一个子模块的输出,经过每个子模块后输入特征图的高和宽各增加到输入的2倍,通道数减小到输入的1/2。

16.进一步地,所述使用卷积长短时记忆结构、预测模块、和细化模块由所述特征图预测深度图的置信度,包括:多次迭代,在每次迭代中,使用卷积长短时记忆结构保留特征图在多次迭代时的长时和短时记忆,之后使用卷积层构成的预测模块得到每次迭代的置信度图,使用由卷积层构成的细化模块对预测得到的结果进行细化。

17.进一步地,迭代地从特征图中预测并细化置信度图,将u型网络结构提取到的u

‑

net特征作为固定参考信息,每轮迭代中,将u

‑

net特征和上一轮迭代的预测输出串联,作为本次迭代的输入,然后依次经过卷积长短时记忆结构、预测模块、和细化模块;

18.循环上述卷积长短时记忆结构、预测模块、和细化模块多次得到细化后的置信度图,在不同次迭代间共享模块的权重;

19.在首轮迭代中将预测输出初始化为像素值为0的图,在最后一轮迭代中只使用卷积长短时记忆结构和预测模块来获取预测结果。

20.进一步地,所述卷积长短时记忆结构用于处理序列数据,基础结构是元胞,元胞内包括遗忘门、输入门和输出门,分别决定该元胞需要遗忘、存储和输出的信息。

21.进一步地,所述细化模块由多个卷积层构成,输入是每轮迭代的预测结果,输出是由预测结果提取到的新特征,将所述新特征和u型网络结构提取到的u

‑

net特征串联作为新一轮预测的输入。

22.进一步地,所述细化模块的具体操作步骤为:

23.细化模块对预测模块的结果进行细化,每个卷积层包括卷积、批归一化和非线性激活操作;

24.细化模块对单通道置信度图进行特征再提取,第一个卷积层从单通道置信度图中提取出多通道信息,之后的卷积层不再改变通道数,只编码关于置信度图的高层次信息。

25.进一步地,所述通过多监督方法细化估计结果,包括:

26.监督最终预测的置信度图,以及单独对u型网络结构解码后的特征进行监督:对u型网络结构输出结果做单层卷积、批归一化和sigmoid激活,得到由u型网络结构直接预测到的置信度图,最后分别由所述u型网络结构直接预测到的置信度图和所述最终预测的置信度图计算交叉熵损失函数,根据结果调整两者权重。

27.本发明的优点在于:本发明能对各种多目立体匹配算法所生成的深度图进行质量评估,能鲁棒地估计出多目立体匹配中的深度图置信度,以利于多目立体匹配算法的评估和对深度图的后处理。

附图说明

28.通过阅读下文优选实施方式的详细描述,各种其他的优点和益处对于本领域普通技术人员将变得清楚明了。附图仅用于示出优选实施方式的目的,而并不认为是对本发明的限制。而且在整个附图中,用相同的参考符号表示相同的部件。在附图中:

29.图1根据本发明实施方式的一种基于卷积神经网络的深度图置信度方法流程图;

30.图2为根据本发明实施方式的u

‑

net结构图;

31.图3为根据本发明实施方式的由u

‑

net结构预测得到的初始置信度图;

32.图4为根据本发明实施方式的对convlstm的元胞结构图;

33.图5为根据本发明实施方式的由预测及细化模块得到的最终置信度图。

具体实施方式

34.下面将参照附图更详细地描述本公开的示例性实施方式。虽然附图中显示了本公开的示例性实施方式,然而应当理解,可以以各种形式实现本公开而不应被这里阐述的实施方式所限制。相反,提供这些实施方式是为了能够更透彻地理解本公开,并且能够将本公开的范围完整的传达给本领域的技术人员。

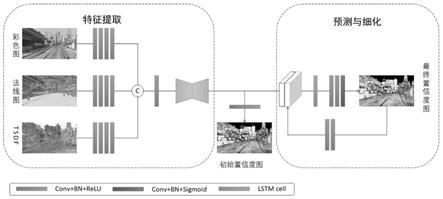

35.本发明提出基于多目立体匹配的深度图置信度估计网络初步解决了该问题,利用u型网络(u

‑

net)结构对多目立体匹配算法生成的截断符号距离函数图(tsdf)、彩色图和法线图进行特征提取,利用卷积长短时记忆(convlstm)和预测模块由特征图预测深度图的置信度,利用细化模块和多监督方法改善估计效果。

36.u

‑

net结构是一种经典的编码

‑

解码结构,编码结构能识别到图像的多尺度特征,解码结构能恢复图像的细节并进一步提取任务导向的特征,由于是全卷积网络,u

‑

net能充分利用图像的全局信息。u

‑

net结构的编码模块由多个编码子模块构成,其中卷积操作对图像进行特征提取,降采样操作逐步减小通道数量,解码模块逐步修复物体的细节并恢复空间维度,解码模块由多个解码子模块构成,每个子模块包括转置卷积、卷积、批归一化和非线性激活四个操作。每个编码子模块卷积后的特征图通过跳跃连接(skip connection)连接到相应的解码子模块中,以保留原始图像的细节信息。

37.长短时记忆网络,即convlstm网络用于处理序列数据,解决了神经网络的长时依赖问题,convlstm的基础结构是元胞,每个元胞的输入包含当前时刻网络的输入值、上一时刻元胞的输出值和上一时刻元胞的状态,元胞内包括遗忘门、输入门和输出门,分别决定该元胞需要遗忘、存储和输出的信息。convlstm是lstm在图像处理中的应用,将经典lstm中的全连接层转变为卷积层,能更加针对性的提取图像特征。

38.如图1所示,本发明所述的一种基于卷积神经网络的深度图置信度方法,该方法的具体步骤如下:

39.步骤一:由多目立体匹配算法生成的深度图计算tsdf和法线图;

40.(1.1):法线图:假设像素点和其4

‑

邻域对应的三维点在同一个平面上,则从这些三维点构成的向量中,任选两个不在同一平面的向量进行叉乘,即得到该像素对应的法线。

41.(1.2):tsdf:多目立体匹配的几何误差可用三维点的z坐标与平面深度之差来表示,该值是三维点到平面的距离的近似,为了增强该评价指标在实际应用中的鲁棒性,将该值映射到一定范围内,并加权处理。为缓解多目立体匹配中的尺度差异问题,使用逆深度来计算tsdf。

42.步骤二:利用u

‑

net结构对tsdf、彩色图和法线图进行特征提取;

43.(1):对原始图像进行编码:包括四个编码子模块,每个子模块包括卷积、批归一化、非线性激活和最大池化四个操作。输入为来自tsdf、彩色图和法线图三个模态的卷积特征,每个模态包含64维特征,在每个子模块内,首先经过3x3卷积扩大感受野,为了保证输出

图像的空间维度不变,采用1像素的常量填充,同时输入的通道数增加到原来的2倍;然后通过经过批归一化对每个批次的数据计算均值和方差,利用均值和方差对数据进行归一化处理,使得卷积层的输出更接近真实的分布,缓解梯度弥散问题并加快训练的收敛;之后经过relu函数将输出映射到[0,+∞]范围内,增加网络的非线性表达能力;最后利用步长为2的最大池化对特征图进行降采样。每个编码子模块的输入为前一个子模块的输出,经过每个子模块后输出特征图的高和宽各缩小到输入的1/2,通道数增加到输入的2倍,为了减少图像细节的损失,保留每个子模块的卷积结果用于解码。

[0044]

(2):对编码模块的输出进行解码:包括四个解码子模块,每个子模块包括转置卷积、卷积、批归一化和非线性激活四个操作。在每个子模块内,首先经过步长为2、卷积核为3x3的转置卷积对输入特征进行上采样,为了保证图像的空间维度不变,对输入填充1像素,输出填充1像素;之后将上采样结果和对应编码子模块中的卷积结果进行通道级的连接;之后通过3x3的卷积提取这两部分的信息,为了保证输出维度不变,对输入填充1像素,同时将图像通道数缩减到和对应编码子模块相同的数量;然后通过经过批归一化对每个批次的数据计算均值和方差,利用均值和方差对数据进行归一化处理,使得卷积层的输出更接近真实的分布,缓解梯度弥散问题并加快训练的收敛;之后经过relu函数将输出映射到[0,+∞]范围内,增加网络的非线性表达能力。每个解码子模块的输入为前一个子模块的输出,经过每个子模块后输入特征图的高和宽各增加到输入的2倍,通道数减小到输入(不包含skip connection部分)的1/2。

[0045]

步骤三:使用convlstm结构、预测模块、细化模块和多监督方法对特征图进行预测;

[0046]

(1)通过三次迭代从特征图中预测并细化置信度图,将u

‑

net结构提取到的特征作为固定参考信息,每轮迭代中,将u

‑

net特征和上一轮迭代的预测输出串联,作为本次迭代的输入,然后依次经过convlstm模块、预测模块和细化模块。特别地,在首轮迭代中将预测输出初始化为像素值全为0的图,在最后一轮迭代中只经过convlstm模块和预测模块来获取预测结果。具体步骤为:

[0047]

(1.1):使用convlstm保留迭代中的长短时信息,convlstm模块为一个convlstm元胞,元胞中保留着两个值:元胞在上一次的输出h

t

‑1和上一次的状态c

t

‑1。元胞首先将本次迭代的输入x

t

和元胞上一次的输出h

t

‑1通过由卷积和激活函数构成的遗忘门、输入门和输出门,卷积核大小为3x3,为了保证输出图像的空间维度不变,对输入填充1像素,三个门操作分别决定该元胞需要遗忘、存储和输出的信息,t在本发明中为迭代的次数:

[0048]

f

t

=σ(w

xf

x

t

+b

xf

+w

hf

h

t

‑1+b

hf

)

[0049]

g

t

=tanh(w

xg

x

t

+b

xg

+w

hg

h

t

‑1+b

hg

)

[0050]

i

t

=σ(w

xi

x

t

+b

xi

+w

hi

h

t

‑1+b

hi

)

[0051]

o

t

=σ(w

xo

x

t

+b

xo

+w

ho

h

t

‑1+b

ho

)

[0052]

其中遗忘门得到保留上一次状态的权重f

t

,w

xf

、b

xf

分别表示计算遗忘门时x

t

的卷积权重和偏置,w

hf

、b

hf

分别表示计算遗忘门时h

t

‑1的卷积权重和偏置;输入门预测两个值:g

t

、i

t

,分别是新预测的候选状态和保留该状态的权重,将该候选状态和上一次的状态加权求和可得到本轮的状态c

t

=f

t

c

t

‑1+i

t

g

t

,w

xg

、b

xg

分别表示计算输入门的候选状态时x

t

的卷积权重和偏置,w

hg

、b

hg

分别表示计算输入门的候选状态时h

t

‑1的卷积权重和偏置,w

xi

、b

xi

分别

表示计算输入门的权重时x

i

的卷积权重和偏置,w

hi

、b

hi

分别表示计算输入门的权重时h

t

‑1的卷积权重和偏置;输出门决定输出内容的权重o

t

,w

xo

、b

xo

分别表示计算遗忘门时x

t

的卷积权重和偏置,w

ho

、b

ho

分别表示计算遗忘门时h

t

‑1的卷积权重和偏置,将o

t

和经tanh激活的本轮状态点乘作为该元胞本轮的输出h

t

=o

t

tanh(c

t

)。元胞通过保留短时的输出和长时的状态,缓解了每轮迭代中的长时依赖问题。

[0053]

(1.2):使用预测模块将特征预测为置信度图,预测模块由多个卷积层串联而成,每个卷积层包括卷积、批归一化和非线性激活操作,在第一个卷积层内,使用3x3卷积核将128通道的输入特征转化为64通道,为保证图像空间维度不变填充1像素,然后使用relu激活函数,在第二个卷积层内,使用3x3卷积核对图像卷积,填充1像素,输出通道数不变,之后使用relu激活函数,在第三个卷积层内,使用1x1卷积核提取单像素特征,并输出单通道的图像,经过sigmoid函数激活,将输出映射到[0,1]范围内得到置信度图,每个卷积层在卷积后都使用批归一化操作来加速收敛。

[0054]

(1.3):使用细化模块对预测模块的结果进行细化,细化模块由多个卷积层串联而成,每个卷积层包括卷积、批归一化和非线性激活操作。细化模块对单通道置信度图进行特征再提取,第一个卷积层使用3x3卷积核从置信度图中提取64通道特征,为保证图像空间维度不变填充1像素,第二个卷积层使用3x3卷积核,填充1像素,输出通道数不变,只编码关于置信度图的高层次信息。

[0055]

循环上述模块多次可得到细化后的置信度图,考虑到数据在不同迭代中语义信息相似,因此在不同次迭代间共享模块的权重。

[0056]

(2)使用多监督方法分别对细化前后的结果施加监督。由于网络模块较多,为了避免网络训练出现过拟合现象,除了监督最终预测的置信度图外,还单独对u

‑

net解码后的特征进行监督:对u

‑

net输出结果做单层卷积、批归一化和sigmoid激活,得到由u

‑

net直接预测到的置信度图,最后分别由该图、最终置信度图与真实置信度计算交叉熵损失函数:

[0057]

a=

‑

w1[x

*

logx1+(1

‑

x

*

)log(1

‑

x1)]

‑

w2[x

*

logx2+(1

‑

x

*

)log(1

‑

x2)]

[0058]

其中x1分别表示u

‑

net预测得到的置信度图,w1表示由其计算的loss占最终loss的比例,x2表示由网络最终预测得到的置信度图,w2表示由其计算的loss占最终loss的比例,x

*

表示真实置信度,在实验中根据结果调整两者权重。

[0059]

本发明能对各种多目立体匹配算法所生成的深度图进行质量评估,能鲁棒地估计出多目立体匹配中的深度图置信度,以利于多目立体匹配算法的评估和对深度图的后处理。

[0060]

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以所述权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1