基于多特征融合的图像中人物交互检测方法

1.本发明属于利用计算机视觉进行图像中视觉关系检测和理解的技术领域,具体涉及一种基于多特征融合的图像中人物交互检测方法。

背景技术:

2.图像中的人物交互(human

‑

object interaction,hoi)检测的目标是利用计算机视觉自动检测出输入图片中发生交互的人、物体等目标的具体位置,并识别出<人

‑

物体>对之间的交互行为类别,从而实现机器对图像内容的自动理解。人物交互检测是通过计算机视觉自动理解深层次视觉关系、实现高级人工智能的核心技术,可广泛应用于智能机器人、安全监控、信息检索、人机交互等诸多领域。

3.现有的人物交互检测方法大多数是从目标检测的结果出发,将图中所有的人和物体完全配对,提取出人和物体的特征,以及<人

‑

物体>对间的空间特征来推测人与物体之间的交互行为。这种仅依靠实例级特征的推测方式在处理相对复杂的交互类时仍存在不足,导致整体检测精度不高。首先,由于缺乏细节线索,难以确定具有实例级别表示的人与物体实例的相关性,容易导致人和未发生交互物体之间的错误关联。另外,仅依靠相似的实例级特征来区分精细粒度的交互类型时,特征之间的内在联系未被有效利用,无法对复杂情况进行准确判断。

技术实现要素:

4.为了解决现有技术问题,本发明的目的在于克服已有技术存在的不足,提供一种基于多特征融合的图像中人物交互检测方法。该方法在利用人体位姿捕获交互行为的全局空间配置基础上,关注于图像场景中的人体与物体的交集区域所提供的有效信息,通过多支流神经网络学习更加精细的局部特征,增加了正确匹配<人

‑

物体>交互对的概率,并通过短期记忆选择模块,对人体和物体及其背景区域信息进行有效的筛选利用,通过各类特征的融合实现人物交互行为检测。

5.为达到上述发明创造目的,本发明采用如下发明构思:

6.首先利用目标检测算法检测出图片中所有实例信息,包括人体位置信息以及物体位置和类别信息等,之后输入训练好的人物交互行为识别网络,检测待测图片中人物对之间的交互行为。人物交互识别网络采用多支流神经网络结构,包括成对支流、交集支流和短期记忆选择支流,网络对图片中<人

‑

物体>实例对各类特征进行了学习训练。

7.根据上述发明构思,本发明采用如下技术方案:

8.一种基于多特征融合的图像中人物交互检测方法,其操作步骤为:

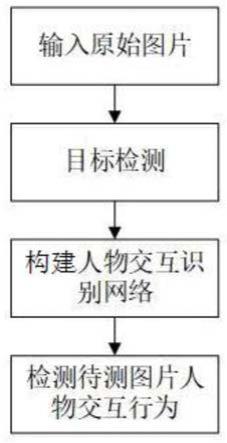

9.步骤1:输入原始图片;

10.步骤2:目标检测;

11.步骤3:构建人物交互识别网络;

12.步骤4:检测待测图片人物交互行为;

13.在所述步骤2中,利用目标检测算法检测出图片中所有实例信息,包括人体位置信息以及物体位置和类别信息后,输入训练好的人物交互行为识别网络,检测待测图片中人物对之间的交互行为;

14.在所述步骤3中,人物交互识别网络采用多支流神经网络结构,包括成对支流、交集支流和短期记忆选择支流,网络对图片中<人

‑

物体>实例对各类特征进行了学习训练。

15.优选地,在所述步骤2中,目标检测的过程为:

16.采用训练好的目标检测器对输入图片进行目标检测,得到人的候选框b

h

以及人的置信度s

h

和物体的候选框b

o

以及物体的置信度s

o

,其中下标h表示人体、o表示物体。

17.优选地,在所述步骤3中,构建人物交互识别网络包括以下步骤:

18.1)提取整张图片卷积特征:

19.使用经典残差网络resnet

‑

50对原始输入图片进行卷积特征提取,得到整张图片的全局卷积特征图f,与目标检测结果的人体位置b

h

、物体位置b

o

一起作为人物交互检测网络的输入;

20.2)构建成对支流:

21.根据给定的人物边界框生成一幅具有两个通道的二进制图像b

h,o

,将其输入包含两个卷积层两个池化层的浅层卷积神经网络,两个卷积层卷积核大小都是5

×

5,卷积核的数量分别为64和32,池化层均为最大池化;然后经过平铺位置特征图,得到位置特征向量f

sp

,其中下标sp表示人和物体相对位置,之后将向量输入全连接层分类器和sigmoid激活函数得到位置特征支流在各交互类别上分类结果其中上标a∈{1,...,a}是所对应的交互类别,其中a是所有交互类别数;

22.3)构建交集支流:

23.首先根据人与物体位置求取人物对交集边界框坐标b

inter

,其中下标inter表示人与物体的交集,并利用感兴趣区域池化操作roi pooling在全局卷积特征图f上截取交集区域卷积特征,之后使用残差块res对特征进行优化,并通过全局平均池化层gap后得到人物对交集区域特征f

inter

;同时,对图片人体关键点检测结果进行编码,在每个人物对的最小外接矩形框中,模型对不同关节点之间按coco数据集提供的骨架模型用不同灰度值的连线连接,用于表征身体的不同部位,其中coco数据集是由微软公司制作的适用于各类计算机视觉任务的大型公开数据集;矩形框内其余区域像素值都设为0,并且将矩形框调整至一个固定尺度64

×

64,得到位姿特征图;然后通过两个卷积池化层提取位姿特征f

pose

,其中下标pose表示人体位姿,两个卷积层卷积核大小都是5

×

5,卷积核的数量分别为32和16,池化层均采用最大池化;然后将交集区域特征f

inter

与位姿特征f

pose

进行拼接并通过两个全连接层进行特征融合得到f

inter

‑

pose

,将其输入全连接层分类器和sigmoid函数得到交集特征支流a维分类结果

24.4)构建短期记忆选择支流:

25.首先根据人体位置坐标b

h

在全局卷积特征图f上进行roi pooling操作提取人体区域特征,之后再利用残差块res优化特征并通过全局平均池化gap得到池化后的人体特征向量f

h

;

26.根据物体位置坐标b

o

在全局卷积特征图f上进行roi pooling操作提取物体区域特征,之后利用残差块res优化特征并通过全局平均池化gap得到池化后的物体视觉特征向

量其中上标vis表示视觉特征,并选取google

‑

news数据集上预训练后的可公开使用的word2vec向量作为物体语义特征,针对每一个物体类别的标签可提取一个300维的语义特征向量其中上标sem表示语义特征;之后将物体的语义特征向量与视觉特征向量拼接后经过一个全连接层,最终获得1024维的物体特征向量f

o

;优选可公开使用的word2vec向量为至少1000亿个单词;google

‑

news数据集为谷歌公司制作的数据集;

27.对于共同区域的视觉特征,首先根据人和物体的边界框计算最小外接矩形,即两个边界框的并集区域b

union

,其中下标union表示人与物体并集,之后在卷积特征图上通过共同区域边界框坐标进行roi pooling操作规范化到7

×

7固定大小,之后经过残差块和全局平均池化提取得到2048维的视觉特征向量之后与成对支流输出的位置特征向量f

sp

硬连接,并送入全连接层得到1024维融合后的共同区域特征f

union

;

28.最后将人体特征f

h

,物体特征f

o

和人和物体共同区域特征f

union

输入短期记忆选择模块,短期记忆选择模块由两个门控循环单元(gated recurrent unit,gru)单元组成,将共同区域特征f

union

作为短期记忆模块的初始状态,第一个gru单元输入为人的表征f

h

,第二个单元输入为物体的表征f

o

,最后经由短期记忆选择模块的输出状态得到表征f

hoi

,经过全连接层分类器和sigmoid函数得到短期记忆选择支流分类结果

29.5)训练人物交互识别网络:

30.三个支流共同构成整个人物交互识别网络,将训练集中的样本作为人物交互行为识别网络的输入,计算三支流的交叉熵损失函数之和,利用梯度下降法更新网络参数,直到优化达到最大次数,则终止训练,得到训练好的人物交互行为识别网络。

31.优选地,在所述步骤4中,检测待测图片中人物交互行为的检测过程为:

32.针对待测图片先经过目标检测得到人与物体位置类别信息,之后将所有信息送入训练好的人物交互识别网络进行判断;采取先分类后融合的特征融合方式,即每个支流分别提取特征并进行检测分类,然后再对各支流分类结果分数进行融合得到最后的人物交互行为检测结果;然后针对每个人物对(b

h

,b

o

),人物交互检测最终得分计算公式如下:

[0033][0034]

其中,s

h

,s

o

为目标检测结果人体和物体的置信度,为在a类交互行为分类任务中属于每一类别的概率得分向量,中的*表示不同的支流。

[0035]

本发明与现有技术相比较,具有如下显而易见的突出实质性特点和显著优点:

[0036]

1.本发明利用多特征的充分融合来提升人物交互行为检测精度,通过关注人体位姿信息,与交集区域特征进行有效融合,在捕获全局空间配置的基础上融合细节信息,使网络学习更多局部细节信息,建立了人与物体的关联,特征区分更加明显,增加了正确人物交互对匹配的概率,从而提高整体分类准确率;

[0037]

2.本发明通过短期记忆选择模块对人和物体及其共同区域特征进行充分筛选,有效利用背景信息,进一步提高了人物交互检测的平均精度。

附图说明

[0038]

图1为本发明的基于多特征融合的图像中人物交互检测方法的流程图。

[0039]

图2为本发明的人物交互识别网络的结构示意图。

[0040]

图3为人体关键点检测获取的17个人体骨架关节点模型示意图。

具体实施方式

[0041]

以下结合具体的实施例子对上述方案做进一步说明,本发明的优选实施例详述如下:

[0042]

实施例一:

[0043]

在本实施例中,参见图1,基于多特征融合的图像中人物交互检测方法,,操作步骤为:

[0044]

步骤1:输入原始图片;

[0045]

步骤2:目标检测;

[0046]

步骤3:构建人物交互识别网络;

[0047]

步骤4:检测待测图片人物交互行为;

[0048]

在所述步骤2中,利用目标检测算法检测出图片中所有实例信息,包括人体位置信息以及物体位置和类别信息后,输入训练好的人物交互行为识别网络,检测待测图片中人物对之间的交互行为;

[0049]

在所述步骤3中,人物交互识别网络采用多支流神经网络结构,包括成对支流、交集支流和短期记忆选择支流,网络对图片中<人

‑

物体>实例对各类特征进行了学习训练。

[0050]

本实施例在利用位姿捕获交互关系的全局空间配置的基础上,关注于人与物体交集区域提供的有效信息,学习更加精细的局部特征,增加了正确人物交互对匹配的概率,并借助短期记忆选择模块对人和物体及其背景区域信息进行有效的筛选利用,通过各类特征的融合,提高了人物交互检测的精度。

[0051]

实施例二:

[0052]

本实施例与实施例一基本相同,特别之处在于:

[0053]

在本实施例中,在所述步骤2中,目标检测的过程为:

[0054]

采用训练好的目标检测器对输入图片进行目标检测,得到人的候选框b

h

以及人的置信度s

h

和物体的候选框b

o

以及物体的置信度s

o

。其中下标h表示人体、o表示物体。

[0055]

在本实施例中,在所述步骤3中,构建人物交互识别网络包括以下步骤:

[0056]

1)提取整张图片卷积特征:

[0057]

使用经典残差网络resnet

‑

50对原始输入图片进行卷积特征提取,得到整张图片的全局卷积特征图f,与目标检测结果的人体位置b

h

、物体位置b

o

一起作为人物交互检测网络的输入;

[0058]

2)构建成对支流:

[0059]

根据给定的人物边界框生成一幅具有两个通道的二进制图像b

h,o

,将其输入包含两个卷积层两个池化层的浅层卷积神经网络,两个卷积层卷积核大小都是5

×

5,卷积核的数量分别为64和32,池化层均为最大池化;然后经过平铺位置特征图,得到位置特征向量f

sp

,其中下标sp表示人和物体相对位置,之后将向量输入全连接层分类器和sigmoid激活函

数得到位置特征支流在各交互类别上分类结果其中上标a∈{1,...,a}是所对应的交互类别,其中a是所有交互类别数;

[0060]

3)构建交集支流:

[0061]

首先根据人与物体位置求取人物对交集边界框坐标b

inter

,其中下标inter表示人与物体的交集,并利用感兴趣区域池化操作roipooling在全局卷积特征图f上截取交集区域卷积特征,之后使用残差块res对特征进行优化,并通过全局平均池化层gap后得到人物对交集区域特征f

inter

;同时,对图片人体关键点检测结果进行编码,在每个人物对的最小外接矩形框中,模型对不同关节点之间按coco数据集提供的骨架模型用不同灰度值的连线连接,用于表征身体的不同部位;其中coco数据集是由微软公司制作的适用于各类计算机视觉任务的大型公开数据集;矩形框内其余区域像素值都设为0,并且将矩形框调整至一个固定尺度64

×

64,得到位姿特征图;然后通过两个卷积池化层提取位姿特征f

pose

,其中下标pose表示人体位姿,两个卷积层卷积核大小都是5

×

5,卷积核的数量分别为32和16,池化层均采用最大池化;然后将交集区域特征f

inter

与位姿特征f

pose

进行拼接并通过两个全连接层进行特征融合得到f

inter

‑

pose

,将其输入全连接层分类器和sigmoid函数得到交集特征支流a维分类结果

[0062]

4)构建短期记忆选择支流:

[0063]

首先根据人体位置坐标b

h

在全局卷积特征图f上进行roi pooling操作提取人体区域特征,之后再利用残差块res优化特征并通过全局平均池化gap得到池化后的人体特征向量f

h

;

[0064]

根据物体位置坐标b

o

在全局卷积特征图f上进行roi pooling操作提取物体区域特征,之后利用残差块res优化特征并通过全局平均池化gap得到池化后的物体视觉特征向量其中上标vis表示语义特征,并选取google

‑

news数据集上预训练后的可公开使用的word2vec向量作为物体语义特征,针对每一个物体类别的标签可提取一个300维的语义特征向量其中上标sem表示语义特征;之后将物体的语义特征向量与视觉特征向量拼接后经过一个全连接层,最终获得1024维的物体特征向量f

o

;优选可公开使用的word2vec向量为至少1000亿个单词;

[0065]

对于共同区域的视觉特征,首先根据人和物体的边界框计算最小外接矩形,即两个边界框的并集区域b

union

,其中下标union表示人与物体并集,之后在卷积特征图上通过共同区域边界框坐标进行roi pooling操作规范化到7

×

7固定大小,之后经过残差块和全局平均池化提取得到2048维的视觉特征向量之后与成对支流输出的位置特征向量f

sp

硬连接,并送入全连接层得到1024维融合后的共同区域特征f

union

;

[0066]

最后将人体特征f

h

,物体特征f

o

和人和物体共同区域特征f

union

输入短期记忆选择模块,短期记忆选择模块由两个门控循环单元(gated recurrent unit,gru)单元组成,将共同区域特征f

union

作为短期记忆模块的初始状态,第一个gru单元输入为人的表征f

h

,第二个单元输入为物体的表征f

o

,最后经由短期记忆选择模块的输出状态得到表征f

hoi

,经过全连接层分类器和sigmoid函数得到短期记忆选择支流分类结果

[0067]

5)训练人物交互识别网络:

[0068]

三个支流共同构成整个人物交互识别网络,将训练集中的样本作为人物交互行为识别网络的输入,计算三支流的交叉熵损失函数之和,利用梯度下降法更新网络参数,直到优化达到最大次数,则终止训练,得到训练好的人物交互行为识别网络。

[0069]

在本实施例中,在所述步骤4中,检测待测图片中人物交互行为的检测过程为:

[0070]

针对待测图片先经过目标检测得到人与物体位置类别信息,之后将所有信息送入训练好的人物交互识别网络进行判断;采取先分类后融合的特征融合方式,即每个支流分别提取特征并进行检测分类,然后再对各支流分类结果分数进行融合得到最后的人物交互行为检测结果;然后针对每个人物对(b

h

,b

o

),人物交互检测最终得分计算公式如下:

[0071][0072]

其中s

h

,s

o

为目标检测结果人体和物体的置信度,为在a类交互行为分类任务中属于每一类别的概率得分向量,中的*表示不同的支流。

[0073]

本实施例基于多特征融合的图像中人物交互检测方法,利用目标检测算法检测出图片中所有实例信息,包括人体位置信息以及物体位置和类别信息等后,输入训练好的人物交互行为识别网络,检测待测图片中人物对之间的交互行为。本实施例利用位姿捕获交互关系的全局空间配置的基础上,关注于人与物体交集区域提供的有效信息,学习更加精细的局部特征,增加了正确人物交互对匹配的概率,并借助短期记忆选择模块对人和物体及其背景区域信息进行有效的筛选利用,通过各类特征的融合,提高了人物交互检测的精度。

[0074]

实施例三:

[0075]

本实施例与上述实施例基本相同,特别之处在于:

[0076]

在本实施例中,如图1所示,一种基于多特征融合的图像中人物交互检测方法,具体步骤如下:

[0077]

步骤1:对图片进行目标检测获取所有实例信息,包括人体位置信息以及物体位置和类别信息,并将人与物体组成<人

‑

物体>实例对输入人物交互识别网络进行人物交互检测。

[0078]

步骤2:构建人物交互识别网络,采用多支流神经网络结构对图片中<人

‑

物体>实例对各类特征进行学习,包括成对支流、交集支流和短期记忆选择支流,每个支流分别提取不同的特征信息以检测人物对之间的交互行为。下面结合附图2对本发明中人物交互识别网络的实现步骤做进一步的描述。

[0079]

1)使用resnet

‑

50对原始输入图片进行卷积特征提取,得到整张图片的全局卷积特征图f,与目标检测结果的人体位置b

h

、物体位置b

o

一起作为人物交互识别网络的输入;

[0080]

2)构建成对支流,具体为:

[0081]

2a)首先根据给定的人物边界框生成一幅具有两个通道的二进制图像:第一个通道在人边界框包围的像素处的值为1,在其他位置的值为0;第二个通道在由物体边界框包围的像素处的值为1,在其他位置为0。之后用一个与人与物体实例边界框组成的外接矩形同心的正方形剪取出人与物体的位置信息,舍弃其余无效信息,用于剪取的正方形边长等于外接矩形的最大边长,最后将形状为正方形的两通道二值图调整大小,得到一个固定尺度等于64

×

64的二值图b

h,o

;

[0082]

2b)将二进制图像b

h,o

输入包含两个卷积层两个池化层的浅层卷积神经网络,两个卷积层卷积核大小都是5

×

5,卷积核的数量分别为64和32,池化层均为最大池化。最后经过平铺位置特征图,得到位置特征向量f

sp

,之后将向量输入全连接层分类器和sigmoid函数得到位置特征支流在各交互类别上分类结果是所对应的交互类别,其中a是所有交互类别数。

[0083]

3)构建交集支流,具体为:

[0084]

3a)首先根据人边界框与物体边界框求取人物对交集框边框坐标b

inter

,计算表达式如下:

[0085][0086]

其中area()表示区域面积,且:

[0087][0088][0089][0090][0091]

之后利用roipooling在全局卷积特征图f上截取交集区域卷积特征,之后再利用残差块res优化特征并通过全局平均池化操作gap得到人物对交集区域特征f

inter

,公式表达式如下:

[0092]

f

inter

=gap(res

inter

(roi(f,b

inter

)))

[0093]

3b)对图片人体关键点检测结果进行编码,利用人体关键点检测网络对图片进行位姿估计得到人体关键点向量其中是第k个人体关键点坐标,k=17为提取的关键点总数。之后将位姿估计结果的十七个关节点进行编码,在每个人物对的最小外接矩形框中,模型对不同关节点之间按coco数据集提供的骨架模型,如图3所示,用不同灰度值的连线连接,这些灰度值从0.15到0.95的不同的连线表征了身体的不同部位,例如用灰度值为0.5的连线连接左手肘与左手腕用于表征左大臂。矩形框内其余区域像素值都设为0,并且将矩形框调整至一个固定尺度64

×

64,得到位姿特征图。最后通过两个卷积池化层提取位姿特征f

pose

,两个卷积层卷积核大小都是5

×

5,两层卷积层卷积核数量分别为32和16,池化层均采用最大池化。

[0094]

3c)将交集区域特征f

inter

与位姿特征f

pose

进行拼接并通过两个全连接层进行特征融合得到f

inter

‑

pose

,公式表达式如下:

[0095][0096]

其中代表特征向量的硬连接(concatenate),w

inter

为投影矩阵。最终融合后的特征f

inter

‑

pose

经过全连接层分类器,和sigmoid函数得到交集特征支流a维分类结果

[0097]

4)构建短期记忆选择支流,具体为:

[0098]

4a)根据人体位置坐标b

h

在全局卷积特征图f上进行roipooling操作提取人体区域特征,之后再利用残差块res优化特征并通过全局平均池化gap得到池化后的人体特征向量f

h

,过程用公式描述如下:

[0099]

f

h

=gap(res

h

(roi(f,b

h

)))

[0100]

4b)根据物体位置坐标b

o

在全局卷积特征图f上进行roipooling操作提取物体区域特征,之后利用残差块res优化特征并通过全局平均池化gap得到池化后的物体视觉特征向量过程用公式描述如下:

[0101][0102]

利用google

‑

news数据集上预训练后的可公开使用的word2vec向量提取物体语义特征,针对每一个物体类别的标签可提取一个300维的语义特征向量之后将物体的语义特征向量与视觉特征向量拼接后经过一个全连接层,最终获得1024维的物体特征向量f

o

。

[0103]

4c)对于共同区域的视觉特征,首先根据人和物体的边界框计算最小外接矩形,即两个边界框的并集区域,之后在卷积特征图上通过共同区域边界框坐标b

union

进行roi pooling操作规范化到7

×

7固定大小,并经过残差块和全局平均池化提取得到2048维的视觉特征向量过程用公式描述如下:

[0104][0105]

之后与成对支流输出的位置特征向量f

sp

硬连接,并送入全连接层得到1024维融合后的共同区域特征f

union

。公式表达式如下:

[0106][0107]

其中代表特征向量的硬连接(concatenate),w

union

为投影矩阵。

[0108]

4d)将提取的人体特征f

h

,物体特征f

o

和人物共同区域特征f

union

输入短期记忆选择模块进行特征融合。短期记忆选择模块由两个gru单元组成,其参数更新公式如下:

[0109]

z

t

=σ(w

z

x

t

+u

z

h

t

‑1+b

z

)

[0110][0111]

r

t

=σ(w

r

x

t

+u

r

h

t

‑1+b

r

)

[0112][0113]

其中,x

t

为第t个gru单元的输入,t分别为1和2。gru网络在存储单元h

t

(隐藏状态)中累积和更新。z

t

为更新门门控信号,w

z

,u

z

为更新门z

t

权重矩阵,b

z

为更新门z

t

偏置向量,σ(

·

)是sigmoid激活函数。表示候选状态,w

h

,u

h

为候选状态权重矩阵,b

h

为候选状态偏置向量,

⊙

表示元素对应乘积。r

t

为重置门门门控信号,w

r

,u

r

为重置门r

t

权重矩阵,b

r

为重置门r

t

偏置向量。短期记忆模块的初始状态为人和物体共同区域特征即h0=f

union

,第一个gru单元输入为人的表征即x1=f

h

,第二个单元输入为物体的表征x2=f

o

,最后输出状态h2作为hoi

的表征f

hoi

,经过输出维度为所有hoi类别数a的全连接层进行分类和sigmoid函数得到分类结果

[0114]

5)训练人物交互识别网络,神经网络训练的目标是最小化真实标签和预测标签之间的损失函数,针对训练集中所有样本,计算每一支流预测结果y

i

与真实标签a

i

之间的交叉熵损失函数,计算公式如下:

[0115][0116]

整个交互识别网络的损失函数为各支流损失函数之和,包括成对支流分类损失loss

sp

、交集支流分类损失loss

inter

和短期记忆选择支流分类损失loss

stms

,计算公式如下:

[0117]

loss

hoi

=λ1*loss

stms

+λ2*loss

sp

+loss

inter

[0118]

为了平衡不同支流的贡献能力的不同,使用不同的权重系数λ1=2,λ2=0.5对各分支损失进行加权。训练过程中采用带有动量的随机梯度下降法更新网络参数,直到优化达到最大次数,则终止训练,得到最终训练好的人物交互行为识别网络。

[0119]

步骤3:检测待测图片中的人物交互行为,先将待测图片经过步骤1目标检测得到人与物体位置类别信息,之后将所有信息送入训练好的人物交互识别网络进行判断。本发明采取先分类后融合的特征融合方式,即每个支流分别提取特征并进行检测分类,最后再对各支流分类结果分数进行融合得到最后的人物交互行为检测结果。最终针对每个人物对(b

h

,b

o

),人物交互检测最终得分计算公式如下:

[0120][0121]

其中s

h

,s

o

为目标检测结果人体和物体的置信度,为在a类交互行为分类任务中属于每一类别的概率得分向量,中的*表示不同的支流。

[0122]

本实施例利用多特征的充分融合来提升人物交互行为检测精度,通过关注人体位姿信息,与交集区域特征进行有效融合,在捕获全局空间配置的基础上融合细节信息,使网络学习更多局部细节信息,建立了人与物体的关联,特征区分更加明显,增加了正确人物交互对匹配的概率,从而提高整体分类准确率;同时通过短期记忆选择模块对人和物体及其共同区域特征进行充分筛选,有效利用背景信息,进一步提高了人物交互检测的平均精度。

[0123]

上面对本发明实施例结合附图进行了说明,但本发明不限于上述实施例,还可以根据本发明的目的做出多种变化,凡依据本发明技术方案的精神实质和原理下做的改变、修饰、替代、组合或简化,均应为等效的置换方式,只要符合本发明的发明目的,只要不背离本发明的技术原理和发明构思,都属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1