婴幼儿眼底视网膜全景影像生成采集反馈方法及系统

1.本发明涉及图像拼接融合领域,更具体地,涉及一种婴幼儿眼底视网膜全景影像生成采集反馈方法及系统。

背景技术:

2.近年来,国家对于儿童视力情况的关注不断加强,2021年6月24日,国家卫生健康委办公厅发布了《0~6岁儿童眼保健及视力检查服务规范(试行)》,目的是进一步规范0~6岁儿童眼保健及视力检查服务,早期发现儿童常见眼病、视力不良及远视储备量不足,及时转诊干预,减少和控制儿童可控性眼病及视力不良的发展;其中对于婴幼儿眼底影像的检查是确认幼儿眼底视网膜健康情况的必须环节,尤其是早产儿以及低体重儿,是规定必须要做的检查内容之一。

3.随着数字成像技术的发展,幼儿眼底检查手段从直接镜/间接镜到目前应用最普遍的数字广角眼底成像设备如retcam成像系统,单张影像最高可达130

°

的视野范围。然而即便如此,对于整个视网膜而言也还是远远不够的,眼科医生在检查婴幼儿的时候,仍需要手持设备拍摄多达几十张的影像来确保完整的检查到整个视网膜区域。眼科医生在采集到数据后,需要对多个方位的数据进行遍历检查才能确定检查结果,而且在数据采集过程中由于缺少拍摄影像的方位提示,常常会重复采集方位数据或缺少部分方位数据的情况。因此,能够实现对多方位影像的快速拼接、展示以及提示范围的功能对于辅助眼科医生快速采集影像数据和评估已采集数据质量是很有必要的。然而目前市场上和业界还没有相关产品和研究工作,已有的工作几乎都集中于成人眼底影像的拼接方法,而且绝大多数是两张影像的匹配拼接和融合工作。专利(102908120a,106846293a,107564048a,108198211a,109658393a,112435281a)通过首先对血管进行分割,之后利用分割血管的结果提取其特征进行匹配,以此来确定两幅图像之间的配准变换关系;专利(101593351a,109744996a)利用血管以外的标志物如视盘进行刚性变换的参数计算,获得图像间刚性变换所需的单映矩阵后实现配准;专利(109767459a,110544274a)使用深度学习方法建模,对两幅图像之间的形变场进行预测,通过形变场可以将浮动图转换到目标图的位置上,实现配准功能;专利(108022228a,112164043a)基于传统特征点及其对应的局部特征来进行点配对,再经过配对点筛选后得到可靠的特征点配对关系,结合图像融合的方法如像素最大值或拼接缝加权等方式得到两张或多张眼底影像的拼接大图。

4.现有方法还存在几个问题:(1)现有已发表工作绝大多数集中于解决预测两张图象之间的配准关系以及对应的重合区域融合,然而对于配准方法的后续应用或者是多张图像之间的持续配准工作没有提及和进一步研究;(2)极少数工作提及能够实现多张图像的拼接和融合,而且其流程是高度相似的,都是基于特征点检测以然后提取其局部特征信息,再通过匹配筛选和变换矩阵估计来实现配准结果(然而在本发明的部分流程中使用了传统配准方法,并且显示其配准结果不稳定);(3)部分基于深度学习建模的工作需要额外的数据标注工作,多数工作都需要利用血管、视盘等标志物的信息标注来训练一个标志物分割

模型,这增加了建模的成本;(4)部分基于深度学习建模预测形变场的方法,只适用于预测图像对之间偏移量较小的情况,需要足够的重合区域进行像素拟合和形变估计,如果偏移量过大,形变场预测的效果会变差;(5)以上的工作影像都是基于成人的眼底影像,这类影像相比婴幼儿影像数据有视野范围小、血管密度高以及清晰度高几乎无噪声和噪点的特点,这使得之前的工作和方法在婴幼儿眼底影像中的效果会下降(婴幼儿眼底方位影像通常有大片的无血管区,使得在上述方法中无法进行特征对齐),即目前还没有专门针对婴幼儿影像的多影像拼接融合方法,现有所有方法只能输出配准结果或预测配准后的信息,缺少对本次配准结果的评估,结果评估只能是人工观察主观评价。

技术实现要素:

5.本发明的首要目的是提供一种婴幼儿眼底视网膜全景影像生成采集反馈方法,利用深度学习技术实现了配准模型和融合模型的建模设计和训练流程,实现婴幼儿眼底影像的拼接融合

6.本发明的进一步目的是提供一种婴幼儿眼底视网膜全景影像生成采集反馈系统。

7.为解决上述技术问题,本发明的技术方案如下:

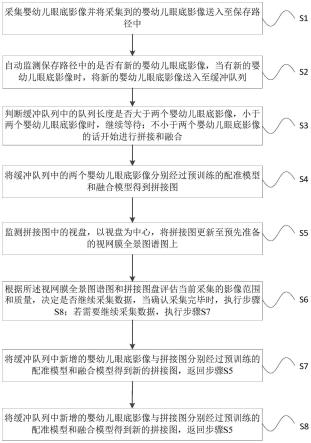

8.一种婴幼儿眼底视网膜全景影像生成采集反馈方法,包括以下步骤:

9.s1:采集婴幼儿眼底影像并将采集到的婴幼儿眼底影像送入至保存路径中;

10.s2:自动监测保存路径中的是否有新的婴幼儿眼底影像,当有新的婴幼儿眼底影像时,将新的婴幼儿眼底影像送入至缓冲队列;

11.s3:判断缓冲队列中的队列长度是否大于两个婴幼儿眼底影像,小于两个婴幼儿眼底影像时,继续等待;不小于两个婴幼儿眼底影像的话开始进行拼接和融合;

12.s4:将缓冲队列中的两个婴幼儿眼底影像分别经过预训练的配准模型和融合模型得到拼接图;

13.s5:监测拼接图中的视盘,以视盘为中心,将拼接图更新至预先准备的视网膜全景图谱图上;

14.s6:根据所述视网膜全景图谱图和拼接图盘评估当前采集的影像范围和质量,决定是否继续采集数据,当确认采集完毕时,执行步骤s8;若需要继续采集数据,执行步骤s7:

15.s7:将缓冲队列中新增的婴幼儿眼底影像与拼接图分别经过预训练的配准模型和融合模型得到新的拼接图,返回步骤s5;

16.s8:输出当前的拼接图作为全景视网膜影像结果。

17.优选地,所述步骤s4中配准模型基于深度学习建模,利用通过自动配准生成的训练数据,结合了栅格点偏移估计、单映矩阵估计以及刚性变换对配准模型进行监督训练,在训练时还进行随机增强操作。

18.优选地,所述通过自动配准生成的训练数据,具体包括以下步骤:

19.s401:导出大量的以病例id和拍摄数据序号为文件名的图像文件,按照病例id进行分组;

20.s402:对每一组内的图像文件进行两两组合,进行配准操作并评估配准效果;

21.s403:将配准效果为可靠的集合作为训练数据,配准效果为不可靠的集合作为验证数据。

22.优选地,所述步骤s402中对每一组内的图像文件进行两两组合,进行配准操作,具体为:

23.s4021:对于两两组合的图像a和图像b,遍历检索图像a和图像b中的关键点集合ka和kb;

24.s4022:对集合ka和kb中的点的局部进行特征统计,得到每个特征点对应的局部特征向量集合fa和fb;

25.s4023:对两个局部特征向量集合fa和fb中的两两向量计算欧式距离,遍历检索从集合fa中到集合fb中所有最短的距离配对,再以同样的方式遍历检索从集合fb中到集合fa中所有最短的距离配对,两次配对中筛选重复的配对,完成交叉验证,得到粗匹配特征点对pps;

26.s4024:利用配对筛选算法对粗匹配特征点对pps进一步筛选出可靠配对ppsr。

27.优选地,所述步骤s402中评估配准效果,具体为:

28.s4025:对得到的可靠配对ppsr统计其点对数量nps,分别统计每个配对点在x和y方向上的偏移距离lx和ly以及对应的所有点在x和y方向的平均偏移距离lax和lay,同时设置配对点数量阈值nlevel和两个方向上的位移离群点阈值xlevel、ylevel,具体判定方式为:

29.只有当nps《nlevel且所有的lx和ly分别跟lax和lay都是同向的情况就是可靠配准,其余为不可靠配准,同向指同时是正数或同时负数。

30.优选地,所述配准模型的训练过程,具体为:

31.s411:通过配准操作生成的训练数据为成对的影像数据和对应的匹配点对关系信息,其配对点关系信息为ina-b,即图像a中的特征点坐标对应在图像b中的坐标信息,可拆分为pas和pbs,通过阈值分割获取图像a和图像b的通用视野范围掩膜m;

32.s412:利用随机变换矩阵hr对图像b及其配对点pbs进行随机角度、随机尺度以及x、y方向上随机偏移的处理,利用此时的转换后的配对点rpbs和pas,通过svd奇异值分解的方式可以求得由变换后图像rb向图像a进行配准的转换矩阵hrba,利用转换矩阵hrba对掩膜m进行转换后得到转换后的目标掩膜mb;

33.s413:在图像a中按照设置好的栅格数目进行均匀取点,得到栅格点坐标集合gas,利用pas和pbs进行svd求解,得到由图像a向图像b左边转换的转换矩阵hba,利用hba得到栅格点集合gas对应在图像b中的点集合gbs,再根据随机变换矩阵hr,再次对点集合gbs进行同样的转换得到转换图像b对应的栅格点集合rgbs,其中点集合rgbs中的坐标是每一个点集合gbs中的坐标利用随机变换矩阵hr转换过来;

34.s414:利用上述流程中的点集合rgbs和点集合gas,两个集合中的坐标是一一对应的,逐元素相减得到由n个坐标对的偏移位移组成的集合offs{[dx1,dy1],[dx2,dy2],

…

,[dxn,dyn]};

[0035]

s415:将转换矩阵hrba、目标掩膜mb、集合offs作为配准模型的训练标签,训练损失包括计算回归误差的损失函数和重合区域计算损失,分别选择smooth-l1 loss损失和dice loss损失两种,具体对应关系是smooth-l1 loss来约束配准模型对转换矩阵和偏移量的预测估计与标签的误差,dice loss用来约束训练配准模型对转换后的掩膜预测结果;

[0036]

s416:训练过程中利用对配准模型预测的栅格点偏移量添加随机噪声的方式来生

成不可靠预测结果,所述随机噪声是跟预测的栅格点偏移量同尺寸的符合标准正态分布的一组随机数组成的张量矩阵,随机50%的概率整体取负,原先不加入噪声的预测作为可靠预测结果,可靠和不可靠对应的评分标签分别为1和0,利用上述的回归误差的损失函数进行监督约束;利用若干层卷积作为评分估计模块对对配准模型预测的栅格点偏移量结果进行预测评分,评分模块需要利用配准模型预测的栅格点偏移量之间的影像特征图和预测偏移量进行拼接成一个张量矩阵后送入评分模块进行评分预测,训练后得到训练好的配准模型。

[0037]

优选地,所述步骤s412中随机变换矩阵hr,具体为:

[0038][0039]

式中,s作为随机尺度变换因子,lx和ly是随机偏移量,θ是随机旋转角度,s、lx、ly、θ有各自的取值范围,在使用中会随机在各自的取值范围内进行随机取值。

[0040]

优选地,所述步骤s415中smooth-l1 loss损失和dice loss损失,具体为:

[0041]

smooth-l1 loss是基于l1 loss而来,具体定义为:

[0042]

l1loss=|f(x)-y|

[0043][0044]

其中,f(x)是预测结果,y是标签数据,l1是l1loss;

[0045][0046]

其中,f(x)是预测结果,y是标签数据。

[0047]

优选地,所述步骤s4中融合模型的训练过程,具体为:

[0048]

s421:对于眼底方位图像i,首先分别随机截取两个图像i中的范围ia和ib,计算截取两个范围的重合度,以iou来计算,即统计两个区域的交集和并集之比,如果满足预先设定的重合限定范围[nl,nh],将ia和ib分别放置到与i具有相同尺寸的纯黑色背景图中,使得最终ia,ib和图像i具有相同的分辨率尺寸,如不满足重合范围就重复随机截取,直到满足为止;

[0049]

s422:对上述得到的ia和ib进行随机图像增强,具体为随机亮度、对比度和hsv颜色转换后随机饱和度改变,随后利用ia和ib的范围并集,对原图像i进行roi感兴趣区域扣取,并集以外的区域填充为像素0,以此作为ia和ib的真实融合图像;

[0050]

s423:将上述增强后ia和ib送入融合模型,根据模型预测结果和所述真实融合图像进行模型的训练,基于纹理、内容、风格感知这三个模块进行监督和约束模型,具体方法为:

[0051]

纹理特征提取,分别对预测结果i-pred和真实融合图像进行一个卷积操作,具体是利用卷积核ch对二者进行遍历滤波卷积操作得到纹理增强后的图像如图,再利用smooth-l1 loss计算纹理特征误差;

[0052]

对于内容约束,直接利用smooth-l1 loss计算预测结果i-pred和真实融合图之间的差异;

[0053]

对于风格感知约束,利用相同的固定权重的编码网络对i-pred和真实融合图进行

编码,首先利用编码网络得到i-pred的多层输出特征图组成特征图组1,然后用相同的方法得到真实融合图的特征图组2,利用两个特征图组计算对应的gram矩阵,得到两个组中对应每个特征图对的相关性,具体是预测图和真实图经过模型计算分别得到多个特征图,大小为n*c*h*w,对每个特征图,计算其gram矩阵:

[0054]

gf=f

tf[0055]

分别由预测图和真实图得到的两组特征图gram矩阵彼此间进行计算欧氏距离,得到的所有距离进行求和再取平均值作为风格感知差异来约束;

[0056]

基于上述三个约束来训练融合模型,得到训练好的融合模型。

[0057]

一种婴幼儿眼底视网膜全景影像生成采集反馈系统,包括:

[0058]

采集模块,所述采集模块用于采集婴幼儿眼底影像并将采集到的婴幼儿眼底影像送入至保存路径中;

[0059]

传输模块,所述传输模块用于自动监测保存路径中的是否有新的婴幼儿眼底影像,当有新的婴幼儿眼底影像时,将新的婴幼儿眼底影像送入至缓冲队列;

[0060]

缓冲队列判断模块,所述缓冲队列判断模块用于判断缓冲队列中的队列长度是否大于两个婴幼儿眼底影像,小于两个婴幼儿眼底影像时,继续等待;不小于两个婴幼儿眼底影像的话开始进行拼接和融合;

[0061]

第一拼接融合模块,所述拼接融合模块用于将缓冲队列中的两个婴幼儿眼底影像分别经过预训练的配准模型和融合模型得到拼接图;

[0062]

图谱更新模块,所述图谱更新模块用于监测拼接图中的视盘,以视盘为中心,将拼接图更新至预先准备的视网膜全景图谱图上;

[0063]

评估模块,所述评估模块根据所述视网膜全景图谱图和拼接图盘评估当前采集的影像范围和质量,决定是否继续采集数据,当确认采集完毕时,进入输出模块;若需要继续采集数据,则进入第二拼接融合模块;

[0064]

第二拼接融合模块,所述第二拼接融合模块将缓冲队列中新增的婴幼儿眼底影像与拼接图分别经过预训练的配准模型和融合模型得到新的拼接图,返回图谱更新模块;

[0065]

输出模块,所述输出模块输出当前的拼接图作为全景视网膜影像结果。

[0066]

与现有技术相比,本发明技术方案的有益效果是:

[0067]

(1)本发明在建模图像拼接模型和融合模型的基础上,实现对婴幼儿眼底影像的多图像持续拼接和融合流程,能够在数据采集过程中监测到新的数据后实时更新结果;

[0068]

(2)本发明相比传统配准方法基础上的多图像拼接流程,在拼接的稳定性和速度上均优于之前的方法;

[0069]

(3)本发明的配准和融合两个模型不需要额外的人工进行标注工作,配准模型的训练数据可以自动生成,融合模型的训练是一个自监督训练的范畴;

[0070]

(4)本发明能适应多种情况下的图像配准和拼接条件,对于偏移距离较大的情况也能够兼容,除了偏移距离,本方法对于较大尺度缩放和角度旋转也有良好的匹配效果;

[0071]

(5)本发明在婴幼儿眼底数据上进行建模,能适应该类型数据的特点,由于不需要人工的标注工作,在成人眼底数据中同样可以进行训练和后续的部署,方法具有通用性,不只局限于婴幼儿的影像数据。

[0072]

(6)本发明利用自监督训练方法,利用随机噪声增强的方式实现对配准结果的评

分。

附图说明

[0073]

图1为本发明的方法流程示意图。

[0074]

图2为本发明的训练数据生成流程示意图。

[0075]

图3为本发明的配准模型的训练过程示意图。

[0076]

图4为本发明的融合模型的训练过程示意图。

[0077]

图5(a)为训练集中图像a和图像b,图5(b)为实施例提供的通用掩膜m的示意图。

[0078]

图6(a)为训练集中图像a和图像b的栅格点示意图,图6(b)为随机变换后的图rb和rgbs,图(c)为两个集合中栅格点的对应关系示意图。

[0079]

图7(a)为配准差的预测偏移量估计连线示意,图7(b)为配准差的预测配准评分示意图,图7(c)为配准优的预测偏移量估计连线示意,图7(d)为配准优的预测配准评分示意图。

[0080]

图8(a)为眼底方位图像i,图8(b)为截取两个图像i中的范围ia和ib,图8(c)为范围ia和ib的真实融合图,图8(d)为测试图ia、ib,图8(e)为测试图ia、ib对应的预测融合图。

[0081]

图9为视网膜全景影像图谱示意图。

[0082]

图10为实施例提供的采集过程中持续配准的视网膜拼接影像展示以及对应的采集范围提示和未采集范围提示示意图。

[0083]

图11为本发明的系统模块示意图。

具体实施方式

[0084]

附图仅用于示例性说明,不能理解为对本专利的限制;

[0085]

为了更好说明本实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;

[0086]

对于本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

[0087]

下面结合附图和实施例对本发明的技术方案做进一步的说明。

[0088]

实施例1

[0089]

本实施例提供一种婴幼儿眼底视网膜全景影像生成采集反馈方法,如图1所示,包括以下步骤:

[0090]

s1:采集婴幼儿眼底影像并将采集到的婴幼儿眼底影像送入至保存路径中;

[0091]

s2:自动监测保存路径中的是否有新的婴幼儿眼底影像,当有新的婴幼儿眼底影像时,将新的婴幼儿眼底影像送入至缓冲队列;

[0092]

s3:判断缓冲队列中的队列长度是否大于两个婴幼儿眼底影像,小于两个婴幼儿眼底影像时,继续等待;不小于两个婴幼儿眼底影像的话开始进行拼接和融合;

[0093]

s4:将缓冲队列中的两个婴幼儿眼底影像分别经过预训练的配准模型和融合模型得到拼接图;

[0094]

s5:监测拼接图中的视盘,以视盘为中心,将拼接图更新至预先准备的视网膜全景图谱图上;

[0095]

s6:根据所述视网膜全景图谱图和拼接图盘评估当前采集的影像范围和质量,决定是否继续采集数据,当确认采集完毕时,执行步骤s8;若需要继续采集数据,执行步骤s7:

[0096]

s7:将缓冲队列中新增的婴幼儿眼底影像与拼接图分别经过预训练的配准模型和融合模型得到新的拼接图,返回步骤s5;

[0097]

s8:输出当前的拼接图作为全景视网膜影像结果。

[0098]

在具体实施过程中,本实施例提出一套应用于婴幼儿眼底影像的拼接融合方法,利用深度学习技术分别实现了配准模型和融合模型的建模设计和训练流程。通过实现影像文件监测,多图像持续配准,多图像持续融合以及全景影像图谱提示等模块功能。

[0099]

实施例2

[0100]

本实施例在实施例1的基础上,提供配准模块的训练过程:

[0101]

所述步骤s4中配准模型基于深度学习建模,利用通过自动配准生成的训练数据,结合了栅格点偏移估计、单映矩阵估计以及刚性变换对配准模型进行监督训练,在训练时还进行随机增强操作。

[0102]

所述通过自动配准生成的训练数据,如图2所示,具体包括以下步骤:

[0103]

s401:以retcam系统为例,导出大量的以病例id和拍摄数据序号为文件名的图像文件,按照病例id进行分组;

[0104]

s402:对每一组内的图像文件进行两两组合,进行配准操作并评估配准效果;

[0105]

s403:将配准效果为可靠的集合作为训练数据,配准效果为不可靠的集合作为验证数据。

[0106]

所述步骤s402中对每一组内的图像文件进行两两组合,进行配准操作,具体为:

[0107]

s4021:对于两两组合的图像a和图像b,遍历检索图像a和图像b中的关键点集合ka和kb,具体方法为传统配准领域常用的特征点检测方法如sift或surf特征点检测;

[0108]

s4022:对集合ka和kb中的点的局部进行特征统计,得到每个特征点对应的局部特征向量集合fa和fb,具体方法为传统配准领域内常用的领域特征统计如sift或surf中的特征描述符计算方法;

[0109]

s4023:对两个局部特征向量集合fa和fb中的两两向量计算欧式距离,遍历检索从集合fa中到集合fb中所有最短的距离配对,再以同样的方式遍历检索从集合fb中到集合fa中所有最短的距离配对,两次配对中筛选重复的配对,完成交叉验证,得到粗匹配特征点对pps;

[0110]

s4024:利用传统配准领域常用的配对筛选算法如ransac(随机抽取一致性)对粗匹配特征点对pps进一步筛选出可靠配对ppsr。

[0111]

所述步骤s402中评估配准效果,具体为:

[0112]

s4025:对得到的可靠配对ppsr统计其点对数量nps,分别统计每个配对点在x和y方向上的偏移距离lx和ly以及对应的所有点在x和y方向的平均偏移距离lax和lay,同时设置配对点数量阈值nlevel和两个方向上的位移离群点阈值xlevel、ylevel,具体判定方式为:

[0113]

只有当nps《nlevel且所有的lx和ly分别跟lax和lay都是同向的情况就是可靠配准,其余为不可靠配准,同向指同时是正数或同时负数。

[0114]

基于以上流程将眼底影像数据两两配对,并且得到每一对图像的可靠配对点集合

作为训练数据,此外不可靠的图像对可作为测试验证数据。在本实施例中,整理了2160张图像,经id分组后分为101组,然后两两配对总共生成57360组配对,最终经筛选后可靠配对数量有19413,不可靠配对数量有37947组,同时也验证了传统配准方法效果不够稳定,不可靠配对数量远多于可靠配对

[0115]

所述配准模型的训练过程,如图3所示,具体为:

[0116]

s411:通过配准操作生成的训练数据为成对的影像数据和对应的匹配点对关系信息,其配对点关系信息为ina-b,即图像a中的特征点坐标对应在图像b中的坐标信息,可拆分为pas和pbs,通过阈值分割获取图像a和图像b的通用视野范围掩膜m,如图5所示;

[0117]

s412:利用随机变换矩阵hr对图像b及其配对点pbs进行随机角度、随机尺度以及x、y方向上随机偏移的处理,利用此时的转换后的配对点rpbs和pas,通过svd奇异值分解的方式可以求得由变换后图像rb向图像a进行配准的转换矩阵hrba,利用转换矩阵hrba对掩膜m进行转换后得到转换后的目标掩膜mb;

[0118]

s413:由于每个训练数据中的匹配点数目是不一致的,不适合建模估计,因此利用栅格均匀取点的方式来生成偏移量估计训练数据,具体做法是:在图像a中按照设置好的栅格数目(如8*8,16*16,32*32等)进行均匀取点,得到栅格点坐标集合gas,利用pas和pbs进行svd求解,得到由图像a向图像b左边转换的转换矩阵hba,利用hba得到栅格点集合gas对应在图像b中的点集合gbs,再根据随机变换矩阵hr,再次对点集合gbs进行同样的转换得到转换图像b对应的栅格点集合rgbs,其中点集合rgbs中的坐标是每一个点集合gbs中的坐标利用随机变换矩阵hr转换过来,如图6(a)至图6(c)所示;

[0119]

s415:将转换矩阵hrba、目标掩膜mb、集合offs作为配准模型的训练标签,训练损失包括计算回归误差的损失函数和重合区域计算损失,分别选择smooth-l1 loss损失和dice loss损失两种,具体对应关系是smooth-l1 loss来约束配准模型对转换矩阵和偏移量的预测估计与标签的误差,dice loss用来约束训练配准模型对转换后的掩膜预测结果;

[0120]

计算回归误差的损失函数不限于常见的数值回归预测约束损失如l1 loss、smooth-l1 loss、mseloss、huber loss等回归损失;重合区域计算损失不限于常见的区域重合度约束损失或分割损失如iouloss、diceloss、bceloss等。

[0121]

s416:训练过程中利用对配准模型预测的栅格点偏移量添加随机噪声的方式来生成不可靠预测结果,所述随机噪声是跟预测的栅格点偏移量同尺寸的符合标准正态分布的一组随机数组成的张量矩阵,随机50%的概率整体取负,原先不加入噪声的预测作为可靠预测结果,可靠和不可靠对应的评分标签分别为1和0,利用上述的回归误差的损失函数进行监督约束;利用若干层卷积作为评分估计模块对对配准模型预测的栅格点偏移量结果进行预测评分,评分模块需要利用配准模型预测的栅格点偏移量之间的影像特征图和预测偏移量进行拼接成一个张量矩阵后送入评分模块进行评分预测,训练后得到训练好的配准模型。

[0122]

所述步骤s412中随机变换矩阵hr,具体为:

[0123][0124]

式中,s作为随机尺度变换因子,lx和ly是随机偏移量,θ是随机旋转角度,s、lx、

ly、θ有各自的取值范围,在使用中会随机在各自的取值范围内进行随机取值。

[0125]

所述步骤s415中smooth-l1 loss损失和dice loss损失,具体为:

[0126]

smooth-l1 loss是基于l1 loss而来,具体定义为:

[0127]

l1loss=|f(x)-y|

[0128][0129]

其中,f(x)是预测结果,y是标签数据,l1是l1loss;

[0130][0131]

其中,f(x)是预测结果,y是标签数据。

[0132]

实施例3

[0133]

本实施例在实施例1和2的基础上,提供融合模型的训练过程。

[0134]

所述步骤s4中融合模型的训练过程,如图4所示,具体为:

[0135]

s421:对于眼底方位图像i,如图8(a)所示,首先分别随机截取两个图像i中的范围ia和ib,如图8(b)所示,计算截取两个范围的重合度,以iou来计算,即统计两个区域的交集和并集之比,如果满足预先设定的重合限定范围[nl,nh],将ia和ib分别放置到与i具有相同尺寸的纯黑色背景图中,使得最终ia,ib和图像i具有相同的分辨率尺寸,如不满足重合范围就重复随机截取,直到满足为止;

[0136]

s422:对上述得到的ia和ib进行随机图像增强,具体为随机亮度、对比度和hsv颜色转换后随机饱和度改变,随后利用ia和ib的范围并集,对原图像i进行roi感兴趣区域扣取,并集以外的区域填充为像素0,以此作为ia和ib的真实融合图像,如图8(c)所示;

[0137]

s423:将上述增强后ia和ib送入融合模型,根据模型预测结果和所述真实融合图像进行模型的训练,基于纹理、内容、风格感知这三个模块进行监督和约束模型,具体方法为:

[0138]

纹理特征提取,分别对预测结果i-pred和真实融合图像进行一个卷积操作,具体是利用卷积核ch对二者进行遍历滤波卷积操作得到纹理增强后的图像如图,再利用smooth-l1 loss计算纹理特征误差;

[0139]

对于内容约束,直接利用smooth-l1 loss计算预测结果i-pred和真实融合图之间的差异;

[0140]

对于风格感知约束,利用相同的固定权重的编码网络对i-pred和真实融合图进行编码,首先利用编码网络得到i-pred的多层输出特征图组成特征图组1,然后用相同的方法得到真实融合图的特征图组2,利用两个特征图组计算对应的gram矩阵,得到两个组中对应每个特征图对的相关性,具体是预测图和真实图经过模型计算分别得到多个特征图,大小为n*c*h*w,对每个特征图,计算其gram矩阵:

[0141]

gf=f

tf[0142]

分别由预测图和真实图得到的两组特征图gram矩阵彼此间进行计算欧氏距离,得到的所有距离进行求和再取平均值作为风格感知差异来约束;

[0143]

基于上述三个约束来训练融合模型,得到训练好的融合模型。

[0144]

利用图8(d)中的测试图ia、ib输入训练好的融合模型,融合模型输出的预测融合

图如图8(e)所示。

[0145]

实施例4

[0146]

本实施例提供一种婴幼儿眼底视网膜全景影像生成采集反馈系统,如图11所示,包括:

[0147]

采集模块,所述采集模块用于采集婴幼儿眼底影像并将采集到的婴幼儿眼底影像送入至保存路径中;

[0148]

传输模块,所述传输模块用于自动监测保存路径中的是否有新的婴幼儿眼底影像,当有新的婴幼儿眼底影像时,将新的婴幼儿眼底影像送入至缓冲队列;

[0149]

缓冲队列判断模块,所述缓冲队列判断模块用于判断缓冲队列中的队列长度是否大于两个婴幼儿眼底影像,小于两个婴幼儿眼底影像时,继续等待;不小于两个婴幼儿眼底影像的话开始进行拼接和融合;

[0150]

第一拼接融合模块,所述拼接融合模块用于将缓冲队列中的两个婴幼儿眼底影像分别经过预训练的配准模型和融合模型得到拼接图;

[0151]

图谱更新模块,所述图谱更新模块用于监测拼接图中的视盘,以视盘为中心,将拼接图更新至预先准备的视网膜全景图谱图上,如图9至图10所示;

[0152]

评估模块,所述评估模块根据所述视网膜全景图谱图和拼接图盘评估当前采集的影像范围和质量,决定是否继续采集数据,当确认采集完毕时,进入输出模块;若需要继续采集数据,则进入第二拼接融合模块;

[0153]

第二拼接融合模块,所述第二拼接融合模块将缓冲队列中新增的婴幼儿眼底影像与拼接图分别经过预训练的配准模型和融合模型得到新的拼接图,返回图谱更新模块;

[0154]

输出模块,所述输出模块输出当前的拼接图作为全景视网膜影像结果。

[0155]

采集模块主要是摄像头硬件,通过广角摄像头可以用来拍摄方位眼底影像;

[0156]

采集到的数据会保存至数据存储设备(硬盘)中,以唯一id进行图像文件命名并保存在设置好的文件夹中;

[0157]

数据传输和运算处理设备主要由网线和高性能计算机主机组成,首先通过网线获取存储设备中的保存图像文件,监测文件夹情况,当有新的影像文件生成就通过该连接抓取文件到高性能主机中,存入待处理缓冲图像序列中,随后配准和融合处理模块对其进行持续处理直到缓冲队列中的图像处理完毕;

[0158]

持续更新结果到显示设备中,采集人员可以通过显示设备直观且实时地判断已经采集到的数据质量情况,包括不只限于视野范围、影像质量等。

[0159]

相同或相似的标号对应相同或相似的部件;

[0160]

附图中描述位置关系的用语仅用于示例性说明,不能理解为对本专利的限制;

[0161]

显然,本发明的上述实施例仅仅是为清楚地说明本发明所作的举例,而并非是对本发明的实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明权利要求的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1