一种面向新生儿的视觉心率估计方法、装置及系统

1.本发明涉及心率检测技术领域,特别是涉及一种面向新生儿的视觉心率估计方法、装置及系统。

背景技术:

2.心率测量是指检测人体在安静状态下每分钟心跳的次数,是现代医学的重要人体检测手段之一。心率的高低可以反映人体的健康状态,很多疾病都会引起心率的异常,所以心率测量是判断人体状况的必要手段之一。

3.据世界卫生组织(worldhealth organization,who)2020年9月报道可知,5周岁以下的死亡儿童中,有接近3/4的婴儿是死于他们出生后的一周内。从这些数据中可以看出,新生儿降生以后的四周以内是高风险期,特别是在第一周内,因为新生儿从胎儿出生以后对于外部的环境需要一个新的适应过程。另一方面,婴儿是无法正确的表达他们所出现的生理问题的,所以如何监测新生儿的生理信号以提升新生儿的监护质量与生存能力是非常具有实际的应用价值的。

4.传统基于心电(electrocardiogram,简称ecg)信号或者光体积描记图(photoplethysmogram,简称ppg)信号的心率测量是接触式的,需要将仪单元设备与人体相接触,需要被测试者保持一定的姿势来维持与设备的连接。由于新生儿无法长时间保持一个姿势,无法实现在安静状态下测量心率次数;另外,婴儿皮肤非常的敏感,所以采用传统接触式的测量方法对新生儿进行长期监护时,长时间接触心电传感单元与脉搏血氧仪等,会对婴儿的皮肤造成一定程度的伤害。

技术实现要素:

5.本发明的目的是提供一种面向新生儿的视觉心率估计方法、装置及系统,以实现对新生儿进行视觉心率估计。

6.为实现上述目的,本发明提供了一种面向新生儿的视觉心率估计方法,其特征在于,所述方法包括:

7.获取新生儿脸部的视频信息;所述视频信息包括多帧图像;

8.获取各帧图像对应的生理信号;所述生理信号包括心率真实信号和ppg真实信号;

9.采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型;

10.获取新生儿脸部的待检测视频信息;

11.将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

12.可选地,所述采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型,具体包括:

13.对所述视频信息中各帧图像进行脸部区域标注,获得已标注视频信息;

14.将所述已标注视频信息和与所述视频信息对应的所述生理信号进行切片,获得多个视频片段、多个ppg真实序列片段和多个心率真实均值;

15.对多个所述视频片段分别进行空间特征提取,获得多组空间特征;

16.对多组空间特征分别进行ppg信号估计,获得多个ppg估计序列片段;

17.将多个ppg估计序列片段与多个ppg真实序列片段代入ppg损失函数,计算ppg差异度;

18.对多个ppg估计序列片段分别进行心率估计与计算,获得多个心率估计均值;

19.将多个心率估计均值与多个心率真实均值代入心率损失函数,计算心率差异度;

20.根据ppg差异度和心率差异度计算总差异度;

21.根据总差异度来优化深度学习模型参数,直到总差异度最小为止。

22.可选地,所述对所述视频信息中各帧图像进行脸部区域标注,获得已标注视频信息,具体包括:

23.对所述视频信息中第一帧图像进行脸部区域标注;

24.基于第一帧图像标注的脸部区域,利用kcf算法跟踪所述视频信息中剩余帧图像对应的脸部区域;

25.将各帧已标注脸部区域的图像尺寸重新调整为128*128的图像,并构建已标注视频信息。

26.可选地,所述ppg损失函数为:

[0027][0028]

其中,l

ppg

为ppg差异度,α为常数,m为训练集中视频片段的总个数,r(j)为第j个视频片段对应的皮尔森系数,l

smse

为均方误差,s

g

(i,j)第i个视频片段第j个帧生理信号对应的ppg真实信号,为第j个视频片段对应的ppg真实信号均值,s

p

(i,j)为第i个视频片段第j个帧生理信号对应的ppg估计信号,为第j个视频片段对应的ppg估计信号均值,n为一个生理信号片段的总帧数。

[0029]

可选地,所述心率损失函数为:

[0030][0031]

其中,l

hr

为心率差异度,m为训练集中视频片段的总个数,hr

g

(j)为心率真实均值,hr

p

(j)为心率估计均值。

[0032]

本发明还提供一种面向新生儿的视觉心率估计装置,所述装置包括:

[0033]

摄像机,与新生儿脸部对应设置,用于获取新生儿脸部的待检测视频信息;

[0034]

控制终端,与所述摄像机连接,内部存储所述深度学习模型,用于根据上述方法将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

[0035]

可选地,所述装置还包括:

[0036]

生理信号采集模块,与所述控制终端连接,用于采集生理信号,并将生理信号与多帧图像一一对应。

[0037]

本发明还公开一种面向新生儿的视觉心率估计系统,所述系统包括:

[0038]

第一获取模块,用于获取新生儿脸部的视频信息;所述视频信息包括多帧图像;

[0039]

第二获取模块,用于获取各帧图像对应的生理信号;所述生理信号包括心率真实信号和ppg真实信号;

[0040]

训练模块,用于采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型;

[0041]

第三获取模块,用于获取新生儿脸部的待检测视频信息;

[0042]

预测模块,用于将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

[0043]

可选地,所述训练模块,具体包括:

[0044]

标注单元,用于对所述视频信息中各帧图像进行脸部区域标注,获得已标注视频信息;

[0045]

切片单元,用于将所述已标注视频信息和与所述视频信息对应的所述生理信号进行切片,获得多个视频片段、多个ppg真实序列片段和多个心率真实均值;

[0046]

空间特征提取单元,用于对多个所述视频片段分别进行空间特征提取,获得多组空间特征;

[0047]

ppg信号估计单元,用于对多组空间特征分别进行ppg信号估计,获得多个ppg估计序列片段;

[0048]

ppg差异度计算单元,用于将多个ppg估计序列片段与多个ppg真实序列片段代入ppg损失函数,计算ppg差异度;

[0049]

心率估计均值确定单元,用于对多个ppg估计序列片段分别进行心率估计与计算,获得多个心率估计均值;

[0050]

心率差异度计算单元,用于将多个心率估计均值与多个心率真实均值代入心率损失函数,计算心率差异度;

[0051]

总差异度计算单元,用于根据ppg差异度和心率差异度计算总差异度;

[0052]

优化单元,用于根据总差异度来优化深度学习模型参数,直到总差异度最小为止。

[0053]

可选地,所述标注单元,具体包括:

[0054]

标注子单元,用于对所述视频信息中第一帧图像进行脸部区域标注;

[0055]

跟踪子单元,用于基于第一帧图像标注的脸部区域,利用kcf算法跟踪所述视频信息中剩余帧图像对应的脸部区域;

[0056]

已标注视频信息构建单元,用于将各帧已标注脸部区域的图像尺寸重新调整为128*128的图像,并构建已标注视频信息。

[0057]

根据本发明提供的具体实施例,本发明公开了以下技术效果:

[0058]

本发明公开一种面向新生儿的视觉心率估计方法、装置及系统,本发明利用新生儿脸部的视频信息和所述生理信号,并采用深度学习技术进行训练获得深度学习模型;后续只需将获取的新生儿脸部的待检测视频信息输入深度学习模型进行预测,就能获得新生儿视觉心率估计值,克服传统采用接触式对心率测量带来的弊端。另外,本发明在训练深度学习模型时,还考虑了ppg信号,以提高预测深度学习模型的准确性,进而提高新生儿视觉心率估计的准确性。

附图说明

[0059]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0060]

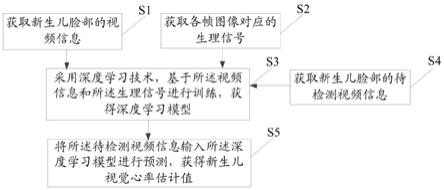

图1为本发明面向新生儿的视觉心率估计方法流程图;

[0061]

图2为本发明采集的视频信息和生理信号示意图;

[0062]

图3为本发明采集与标注新生儿脸部视频数据示意图;

[0063]

图4为本发明视频信息和生理信号分割示意图;

[0064]

图5为本发明空间特征提取深度神经网络示意图

[0065]

图6为本发明ppg信号和心率信号估计示意图;

[0066]

图7为本发明面向新生儿的视觉心率估计装置结构图;

[0067]

图8为本发明参考心率与预测心率的相关图;

[0068]

图9为本发明参考心率与预测心率之差的分布直方图;

[0069]

图10为本发明参考心率与预测心率一致性评价图;

[0070]

图11为本发明对三个30s视频所预测心率结果。

具体实施方式

[0071]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0072]

本发明的目的是提供一种面向新生儿的视觉心率估计方法、装置及系统,以实现对新生儿进行视觉心率估计。

[0073]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

[0074]

视觉心率测量(visual heart rate measurement)是一种非接触式的远程测量方法,在进行测量时,不需要与被测试者进行接触,可以有效解决上述问题。视觉心率测量一般是指基于脸部皮肤区域的视频信息提取心率信息的算法任务。当光线经过类皮肤区域反射以后,部分进入表层皮肤经毛细血管的反射光线带有血液流动的周期性信息。因此表层血管中血液的周期性流动会对该反射光线产生周期性的变化,并且该周期性的变化与心脏

的周期性跳动一致,即心率。因此理论上,可以通过摄像头捕捉皮肤表面的视频信息来测量或者估计被测试者的心率信息。

[0075]

如图1所示,本发明公开一种面向新生儿的视觉心率估计方法,所述方法包括:

[0076]

步骤s1:获取新生儿脸部的视频信息;所述视频信息包括多帧图像。

[0077]

步骤s2:获取各帧图像对应的生理信号;所述生理信号包括心率真实信号和ppg真实信号。

[0078]

步骤s3:采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型。

[0079]

步骤s4:获取新生儿脸部的待检测视频信息。

[0080]

步骤s5:将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

[0081]

下面对各个步骤进行详细论述:

[0082]

步骤s1:获取新生儿脸部的视频信息。本发明使用摄像机以正上方的固定角度对准新生儿脸部,之后进行无损视频信息采集。本发明获得的视频信息如图2中的(a)所示。

[0083]

步骤s2:获取各帧图像对应的生理信号;本发明同时获取生理信号以及视频信息。利用接触式的医用生理信号采集装置获得精确的生理信号,其中生理信号除了包括心率真实信号和ppg真实信号之外,还包括血氧饱和度。本发明获得的生理信号如图2中的(b)所示。

[0084]

心率测量方法主要包含模型学习阶段与心率测量阶段。模型学习阶段通过处理采集到的视频信息与生理信号,使用深度学习技术,学习一个深度学习模型,提供给心率测量阶段使用。

[0085]

步骤s3:采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型,具体包括:

[0086]

步骤s31:对所述视频信息中各帧图像进行脸部区域标注,获得已标注视频信息,具体包括:

[0087]

步骤s311:对所述视频信息中第一帧图像进行脸部区域标注,如图3所示。由于新生儿主要是脸部暴露在空气中,脸部是采集到的视频信息中信息量最高的区域,获得这个区域可以有利于之后的处理。使用矩形框标记每条视频信息中第一帧的新生儿脸部的位置,标记矩形框的大小尽可能最大的覆盖新生儿脸部皮肤区域。

[0088]

步骤s312:基于第一帧图像标注的脸部区域,利用kcf算法跟踪所述视频信息中剩余帧图像对应的脸部区域。由于新生儿并不是静止不动的,采集到的视频信息中新生儿脸部区域是不断变化的,所以需要跟踪脸部区域。本发明利用kcf算法跟踪视频随后帧的脸部位置,这样可以得到整个视频序列中每一帧的脸部位置信息。

[0089]

在步骤s312之后还包括:

[0090]

步骤s313:将各帧已标注脸部区域的图像尺寸重新调整为128*128的图像,并构建已标注视频信息。已标注视频信息包括多帧已标注脸部区域的128*128的图像。

[0091]

步骤s32:将所述已标注视频信息和与所述视频信息对应的所述生理信号进行切片,获得m个视频片段、m个ppg真实序列片段和m个心率真实均值。所述ppg真实序列片段和所述心率真实均值均与所述视频片段均存在一一对应关系,m为大于1的正整数。每个视频

片段为60*128*128*3的规格,即每个视频片段包括60帧图像,像素值为128*128,通道为3。每个所述视频片段包括60帧已标注视频图像。

[0092]

如图4所示,第一步是对已标注的视频信息进行切片。具体为,将标记的脸部感兴趣区域统一缩放到128*128的大小。对于30fps的视频信息,放弃起始位置上的前10帧图像,将之后的视频切成60帧即两秒的片段,获得多个视频片段。第二步是对相应的生理信息进行切片。具体为,放弃起始位置上的前10帧图像对应的前20帧生理信号信息,对于60fps的ppg真实信号,需要进行下采样操作,生成30fps的信号序列,将之后的序列切成60帧即两秒的片段,与视频片段所对应,共计获得多个ppg真实序列片段。第三步是对心率真实数据进行切片。具体的,每两秒得到一个的平均心率,与视频片段及ppg序列片段对应。第四步是对以上三种片段进行对应及存储,以便之后的模型学习使用。fps为每秒传输帧数,对应的英文全称为frames per second。

[0093]

步骤s33:对m个所述视频片段分别进行空间特征提取,获得m组空间特征;如图5所示,首先将m个所述视频片段输入第一层的时间分布2d卷积层后得到60*128*128*3的中间特征,将60*128*128*3的中间特征输入到第二层的时间分布2d卷积层后得到60*128*128*32的中间特征,将60*128*128*32的中间特征输入到第三层的时间分布2d卷积层后得到60*64*64*32的中间特征。再将60*64*64*32的中间特征输入到两层的平行扩张层中,得到60*16*16*96的中间特征。再将60*16*16*96的中间特征依次经过四层的时间分布2d卷积层,依次得到60*16*16*128、60*8*8*192、60*8*8*192以及60*4*4*256的中间特征,将60*4*4*256的中间特征输入到一个平均池化层得到最终的60*1*256的空间特征。上述过程中均为2维卷积操作。另外,由于四维数据不能形象的表示,所以在图5中所示的数据规格中均省略了时序维度t=60。

[0094]

步骤s34:对m组空间特征分别进行ppg信号估计,获得m个ppg估计序列片段。如图6所示,将m组空间特征依次通过两层双向lstm网络层、一层单向lstm网络层及一层1d卷积操作得到m个ppg估计序列片段;所述ppg估计序列片段包括t个ppg估计信号。每组空间特征的规格是60*256;每组空间特征包括t个时序相关的空间特征向量,本实施例中t为60。

[0095]

步骤s35:将m个ppg估计序列片段与m个ppg真实序列片段代入ppg损失函数,计算ppg差异度;本发明使用指定的ppg损失函数计算ppg估计信号与ppg真实信号的差异程度,以使反向传播优化参数。所述ppg损失函数为:

[0096][0097]

其中,l

ppg

为ppg差异度,α为常数,m为训练集中视频片段的总个数,r(j)为第j个视频片段对应的皮尔森系数,l

smse

为均方误差,s

g

(i,j)第i个视频片段第j个帧生理信号对应

的ppg真实信号,为第j个视频片段对应的ppg真实信号均值,s

p

(i,j)为第i个视频片段第j个帧生理信号对应的ppg估计信号,为第j个视频片段对应的ppg估计信号均值,n为一个生理信号片段的总帧数。

[0098]

步骤s36:对m个ppg估计序列片段分别进行心率估计与计算,获得多个心率估计均值;将m个ppg估计序列片段作为输入,同样通过两层双向lstm网络层、一层单向lstm网络层及两个全连接层得到的心率估计值,然后将各视频片段内对应的多个心率估计值进行求平均,获得m个心率估计均值。另外,本发明使用指定的心率损失函数计算心率估计值与心率真实值的差异程度,反向传播优化参数;所述心率损失函数为:

[0099][0100]

其中,l

hr

为心率差异度,m为训练集中视频片段的总个数,hr

g

(j)为心率真实均值,hr

p

(j)为心率估计均值。

[0101]

步骤s38:根据ppg差异度和心率差异度计算总差异度,具体公式为:

[0102]

l

g

=βl

hr

+(1

‑

β)l

ppg

[0103]

其中,β为权重系数,l

hr

为心率差异度,l

ppg

为ppg差异度,l

g

为总差异度。

[0104]

步骤s39:根据总差异度来优化深度学习模型参数,直到总差异度最小为止,即深度学习模型参数不能再优化为止。

[0105]

实施例2

[0106]

如图7所示,本发明还公开一种面向新生儿的视觉心率估计装置,所述装置包括:

[0107]

摄像机701,与新生儿脸部对应设置,用于获取新生儿脸部的待检测视频信息;

[0108]

控制终端702,与所述摄像机701连接,内部存储所述深度学习模型,用于根据实施例1的方法将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

[0109]

本发明所述装置还包括:生理信号采集模块703,与所述控制终端连接,用于采集生理信号,并将生理信号与多帧图像一一对应。本发明生理信号采集模块优选脉搏血氧仪。

[0110]

本发明利用控制终端702(如计算机)用来处理保存获得的视频信息及生理信号。控制终端702使用高速的存储设备保存视频信息采集模块采集的无损视频信息。另外,控制终端702将生理信号采集模块采集的生理脉冲信号存储为离散的格式化数据。

[0111]

在采集过程中,视频信息与生理信号是同时采集的,由于摄像机701与生理信号采集模块703的启动延迟不同,控制终端702需要记录视频信息与生理信号的精确采集时间,以便之后对信息进行处理。

[0112]

本发明利用摄像机701用于采集视频信息视频的采集帧率为30帧/秒,利用专用的脉搏血氧仪用于采集生理脉冲信号,三种生理脉冲信号的采集帧率均为60帧/秒,为确保采集的视频帧与生理信号的同步性,每帧视频信号和每帧生理信号的采集系统时间都记录保存,精确到毫秒级。

[0113]

实施例3

[0114]

本发明还公开一种面向新生儿的视觉心率估计系统,其特征在于,所述系统包括:

[0115]

第一获取模块,用于获取新生儿脸部的视频信息;所述视频信息包括多帧图像。

[0116]

第二获取模块,用于获取各帧图像对应的生理信号;所述生理信号包括心率真实信号和ppg真实信号。

[0117]

训练模块,用于采用深度学习技术,基于所述视频信息和所述生理信号进行训练,获得深度学习模型。

[0118]

第三获取模块,用于获取新生儿脸部的待检测视频信息。

[0119]

预测模块,用于将所述待检测视频信息输入所述深度学习模型进行预测,获得新生儿视觉心率估计值。

[0120]

作为一种可选的实施方式,本发明所述训练模块,具体包括:

[0121]

标注单元,用于对所述视频信息中各帧图像进行脸部区域标注,获得已标注视频信息。

[0122]

切片单元,用于将所述已标注视频信息和与所述视频信息对应的所述生理信号进行切片,获得多个视频片段、多个ppg真实序列片段和多个心率真实均值。

[0123]

空间特征提取单元,用于对多个所述视频片段分别进行空间特征提取,获得多组空间特征。

[0124]

ppg信号估计单元,用于对多组空间特征分别进行ppg信号估计,获得多个ppg估计序列片段。

[0125]

ppg差异度计算单元,用于将多个ppg估计序列片段与多个ppg真实序列片段代入ppg损失函数,计算ppg差异度。

[0126]

心率估计均值确定单元,用于对多个ppg估计序列片段分别进行心率估计与计算,获得多个心率估计均值。

[0127]

心率差异度计算单元,用于将多个心率估计均值与多个心率真实均值代入心率损失函数,计算心率差异度。

[0128]

总差异度计算单元,用于根据ppg差异度和心率差异度计算总差异度。

[0129]

优化单元,用于根据总差异度来优化深度学习模型参数,直到总差异度最小为止。

[0130]

作为一种可选的实施方式,本发明所述标注单元,具体包括:

[0131]

标注子单元,用于对所述视频信息中第一帧图像进行脸部区域标注。

[0132]

跟踪子单元,用于基于第一帧图像标注的脸部区域,利用kcf算法跟踪所述视频信息中剩余帧图像对应的脸部区域。

[0133]

已标注视频信息构建单元,用于将各帧已标注脸部区域的图像尺寸重新调整为128*128的图像,并构建已标注视频信息。

[0134]

实施例4

[0135]

在医院产科临床环境下采集数据并开展的实验研究。本发明共采集257个新生儿对象,包括1130个脸部无损视频与对应的生理信息数据,视频时长为9.6小时,共921gb数据量。每个新生儿人脸样本的视频长度为25s、30s、45s或者60s。在训练的过程中,本发明实施例将连续的视频切断成若干2s(60帧)的视频的片段,分割的两个连续视频片段的重合帧数为30帧,视频切割方法如图4所示。

[0136]

本发明使用普通的消费级摄像头采集视频信息,使用新生儿专用脉搏血氧仪采集生理信号,可以用于获取ppg信号、心率以及血氧信息。控制终端运行采集程序,记录与保存视频信息和生理信号到数据存储单元,由于本发明采集的视频信息是无损视频,为了确保

视频存储帧率的稳定,需要使用固体硬盘接收实时存储数据。

[0137]

本发明所采集的新生儿视频数据是分辨率为(640*480),时长为25秒、30秒、45秒或者60秒,如图3所示。而本发明的深度神经网络的输入为2秒(60帧)的脸部视频数据,以下将详细阐述本数据处理的流程。

[0138]

脸部区域标记:由于只有皮肤区域包含生理信息,且包含的生理信息是非常微弱的,所以为了减少其他区域的干扰,本发明需要手动标记每个单独视频的第一帧新生儿脸部所在的位置,如图3中第一列图像所示。手动标记的感兴趣区域(region ofinterest,roi)需要尽可能的包含更多的新生儿脸部区域,即在标记的感兴趣区域内脸部皮肤区域的面积所占比例最大,但是roi的像素面积也不能太小,一般皮肤的像素面积需要大于8000个,以消除白噪声的干扰。

[0139]

在标记每一个视频的第一帧的脸部roi以后,之后的每帧使用核相关滤波(kernel correlationfilter,kcf)跟踪算法或方向梯度直方图来确定之后每帧的脸部roi的位置。提取完roi区域以后,需要将所提取的脸部roi的分辨率重新调整为(128*128),存储为裁剪后的roi视频序列。

[0140]

本发明中的深度神经网络算法的输入信号为2秒(60帧)的新生儿脸部视频信息,输出为这2秒内的平均心率值,其中在训练过程还需要利用对应的参考的ppg信号。在完成上述的脸部roi标记以及roi跟踪以后,本发明将分辨率重新调整为(128*128)的连续视频序列分成若干2秒(60帧)的roi视频序列片段,并且定位出对应的生理信号信息(包括ppg信号和心率信息)。最后本发明将2秒的视频片段和对应的生理信号信息保存为一个训练数据样本,一共得到超过29000个样本数据。

[0141]

图8的横坐标为预测心率值,纵坐标为真实心率值,如果图8中的点越接近于中间的斜线,表示算法估计的越准确。图9为预测心率值与真实心率值之差的分布直方图。图10为参考心率与预测心率一致性评价图,sd表示标准差,在正负1.96倍(95%)的标准差内的分布情况。图11为三个30秒的视频分割的切片的预测结果,图11中(a)的真实值大概在125bpm到140bpm之间,图11中(b)的真实值大概在100bpm到110bpm之间,图11中(c)的真实值大概在为110bpm到125bpm之间。

[0142]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0143]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1