一种阶次优化的远程操控行为轮廓规划方法

1.本发明属于人机交互技术领域,具体涉及一种阶次优化的远程操控行为轮廓规划方法。

背景技术:

2.人机交互是机器人执行复杂任务时的主要辅助手段,在保障作业安全按的前提下,通过操作人员对任务的理解并施加相应的行为,可以提升任务实施过程的效率。

3.在人类涉足危险作业环境之前,人机交互仅仅作为辅助手段以提升操作过程的可靠与效率为主要目的,随着机器人技术发展,以及工业化环境中复杂任务增多,作为机器人危险场景中顺利实施高效高精度任务的必要手段,人机交互已经从人机共在同一环境中,转变为可以在时空分离条件下开展机器人智能化作业的必要手段,例如在空间机器人在轨服务中,机器人遥操作的人机交互技术显得尤为重要。

4.人机交互方面技术的发展对于机器人提升任务作业能力有明显的促进作用,也是机器人智能化发展的重要力量。现有运用整数阶次或者分数阶次的控制方法只能兼顾动态或者稳态特征,即对于轨迹及轮廓跟踪的整体误差难以令人满意。

技术实现要素:

5.本发明的目的是提供一种阶次优化的远程操控行为轮廓规划方法,以解决现有方法动态响应及稳态性能难以满足人机交互要求的问题。

6.本发明采用以下技术方案:一种阶次优化的远程操控行为轮廓规划方法,包括以下内容:

7.步骤1.初始化考虑操作人员操作行为的机械臂末端动力学方程的状态以及期望的阻抗结构,计算在操作人员行为作用下生成的机械臂末端运动轨迹,

8.步骤2.进行轮廓的扩张生成,基于所述步骤1中生成的机械臂末端运动轨迹最近生成轮廓的三个点:x

r(k-2)

=(x1,y1),x

r(k-1)

=(x2,y2),x

r(k)

=(x3,y3)来确定对应的典型的圆形轮廓,所述圆形轮廓的圆心和半径分别为:

[0009][0010][0011][0012]

其中,a=(x

1-x2)(y

1-y3)-(x

1-x3)(y

1-y2);

[0013]

根据该几何关系,利用贪心算法,计算获得距离当前位置最近的轮廓点位置x

cr

作为期望的跟踪位置,定义轮廓跟踪误差为:e=x-x

cr

;

[0014]

根据所述圆形轮廓确定的轨迹微元,最终确定机械臂末端的轨迹。

[0015]

本发明采用的第二种技术方案是,一种阶次优化的远程操控行为轮廓控制方法,其基于一种阶次优化的远程操控行为轮廓规划方法,包括以下内容:

[0016]

步骤1.选定可行的阶次集合与误差集合;

[0017]

步骤2.初始化近似求解过程的参数,包括markov决策过程的误差集合及可行的阶次集合设定,以及迭代目标值∈q,即收敛过程的收敛值的差,一旦收敛值的差小于迭代目标值,则求解过程完成,求解i=1∶n,j=1∶m条件下的

[0018][0019]

直到||ξk′

+1-ξk′

||≤∈q;

[0020]

迭代停止时获得的ξk′

+1

为近似最佳策略从而可以获得近似最优的阶次选择策略为:使得近似q值函数最大的对应的阶次选择策略,数学描述如下:

[0021][0022]

步骤3.根据步骤1中的轮廓跟踪误差及步骤2中的阶次选择策略,基于轮廓跟踪误差的变化阶次滑模面为:

[0023]

s=d

α

e+ce

ꢀꢀꢀꢀ

(4)

[0024]

其中,s是滑模面,c是正实数,k为一个非负整数,l-1<α<l,α是待求解的合适的阶次;

[0025]

控制指令为:

[0026][0027]

进一步的,可行的阶次集合中包含所有能够使控制器稳定的机械臂末端运动跟踪误差的分数阶次,具体为大于0小于1的实数,误差集合具体指包括控制过程中所有出现的机械臂末端运动跟踪误差的实数集。

[0028]

本发明的有益效果是:本发明运用q学习方法获取跟踪过程中兼顾动态及稳态特征的最优阶次,提升跟踪控制效果。运用q学习方法获得近最优的阶次选择策略是综合固定分数阶条件下不同阶次对于动态及稳态过程响应优势的方法,属于本方法的创新点,此外,运用轮廓误差的思想优化任务实施过程也是本发明的重要创新。相比现有方法,全局最优的阶次优化是本发明首次提出的,综合考虑期望阻抗的轮廓扩张结构也未见报道。

附图说明

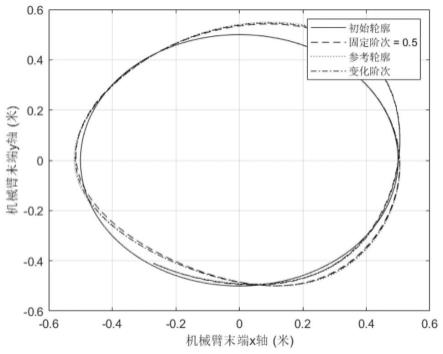

[0029]

图1为本发明实施例中机械臂末端的轮廓跟踪效果示意图;

[0030]

图2为本发明实施例中机械臂末端轮廓跟踪细节示意图;

[0031]

图3为本发明实施例中机械臂末端跟踪轨迹误差示意图;

[0032]

图4为本发明实施例中操作人员的操作力示意图;

[0033]

图5为本发明实施例中阶次选择策略示意图。

具体实施方式

[0034]

下面结合附图和具体实施方式对本发明进行详细说明。

[0035]

一、本发明提供了一种阶次优化的远程操控行为轮廓规划方法,包括以下内容:

[0036]

考虑人在环路的二维平面运动的机械臂末端人机交互动力学模型可以表示如下:

[0037][0038]

其中,是机械臂末端操作空间的质量/惯量矩阵,是机械臂末端操作空间的科里奥利力矩阵,是机械臂末端空间的重力矩阵,是操作人员在机械臂末端实施的作用力,本发明中认为是可以测量的已知量,是需要发明的控制器输出的控制力。

[0039]

本发明的目标是在控制力的作用下,操作人员在机械臂末端能够感受到接近期望阻抗的作用力,该作用力中包含了末端为操作者提供的轮廓跟踪引导力。

[0040]

人机交互的期望阻抗数学描述由期望质量/惯量矩阵期望阻尼参数矩阵以及期望弹性参数矩阵构建如下的表达式-其中,是操作人员的力在期望阻抗条件下生成的期望轨迹,是预先设定的期望轨迹,在无操作人员的介入下,机械臂末端将跟踪该轨迹运动。

[0041]

值得注意的是,生成的期望轨迹是操作人员根据自身的需求发明的,对于机械臂末端而言,由于该轨迹的位置与时序关系是固定的,可能存在连续间隔的期望跟踪点存在非平滑等情况,为此,本发明将机械臂末端的操作平滑性作为人机交互过程的一个重要指标,进一步对操作人员作用力下的轨迹指令进行规划。

[0042]

任意生成轨迹的轮廓扩张准则是轮廓的扩张生成是有已知的最近生成轮廓的三个点x

r(k-2)

=(x1,y1),x

r(k-1)

=(x2,y2),x

r(k)

=(x3,y3)确定的,对应的轮廓为典型的圆形,其圆心和半径分别为:

[0043][0044][0045][0046]

其中,a=(x

1-x2)(y

1-y3)-(x

1-x3)(y

1-y2)。

[0047]

根据该几何关系,利用贪心算法,计算获得距离当前位置最近的轮廓点位置x

cr

作为期望的跟踪位置,x是机械臂末端位置,定义轮廓跟踪误差为:

[0048]

e=x-x

cr

ꢀꢀꢀꢀ

(3);

[0049]

根据所述圆形轮廓确定的轨迹微元,最终确定机械臂末端的轨迹。最近生成轮廓的三个点可以确定一段尽可能小的轨迹微元,考虑到任意轨迹可以利用无穷多个轨迹微元进行近似,而三点确定的轨迹微元可以描述某一个圆轮廓的弧段,所以根据几何关系确定该小弧段所对应的近似典型圆形轮廓,求出圆形轮廓的圆心和半径,最终就可以确定机械臂末端的轨迹。

[0050]

二、本发明还提供了一种阶次优化的远程操控行为轮廓控制方法,包括以下内容:

[0051]

本发明基于轮廓跟踪误差的变化阶次滑模面:

[0052]

s=d

α

e+ce

ꢀꢀꢀꢀ

(4),

[0053]

其中,s是滑模面,e是机械臂末端跟踪误差,c是正实数,

[0054]

l为一个非负整数,l-1<α<l,α是本发明中待求解的合适的阶次。其中,l>a,t是积分变量,e是指数函数运算符。

[0055]

为了实现人机交互过程中的轮廓跟踪,发明如下的控制指令,实现系统稳定控制。

[0056][0057]

其中,是对角矩阵,对角线上的元素都是正数,e=x-x

cr

是轮廓误差,x是机械臂末端位置,x

cr

是生成的期望轮廓位置。

[0058]

为了提升人机交互条件下轮廓跟踪性能,基于mittage-leffler稳定性理论,固定阶次的分数阶控制系统难以同时兼顾动力学响应快速性与稳态高精度,为了提升固定分数阶次闭环系统的快速响应与高精度稳态性能。本发明综合模糊q学习算法与连续分数阶系统的数值近似扩展表达进行分数阶次的优化,增强机械臂末端的轮廓跟踪性能,实现有人参与的期望阻抗条件下生成参考规划轮廓的高质量跟踪效果。

[0059]

滑模控制趋近律作能够保证滑模面始终存在,则满足如下的数学描述:

[0060]

s=0

ꢀꢀꢀꢀ

(6),

[0061]

继而有

[0062]dα

e=-ce

ꢀꢀꢀꢀ

(7)。

[0063]

上述动力学系统响应可以利用欧拉法构建为一个确定的markov决策过程:

[0064]ek+1

=f(ek,αk)

ꢀꢀꢀꢀ

(8),

[0065]

其中,e

k+1

是第k+1个采样时间时的误差,αk是第k+1个采样时间时的阶次,f(ek,αk)=-d

αek+1

/c在该过程中,误差所在集合为误差空间ε,而阶次可选集合为可行阶次空间可行阶次空间与误差空间满足如下关系

[0066]

定义在时刻k的可行阶次为αk,所选择的阶次对应产生的效果可以通过评价如下代价函数进行评价

[0067][0068]

其中,r

k+1

第k+1个时刻的奖励函数,公式(9)描述了在是有界的假设条件下,存在状态以依赖的策略使得最优的阶次选择αk=p(ek)满足系统响应性能要求。本发明采用带有折扣参数的回报评价最优阶次选择的长期性能,回报评价的数学描述如下:

[0069]

[0070]

其中,γ∈[0,1)是折扣参数。

[0071]

前述回报对应的阶次选择的最优q函数定义为以描述策略行为与效果关系,该关系具有如下的数学表达:

[0072][0073]

上述描述中,要求阶次选择是最优的,继而对应的最优策略可以定义如下

[0074][0075]

定义如下的q迭代映射其中,q函数空间定义为包含所有q函数的集合,该映射能够描述q函数之间的传递,具体的数学描述如下:

[0076][0077]

基于bellman函数的最优值函数可以描述如下:

[0078][0079]

其中q

*

是映射的不动点,满足如下条件,对于任意的(q,q

′

)存在上述表达式说明,随着迭代次数k

′

趋于无穷,迭代收敛。

[0080]

直接实施q迭代算法不太现实,主要原因是误差-阶次对空间下计算最优选择策略属于大规模寻优问题,时间及计算空间代价过高。为了解决这一问题,本专利运用模糊近似对q迭代过程进行参数化,定义q函数的近似估计为

[0081][0082]

其中,参数向量为继而如下的近似过程中需要的映射关系成立,参数化过程映射是以及如下的解参数映射以保证

[0083][0084]

因此,q函数相关的误差及阶次选择可以由计算获得。

[0085]

根据上述的定义,可以求解近最优的策略如下

[0086][0087]

误差空间的模糊近似表示可以模糊分割进行重新构建。典型的,模糊分割包含n个模糊集,其可以用ωi,i=1,2,

…

,n表示,表示误差属于模糊集合ωi程度的量是隶属度函数,数学描述为

[0088]

实际上,根据分数阶rl定义,动力学系统响应可以通过数值方法近似,为了降低算法的复杂度,本专利的阶次选择可以做如下的离散化表达:

[0089][0090]

其中,是离散策略空间,因此,不难发现与αj对可以确定参数ξ

(i,j)

。

[0091]

根据如下的模糊规则,如果e是属于集合ωi,则

…

,其中,是参数ξ

(i,1)

对应的语义解释,是参数ξ

(i,2)

对应的语义解释,是参数ξ

(i,m)

对应的语义解释,继而发明随者可以构建模糊q函数如下

[0092][0093]

其中,并且

[0094][0095]

是归一化的隶属度函数。

[0096]

从q函数到近似参数的映射具有如下特征:

[0097]

ξ

(i,j)

=q(xi,uj),

ꢀꢀꢀꢀ

(21),

[0098]

表示误差-阶次对在被选点(i,j)上是精确估计。

[0099]

因此如下表达式成立:

[0100][0101]

其表明,近似求解的在特定点是有效的。结合mdp过程,可以采用如下的过程,进行阶次的近最优求解。

[0102]

迭代求解算法步骤包括以下内容:

[0103]

步骤11、初始化近似求解过程的参数,包括mdp过程的误差及阶次的可行集合设定,以及迭代目标值∈q。

[0104]

步骤12、求解i=1∶n,j=1∶m条件下的

[0105][0106]

直到||ξk′

+1-ξk′

||≤∈q。

[0107]

其中,是i个时刻的代价函数,e

k+1

=f(ek,αk)是描述动力学响应过程的markov过程,e

k+1

和是ek第k+1个和第k个采样时间时的误差,αk是第k个采样时间时的阶次,

γ是折扣参数,是不大于1的正数,φi′

(f(ei,αj))是第i

′

次迭代的隶属度函数,是第k

′

+1次迭代选择第i个误差与第j个阶次对所对应的近似q值估计;

[0108]

步骤13、步骤12中迭代停止时获得的ξk′

+1

为近似最佳策略

[0109]

从而可以获得近似最优的阶次选择策略为,数学描述如下:

[0110][0111]

其中,是最优阶次的选择策略,是近似q函数的传递映射函数,j

*

是使得下一步近似q函数最大的参数对选择对应j值。

[0112]

在一些实施例中,可行的阶次集合中包含所有能够使控制器稳定的机械臂末端运动跟踪误差的分数阶次,具体为大于0小于1的实数,误差集合具体指包括控制过程中所有出现的机械臂末端运动跟踪误差的实数集。

[0113]

图1为本发明实施例中,机械臂末端的轮廓跟踪效果示意图,为了说明本发明相比现有固定阶次方法的优势,实施例中还给出了阶次固定为α=0.5的相同结构控制器对于参考轮廓跟踪。图1中的初始轮廓刻画了在操作人员未进行干预前的预定任务轮廓轨迹为一个半径为0.5m的平面圆,利用本发明的期望轨迹及轮廓生成方法,获得了参考轮廓。

[0114]

图2为本发明实施例中,机械臂末端轮廓跟踪细节,从图中不难发现,本发明作用下轮廓跟踪轨迹与参考轮廓的距离更近,误差更小,轮廓跟踪效果比固定阶次方法更好。

[0115]

图3为本发明实施例中,机械臂末端跟踪轨迹误差,从误差水平上看,本发明提供的方法跟踪误差更小,波动水平更低,误差曲线平缓,适合人机交互过程,满足轮廓跟踪要求。

[0116]

图4为本发明实施例中,操作人员的操作力,选用的为高斯函数描述的钟型力生成过程,与人类操作行为特征一致。

[0117]

图5为本发明实施例中,阶次选择策略的轨迹,从图中可以发现,为了同时兼顾动态及稳态过程,阶次选择策略在误差不同阶段根据本发明的算法进行了适应性调整。

[0118]

本发明运用q学习方法获取跟踪过程中兼顾动态及稳态特征的最优阶次,提升跟踪控制效果。运用q学习方法获得近最优的阶次选择策略是综合固定分数阶条件下不同阶次对于动态及稳态过程响应优势的方法,属于本方法的创新点,此外,运用轮廓误差的思想优化任务实施过程也是本发明的重要创新。相比现有方法,全局最优的阶次优化是本发明首次提出的,综合考虑期望阻抗的轮廓扩张结构也未见报道。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1