与物体交互的过程

与物体交互的过程

1.本发明涉及与第一项权利要求序言所述类型的物体进行交互的过程。

2.具体而言,本发明涉及一种过程,其配置为优选在自动化生产和装配线上使用机器人搬运物体。

3.众所周知,自动化生产和装配线特别灵活,这要归功于利用了能够执行不同任务和处理不同形状和一致性的产品的机器人。

4.这些机器人现在用于在不同工位之间移动物体,例如在仓库和工作站之间移动物体,和/或执行装配和焊接等任务。

5.通过编程,它们可以非常精确地忠实执行重复性任务。这些动作是由软件决定的,软件指定了一系列协调动作的方向、加速度、速度和距离。

6.这些动作由操作员定义,操作员必须为每项操作定义指令,并因此定义向机器人发出的指令,使其能够执行所需的操作。

7.所述的现有技术存在一些重要缺陷。

8.特别是,已知的处理过程需要使用特定的编程语言来指导机器人完成每项新任务的每个动作。这就导致生产流程管理复杂,并经常因不能准确识别要执行的正确过程而出错。

9.为了解决这个问题,我们设计了新的指令定义流程。新型商用机器人配备了图形用户界面(gui),操作员可在短时间内完成编程。

10.虽然这一解决方案大大加快了编程速度,但并没有带来足够的改进。因此,目前已知的物体处理过程特别复杂,不易使用,成本相对较高,并且/或者需要使用复杂而昂贵的机器人。

11.另一个缺点是已知的搬运过程缺乏灵活性,几乎需要不断地重新编程,因为机器人无法适应要执行的动作和/或要搬运的物体的任何变化。

12.在这种情况下,本发明的基础技术任务是设计一种与物体交互的过程,该过程至少能够消除上述缺点的一部分。

13.在上述技术任务的背景下,本发明的一个重要目的是获得一种易于编程、因此极其灵活的物体交互过程。

14.如所附权利要求1所述,通过与物体交互的过程实现了技术任务和规定的目的。从属权利要求中描述了优选实施例。

15.下文将参照附图,通过对本发明优选实施例的详细描述,阐明本发明的特征和优点,其中:

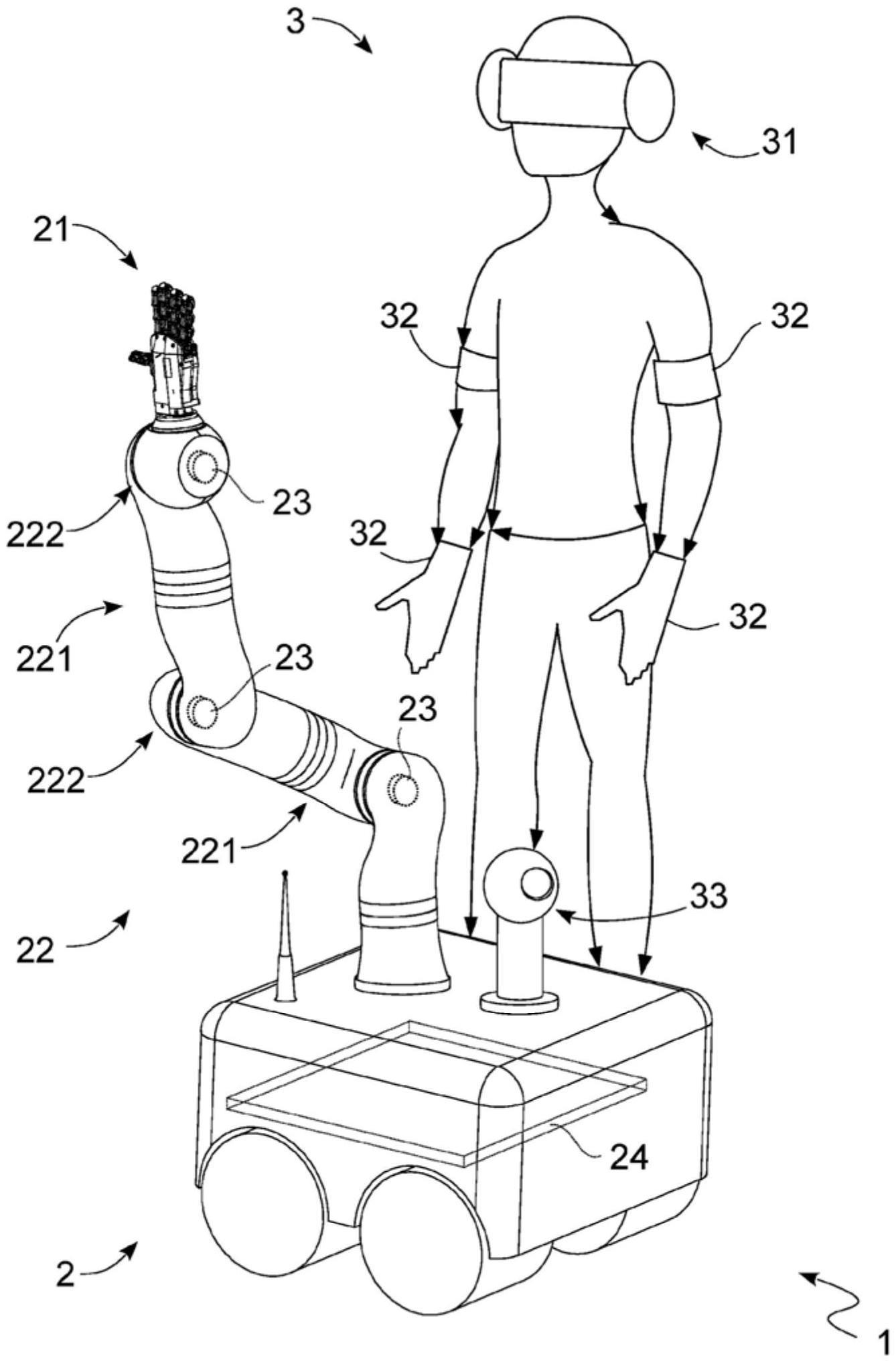

16.图1按比例展示了根据本发明为实现与物体的交互过程而配置的设备;

17.图2a按比例展示了图1的设备的装配;

18.图2b按比例展示了图2a的不同用途的组件;

19.图3按比例展示了根据本发明的实现与物体的交互过程的环境;以及

20.图4展示了根据本发明的与物体的交互过程的示意图。

21.在本文件中,测量值、数值、形状和几何基准(如垂直度和平行度),当与“大约”或

其他类似术语(如“近似”或“大致”)相关联时,应被视为除了因生产和/或制造误差而造成的测量误差或不准确之外,最重要的是,除了与其相关联的数值、测量值、形状或几何基准略有偏差之外。例如,如果这些术语与某一数值相关联,优选表示偏差不超过该数值的10%。

22.此外,在使用“第一”、“第二”、“较高”、“较低”、“主要”和“次要”等术语时,并不一定要确定顺序、关系的主次或相对位置,而只是用来明确区分它们的不同组成部分。

23.除非另有说明,本文中报告的测量结果和数据应视为在国际民航组织国际标准大气层(iso 2533:1975)中进行的测量结果和数据。

24.除非另有说明,在以下讨论中,“处理”、“计算”、“确定”、“计数”或类似术语是指计算机或类似电子计算设备的操作和/或过程,这些设备可操作和/或转换计算机系统和/或内存中寄存器的电子量等表示为物理量的数据,以及计算机系统、寄存器或其他存储、传输或信息显示设备中类似表示为物理量的其他数据。

25.参照附图,根据本发明与物体交互的过程整体地用标记1表示。

26.过程1配置为识别环境10(例如房屋或公寓)中的物体1a并与之交互。优选地将其配置为在工作/工业环境10(如仓库或生产线)中识别物体1a,并与之交互,从而移动/搬运物体1a。

27.环境10可以定义可步行区域10a。

28.环境10可包括至少一个房间11。具体来说,它可以包括多个房间11和每个房间之间至少一个通道12。

29.交互过程1可包括至少一个机器人2。

30.机器人2可配置为与至少一个物体1a进行交互。机器人2可以包括至少一个末端执行器21,用于抓取至少一个物体1a。

31.末端执行器2可与物体1a进行交互,特别是与重量和/或形状适当不同的多个物体1a进行交互。例如,它被配置为一次只与一个物体1a交互并精确地对其操纵/执行抓取。

32.末端执行器2可包括至少两个可相互移动的机械手指,以便执行上述抓取操作。它优选由两根以上的手指组成,尤其是在机器人手(例如us2019269528和us2018311827中描述的机器人手)中可以识别。

33.对于每个末端执行器21,机器人2可包括末端执行器21的驱动器22。

34.驱动器22可配置为相对于物体1a和/或环境10移动末端执行器21。

35.驱动器22可以包括机械臂。它可包括一个或多个刚性体221(可根据选择性伸缩轮廓识别),以及一个或多个适于以适当的独立方式移动刚性体221的接头222。

36.接头222可以配置为通过改变两个刚性体221之间的展开角度来相互旋转刚性体221。

37.接头222优选根据逆运动学或直接运动学移动刚性体221。因此,即使没有明确说明,机器人2的每个动作以及定义这些动作的指令都是根据逆运动学或直接运动学确定的。

38.词语(expression)“逆运动学”定义了在末端执行器21的路径的操作空间中的轨迹。因此,各个接头222的速度和加速度被定义,从而形成所述末端执行器路径21。

39.词语“直接运动学”确定的是空间轨迹的计算,其中确定的是各个接头222的位置、速度和加速度,而不是末端执行器21的路径。因此,末端执行器21的路径是每个接头222的

位置、速度和加速度的结果。

40.每个接头222都可以电动化,具体包括伺服电机。

41.驱动器22可包括位移装置223,其构造成使机器人2沿着可行走平面10a移动。

42.位移装置223可以是电动的。例如,它们可以包括至少一个履带或轮子。

43.机器人2可包括传感器23,用于获取至少一个合适的环境参数和/或用于机器人2与物体1a的交互。

44.传感器23可包括一个或多个传感器,每个传感器都配置为获取选自环境参数和交互参数的参数。优选配置为获取至少一个环境参数和至少一个交互参数。

45.词语“环境参数”指的是机器人2外部的参数,因此与机器人2的运行无关。环境参数可以是环境10特有的物理条件(如温度、湿度、亮度)和/或物体1a的特征(如形状和/或重量)。

46.词语“交互参数”指的是与机器人2在与物体1a进行交互/操作时的运行相关的参数。例如,可以识别末端执行器21的抓取位置和/或力度或末端执行器21的接触温度物体1a。

47.在获取至少一个环境参数的情况下,传感装置23可包括一个或多个传感器,这些传感器可从温度计、光电探测器、湿度计或用于拍摄物体1a的装置(如摄像机)中选择。

48.在交互参数的情况下,传感器23可以包括一个或多个传感器,这些传感器可以从温度计、压电传感器、每个接头222的编码器中选择。

49.传感器23可配置为获取机器人的动作,以便定义必要的指令来确定机器人2的动作。

50.机器人2可以包括卡24,用于控制机器人2,特别是至少控制末端执行器21和驱动器22。

51.卡24可以与传感器23进行数据连接。

52.交互过程1可以包括指令块3,用于定义并向机器人2发送指令,以移动末端执行器21(优选是驱动器22),从而与一个或多个物体1a进行交互。

53.指令块3可以与机器人2进行数据连接,具体来说可以与计算机24进行连接。

54.块3可配置为定义并向机器人2发送必要的指令,以确定物体1a的位置,并在环境10中对物体1a执行交互(搬运、抓取和/或移动)。例如,块3可配置为指示机器人2以定位环境10中存在的物体1a,抓取物体1a,对所述物体1a执行一个或多个操作,然后将其存储在环境10中的位置。

55.指令块3可包括计算机或其他设备,其配置允许操作员输入所述指令。

56.或者,指令块3至少可以部分可穿戴(图1),以便操作员模拟操作,然后根据操作员的动作向机器人2发送所述指令。它可以包括可视化装置31,其配置成向操作员显示传感器23采集到的至少部分参数;以及采集装置32,其配置成采集操作员所做的动作,并向机器人2发送必要的指令,以便机器人重复上述动作。

57.采集装置32可包括感应手套,其配置成检测操作员的手部动作,并向机器人2发送指令,以便允许末端执行器21执行所述手部动作。

58.另外,装置32还可以包括感应装置,其配置成检测操作员的动作,然后向机器人2发送指令,以便执行所述动作。

59.指令块3可以包括至少一个摄像头33,查看器31可以包括屏幕(例如虚拟眼镜),其用于查看摄像头拍摄的画面。

60.摄像头33可以集成到机器人2中(图1)。

61.另外,摄像头33也可以集成到房间10中。指令块3优选包括每个房间11的至少一个摄像头33,摄像头33配置成捕捉房间中的物体1a和/或机器人。

62.交互过程1可包括至少一个标记4,该标记可由传感器23检测,通过检测机器人2在特定点(例如两个房间11之间、房间中的一个物体、(和/或同一房间中的区域之间)的通过情况来识别机器人2的路径。

63.交互过程1可以包括与每个通道部分12相关联的标记4,以便传感器23检测所述通道部分12的通过情况。

64.替代地或附加地,也可以包括至少一个与每个房间11相关联的标记4,以便传感器23检测机器人2是否进入所述房间11。

65.或者,除了一个或多个标记4之外,机器人2还可以通过传感器23探测自身路径,传感器23配置为获取并识别路径上的要素(如家具、门或物体1a)。然后,机器人根据其相对于所述传感器23检测到的一个或多个元件的位置,检测自己的路径。

66.过程1可包括机器人2控制计算机5。或者,它包括多个机器人2和控制所述机器人2的计算机5。

67.计算机5可配置为根据传感器23(即从中获取的一个或多个参数)和下文所述指令控制末端执行器21(优选是驱动器22)。

68.它可以与机器人2以及电路板25和/或传感器23进行数据连接。

69.计算机5可以与指令块3进行数据连接。

70.计算机5可配置为根据场景结束指令将动作分割成一系列场景。特别是,它可以以每个场景结束指令将一个动作分割成多个场景。

71.场景结束指令可以自动和/或手动发出。

72.在自动下达场景结束指令的情况下,计算机5可以包括时钟,该时钟配置为在执行真实/虚拟动作(如下所述)期间测量时间的流逝,然后在流逝的时间与场景持续时间基本相等时下达场景结束指令。

73.在手动下达场景结束指令的情况下,计算机5可以通过块3在检测到操作员执行的指令操作(例如,将位置保持至少一个时间阈值)后下达场景结束指令。或者,块3可以包括信号器(如按钮),当操作员希望发送场景结束命令时,可将其激活。

74.另外,也可以通过机器人2检测到标记4或通过传感器23识别环境10中的要素来发出自动结束场景的指令。

75.计算机可包括下文所述的动作数据库。

76.交互过程1可包括至少一个学习阶段6,其中指令块3定义虚拟动作,机器人2在该虚拟动作中移动末端执行器21,计算机5根据所述虚拟动作命令机器人2执行实际动作,传感器23在执行实际动作期间获取一个或多个参数。

77.虚拟动作包括一条或多条指令,确定机器人2在学习阶段根据从指令块3接收到的指令所要学习的动作。

78.真实动作包括机器人2根据虚拟动作指令执行的一个或多个移动。真实动作的移

动按照虚拟动作的指令顺序执行。因此,真实动作可以与虚拟动作相似,并且可选的与其相同。

79.真实动作可以是模拟的(机器人2不移动和/或不操纵一个或多个物体1a)和/或真实的(机器人2移动和/或操纵一个或多个物体1a)。优选是真实的。

80.交互过程1优选包括多个学习阶段6。因此,块3可以定义多个虚拟动作,这些虚拟动作优选至少部分彼此不同,从而使机器人2执行多个真实动作。

81.每个学习阶段6可包括模拟子阶段61,其中指令块3定义了机器人2移动末端执行器21的虚拟动作。

82.在模拟子阶段61中,指令块3定义虚拟动作,并向机器人2发送执行与所述虚拟动作相对应的实际动作所需的指令。

83.在某些情况下,虚拟动作可能包括与机器人在两个或多个房间11之间适当通过至少一个通道部分12有关的指令。

84.可选择在模拟子阶段61中发出一个或多个场景结束指令。

85.学习阶段6可包括重复子阶段62,在该阶段中,计算机5命令机器人2根据所述虚拟动作执行实际动作。

86.在重复子阶段62中,计算机5命令机器人2执行一个或多个移动,这定义根据虚拟动作的指令的真实动作。

87.优选在子阶段62中,计算机5命令机器人2基本重复虚拟动作中的动作。因此,真实动作与虚拟动作基本相同。

88.在重复子阶段62中,机器人2可以通过至少一个通道部分12从一个房间11移动到另一个房间(如果在虚拟动作中提供)。

89.学习阶段6可包括获取子阶段63,其中传感器23在重复子阶段62期间获取一个或多个参数。

90.在子阶段63中,传感器23可获取其他环境参数(如环境10的亮度、压力和/或温度)和/或一个或多个交互参数,如末端执行器21的抓力和/或施加于其上的力。

91.在采集子阶段63中,传感器23优选至少能获取物体1a的环境参数(例如形状和/或颜色),以便允许机器人2检测环境10中是否存在物体1a。

92.另外,传感器23还可获取至少一个标记4,以便允许计算机识别所执行的路径。或者,除了一个或多个标记4之外,传感器23还可以获取环境10中的一个或多个要素,机器人2根据其相对于所述传感器23检测到的一个或多个要素的位置确定自己的路径。

93.在采集子阶段63中,传感器23可以获取机器人2的动作,从而定义必要的指令,以确定机器人2随后必须执行的动作,从而重复上述动作。

94.采集子阶段63最后向计算机5发送采集参数、一个或多个场景结束指令以及与机器人2的运动有关的铭文(inscription)。

95.子阶段61、62和63几乎可以同时进行。

96.交互过程1可以包括分析阶段7,在该阶段中,学习阶段6中执行的每个实际动作都被分解成一系列场景。

97.在分析阶段7,计算机5可以根据至少一个结束场景指令,将每个真实动作适当分割为初始场景、结束场景,优选还有至少一个介于初始场景和结束场景之间的场景。

98.计算机5可将一个或多个用于机器人2的指令与每个场景关联起来,这些指令定义了机器人要执行的操作。所述指令是根据采集子阶段63中检测到的机器人2的运动来定义的。

99.在某些情况下,初始场景可能与指令无关。

100.计算机5可以在学习阶段6并具体来说在场景开始时,即接收到场景结束指令后立即将至少一个与场景执行过程中获得的参数(环境和/或交互)相对应的值与每个场景关联起来。

101.在本文中,术语“值”指的是由传感器23在学习阶段6中记录并适当存储在下面的动作数据库中的参数。

102.计算机5优选将在学习阶段6获取的每个参数值关联到每个场景。

103.交互过程1可以包括再处理阶段8,在该阶段中,计算机5通过将与初始场景相关联的至少一个值基本相同的实际动作相互关联来创建动作数据库,从而定义由单个初始场景和多个最终场景组成的复合动作。

104.优选是将具有相同值的初始场景,并且可选地,相同指令的实际操作相互关联。

105.最终场景的数量可能与组合在一起的真实动作的数量基本相等。

106.如果有一个或多个中间场景,其中两个或多个场景只有在具有基本相同的指令和可选的相同值时才能合并。

107.概括地说,复合动作只有一个初始场景,从初始场景分支出多个最终场景。如果存在,中间场景可以识别连接每个最终场景和初始场景的一个或多个分支。

108.在动作数据库中,每个场景都可以与机器人2的一个或多个指令相关联。

109.复合动作的每个场景可与至少一个值相关联,即与传感器23在实际动作的每个学习阶段6的场景执行过程中获取的一个或多个参数相关联,实际动作在所述复合动作中合并。具体来说,在不同的学习阶段6中执行场景时,对于同一传感器检测到的每个参数,如果这些参数几乎相等,则场景只与一个值相关联;而如果这些参数彼此不同,则场景与多个值相关联,每个值对应于传感器在学习阶段6中检测到的参数。

110.场景的每个值都与该场景之后的至少一个场景相关联,以便确定场景的执行顺序。在本文件中,词语“下一个场景”指与给定场景相邻或紧接着给定场景的场景。

111.如果同一个传感器检测到的参数有不同的值,则每个值只能与以下场景的一部分相关联。具体来说,在复合动作的备选场景之间的分岔口上游的至少一个场景可以与值相关联,每个值只与后续备选场景的一部分(具体来说只与一个)相关联,这样机器人2就可以根据所述值确定要执行哪个备选场景。

112.交互过程1可以包括执行阶段9,在该执行阶段中,机器人2以适当的自动模式执行动作数据库中的一个动作。

113.详细而言,在执行阶段9中,传感器23通过检测所述至少一个参数定义初始因子,计算机5在动作数据库中选择初始值与初始因子基本相等的复合动作,并命令机器人2根据所识别复合动作的初始场景之后的场景执行操作;计算机5命令机器人2在与所选复合动作相关联的下一个场景中执行下一个要执行的操作,其通过将动作数据库中与下一个场景之前的一个或多个场景相关联的至少一个值(因此仍要执行),与通过检测下一个场景之前的一个或多个操作中的至少一个参数而获得的至少一个因子进行比较。

114.在本文中,术语“因子”指的是执行阶段9中传感器23记录的参数。

115.执行阶段9可以包括采集子阶段91,在该采集子阶段中,传感器23通过检测所述至少一个参数来定义至少一个初始因子。

116.初始因子在机器人2启动时获得,即在它执行任何动作之前。

117.优选是在采集子阶段91中,传感器23获取所有参数,然后为每个参数定义初始因子。

118.在采集子阶段91中,机器人2可基本静止。

119.执行阶段9可包括待执行复合操作的识别子阶段92。

120.在识别子阶段92中,计算机5在动作数据库中选择具有与所述初始因子基本相等的初始值的复合动作。具体来说,计算机5在动作数据库中选择具有与子阶段91中定义的所有初始因子基本相等的初始值的复合动作。

121.确定复合动作后,计算机3将结束发展(development)子阶段93,并命令机器人2执行初始场景之后的场景;

122.执行阶段9可包括至少一个发展子阶段93,在该发展子阶段中,机器人2根据所识别的场景,特别是根据与之相关的指令执行操作。

123.因此,执行阶段9可包括至少一个选择子阶段94,在该选择子阶段中,计算机5在组成动作的场景中识别出要执行的下一个场景,然后命令机器人2根据所述下一个场景执行操作。

124.在该子阶段94中,计算机5在之后的场景中识别出下一个在接下来的发展子阶段93中适当执行的场景。

125.这种选择可以通过将所述下一个场景之前的至少一个场景的至少一个值与迄今为止所执行的操作中定义的一个或多个因子进行比较来实现。下一个要执行的场景可能是与至少一个前置场景的一个或多个值相连的场景,该至少一个前置场景的一个或多个值与前面操作中检测到的参数对应的一个或多个因子基本相等。

126.可以从初始动作和场景开始,对所有动作和场景进行这种值-因子的比较。

127.确定下一个场景后,计算机5命令机器人2按照下一个场景执行操作,然后执行新的发展子阶段93和新的选择子阶段94。

128.当在选择子阶段94中选择最终场景作为下一个场景,然后在下一个发展子阶段93中根据所述最终场景执行最终操作时,执行阶段9结束。

129.为了说明过程,我们举例说明交互1过程的应用。

130.最初,该过程设想执行两个学习阶段6,即由模拟61、重复62和采集63的第一子阶段组成的第一阶段6和由模拟61、重复62和采集63的第二子阶段组成的第二学习阶段6。

131.在第一模拟子阶段61中,操作员通过指令块3模拟第一虚拟动作,包括定位到玻璃杯,从第一个房间12拿起空玻璃杯,到达第二个房间12,用卡拉夫瓶(carafe)倒满玻璃杯,并将玻璃杯放在托盘上。在虚拟动作的每个部分结束时,操作员会发出场景结束指令,在本例中定义了五个场景。

132.与第一子阶段61同时进行的还有第一重复子阶段62,机器人2在计算机5的引导下,根据从块3接收到的信号,重复上述动作;以及第一采集子阶段63,在第一采集子阶段中,传感器23优选依次采集识别玻璃杯的参数;玻璃杯拾取指令和空玻璃杯的重量;房间更

换指令12(识别一个或多个元件和/或一个或多个标记4);壶识别参数和玻璃杯填充指令;最后是托盘识别参数(物体放置位置1a)和将玻璃杯放在托盘上的指令。

133.第一学习阶段6完成后,过程规定进入第二学习阶段6。

134.在第二模拟子阶段61中,操作员通过指令块3模拟第二虚拟动作,包括:找到玻璃杯,从第一房间12拿起满的玻璃杯,到达第二房间12并将玻璃杯放在托盘上。在第二虚拟动作的每个部分结束时,操作员发出场景结束指令,在第二个示例中定义了四个场景。

135.与第二子阶段61同时进行的是第二重复子阶段62,机器人2在计算机5的引导下,根据来自块3的信号,重复上述动作;以及第二采集子阶段63,在其中,传感器23优选依次获取玻璃杯识别参数、玻璃杯拾取指令和满玻璃杯重量、房间更换指令12以及托盘识别参数和将玻璃杯放在托盘上的指令。

136.在完成所有阶段6之后,交互过程1将进入分析阶段7,在这一阶段中,将根据场景结束指令将两个动作划分为多个场景,并在每个场景中获取相关指令和参数。

137.第一真实动作被细分为定位玻璃杯的初始场景、从第一个房间12拿起空玻璃杯的第一中间场景、到达第二房间12的第二中间场景、用卡拉夫瓶倒满玻璃杯的第三中间场景以及将玻璃杯放在托盘上的最终场景。

138.第二真实动作被细分为定位玻璃杯的初始场景、从第一房间12拿起装满的玻璃杯的第一个中间场景、到达第二房间12的第二中间场景和将玻璃杯放在托盘上的最终场景。

139.此时需要对场景进行阶段8的再处理,然后创建动作数据库。

140.在本例中,由于初始场景相同,因此定义了包含两个最终场景的复合动作,并在第二中间场景的末尾具体说明了分支。

141.确切地说,复合动作提供了与“玻璃杯识别”值相关联的初始场景;与拾取指令和两个值(满玻璃重量和空玻璃重量)相关联的第一中间场景,以及与房间12变化指令(检测环境10中的一个或多个标记4和/或一个或多个元素)相关联的第二中间场景。因此,复合动作提供了分支(即执行不同操作的可能性)。在分支的第一分支中,复合动作包括与装杯相关的第三场景和在托盘上摆放杯子的最终场景;而在第二分支中,复合动作只包括在托盘上摆放杯子的最终场景。

142.第一分支与第一中间场景的空杯重量值相关联,第二分支与第一中间场景的满杯重量值相关联。

143.此时,可进入执行阶段9。

144.在采集子阶段91,传感器23检测/识别玻璃杯,从而确定相应的初始因子。

145.在识别子阶段92中,计算机5在动作数据库中搜索具有初始值基本等于所述初始因子的初始场景的复合动作,并命令执行初始场景之后的场景,即第一中间场景。需要注意的是,只有在检测到与动作数据库中存在的初始值相对应的初始因子时,子阶段91和92才能结束。

146.然后是发展子阶段93,根据第一中间场景,机器人2执行拾取玻璃杯(例如满杯)的操作,传感器23获取与玻璃杯重量相关的因子。

147.此时,计算机5将在第一中间场景之后的场景中(即在一个或多个第二中间场景中)搜索与获得的因子相关的场景,这就是选择子阶段94。在这种情况下,由于只存在第二中间场景,计算机5发出执行命令。

148.然后,执行阶段9提供新的执行子阶段93,在该阶段中,机器人2根据第二中间场景执行操作。然后从第一房间12移动到第二房间12,传感器23采集与标记4和/或检测到的要素相对应的采集的因子。

149.由于最终场景还没有完成,因此会出现新的选择子阶段94,在这个阶段中,计算机5会在第二中间场景之后的场景中搜索与采集的因子相关联的场景。

150.由于有两个可能的连续场景,计算机3会在之前操作中采集的因子中搜索哪个场景(即第二中间场景、第一中间场景和初始场景)的值与相应子阶段93中采集的因子相对应。具体来说,它通过在第一子阶段识别对“满玻璃杯”因子的检测,检测出相应的值与第二情况的最终场景相关联,将第二情况的最终场景识别为下一个场景,并命令执行该场景。

151.执行阶段9提供了根据最终场景执行操作的新子阶段93。具体来说,机器人2在房间12中寻找托盘,识别托盘并将玻璃杯放回托盘上。

152.在这一发展子阶段93结束时,第9阶段也就结束了,因为已确定的复合行动的最终场景已经执行了。

153.本发明的交互过程1具有重要的优势。

154.事实上,过程1可以以实用、快速的方式对机器人2发出指令,最重要的是可以快速更新特定动作数据库。

155.与操作数据库的创建和使用有关的另一个优势在于,交互过程1可以在不使用复杂和昂贵的结构的情况下,管理多种不同的操作,而不会在识别要执行的正确操作时出现错误。

156.这一优势还可以转化为以精确、简单和快速的方式同时控制多个机器人2的可能性。

157.另一个优点是机器人2的指令简单。

158.因此,另一个优势在于交互过程1的高度灵活性,事实上,它不需要不断地重新编程,因为传感器23的特别使用使机器人2能够适应要执行的动作和/或与之交互的物体1a的变化。例如,事实上,机器人2能够识别物体1a,而不论其在环境10和/或定位场所中的位置如何,因此能够快速适应任何工作条件,从而以最快的速度移动定位物体1a。

159.本发明可在权利要求书所定义的发明概念范围内进行修改。

160.例如,至少在交互过程1中,卡24和计算机5可以重合。

161.此外,在选择子阶段63中选择下一个场景时,计算机可以选择与至少一个先前操作中获得的因子最接近的值相关联的场景作为下一个场景。

162.在某些情况下,指令可能只确定物体1a和/或机器人2的最终位置。因此,机器人2将根据传感器23采集的参数,自动确定要执行的动作,以达到最终位置。例如,指令可以确定物体1a在场地上的位置,然后机器人2将自行决定执行哪些动作来将所述物体1a布置在所述场地上。

163.在某些情况下,传感器23可包括摄像头,显示屏31可显示摄像头的画面。

164.在这样的实施方案中,所有细节都可以用等效元件替换,材料、形状和尺寸也可以任意选择。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1