提供精准眼动追踪的光学系统和相关方法与流程

1.本发明涉及一种提供精准眼动追踪的光学系统和相关方法,特别是涉及一种能在互动式虚拟环境中提供精准眼动追踪的光学系统和相关方法。

背景技术:

2.虚拟现实(virtual reality,vr)是利用计算机技术模拟出一个立体且高拟真的三维空间,当用户穿戴特殊显示设备执行vr应用时会产生好像处在现实中的错觉。扩增现实(augmented reality,ar)是一种将虚拟信息扩增到现实空间中的技术,相较于取代现实空间的vr,ar是在现实空间中添加虚拟对象。混合现实(mixed reality,mr)则是把现实世界与虚拟世界合并在一起,从而建立出一个新的环境以及符合一般视觉上所认知的虚拟图像,其中现实世界中的对象能够与数字世界中的对象共同存在并且实时的产生互动。现有vr/ar/mr的应用多半是通过双手控制摇杆或是触控面板来操作,但在不同场所需要随时携带这些控制装置,在使用上并不便利。若是将眼动追踪(eye-tracking)的技术应用在vr/ar/mr领域,用户可轻易地将眼睛变成操作界面,通过眼睛注视点、聚焦点和特定细微动作即可完成选取或点击对象的动作。

3.眼动追踪是一种能通过测量眼睛的注视位置或眼球相对头部的运动,来追踪用户眼球运动的技术。现有计算机会在显示屏幕上呈现一用户界面(user interface),以提供用户各种视觉数据。上述数据呈现方式会受限于用户的主动视觉和显示屏幕的尺寸。举例来说,用户因其生理特征(例如眼睛构造)可能会具备较窄的主动视觉,而行动式装置多半需要在很小的屏幕(虚拟可视范围)上呈现大量数据。

4.因此,需要一种能在互动式虚拟环境中提供精准眼动追踪的光学系统和方法。

技术实现要素:

5.本发明提供一种提供精准眼动追踪的光学系统,其包含一眼动追踪仪和一头戴式显示器。该眼动追踪仪包含一传感器模块,用来捕捉一用户的一个或多个眼睛影像。该头戴式显示器包含一第一处理器和一显示屏幕。该第一处理器用来控制该头戴式显示器的运作,并提供一用户界面。该显示屏幕用来呈现该用户界面,其中该用户界面包含一虚拟可视范围和至少一用户界面对象,该至少一用户界面对象用来接收一注视指令,且该注视指令相关于该用户的一个或多个注视点,且该至少一用户界面对象被安排在该用户的一预估可视范围内,且位于该用户界面的该虚拟可视范围之外。

6.本发明还提供一种提供精准眼动追踪的方法,其包含捕捉一用户的一个或多个眼睛影像,依据该一个或多个眼睛影像来计算出该用户的一个或多个注视点,以及提供一用户界面。其中,该用户界面包含一虚拟可视范围和至少一用户界面对象,且该至少一用户界面对象被安排在该用户的一预估可视范围内,且位于该用户界面的该虚拟可视范围之外。

附图说明

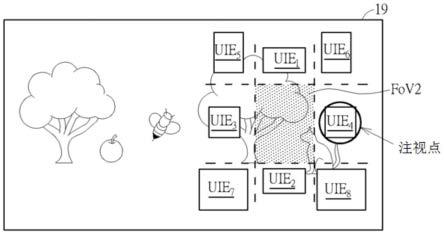

7.图1为本发明实施例中一种可在互动虚拟环境中提供精准眼动追踪的光学系统的功能方块图。图2为本发明另一实施例中一种可在互动虚拟环境中提供精准眼动追踪的光学系统的功能方块图。图3为本发明实施例中可在互动虚拟环境中提供精准眼动追踪的光学系统运作时的方法流程图。图4为本发明实施例中在光学系统运作时所呈现的用户界面的示意图。图5为本发明实施例中在光学系统运作时所呈现的用户界面的放大示意图。图6为本发明实施例光学系统中用户界面对象的功能的示意图。附图标记说明如下:10:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

头戴式显示器12、22:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

处理器14:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

显示屏幕16、26:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

传感器模块18:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

输入/输出装置19:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

用户界面20:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

眼动追踪仪24:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

照明模块30:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

用户100、200:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

光学系统310-360:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

步骤uie

1-uien:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

用户界面对象fov1:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

用户的可视范围fov2:

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

用户界面的虚拟可视范围

具体实施方式

8.图1为本发明实施例中一种可在互动虚拟环境中提供精准眼动追踪的光学系统100的功能方块图。图2为本发明另一实施例中一种可在互动虚拟环境中提供精准眼动追踪的光学系统200的功能方块图。

9.在图1所示的实施例中,光学系统100包含一头戴式显示器(head-mounted display,hmd)10和一眼动追踪仪20。头戴式显示器10包含一处理器12、一显示屏幕14、一传感器模块16、一输入/输出装置18,以及一用户界面19。眼动追踪仪20包含一处理器22、一照明模块24,以及一传感器模块26。处理器12可控制头戴式显示器10的运作,而处理器22可控制眼动追踪仪20的运作。

10.在图2所示的实施例中,光学系统200为一头戴式显示器10,其包含一处理器12、一显示屏幕14、一传感器模块16、一输入/输出装置18、一用户界面19,以及一眼动追踪仪20。眼动追踪仪20包含一处理器22、一照明模块24,以及一传感器模块26。眼动追踪仪20包含一处理器22、一照明模块24,以及一传感器模块26。处理器12可控制头戴式显示器10的运作,

而处理器22可控制眼动追踪仪20的运作。

11.在本发明其它实施例中,光学系统100和200可省略处理器22。更详细地说,头戴式显示器10和眼动追踪仪20可共享同一处理器12,并由处理器12来控制头戴式显示器10和眼动追踪仪20的运作。

12.图3为本发明实施例中可在互动虚拟环境中提供精准眼动追踪的光学系统100和200运作时的方法流程图。图3所示的方法流程图包含下列步骤:

13.步骤310:捕捉用户的一个或多个眼睛影像。

14.步骤320:依据一个或多个眼睛影像来计算出用户的一个或多个注视点。

15.步骤330:求出显示屏幕14的可视范围(field of view)和用户的预估可视范围之间的关系。

16.步骤340:依据用户的一个或多个注视点和显示屏幕14的可视范围和用户的预估可视范围之间的关系来提供包含一虚拟可视范围和至少一用户界面对象的用户界面。

17.步骤350:接收一个或多个用户指令。

18.步骤360:当至少一用户界面对象被用户的一个或多个注视点触发时,执行对应至少一用户界面对象的一预定动作;执行步骤310。

19.在光学系统100中,眼动追踪仪20中的传感器模块26包含至少一个影像传感器(眼睛传感器),用来在步骤310中捕捉用户的一个或多个眼睛影像。眼动追踪仪20中的处理器22可接收传感器模块26所捕捉的一个或多个眼睛影像,并在步骤320中依据一个或多个眼睛影像来计算出用户的一个或多个注视点。此外,眼动追踪仪20中的处理器22还可依据一个或多个眼睛影像来计算出其它眼动追踪相关数据,例如预估注视点的信心度和准确度、在三维空间内的眼球位置和瞳孔相关信息(例如瞳孔大小)。眼动追踪运作的算法可实作成能被眼动追踪仪20中的处理器22执行的程序/软件/固件,但不限定本发明的范围。

20.在光学系统200中,眼动追踪仪20中的传感器模块26包含至少一个影像传感器(眼睛传感器),用来在步骤310中捕捉用户的一个或多个眼睛影像。处理器12可接收传感器模块26所捕捉的一个或多个眼睛影像,并在步骤320中依据一个或多个眼睛影像来计算出用户的一个或多个注视点。此外,处理器12还可依据一个或多个眼睛影像来计算出其它眼动追踪相关数据,例如预估注视点的信心度和准确度、在三维空间内的眼球位置和瞳孔相关信息(例如瞳孔大小)。眼动追踪运作的算法可实作成能被处理器12执行的程序/软件/固件,但不限定本发明的范围。

21.在光学系统100和200中,传感器模块16包含至少一场景传感器、至少一声音传感器(例如麦克风),及/或至少一动作传感器(例如陀螺仪或加速度计)。场景传感器可捕捉相关于用户的目前可视范围的一个或多个场景影像,声音传感器可接收用户下达的语音指令,而动作传感器可侦测用户的动作(通常是头部动作)。

22.在光学系统100和200中,照明模块24可包含一个或多个红外光发光二极管(light-emitting diode,led),用来照亮用户双眼,以确保不同眼色的用户在虹膜和瞳孔之间能有足够对比,尤其是在非常亮或非常暗的背景下,进而提升眼动追踪仪20捕捉用户双眼反射光线时的精准度。然而,照明模块24的实施方式并不限定本发明的范围。

23.在步骤330中,处理器12可求出显示屏幕14的可视范围和用户的预估可视范围之间的关系。用户的预估可视范围是指当用户正视前方时的可视范围,可依据光学系统100或

200的物理规格和用户的标准人体测量数据来计算出。随着用户的眼球运动,用户的实际可视范围会和用户的预估可视范围有所偏移。显示屏幕14的可视范围和用户的预估可视范围之间的关系至少包含显示屏幕14的可视范围和用户的该预估可视范围之间的面积比,其中上述面积比的值小于1。显示屏幕14的可视范围和用户的预估可视范围之间的关系可还包含显示屏幕14对应用户的预估可视范围的一相对位置,其中上述相对位置可依据头戴式显示器10的物理规格和用户的标准人体测量数据来计算出。在一实施例中,处理器12还可依据相关一个或多个眼睛影像的眼动追踪相关数据来微调上述相对位置。

24.在光学系统100或200中,包含一虚拟可视范围(virtual field of view)和一个或多个用户界面对象(ui elemement)uie

1-uien的用户界面19可呈现在显示屏幕14上,其中n为正整数。在一实施例中,用户界面对象uie

1-uien可为用户看不见的抽象对象。如果用户界面对象uie

1-uien为互动对象,每一用户界面对象会连接至一事件处理器,其中每一事件处理器相关于光学系统100或200的一特定运作,且由控制器12来掌控。

25.用户界面对象uie

1-uien可增加用户界面19的互动性,并提供用户下达眼动指令的接触点。每一用户界面对象的功能可相关于输入控制、浏览控制和信息显示,但不限定本发明的范围。每一用户界面对象包含一图像对象和一命中框(hit box)。图像对象可决定相对应用户界面对象的外观,且可相关于相对应用户界面对象的功能。在一实施例中,用户界面对象的图像对象可为相关输入控制的复选框(checkbox)、单选钮(radio button)、下拉式选单(dropdown list)、列表盒(list box)、开关按钮(toggle button)或日期/时间选项。在另一实施例中,用户界面对象的图像对象可为相关浏览控制的页面路径(breadcrumb)、滑动选单(slider)、分页选单(pagination)、图标(icon)或图像轮播(image carousel)。在另一实施例中,用户界面对象的图像对象可为相关信息显示的工具提示框(tooltip)、进度条(progress bar)、提示通知(notification)、对话框(message box)或互动窗口(modal window)。然而,用户界面对象的图像对象的外观并不限定本发明的范围。

26.用户界面对象的命中框为用户看不见的虚拟对象,其连接至相对应事件处理器。当关于用户的一个或多个注视点的一注视指令触发一用户界面对象的命中框时,处理器12会执行对应被触发用户界面对象的动作。在满足一个或多个触发条件时,本发明会判定用户界面对象被注视指令触发。上述触发条件包含下列至少一条件:在用户的一个或多个注视点位于一用户界面对象的命中框内后,用户立即或在一预定时间间隔内通过输入/输出装置18或传感器模块16(例如麦克风)加以确认;当用户的一个或多个注视点位于一用户界面对象的命中框内超过一预定凝视时段时;在用户的一个或多个注视点位于一用户界面对象的命中框后,用户立即或在一预定时间间隔内通过自主性眼动(例如眼球扫视或眨眼)加以确认;以及当包含用户的一个或多个注视点的一注视轨迹通过一用户界面对象的命中框的反应边界时。然而,相关每一用户界面对象的触发条件类型并不限定本发明的范围。

27.在光学系统100或200中,输入/输出装置18可接收用户下达的指令。在一实施例中,输入/输出装置18可包含任何种类的手持式控制器(例如游戏手柄或游戏机)及/或任何形式的触觉回馈装置(例如体感套装或体感手套)。输入/输出装置18可侦测用户的动作信号,并将用户的动作信号传送至光学系统100或200的控制器12。在一实施例中,控制器12可依据输入/输出装置18接收到的用户指令来控制光学系统100或200的运作。在另一实施例中,控制器12可同时依据输入/输出装置18接收到的用户指令和用户界面19的用户界面对

象uie

1-uien接收到的注视指令来控制光学系统100或200的运作。

28.在步骤340中,处理器12可依据用户的一个或多个注视点和显示屏幕14的可视范围和用户的预估可视范围之间的关系来提供用户界面19,其中用户界面19包含虚拟可视范围和至少一用户界面对象。

29.图4为本发明实施例中在光学系统100和200运作时所呈现的用户界面19的示意图。fov1代表一用户30的可视范围,而fov2代表光学系统100和200中用户界面19的虚拟可视范围。

30.图5为本发明实施例中在光学系统100和200运作时所呈现的用户界面19的放大示意图。在本发明中,用户界面对象uie

1-uien被安排在用户30的可视范围fov1内,且位于用户界面19的虚拟可视范围fov2之外的不同区域。为了说明目的,图5显示了n=8的实施例。用户界面对象uie1呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第一区域,且第一区域位于用户界面19的虚拟可视范围fov2的上方。用户界面对象uie2呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第二区域,且第二区域位于用户界面19的虚拟可视范围fov2的下方。用户界面对象uie3呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第三区域,且第三区域位于用户界面19的虚拟可视范围fov2的左方。用户界面对象uie4呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第四区域,且第四区域位于用户界面19的虚拟可视范围fov2的右方。用户界面对象uie5呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第五区域,且第五区域位于用户界面19的虚拟可视范围fov2的左上方。用户界面对象uie6呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第六区域,且第六区域位于用户界面19的虚拟可视范围fov2的右上方。用户界面对象uie7呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第七区域,且第七区域位于用户界面19的虚拟可视范围fov2的左下方。用户界面对象uie8呈现在可视范围fov1内并位于虚拟可视范围fov2之外的一第八区域,且第八区域位于用户界面19的虚拟可视范围fov2的右下方。

31.如图4和图5所示,头戴式显示器10中用户界面19的虚拟可视范围fov2仅占据用户30的可视范围fov1内的极小区域,其有限的数据显示量会限制基于眼动的用户互动。由于眼动追踪仪20中传感器模块26取得的眼动信息(更精确地说,用户的注视点)可位于用户30的可视范围fov1内的任何位置,本发明的光学系统100和200会将用户界面对象uie

1-uien显示在用户界面19的虚拟可视范围fov2之外的区域。如此一来,用户界面对象uie

1-uien的设置会更具弹性,且不会被虚拟可视范围fov2的有限面积所局限。此外,用户界面19的虚拟可视范围fov2也能显示更多影像数据。

32.在步骤350中,光学系统100和200会接收一个或多个用户指令。如前所述,本发明可通过输入/输出装置18来接收用户指令,或通过用户界面19的用户界面对象uie

1-uien来接收注视指令。在满足一个或多个触发条件时,本发明会判定用户界面对象被注视指令触发。当一特定用户界面对象的命中框接受到用户的一注视指令,且该注视指令满足一个或多个触发条件时,处理器12会执行对应特定用户界面对象的一预定动作。上述触发条件包含用户的注视点位于特定用户界面对象的命中框内超过相关特定用户界面对象的凝视时段、用户按下另一按键、用户下达一语音指令、用户自主性地眨眼,或侦测到特定注视点轨迹/模式,但不限定本发明的范围。上述预定动作包含内容选择、往前一页、往后一页、设定、

关闭页面、返回、回主页、显示通知信息或屏幕锁定,但不限定本发明的范围。

33.图6为本发明实施例光学系统100和200中用户界面对象uie

1-uien的功能的示意图。当用户界面对象uie1被触发时,光学系统100和200可在用户界面19的虚拟可视范围fov2内显示一设定选项。当用户界面对象uie2被触发时,光学系统100和200可让用户30返回用户界面19的首页。当用户界面对象uie3被触发时,光学系统100和200可将用户界面19的虚拟可视范围fov向左方滑动(上一页)。当用户界面对象uie4被触发时,光学系统100和200可将用户界面19的虚拟可视范围fov向右方滑动(下一页)。当用户界面对象uie5被触发时,光学系统100和200可让用户30返回上次浏览的页面或屏幕。当用户界面对象uie6被触发时,光学系统100和200可终止目前执行中的应用程序。当用户界面对象uie7被触发时,光学系统100和200可锁定用户界面19的目前状态。当用户界面对象uie8被触发时,光学系统100和200可在用户界面19的虚拟可视范围fov2内显示一通知版。然而,用户界面19中每一用户界面对象的功能并不限定本发明的范围。

34.在本发明中,光学系统会将一个或多个用户界面对象显示在用户界面的虚拟可视范围之外的区域,以提供基于眼动的用户互动功能。如此一来,用户界面对象的设置会更具弹性,且不会被用户界面的虚拟可视范围的有限面积所局限。此外,用户界面的虚拟可视范围也能显示更多影像数据。因此,本发明可提供一种能在互动式虚拟环境中提供精准眼动追踪的光学系统和方法。以上所述仅为本发明的较佳实施例,凡依本发明权利要求所做的均等变化与修饰,都应属本发明的涵盖范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1