一种歌声合成模型的训练方法、装置、设备和存储介质与流程

1.本发明涉及音频处理技术领域,尤其涉及一种歌声合成模型的训练方法、装置、设备和存储介质。

背景技术:

2.随着科技的不断进步,音频处理技术也不断的发展,端到端的语音合成系统已经逐渐成熟并且在语音合成领域得到了广泛的应用。但是,随着用户需求的不断变化,在一些电子消费品和娱乐应用程序中,用户不但希望可以合成语音,还希望合成歌曲,这就需要训练一个具有歌曲合成能力的模型。

3.在训练歌曲合成模型时,将乐谱信息和歌词作为条件输入到歌曲合成模型,使歌曲合成模型输出预测歌曲,然后使用乐谱信息对应的真实歌曲以及歌曲合成模型输出的预测歌曲对歌曲合成模型进行调整,最终通过大量训练获得高质量的歌曲合成模型。但是,目前在歌曲合成模型时,对于训练样本的要求较高,真实歌曲需要专业歌手录制而成,如果采用普通用户录制的歌曲训练模型,会因为普通用户缺少专业训练,歌唱效果差且音色不稳定,导致录制的歌曲质量较差,进而造成歌曲合成模型的合成效果极差。

4.这样,现有歌曲合成模型只能用于合成歌曲,无法合成具有普通用户的个性化音色的歌声。

技术实现要素:

5.本发明的主要目的在于提出一种歌声合成模型的训练方法、装置、设备和存储介质,旨在解决现有的歌曲合成模型无法合成具有普通用户的个性化音色的歌声的问题。

6.为实现上述技术问题,本发明是通过以下技术方案来实现的:

7.本发明实施例提供了一种歌声合成模型的训练方法,包括:获取预先训练的歌声合成模型;采集目标用户输入的语音信息;获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

8.其中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型;所述重训练所述歌声合成模型,包括:使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息;使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征;预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值;如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

9.其中,所述使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,

生成曲谱信息,包括:针对所述语音信息中的每个音节,根据所述音节对应的基频确定所述音节对应的音高,并且,根据所述音节对应的时长确定所述音节对应的时值;根据所述语音信息中的每个音节对应的音高和时值,生成曲谱信息。

10.其中,在所述声学模型中包括:顺序连接的编码器,时长模型和解码器;所述使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征,包括:使所述编码器将所述文本信息和所述曲谱信息融合为歌谱信息;使所述时长模型为所述歌谱信息中每个音节的各个音素对应分配时长;使所述解码器根据歌谱信息以及所述歌谱信息中每个音节的各个音素对应的时长,映射声学特征。

11.其中,所述获取所述语音信息对应的文本信息,包括:针对所述语音信息执行语音识别处理,得到并获取所述语音信息对应的文本信息;或者,获取所述目标用户在输入所述语音信息时采用的文本信息。

12.其中,在所述重训练所述歌声合成模型之后,还包括:接收目标歌谱信息;所述目标歌谱信息包括:歌词文本以及所述歌词文本中的每个音节对应的音高和时值;将所述目标歌谱信息输入重训练完成的所述歌声合成模型,以便所述歌声合成模型根据所述目标歌谱信息合成具有所述目标用户的音色的歌曲音频。

13.本发明实施例还提供了一种歌声合成模型的训练装置,包括:获取模块,用于获取预先训练的歌声合成模型;采集模块,用于采集目标用户输入的语音信息;提取模块,用于获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;训练模块,用于根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

14.其中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型;所述训练模块,用于:使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息;使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征;预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值;如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

15.本发明实施例还提供了一种歌声合成模型的训练设备,所述歌声合成模型的训练设备包括处理器、存储器;所述处理器用于执行所述存储器中存储的歌声合成模型的训练程序,以实现上述任一项所述的歌声合成模型的训练方法。

16.本发明实施例还提供了一种计算机可读存储介质,所述计算机可读存储介质存储有一个或者多个程序,所述一个或者多个程序可被一个或者多个处理器执行,以实现上述任一项所述的歌声合成模型的训练方法。

17.本发明有益效果如下:

18.在本发明实施例中,预先训练作为基础的歌声合成模型,之后采集目标用户输入的语音信息;获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应

的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。本发明实施例在具备基础歌声合成模型的基础上,利用目标用户的语音信息,就可以训练出能够合成具有目标用户音色的歌曲的歌声合成模型。

附图说明

19.此处所说明的附图用来提供对本发明的进一步理解,构成本技术的一部分,本发明的示意性实施例及其说明用于解释本发明,并不构成对本发明的不当限定。在附图中:

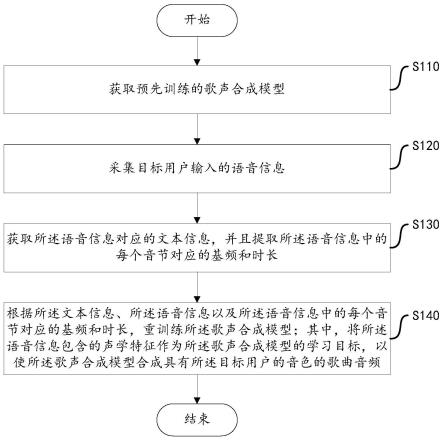

20.图1为根据本发明一实施例的歌声合成模型的训练方法的流程图;

21.图2为根据本发明一实施例的歌声合成模型的重训练的步骤流程图;

22.图3为根据本发明一实施例的歌声合成模型的重训练的示意图;

23.图4为根据本发明一实施例的歌声合成模型的训练装置的结构图;

24.图5为根据本发明一实施例的歌声合成模型的训练设备的结构图。

具体实施方式

25.为使本发明的目的、技术方案和优点更加清楚,以下结合附图及具体实施例,对本发明作进一步地详细说明。

26.根据本发明的实施例,提供了一种歌声合成模型的训练方法。如图1所示,为根据本发明一实施例的歌声合成模型的训练方法的流程图。

27.步骤s110,获取预先训练的歌声合成模型。

28.歌声合成模型可以是利用专业歌手录制的歌曲训练的歌曲合成模型。

29.步骤s120,采集目标用户输入的语音信息。

30.目标用户为具有歌声合成模型的个性化音色的用户。

31.语音信息可以是目标用户按照歌词内容输入的音频。

32.步骤s130,获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长。

33.文本信息的内容对应语音信息的内容。进一步地,文本信息可以是歌词。语音信息可以是歌词对应的语音信息。

34.音节对应的基频是指音节的最低振荡频率。

35.音节对应的时长是指音节的持续的时间。

36.在获取语音信息对应的文本信息时,可以针对所述语音信息执行语音识别处理,得到并获取所述语音信息对应的文本信息;或者,获取所述目标用户在输入所述语音信息时采用的文本信息。其中,语音识别处理用于将语音信息识别为文本信息。

37.在提取语音信息中每个音节对应的基频和时长时,可以利用预设的时长提取工具在语音信息中提取每个音素的时长。其中,该时长提取工具可以是mfa(montreal forced aligner),htk(hmm toolkit),kaldi(一种语音识别工具)等工具。音素是指最小语音单位。进一步地,语音信息中的多个音节是由至少一个音素规律性组合而成的。例如:在中文中,音节包括声母和韵母,并且声母为首位。所以根据音节的规律性特点,可以进行字边界识别;字边界为音节的边界(音节的时长),那么字边界识别即为:将语音信息中的各个音素划

分为多个音节,字边界识别可以通过语音识别或者歌曲识别的方式来执行;根据各个音素分别对应的时长,确定每个音节对应的时长;根据在语音信息中划分出的各个音节,可以在语音信息的整体频谱中划分出每个音节对应的频谱,进而根据每个音节对应的频谱,确定每个音节对应的基频。

38.步骤s140,根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

39.音节对应的基频可以反映歌曲中音节的音高。

40.音节对应的时长可以反映歌曲中音节的时值。

41.声学特征不仅包括语音的文本内容,还包括目标用户的音色特征等内容。

42.将文本信息以及语音信息中各个音节分别对应的基频和时长作为歌声合成模型的输入,使歌声合成模型输出预测的歌曲音频。由于本发明实施例是希望歌声合成模型输出具有目标用户的音色的歌曲音频,而在语音信息中包含了目标用户的声学特征,在重训练歌声合成模型时,使目标用户的声学特征作为歌声合成模型的学习目标,基于声学特征确定歌声合成模型的损失值,通过这种方式就可以训练出可以合成具有目标用户的音色歌声的歌声合成模型。

43.在本发明实施例中,由于目标用户的语音信息数量有限,所以可以将目标用户的语音信息截取为多段语音信息,依此来增加训练样本的数量,这样可以利用每段语音信息对应的文本信息以及在该段语音信息中提取的每个音节对应的基频和时长重训练歌声合成模型。

44.在本发明实施例中,预先训练作为基础的歌声合成模型,之后采集目标用户输入的语音信息;获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。本发明实施例在具备基础歌声合成模型的基础上,利用目标用户的语音信息,就可以训练出能够合成具有目标用户音色的歌曲的歌声合成模型。

45.在本发明实施例中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型。当然,在歌声合成模型中还包括声码器。声码器连接声学模型。

46.下面针对歌声合成模型的重训练过程进行描述。如图2所示,为根据本发明一实施例的歌声合成模型的重训练的步骤流程图。如图3所示,为根据本发明一实施例的歌声合成模型的重训练的示意图。

47.步骤s210,使输入单元根据语音信息中的每个音节对应的基频和时长,生成曲谱信息。

48.曲谱信息即乐谱,用于记录音乐的音高和时值。

49.针对所述语音信息中的每个音节,根据所述音节对应的基频确定所述音节对应的音高(note),并且,根据所述音节对应的时长确定所述音节对应的时值(notedur);根据所述语音信息中的每个音节对应的音高和时值,生成曲谱信息。

50.进一步地,可以利用librosa工具,将基频转换为音高。时长单位可以为毫秒(ms),那么时值可以等于时长除以20ms,或者,时长除以25ms,并对值取整或者四舍五入为整数,以便提升声音合成模型的鲁棒性。其中,20ms和25ms为可调的参数,该参数为经验值或者试验获得的值。

51.步骤s220,使声学模型根据所述文本信息和所述曲谱信息映射出声学特征。

52.声学特征为表示语音声学特性的物理量,也是声音诸要素声学表现的统称。例如:表示音色的能量集中区、共振峰频率、共振峰强度和带宽,以及表示语音韵律特性的时长、基频、平均语声功率等。

53.在所述声学模型中包括:顺序连接的编码器(encoder),时长模型和解码器(decoder)。在训练声音合成模型的过程中,也在训练时长模型。

54.使所述编码器将所述文本信息(歌词)和所述曲谱信息融合为歌谱信息。歌谱信息即为歌词和乐谱的组合。进一步地,文本信息包括音节的文本内容以及音节发声的时间信息。例如:第一个音节在第10秒发声,表示前9秒为前奏音乐。将文本信息和曲谱信息叠加在一起,实现文本信息和曲谱信息的融合。

55.使所述时长模型为所述歌谱信息中每个音节的各个音素对应分配时长。例如:在中文中,分配每个声母,每个韵母分别持续的时长。在重训练歌声合成模型的过程中,由于在提取语音信息中各个音节分别对应的时长时,先要提取语音信息中各个音素分别对应的时长,所以时长模型可以按照预先提取的各个音素分别对应的时长,为歌谱信息中的各个音素对应分配时长,并且时长模型在分配时长的过程中进行学习,以便在重训练完成之后,可以预测其他歌谱信息中的各个音素分别对应的时长并且按照预测结果进行时长分配。

56.使所述解码器根据歌谱信息以及所述歌谱信息中每个音节的各个音素对应的时长,映射声学特征。声学特征为梅尔谱(梅尔频谱)。

57.声学模型将所述声学特征输出到声码器。其中,声学模型中的解码器可以对声学特征进行帧扩展,之后输出给声码器。帧扩展用于使解码器输入的帧数和输出的帧数保持一致。

58.声码器根据声学特征(acousticfeatures)、语音信息中每个音节对应的基频(f0)以及每个音节中各音素对应的清浊音(uv判决),合成歌曲音频。其中,仅在判定音素为浊音时,为该音素赋予其所属音节对应的基频。

59.步骤s230,预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值。

60.在目标用户输入语音信息之后,在计算歌声合成模型的损失值之前,可以利用预设的特征提取工具,在该语音信息中提取声学特征。该特征提取工具可以是librosa工具。

61.如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。其中,损失阈值可以是经验值或者试验获得的值。

62.步骤s240,判断所述歌声合成模型的损失值是否大于预设的损失阈值;如果值,则执行步骤s250;如果否,则执行步骤s260。

63.步骤s250,调整所述歌声合成模型中的参数,并跳转到步骤s120,继续采集目标用户输入的语音信息,训练所述歌声合成模型。

64.跳转到步骤s120之后,根据新的语音信息,再次执行重训练步骤。

65.步骤s260,判断所述歌声合成模型是否符合预设的收敛条件;如果是,则执行步骤s270;如果否,则执行步骤s250。

66.收敛条件包括:歌声合成模型中的参数趋于稳定,歌声合成模型的重训练迭代次数达到迭代次数阈值。歌声合成模型中的参数趋于稳定是指模型中的同一个参数在调整前后,差值处于预设范围内。

67.步骤s270,在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

68.在本发明实施例中,利用目标用户的语音信息,对歌声合成模型进行重训练,使得歌声合成模型具备合成目标用户音色的歌声的能力。歌声合成模型在重训练之前已经具有高质量的歌曲合成能力,保证了模型的稳定性,经过重训练,歌声合成模型实现了音色迁移,可以使歌声合成模型可以使用目标用户的音色合成高质量的歌声,进而实现了歌声合成的个性化需求。

69.在本发明实施例中,在所述重训练所述歌声合成模型之后,还可以接收目标歌谱信息;所述目标歌谱信息包括:歌词文本以及所述歌词文本中的每个音节对应的音高和时值;将所述目标歌谱信息输入重训练完成的所述歌声合成模型,以便所述歌声合成模型根据所述目标歌谱信息合成具有所述目标用户的音色的歌曲音频。

70.本发明实施例还提供了一种歌声合成模型的训练装置。如图4所示,为根据本发明一实施例的歌声合成模型的训练装置的结构图。

71.该歌声合成模型的训练装置,包括:

72.获取模块410,用于获取预先训练的歌声合成模型。

73.采集模块420,用于采集目标用户输入的语音信息。

74.提取模块430,用于获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长。

75.训练模块440,用于根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

76.其中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型;所述训练模块440,用于:使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息;使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征;预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值;如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

77.其中,所述训练模块440,用于:针对所述语音信息中的每个音节,根据所述音节对应的基频确定所述音节对应的音高,并且,根据所述音节对应的时长确定所述音节对应的时值;根据所述语音信息中的每个音节对应的音高和时值,生成曲谱信息。

78.其中,在所述声学模型中包括:顺序连接的编码器,时长模型和解码器;所述训练

模块440,用于:使所述编码器将所述文本信息和所述曲谱信息融合为歌谱信息;使所述时长模型为所述歌谱信息中每个音节的各个音素对应分配时长;使所述解码器根据歌谱信息以及所述歌谱信息中每个音节的各个音素对应的时长,映射声学特征。

79.其中,所述获取模块410,用于:针对所述语音信息执行语音识别处理,得到并获取所述语音信息对应的文本信息;或者,获取所述目标用户在输入所述语音信息时采用的文本信息。

80.其中,所述装置还包括应用模块(图中未示出),所述应用模块,用于在所述重训练所述歌声合成模型之后,接收目标歌谱信息;所述目标歌谱信息包括:歌词文本以及所述歌词文本中的每个音节对应的音高和时值;将所述目标歌谱信息输入重训练完成的所述歌声合成模型,以便所述歌声合成模型根据所述目标歌谱信息合成具有所述目标用户的音色的歌曲音频。

81.本发明实施例所述的装置的功能已经在上述方法实施例中进行了描述,故本实施例的描述中未详尽之处,可以参见前述实施例中的相关说明,在此不做赘述。

82.本实施例提供一种歌声合成模型的训练设备。如图5所示,为根据本发明一实施例的歌声合成模型的训练设备的结构图。

83.在本实施例中,所述歌声合成模型的训练设备包括但不限于:处理器510、存储器520。

84.所述处理器510用于执行存储器520中存储的歌声合成模型的训练程序,以实现上述的歌声合成模型的训练方法。

85.具体而言,所述处理器510用于执行存储器520中存储的歌声合成模型的训练程序,以实现以下步骤:获取预先训练的歌声合成模型;采集目标用户输入的语音信息;获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

86.其中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型;所述重训练所述歌声合成模型,包括:使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息;使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征;预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值;如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

87.其中,所述使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息,包括:针对所述语音信息中的每个音节,根据所述音节对应的基频确定所述音节对应的音高,并且,根据所述音节对应的时长确定所述音节对应的时值;根据所述语音信息中的每个音节对应的音高和时值,生成曲谱信息。

88.其中,在所述声学模型中包括:顺序连接的编码器,时长模型和解码器;所述使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征,包括:使所述编码器将所述文本信息和所述曲谱信息融合为歌谱信息;使所述时长模型为所述歌谱信息中每个音节

的各个音素对应分配时长;使所述解码器根据歌谱信息以及所述歌谱信息中每个音节的各个音素对应的时长,映射声学特征。

89.其中,所述获取所述语音信息对应的文本信息,包括:针对所述语音信息执行语音识别处理,得到并获取所述语音信息对应的文本信息;或者,获取所述目标用户在输入所述语音信息时采用的文本信息。

90.其中,在所述重训练所述歌声合成模型之后,还包括:接收目标歌谱信息;所述目标歌谱信息包括:歌词文本以及所述歌词文本中的每个音节对应的音高和时值;将所述目标歌谱信息输入重训练完成的所述歌声合成模型,以便所述歌声合成模型根据所述目标歌谱信息合成具有所述目标用户的音色的歌曲音频。

91.本发明实施例还提供了一种计算机可读存储介质。这里的计算机可读存储介质存储有一个或者多个程序。其中,计算机可读存储介质可以包括易失性存储器,例如随机存取存储器;存储器也可以包括非易失性存储器,例如只读存储器、快闪存储器、硬盘或固态硬盘;存储器还可以包括上述种类的存储器的组合。

92.当计算机可读存储介质中一个或者多个程序可被一个或者多个处理器执行,以实现上述的歌声合成模型的训练方法。

93.具体而言,所述处理器用于执行存储器中存储的歌声合成模型的训练程序,以实现以下步骤:获取预先训练的歌声合成模型;采集目标用户输入的语音信息;获取所述语音信息对应的文本信息,并且提取所述语音信息中的每个音节对应的基频和时长;根据所述文本信息、所述语音信息以及所述语音信息中的每个音节对应的基频和时长,重训练所述歌声合成模型;其中,将所述语音信息包含的声学特征作为所述歌声合成模型的学习目标,以使所述歌声合成模型合成具有所述目标用户的音色的歌曲音频。

94.其中,在所述歌声合成模型中包括:相互连接的输入单元和声学模型;所述重训练所述歌声合成模型,包括:使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息;使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征;预先在所述语音信息中提取声学特征,根据在所述语音信息中提取的声学特征和所述声学模型映射出的声学特征,确定所述歌声合成模型的损失值;如果所述歌声合成模型的损失值大于预设的损失阈值,则调整所述歌声合成模型中的参数,并继续训练所述歌声合成模型;反之,则在所述歌声合成模型符合预设的收敛条件时,停止训练所述歌声合成模型。

95.其中,所述使所述输入单元根据所述语音信息中的每个音节对应的基频和时长,生成曲谱信息,包括:针对所述语音信息中的每个音节,根据所述音节对应的基频确定所述音节对应的音高,并且,根据所述音节对应的时长确定所述音节对应的时值;根据所述语音信息中的每个音节对应的音高和时值,生成曲谱信息。

96.其中,在所述声学模型中包括:顺序连接的编码器,时长模型和解码器;所述使所述声学模型根据所述文本信息和所述曲谱信息映射出声学特征,包括:使所述编码器将所述文本信息和所述曲谱信息融合为歌谱信息;使所述时长模型为所述歌谱信息中每个音节的各个音素对应分配时长;使所述解码器根据歌谱信息以及所述歌谱信息中每个音节的各个音素对应的时长,映射声学特征。

97.其中,所述获取所述语音信息对应的文本信息,包括:针对所述语音信息执行语音识别处理,得到并获取所述语音信息对应的文本信息;或者,获取所述目标用户在输入所述

语音信息时采用的文本信息。

98.其中,在所述重训练所述歌声合成模型之后,还包括:接收目标歌谱信息;所述目标歌谱信息包括:歌词文本以及所述歌词文本中的每个音节对应的音高和时值;将所述目标歌谱信息输入重训练完成的所述歌声合成模型,以便所述歌声合成模型根据所述目标歌谱信息合成具有所述目标用户的音色的歌曲音频。

99.以上所述仅为本发明的实施例而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的权利要求范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1