一种基于门控多级特征编码网络的多模态情感识别方法

本发明属于文本-语音识别,尤其涉及一种基于门控多级特征编码网络的多模态情感识别方法。

背景技术:

1、情感识别是一个一人的情感状态为目标的动态过程,这意味着每个人的行为对应的情感是不同的。日常生活中的情感识别对社会交往很重要,人类以不同的方式表达自己的感受,情感在决定人类行为中起着重要作用。为了确保有意义的交流,对这些情感的准确解读是非常重要的。在实际生活中,情感的表达方式有很多,既有口头语言,也有非口头语言,包括表达性语言、面部姿势、肢体语言等。因此,来自多种模态的情绪信号可以用来预测一个主体的情绪状态。而情感特征和分类模型的好坏直接影响多模态情感识别系统性能。随着人工智能技术的快速发展,多模态情感识别技术的应用越来越广泛,如社交机器人、安全控制、线上远程辅助教学和抑郁症患者情感监测等。但是,要使多模态情感识别更好地应用于人机交互领域,多模态情感识别的性能仍需进一步提升。

2、高区分性和丰富情感信息的特征提取是进行多模态情感识别的关键。对于文本模态,传统的手工文本情感特征的提取主要依赖于词袋(bag of words,bow)模型。随着深度学习的发展,一些基于深度学习的预训练词嵌入模型在文本情感特征提取的任务中得到了广泛的应用。atmaja等人通过长短期记忆网络(long short-term memory,lstm)和支持向量机(svm)进行声学和语义信息的整合。对于语音模态,kwon等人基于多级学习策略提取两类特征:空时高区分度特征和长时依赖性特征。此外,她们利用一维扩张卷积神经网络实现了实现语音情感识别任务。zhu等人提出了一种新的权感知多尺度神经网络系统,利用全局感知融合模块和多尺度特征信息来提高情感识别性能。可以发现,与以往仅使用原始波形或mfcc作为语音情感识别系统的输入,采用多尺度的语音特征和梅尔谱图特征能够提供更加全面的音频信息。

3、另外,情感分类模型的好坏直接影响多模态情感识别系统性能。深度学习的发展为多模态情感识别系统带来了更多的可能性。一些研究人员提出使用含有注意力的网络模型来提高情感识别系统的性能。choi等人使用含有注意力机制的cnn进行语音和文本之间的特征学习。krishna等人使用大型自监督预训练模型和阔模态注意力机制进行多模态情感识别。zhou等人提出了一种新颖的基于自适应和多级分解双线性池化的多模态特征融合算法用于情感识别。

4、上述研究工作都促进了多模态情感识别技术的实现,但仍存在一些问题。首先,在语音信号预处理中,先前大多采用单一帧长进行分帧来提取情感特征。而且,仅采用时频域的信息进行情感识别时不充分的,缺少对空间信息的补充。其次,当采用大型训练模型进行多模态情感识别时,模型复杂且参数计算量大,影响其实用性。最后,在多模态情感识别中,不同模态情感信息的有效融合将直接影响情感识别性能,因此构造自适应的多模态融合模块是非常有必要的。

技术实现思路

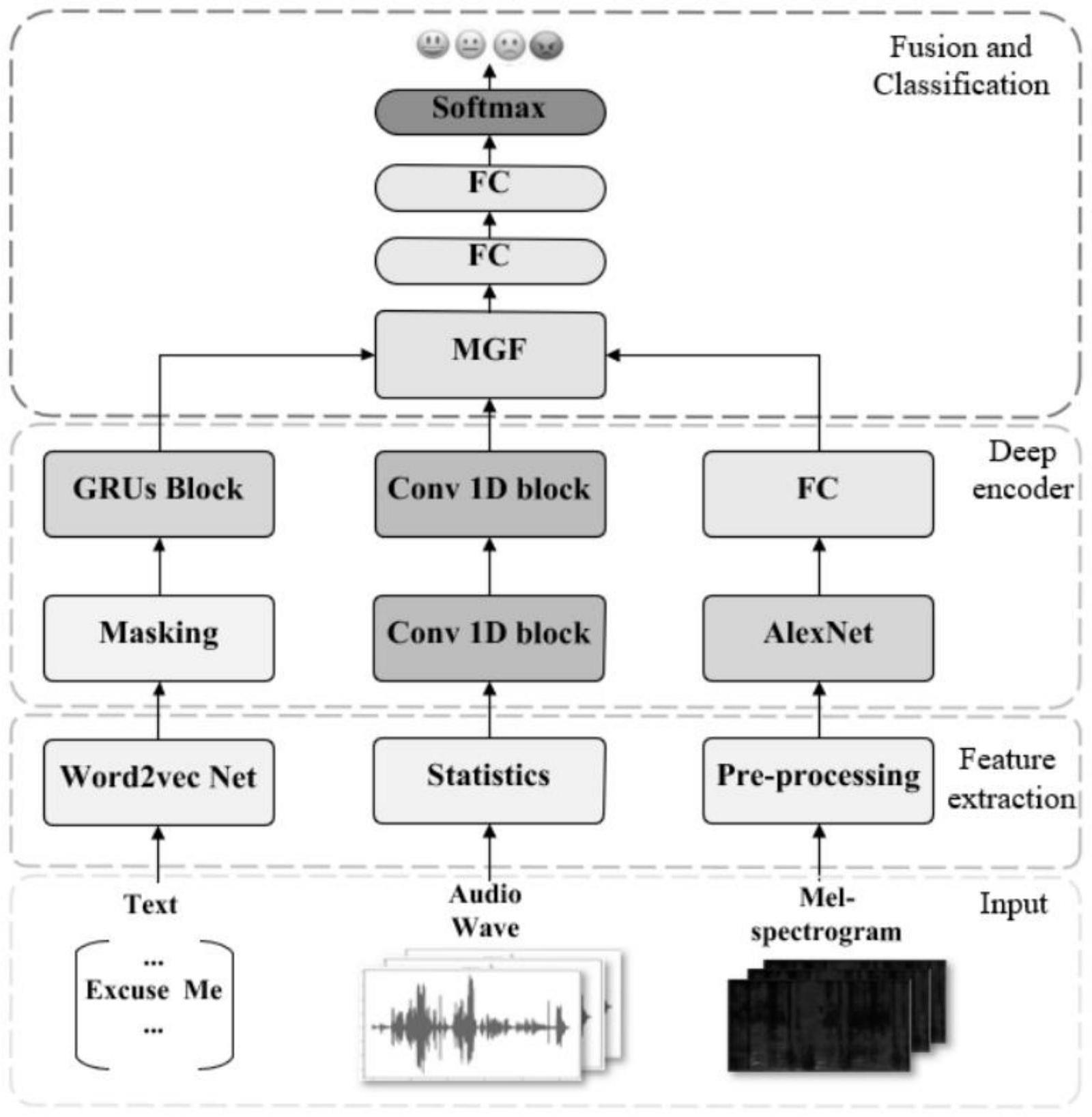

1、发明目的:本发明的目的在于提供一种基于门控多级特征编码网络的多模态情感识别方法,通过三种不同的深度编码器,实现时域频域和空间信息的获取,并通过自适应多模态门控融合模块,使得网络能够捕获更多的高区分度情感特征,通过对多模态门控系统的自适应控制,多模态门控融合模块能够隐式地完成文本-语音信息的融合。

2、技术方案:本发明的一种基于门控多级特征编码网络的多模态情感识别方法,包括以下步骤:

3、步骤1、通过word2vec网络提取每条原始文本的浅层特征,在提取每条原始语音的多尺度统计特征后进行特征融合,得到多尺度融合语音特征,同时采集每条原始语音的梅尔谱图特征;

4、步骤2、以多尺度融合语音特征和原始文本的浅层特征作为输入,多尺度语音深度特征与文本深度特征为输出,构建深度特征编码模型,其中,深度特征编码模型包括适用于文本特征grus网络框架和适用于语音特征的cnns网络框架;

5、步骤3、构建自适应多模态门控融合模块,将步骤1中的梅尔谱图特征与步骤2的多尺度语音深度特征与文本深度特征分别输入自适应多模态门控融合模块,通过引入门控机制自适应地权衡每个模态的贡献,控制信息的传递和抑制,实现多模态特征信息融合,获得情感分类标签;

6、步骤4、对基于门控多级特征编码网络的多模态情感识别方法进行性能评估。

7、进一步的,步骤1具体为:

8、步骤1.1、对每条语音信号采用不同的帧长进行预处理,其中帧长分别取256、512,获取预处理后的信号并进行特征提取,包括24维mfcc、24维mfcc一阶动态差分、24维mfcc二阶动态差分、能量、基音频率和短时过零率;

9、步骤1.2、对尺度为256和512所得到的语音统计特征进行融合,获得750维多尺度融合语音特征;

10、步骤1.3、对每条原始文本进行预处理,并构造word2vec网络,通过word2vec实现无监督学习,学习单词在上下文中的分布来捕捉单词的语义信息,从而将单词映射到一个高维空间中的特征表示,获得300维浅层文本特征;

11、步骤1.4、对原始语音进行采样、预加重、分帧、加窗的操作,并计算功率谱,对功率谱进行梅尔尺度变换,将频率转换到听觉感知尺度,从而获得梅尔谱图。

12、进一步的,步骤2具体为:

13、步骤2.1、构造适用于文本特征的grus网络框架,包含两个gru网络层,通过gru层处理文本序列数据,以更简单的结构和更少的参数实现特征编码;

14、步骤2.2、构造适用于多尺度语音特征的cnns网络框架,包含第一卷积层,第二relu层,第三全连接层,第四卷积层,第五relu层,第六全连接层;

15、步骤2.3、构造mel-spectrogram-alexnet分支,引入alexnet预训练网络模型,通过卷积和非线性激活函数来处理梅尔谱图信息,获取语音谱图特征;

16、进一步的,步骤2.3中,所述构造mel-spectrogram-alexnet分支,包括如下步骤:

17、步骤2.3.1、对梅尔谱图进行归一化操作,统一裁剪大小为224*224;

18、步骤2.3.2、搭建alexnet整体网络框架,包括第一卷积层,第二最大池化层,第三卷积层,第四最大池化层,第五卷积层,第六卷积层,第七卷积层,第八全连接层,第九全连接层;

19、步骤2.3.3、将归一化的语音梅尔谱图输入到预训练模型alexnet网络中,利用卷积操作和非线性激活函数实现谱图特征提取,从而得到300维语音梅尔谱图特征。

20、进一步的,步骤3具体为:

21、步骤3.1、将文本深度特征与多尺度语音深度特征输入门控融合模块,获得加权向量e;

22、

23、

24、z=σ(wz[x′t,x′f])

25、e=zht+(1-z)hf

26、其中,wt,wf,wz分别表示文本向量,音频向量,文本-音频融合向量的计算权重,e为门控单元输出的加权向量,x′t表示深度编码后的文本特征向量,x′f表示深度编码后的多级语音特征向量,σ表示sigmod计算;

27、步骤3.2、将文本深度特征与梅尔谱图深度特征输入门控融合模块,获得加权向量e′;

28、

29、

30、z′=σ(w′z[x′t,x′m])

31、e′=z′ht+(1-z′)hf

32、其中,wt,wm,w′z分别表示文本向量,梅尔谱图向量,文本-梅尔谱图融合向量的计算权重,e′为门控单元输出的加权向量,x′t表示深度编码后的文本特征向量,x′m表示深度编码后梅尔谱图特征向量,σ表示sigmod计算;

33、步骤3.3、将加权向量e,加权向量e′进行拼接,获得自适应的多模态加权特征,并对文本深度特征进行保留,输入到分类器中,其中,分类器包括第一全连接层,第二全连接层,第三softmax层;

34、步骤3.4、设置交叉熵损失函数作为基于门控多级特征编码网络的损失函数,在softmax层获得情感分类标签;

35、

36、其中,pi表示第i类情感的概率,表示第i类情感特征,j表示情感类别。

37、进一步的,步骤4具体为:

38、步骤4.1、将文本浅层特征和多尺度语音统计特征输入相同的grus网络,将文本浅层特征和多尺度语音统计特征输入相同的cnns网络,验证grus-cnns并行网络的有效性;

39、步骤4.2、提取帧长为256的语音统计特征和帧长为512的语音统计特征,并分别作为语音统计特征输入深度编码网络,验证使用多尺度特征对多模态情感识别的有效性;

40、步骤4.3、将文本模态特征、语音模态特征分别输入grus-cnns并行网络,并引入mel-spectrogram-alexnet分支,验证引入mel-spectrogram-alexnet分支对多模态情感识别的有效性;

41、步骤4.4、将文本深度特征,多层次语音统计特征,深度谱图特征分别输入含有门控融合模块的深度编码网络和不含有门控融合模块的深度编码网络,验证门控融合模块对多模态情感识别的有效性。

42、有益效果:与现有技术相比,本发明具有如下显著优点:

43、1、该方法提出了一种简单有效的门控多级特征编码网络。通过三种不同的深度编码器,实现时域频域和空间信息的获取,并通过自适应多模态门控融合模块,使得网络能够捕获更多的高区分度情感特征。

44、2、引入多层次特征作为语音的浅层特征,包括多尺度浅层语音统计特征和梅尔谱图特征。利用mel-spectrogram-alexnet作为辅助分支来补充语音在空间维度的信息。

45、3、提出多模态门控融合模块,实现多层次深度特征的动态融合。通过对多模态门控系统的自适应控制,多模态门控融合模块能够隐式地完成文本-语音信息的融合。

- 还没有人留言评论。精彩留言会获得点赞!