基于交叉注意力的视听语音增强方法及其模型搭建方法

本发明属于语音识别模型,尤其涉及一种基于交叉注意力的视听语音增强方法及其模型搭建方法。

背景技术:

1、通常,正常听力的听众能够专注于特定的声学刺激,针对目标语音或感兴趣的语音,同时过滤掉其他声音,这种众所周知的现象被称为鸡尾酒会效应,因为它类似于鸡尾酒会上发生的情况,由此引发了人们对语音增强这一问题的关注。语音增强的目的是消除信号中的噪声成分同时保留干净的语音信号,提高语音质量和可懂度。随着数字信号处理技术的发展,语音增强技术也得到了很大的发展和改进。通过数字技术对语音信号进行滤波、增强、去混响等处理,语音信号的质量和清晰度得以进一步提高。基于数字信号处理技术的语音增强,可以分为传统的数字语音增强方法和基于神经网络的语音增强方法两大类。

2、传统的数字语音增强方法通常是基于时域或频域进行信号处理的,常见的方法包括谱减法、维纳滤波法、子空间法等。其只适用于简单噪声场景,但现实中的噪声场景通常比较复杂。近年来,由于具有良好的泛化性能,可以从大量的数据中自动学习特征,应对不同的语音增强场景和任务,深度学习在语音增强领域的应用逐渐增多。众多表现良好的语音增强的模型被提出。

3、然而,语音感知本质上是多模态的,特别是视听,因为除了到达听众耳朵的声学语音信号之外,一些有助于语音产生的发音器官(例如舌头、牙齿、嘴唇、下巴和面部表情)的位置和运动也可能对接收者可见。神经科学和言语感知的研究表明,言语的视觉方面对人类将听觉注意力集中在特定刺激上的能力有潜在的强烈影响。2018年谷歌提出了一个基于深度学习联合视听语音分离/增强模型,相比纯音频方法显著提高了其增强性能。但上述方法对视听信息融合方面做的不够充分,如何有效地结合音视频特征,使其提高语音增强效果仍然值得探讨。

技术实现思路

1、针对上述问题,本发明第一方面提供了一种基于交叉注意力的视听语音增强模型搭建方法,包括以下过程:

2、步骤1,获取若干说话人的视频和相应音频的原始数据;

3、步骤2,对步骤1中获取的原始数据进行预处理;将视频分别处理为一帧一帧的图像,同时从原始数据中随机选取一个说话人的数据和一个噪声数据,将其中的音频按一定比例混合后对混合语音做梅尔变换得到语音的梅尔特征图,结合说话人数据对应的面部帧构建数据集,并划分为训练集、验证集和测试集;

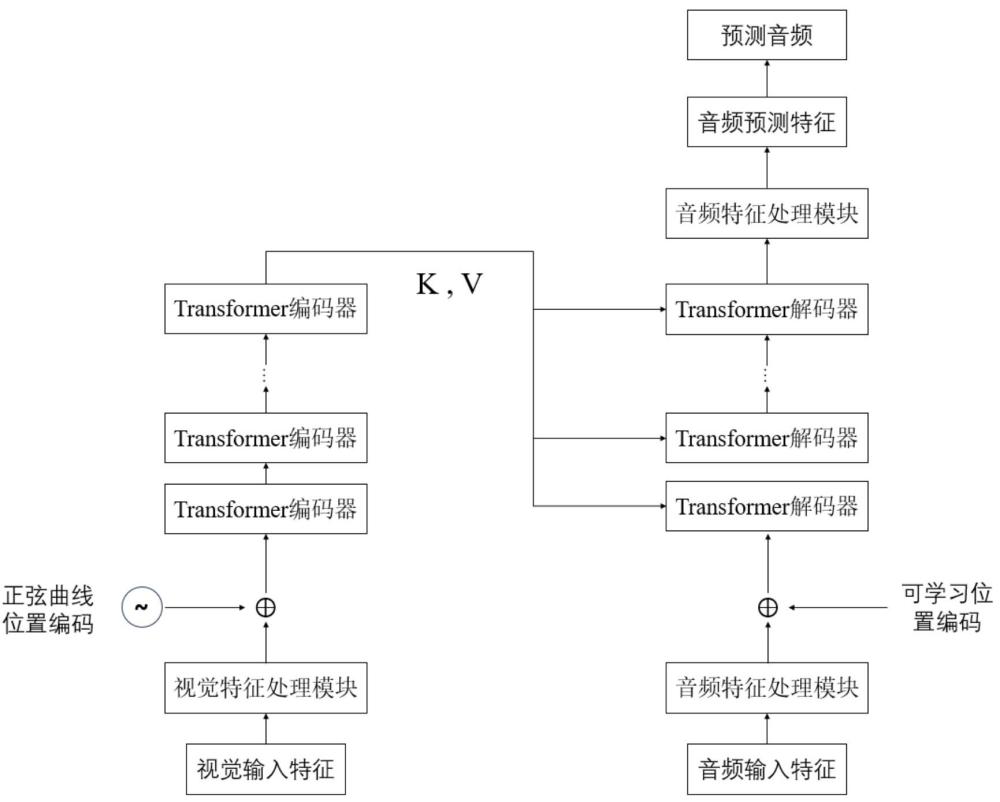

4、步骤3,构建基于交叉注意力的视听语音增强模型;基于resnet18网络结构和cbam注意力机制,构建视觉特征处理模块;基于1d卷积和高斯误差线性单元gelu,构建音频特征处理模块;基于transformer编码器,得到视觉特征的k,v矩阵;基于transformer解码器,将原transformer解码器中的第二个自注意力机制层改为交叉注意力机制层,将音频特征作为q矩阵,解码器的输出作为k,v矩阵;其中,将混合语音的梅尔特征图和视频面部帧作为输入,模型输出为预测音频梅尔特征图,最终将梅尔特征图进行逆梅尔谱变换得到最终预测音频;

5、步骤4,使用预处理后的数据集对构建的视听语音增强模型进行训练与测试评估,获取最终视听语音增强模型。

6、优选的,所述步骤2中预处理的具体过程为:

7、首先将每一个视频以每秒25帧进行裁剪,得到按照时间维度排列的图像,对于每一张图像使用现有的基于opencv库的mtcnn人脸检测器提取每张图片中的目标说话人的人脸缩略图,使用facenet预训练模型来提取每个人脸缩略图的人脸特征,facenet预训练模型经过训练大量人脸图片得到;然后从原始数据中随机选取一个说话人的数据和一个噪声数据,将其中的音频混合后对混合语音做短时傅里叶变换得到语音的语谱图,结合说话人数据对应的面部特征构建数据集。

8、优选的,所述视觉特征处理模块由修改后的resnet18残差网络和卷积块注意力模块cbam组成;

9、所述修改后的resnet18残差网络,包括1个conv5卷积层,4个conv_res层;其中conv5层由大小为5×5步长为1的卷积核、批归一化层bn以及relu激活函数组成,每个conv_res层由两个相同的卷积块组成,每个卷积块包含一个大小为1×7步长为1的卷积核、bn层以及relu激活函数;卷积块的输入输出公式可由下式表示:

10、y = relu(x + bn(conv_res (relu(bn(conv_res (x))))))

11、其中,x代表卷积块的输入,y代表卷积块的输出;conv_res是1×7卷积运算;修改后的resnet18残差网络的输出作为cbam模块的输入;

12、所述cbam模块由通道注意力模块和空间注意力模块组成,cbam模块位于修改后的resnet18残差网络之后,用于高效提取和音频相关性较大的人脸关键区域,忽略人脸之外的次要区域;

13、所述cbam模块的输出作为网络提取的初步视觉特征,其将用作模型中transformer编码器输入。

14、优选的,所述音频特征处理模块由2个1d卷积层和高斯误差线性单元gelu组成;每个1d卷积层的输出维度与输入维度相同,高斯误差线性单元gelu公式如下:

15、

16、代表激活函数的输入,即为激活函数的输出;所述音频特征处理模块输出作为网络提取的初步音频特征,其将用作模型中transformer解码器输入。

17、优选的,所述transformer编码器,包括6个transformer编码器模块,每个transformer编码器模块包括一个自注意力机制层和一个mlp模块;

18、所述transformer编码器的输入为视觉特征处理模块的输出与正弦位置编码的相加,正弦位置编码公式如下:

19、

20、

21、表示位置编码矩阵中第个位置,第个维度的值,表示模型嵌入向量的维度;

22、所述transformer编码器模块中,自注意力机制中的q(query),k(key),v(value)矩阵由编码器输入视频特征进行线性变换得到,自注意力机制输入公式如下:

23、

24、其中,中为编码器输入视频特征经过线性变换后的列维度,为编码器输入视频特征进行线性变换得到的q,k,v矩阵;

25、所述mlp模块包括两个全连接层、高斯误差线性单元gelu和层归一化layernorm,其中全连接层的输出维度与ransformer编码器模块输入维度相等;

26、所述transformer编码器模块的自注意力机制层和mlp模块均用残差结构进行连接;公式如下:

27、

28、

29、其中为mlp模块输入,为mlp模块输出,为进行残差连接后的mlp模块输出,为自注意力机制层输入,为自注意力机制层输出,为进行残差连接后的自注意力机制层输出;

30、所述6个transformer编码器模块,每个模块之前采用残差连接;公式如下:

31、

32、其中,为transformer编码器模块输入,为transformer编码器模块输出,为进行残差连接后transformer编码器模块输出。

33、优选的,所述transformer解码器,包括6个transformer解码器模块,每个transformer解码器模块包括一个自注意力机制层、一个交叉注意力机制层和一个mlp模块;

34、所述transformer解码器的输入为音频特征处理模块的输出与可学习位置编码的相加;

35、所述transformer解码器模块中,自注意力机制中的q(query),k(key),v(value)矩阵由解码器输入视频特征进行线性变换得到,自注意力机制输入公式如下:

36、

37、其中,中为解码器输入音频特征经过线性变换后的列维度,为解码器输入音频特征进行线性变换得到的q,k,v矩阵;代表的转置矩阵;

38、所述transformer解码器模块中,交叉注意力机制中的q(query)矩阵由进行线性变换得到,k(key),v(value)矩阵由transformer编码器的输出进行线性变换得到,交叉注意力机制输入公式如下:

39、

40、其中,代表交叉注意力机制层的输出,为解码器自注意力机制层的输出经过线性变换后的列维度,解码器自注意力机制层的输出进行线性变换得到的q矩阵,为transformer编码器的输出进行线性变换得到的k,v矩阵;

41、所述mlp模块包括两个全连接层、高斯误差线性单元gelu和层归一化layernorm,其中全连接层的输出维度与transformer解码器模块输入维度相等;

42、所述transformer解码器模块的自注意力机制层、交叉注意力机制层和mlp模块均用残差结构进行连接;公式如下:

43、

44、

45、

46、其中为解码器中mlp模块输入,为mlp模块输出,为进行残差连接后的mlp模块输出;为解码器中自注意力机制层输入,为自注意力机制层输出,为进行残差连接后的自注意力机制层输出;为解码器中交叉注意力机制层输入,为交叉注意力机制层输出,为进行残差连接后的交叉注意力机制层输出;

47、所述6个transformer解码器模块组成,每个模块之前采用残差连接;公式如下:

48、

49、其中,为transformer解码器模块输入,为transformer解码器模块输出,为进行残差连接后transformer解码器模块输出。

50、优选的,所述transformer解码器的输出再经过音频处理模块处理后,得到预测梅尔特征图,其与干净音频的梅尔特征图利用均方误差mse损失函数进行训练,得到训练好的梅尔特征图,再利用逆梅尔特征变换得到最终的预测语音,其原理是梅尔特征复原成短时傅里叶变换的功率谱,随后将其使用griffin-lim算法复原成音频,该算法是一种已知幅度谱,未知相位谱,通过迭代生成相位谱,并用已知的幅度谱和计算得出的相位谱,重建语音波形的方法。

51、优选的,所述步骤2中,是通过短时傅里叶变换将时域混合音频转换为语谱图,音频采样率为16khz,音频片段长度为3s,stft帧长为512个采样点,帧移为160个采样点,采用汉宁窗,梅尔滤波器组数为80。

52、本发明第二方面还提供了一种基于交叉注意力的视听语音增强方法,包括以下过程:

53、获取包含有说话人的视频和相应音频;

54、将获取的视频和相应音频进行处理,分别提取混合语音的梅尔特征图和视频面部帧;

55、将混合语音的梅尔特征图和视频面部帧输入到如第一方面所述的搭建方法所搭建的最终视听语音增强模型中;

56、输出最终预测音频。

57、本发明第三方面还提供了一种视听语音增强设备,所述设备包括至少一个处理器和至少一个存储器,所述处理器和存储器相耦合;所述存储器中存储有如第一方面所述的搭建方法所搭建的最终视听语音增强模型的计算机执行程序;所述处理器执行存储器中存储的计算机执行程序时,可以使处理器执行一种基于交叉注意力的视听语音增强方法。

58、本发明第四方面还提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有如第一方面所述的搭建方法所搭建的最终视听语音增强模型的计算机执行程序,所述计算机执行程序被处理器执行时,可以使处理器执行一种基于交叉注意力的视听语音增强方法。

59、与现有技术相比,本发明具有如下有益效果:

60、本发明提出了一个基于交叉注意力的视听语音增强模型,使用交叉注意力机制来融合视听特征,并使用transformer编码器和解码器来搭建模型,交叉注意力机制算法能让网络更好地利用视觉信息和音频信息之间的内在联系,可以实现更好的语音增强性能;针对于传统的级联融合或是加法融合模式,这两种融合方法简单直接且不需要计算,但是在模型中这种简单的融合会损失很多有用的信息,从而导致分离的音频的效果不够准确,本发明提出的融合方法在效果上明显占优;相比于单纯使用音频信号的频域特征,本发明对混合语音信号做梅尔特征变换,充分的利用语音信号信息。

- 还没有人留言评论。精彩留言会获得点赞!