一种针对环岛通行的自动驾驶决策模型构建方法与流程

本技术涉及自动驾驶决策,具体地,涉及一种针对环岛通行的自动驾驶决策模型构建方法。

背景技术:

1、自动驾驶系统中,驾驶决策控制是其中的关键技术和研究内容之一,它主要包括任务规划、行为决策和轨迹规划三个部分。行为决策在自动驾驶技术中起着至关重要的作用,它涉及推理生成驾驶行为,如跟驰、换道、加减速等。行为决策的准确性直接决定了车辆自主行驶的能力,因此是自动驾驶技术发展的关键技术之一。目前先进的决策理论包括模糊推理、强化学习、神经网络等,由于人类驾驶过程中所面临的路况与场景各不相同,且对于不同情况所做出的驾驶策略也因人而异。因此驾驶决策算法的优化需要非常完善高效的人工智能模型以及大量的有效数据,这些数据需要尽可能地覆盖到各种罕见的路况,这也是驾驶决策发展的最大瓶颈所在。

2、在自动驾驶测试路况中,环岛交叉口是一种典型的可变且交互式的场景,通过减少交通信号灯和停车点的数量,环岛场景可以提高交通流量,减少交通延误和拥堵,降低车辆的能耗和排放。在环岛交叉口场景中,自动驾驶车辆需要做出自适应和安全的决策,然而,目前自动驾驶技术虽然取得了高水平的发展,但离实现自动驾驶汽车的正式投入使用还有很长的路要走。在此期间,自动驾驶汽车与人类驾驶汽车混合行驶是不可避免的,并且可能会持续相当长的一段时间。由于人类驾驶员的主观因素,人类驾驶汽车的驾驶行为具有个性化特征,这对于与自动驾驶汽车进行交互的安全驾驶产生了较大的随机性影响。在环岛交叉口场景中,现有的自动驾驶车辆无法适应人类驾驶汽车的不确定性和个性化行为,自动驾驶系统无法准确预测人类驾驶员的行为以做出相应的决策,影响交通安全。

技术实现思路

1、为了克服现有技术中的至少一个不足,本技术提供一种针对环岛通行的自动驾驶决策模型构建方法。

2、第一方面,提供一种针对环岛通行的自动驾驶决策模型构建方法,包括:

3、获取训练数据,训练数据包括主车轨迹数据、主车与周围的交互车辆的交互数据;

4、基于训练数据确定主车的当前时刻的环境状态信息、当前时刻的动作、当前时刻的奖励值,环境状态信息包括安全决策向量表示和任务决策向量表示;动作包括目标加速度、预期动作持续时间、相对于当前车道的侧方偏移量;

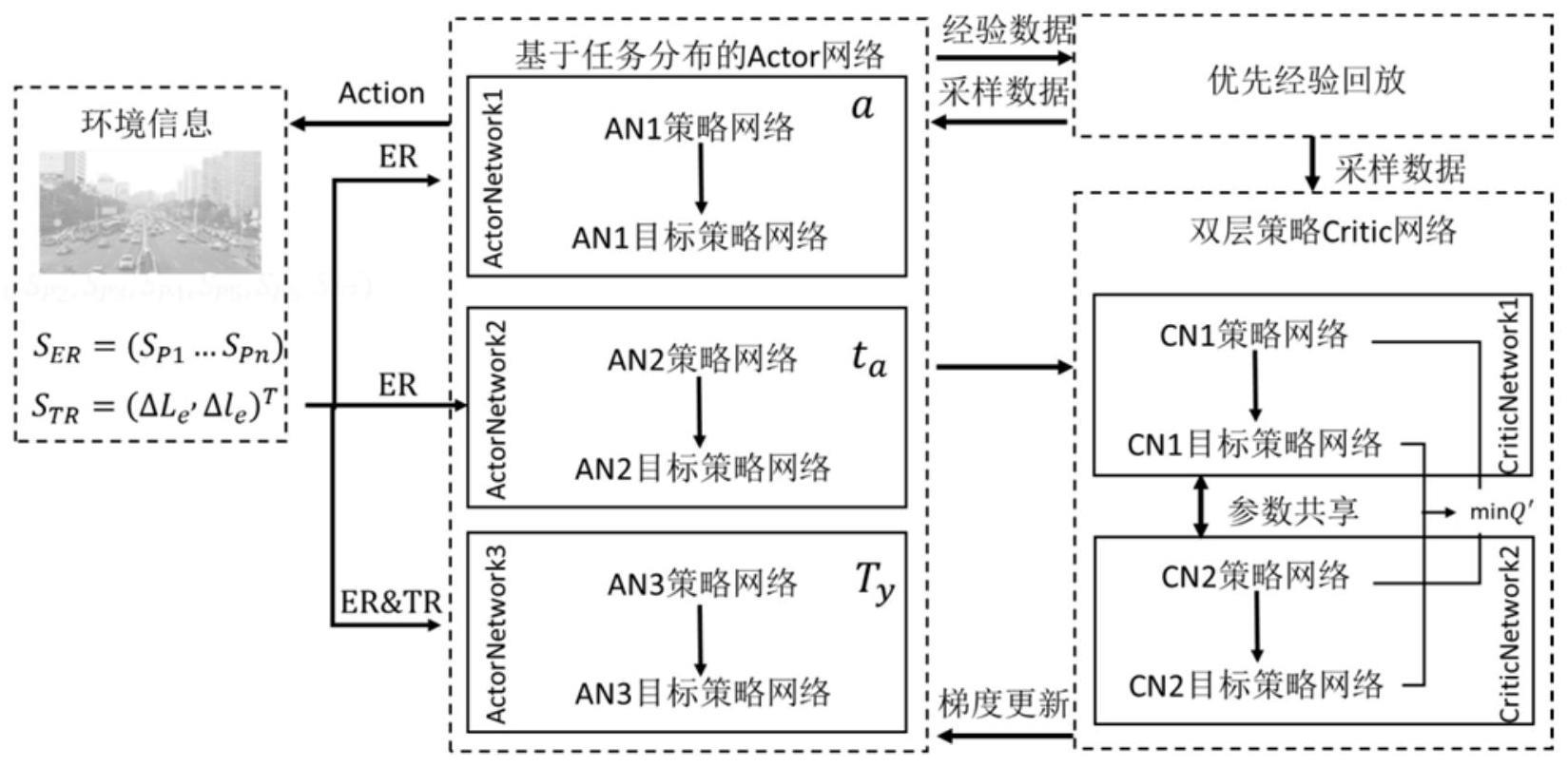

5、将当前时刻的环境状态信息输入到actor网络,actor网络输出下一时刻的动作;

6、下一时刻的动作、下一时刻的环境状态信息、当前时刻的奖励值构成经验数据,将经验数据输入到优先经验回放模型进行数据采样,得到采样数据;

7、将当前时刻的环境状态信息、当前时刻的动作、下一时刻的动作、下一时刻的环境状态信息、采样数据,输入到双层策略critic网络,得到真实值和预测值;

8、基于真实值和预测值计算模型的损失,采用梯度下降方法更新actor网络后的参数;迭代训练多次,得到训练后的actor网络,即为自动驾驶决策模型。

9、在一个实施例中,安全决策向量表示,采用以下公式:

10、er=(sp1,sp2,…,spn)

11、spn=(δln,δνn,an,dn)

12、其中,er为安全决策向量表示,spn为主车与周围第n辆交互车辆的向量表示,δln为主车所在车道与周围第n辆交互车辆所在车道的车道差,δνn为主车与周围第n辆交互车辆的相对速度,an为主车的加速度,dn为主车与周围第n辆交互车辆的相对距离;

13、任务决策向量表示,采用以下公式:

14、tr=(δle,δle)t

15、δle=le-le

16、

17、其中,tr为任务决策向量表示,δle为预期出口车道和主车所在车道的车道差,le为预期出口车道,le为主车所在车道,δle为主车与预期出口的相对纵向距离,de为预期出口的半径值,de为主车的半径值,αee为主车与预期出口的相对夹角。

18、在一个实施例中,奖励值,采用以下公式计算:

19、r=λ1rs+λ2ra+λ3rj

20、其中,r为奖励值,rs为安全奖励,ra为稳定性奖励,rj为任务奖励;λ1为安全奖励的系数,λ2为稳定性奖励的系数,λ3为任务奖励的系数。

21、在一个实施例中,actor网络包括第一actor网络模块、第二actor网络模块和第三actor网络模块;第一actor网络模块包括an1策略网络、an1目标策略网络,第二actor网络模块包括an2策略网络、an2目标策略网络,第三actor网络模块包括an3策略网络、an3目标策略网络;an1目标策略网络、an2目标策略网络和an3目标策略网络分别用于基于采样数据辅助训练an1策略网络、an2策略网络和an3策略网络;

22、an1策略网络的输入是安全决策向量表示er,输出是下一时刻的目标加速度;

23、an2策略网络的输入是安全决策向量表示er,输出是下一时刻的预期动作持续时间;

24、an3策略网络的输入是安全决策向量表示er和任务决策向量表示tr,输出是下一时刻的相对于当前车道的侧方偏移量。

25、在一个实施例中,双层策略critic网络包括第一critic网络模块和第二critic网络模块;第一critic网络模块包括cn1评价网络、cn1目标评价网络,第二critic网络模块包括cn2评价网络、cn2目标评价网络。

26、在一个实施例中,真实值采用以下公式计算:

27、q=maxq′ti(st,at)

28、其中,q为真实值,st为当前时刻的环境状态信息、at为当前时刻的动作,q′ti为第i个目标评价网络,i=1,2;

29、预测值,采用以下公式表示:

30、

31、

32、

33、其中,q′为预测值,为评价网络的目标值,为目标评价网络的目标值,rt为当前时刻的奖励值,γ为折扣因子,为第j个评价网络,st+1为下一时刻的环境状态信息,at+1为下一时刻的动作,为第i个目标评价网络,s′t+1为采样数据中的下一时刻的环境状态信息、a′t+1为采样数据中的下一时刻的动作。

34、在一个实施例中,模型的损失,采用以下公式:

35、

36、其中,lh为模型的损失,q为真实值,q′为预测值,τ为超参数。

37、第二方面,提供一种针对环岛通行的自动驾驶决策模型构建装置,包括:

38、训练数据获取模块,用于获取训练数据,训练数据包括主车轨迹数据、主车与周围的交互车辆的交互数据;

39、建模模块,用于基于训练数据确定主车的当前时刻的环境状态信息、当前时刻的动作、当前时刻的奖励值,环境状态信息包括安全决策向量表示和任务决策向量表示;动作包括主车目标加速度、预期动作持续时间、相对于当前车道的侧方偏移量;

40、动作预测模块,用于将当前时刻的环境状态信息输入到actor网络,actor网络输出下一时刻的动作;

41、采样模块,用于下一时刻的动作、下一时刻的环境状态信息、当前时刻的奖励值构成经验数据,将经验数据输入到优先经验回放模型进行数据采样,得到采样数据;

42、评价模块,用于将当前时刻的环境状态信息、当前时刻的动作、下一时刻的动作、下一时刻的环境状态信息、采样数据,输入到双层策略critic网络,得到真实值和预测值;

43、网络参数更新模块,用于基于真实值和预测值计算模型的损失,采用梯度下降方法更新actor网络后的参数;迭代训练多次后,得到训练后的actor网络,即为自动驾驶决策模型。

44、第三方面,提供一种计算机可读存储介质,计算机可读存储介质存储有计算机程序,计算机程序被处理器执行时,以实现上述的针对环岛通行的自动驾驶决策模型构建方法。

45、第四方面,提供一种计算机程序产品,包括计算机程序/指令,计算机程序/指令被处理器执行时,以实现上述的针对环岛通行的自动驾驶决策模型构建方法。

46、相对于现有技术而言,本技术具有以下有益效果:本技术提供一种针对环岛通行的自动驾驶决策模型构建方法,对其网络结构中的actor网络、critic网络及经验回放模块进行针对性的改进;利用actor子网络分别进行驾驶动作的策略选择;对于critic网络,采用双层策略critic网络结构,降低价值过估计导致的模型预测误差累积问题;引入优先经验回放模型,利用huber损失函数对决策过程中的异常值进行处理;本技术构建的模型能够在双车道环岛交叉口场景下做出安全合理的决策,此外,本技术对自动驾驶时代道路交通安全性和通行效率的提升具有重大的研究意义和应用价值。

- 还没有人留言评论。精彩留言会获得点赞!