一种基于深度强化学习的无人机编队避撞方法与流程

1.本发明涉及深度强化学习领域和无人机技术领域,特别涉及一种基于深度强化学习的无人机编队避撞方法。

背景技术:

2.近年来,多智能体由于在不同领域都具有巨大潜力而引起越来越多的研究。其所涉及的领域包括监控与救援的协同探索、卫星集群协同控制、无人机编队控制等等。多智能体系统的基本概念是利用个体协作解决复杂的任务,这些任务是单个智能体即使拥有昂贵的设备也无法完成的。编队控制是多智能体系统的一个基本问题,其目标是实现并保持一定的编队形状,使多智能体系统能够共同完成特定的任务。编队保持是编队控制中的一个重要问题。此外,为了保证多智能体系统的安全性,还应考虑碰撞的避免。由于智能体之间的相互作用以及避免碰撞和编队维护之间的权衡,在不确定的动态环境中寻找无碰撞、时间高效的路径仍然是一个挑战。

3.针对编队保持问题,其他学者的研究中提出了几种编队控制技术,包括基于行为的编队控制、虚拟结构方法和基于leader-follower架构的编队控制方案。在这些群体控制技术中,leader-follower体系结构以其简单的结构和可实现性得到了广泛的应用。虽然在leader-follower编队控制方面已经取得了一系列的成果,但在之前的工作中,基于避碰的编队控制问题还没有得到充分的研究。特别是在动态环境下,智能体之间的碰撞,以及多智能体系统与障碍物之间的碰撞,使得碰撞的难度越来越大。

4.对于避碰问题,传统的算法通常分为三类,包括离线规划方法、基于人工势场的方法和感避方法。第一种离线规划方法通常提前计算无碰撞轨迹,然后将结果用作后续跟踪控制系统的期望轨迹。然而,这些方法计算量很大。而且整个环境的信息都要提前知道,不方便在动态环境下实现。基于人工势场的方法通过假设环境中个体之间的虚拟吸引和排斥场来避免碰撞。然而,可能存在局部极小值,有时会出现目的地不可达的问题。感知和避免方法通过感知环境并相应地调整当前动作来解决碰撞避免问题,具有仿人的特点。目前关于这些方法的工作可以分为两类:基于反应的方法和基于预测的方法。前者通过基于当前状态设置一步行为规则来避免碰撞,例如基于模糊逻辑的碰撞避免方法和往复速度障碍方法。然而,这些基于反应的方法存在局限,在某些情况下可能不可靠,因为它们没有考虑未来的状态。后者预测障碍物的运动,预测未来的状态,然后输出一个长远的行动来避免碰撞。然而,以下两个问题是显而易见的:一是由于各种不确定性导致的估计不准确;另一个是预测操作的巨大计算复杂性。因此,传统的避撞方法存在很大的局限性,且不具备编队控制的能力,所以研究编队避撞的重心便逐渐转移至强化学习领域。

技术实现要素:

5.本发明针对多无人机编队避撞的问题,提出了一种基于深度强化学习的无人机编队避撞方法,对无人机编队整体进行协调控制,以达到避免碰撞并顺利完成任务的目的。

6.为了实现以上发明目的,本发明采取的技术方案如下:

7.一种基于深度强化学习的无人机编队避撞方法,具体步骤如下:

8.步骤一:选择深度强化学习模型作为主体框架,然后根据行业成熟实验设置初始参数,明确训练目标是输出使得无人机能够自主避撞飞行的策略,并在此基础上通过设置不同的约束条件使得无人机能够保持编队;

9.步骤二:通过模仿学习,在仿真环境中训练无人机,使得无人机模仿人类的选择行为进行运行,通过选择不同行为设置不同的奖励值来逐渐生成一条基于避撞行为的策略,然后记录无人机的各种状态信息和避撞策略,并做一定的存储,将其作为后续学习模型的输入信息;

10.步骤三:通过采用循环神经网络中的lstm方式处理外部的环境信息,主要是障碍物的状态信息,再结合步骤二中的无人机自己的状态信息,在初始策略的基础上进行训练,训练的过程中通过采用二阶动力学模型,调整无人机的速度,以便获取平稳的速度变化,训练的期望值是无人机能够以较短的路径抵达目标位置;

11.其中,长短期记忆(long short-term memory,lstm)是一种特殊的rnn,主要是为了解决长序列训练过程中的梯度消失和梯度爆炸问题。简单来说,就是相比普通的rnn,lstm能够在更长的序列中有更好的表现。

12.步骤四:在避撞的基础上添加不同的约束条件使得无人机在避免队间碰撞的基础上保持一定的队形进行飞行,并通过模型不断运行优化,期望输出一条灵活的、保持队形的、并能够在执行避撞行为后回归正确路径的飞行策略。步骤一中,环境中包括领导者、追随者和障碍物,分别通过上标l,f,o进行表示;

13.在t时刻无人机的状态空间表示为s

t

,行为空间可表示为a

t

,训练环境中的其他参数为:t表示时间,δt表示时间步长,表示无人机在t时刻的位置,表示无人机在t时刻的速度,r为占用半径,pg=[p

gx

,p

gy

]表示目标位置,v

pref

为期望速度,θ

t

为航向角度,为跟随者的状态空间,为领导者的状态空间,为障碍物的状态空间;

[0014]

其在t时刻的状态信息s

t

表示为其中表示无人机可以观测到的状态信息;表示无人机无法观测到的隐藏状态信息;

[0015]

对于无人机的行为a

t

,假设无人机收到控制指令后可以迅速做出反应,设定训练的目标是设计追随者的策略π:来选择适当的行动来保持队形和避开障碍物;

[0016]

在学习结构中,转化为一个目标函数和一组约束的优化问题,目标函数是多目标函数的一种形式,由跟随者到达目标所需要的时间tg和保持编队所累积的误差组成;同时,该约束条件中也包含避撞问题;

[0017]

编队避撞的目标函数如下所示:

[0018][0019][0020][0021][0022]

式(1.2)中,表示环境中的不包含追随者的其他无人机,h

t

表示追随者相对于领导者的期望相对偏移向量;(1.2)表示避免碰撞的约束条件,(1.3)表示到达目标地点的约束条件,(1.4)表示无人机的运动学约束。

[0023]

步骤二具体的包括以下过程:

[0024]

首先,定义无人机的联合状态空间其中表示所有追随者的可观测空间,表示障碍物的可观测空间。

[0025]

其次,设计一个值网络来估计状态空间的值,值网络的目的是找到最优的值函数,值函数的定义如下所示:

[0026][0027]

式(1.5)中,表示在t时刻所获取的奖励,γ表示折扣因子;

[0028]

对于最优策略π

*

:从值函数中进行迭代获取:

[0029][0030]

式(1.6)中表示时间t和t+δt之间的转移概率。

[0031]

最后,基于强化学习的思想将采用队形评价函数来解决队形控制问题,用于队形质量的评价和队形奖励的计算,实时反映编队轨迹的误差;把目标位置和实际位置之间的欧氏距离作为输入;构造的针对编队的奖励函数定义为:

[0032][0033]

式(1.7)中,表示在时刻t所形成的编队误差值;

[0034]

避撞的奖励函数表示如下:

[0035][0036]

式(1.8)中表示追随者和其他无人机之间的最小距离;

[0037]

综合式(1.7)和式(1.8)得到完整的奖励函数r

t

为:

[0038][0039]

步骤三中,所述的二阶动力模型为:

[0040][0041]

式(1.10)中,和分别表示追随者的位置、速度和控制输入向量;与此相对,和表示领导者的位置和速度向量;根据所需要维持的编队队形,追随者应该与领导者保持一定的距离,h

p

=[h

x

,hy]

t

表示相对于领导者追随者所需要保持的相对偏移向量;

[0042]

假设ζf=[(pf)

t

,(vf)

t

]

t

表示追随者的位置和速度,ζ

l

=[(p

l

)

t

,(v

l

)

t

]

t

表示领导者的位置和速度,两者的相对偏移向量为则对于任意给定的初始状态追随者和领导者保持队形的条件为:

[0043][0044]

根据控制条件假设如下控制协议,其中,k1,k2》0:

[0045][0046]

与现有技术相比,本发明的优点在于:

[0047]

针对无人机避撞行为难以与无人机编队行为有效统一,传统的避撞方式缺乏灵动性,且无法与无人机编队系统进行灵活整合,而传统的编队控制大多数基于控制理论,更倾向于固定不变的运动任务,缺少对于动态环境的动态调整。因此本发明从深度强化学习领域的角度出发,提出基于深度强化学习的无人机编队避撞方法,实现无人机避撞和编队的有效统一,可以有效地整合资源,并且可以实时调整个体的行为来获取最优的避撞行为,极大提高了集群系统的机动性和对于复杂环境的适应性。

附图说明

[0048]

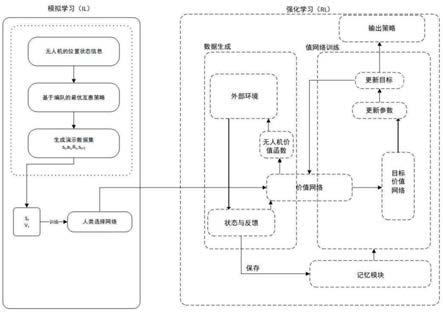

图1是本发明的编队避撞的总体思路图;

[0049]

图2是本发明的通过lstm模块处理数据的流程示意图;

[0050]

图3是本发明的编队避撞的总体算法结构图。

具体实施方式

[0051]

为使本发明的目的、技术方案及优点更加清楚明白,以下根据附图并列举实施例,对本发明做进一步详细说明。

[0052]

一种深度强化学习的无人机编队避撞方法,具体步骤如下:

[0053]

步骤一:首先选择深度强化学习模型作为主体框架,然后根据行业成熟实验设置初始参数,明确训练目标是输出使得无人机能够自主避撞飞行的策略,并在此基础上通过设置不同的约束条件使得无人机能够在一定程度上保持编队。发明所涉及的环境中包括领导者,追随者和障碍物,为了便于区分,将通过上标f,l,o进行划分。

[0054]

在t时刻无人机的状态空间可表示为s

t

,行为空间可表示为a

t

,训练环境中的其他参数如表1中所示。

[0055]

表1参数明细表

[0056][0057][0058]

通过表1可以明确无人机在运行过程中的各种信息,其在t时刻的状态信息s

t

可以表示为其中表示无人机可以观测到的状态信息;表示无人机无法观测到的隐藏状态信息。

[0059]

对于无人机的行为a

t

,假设无人机收到控制指令后可以迅速做出反应,因此设定训练的目标是设计追随者的策略π:来选择适当的行动来保持队形和避开障碍物。

[0060]

在学习结构中,这个问题可以转化为一个目标函数和一组约束的优化问题,目标函数是多目标函数的一种形式,由跟随者到达目标所需要的时间tg和保持编队所累积的误差组成。同时,该约束条件中也包含避撞问题。

[0061]

因此,编队避撞的目标函数如下所示:

[0062][0063][0064][0065][0066]

式(1.2)中,表示环境中的不包含追随者的其他无人机,h

t

表示追随者相对于领导者的期望相对偏移向量。(1.2)表示避免碰撞的约束条件,(1.3)表示到达目标地点的约束条件,(1.4)表示无人机的运动学约束。

[0067]

步骤二:通过模仿学习,在仿真环境中训练无人机,使得无人机模仿人类的选择行为进行运行,通过选择不同行为设置不同的奖励值来逐渐生成一条基于避撞行为的策略,然后记录无人机的各种状态信息和避撞策略,并做一定的存储,将其作为后续学习模型的输入信息。

[0068]

首先定义无人机的联合状态空间其中表示所有追随者的可观测空间,表示障碍物的可观测空间。

[0069]

其次设计一个值网络来估计状态空间的值,值网络的目的是找到最优的值函数,值函数的定义如下所示:

[0070][0071]

式(1.5)中,表示在t时刻所获取的奖励,γ表示折扣因子。

[0072]

对于最优策略π

*

:可以从值函数中进行迭代获取。例如:

[0073][0074]

式(1.6)中表示时间t和t+δt之间的转移概率。

[0075]

最后,基于强化学习的思想将采用队形评价函数来解决队形控制问题,其本质是用于队形质量的评价和队形奖励的计算,特别是能够实时反映编队轨迹的误差。把目标位置和实际位置之间的欧氏距离作为输入。构造的针对编队的奖励函数定义为:

[0076][0077]

式(1.7)中,表示在时刻t所形成的编队误差值。而针对于避撞的奖励函数表示如下:

[0078][0079]

式(1.8)中表示追随者和其他无人机之间的最小距离。综合式(1.7)和式(1.8)得到完整的奖励函数为:

[0080][0081]

综合避撞和集群的思想可以构思无人机集群避撞的思路如图1所示。

[0082]

步骤三:再次,通过采用循环神经网络中的lstm方式处理外部的环境信息,主要是障碍物的状态信息,再结合步骤二中的无人机自己的状态信息,在初始策略的基础上进行训练,训练的过程中通过采用二阶动力学模型,调整无人机的速度,以便获取平稳的速度变化,训练的期望值是无人机能够以较短的路径抵达目标位置。

[0083]

在时刻t,障碍物的状态被视为lstm网络的输入序列,lstm网络逐个处理障碍物的状态信息如图2所示,最终生成所有障碍物的编码信息。采用lstm网络可以解决障碍物数目不确定的问题,从而避免因障碍物数目改变而进行更新网络。

[0084]

所选择的二阶动力模型如下:

[0085][0086]

式(1.10)中,和分别表示追随者的位置、速度和控制输入向量。与此相对,和表示领导者的位置和速度向量。根据所需要维持的编队队形,追随者应该与领导者保持一定的距离,因此h

p

=[h

x

,hy]

t

表示相对于领导者追随者所需要保持的相对偏移向量。

[0087]

假设ζf=[(pf)

t

,(vf)

t

]

t

表示追随者的位置和速度,ζ

l

=[(p

l

)

t

,(v

l

)

t

]

t

表示领导者的位置和速度,两者的相对偏移向量为则对于任意给定的初始状态追随者和领导者保持队形的条件如下所示:

[0088][0089]

根据控制条件可假设如下控制协议(其中,k1,k2》0):

[0090][0091]

步骤四:最后,在避撞的基础上添加不同的约束条件使得无人机在避免队间碰撞的基础上保持一定的队形进行飞行,并通过模型不断运行优化,期望输出一条灵活的、保持队形的、并能够在执行避撞行为后回归正确路径的飞行策略。。

[0092]

无人机编队避撞算法的主体框架如如图3所示。

[0093]

步骤中的训练过程可以细分为:

[0094]

(1)执行基于编队的最优互惠避撞策略算法,收集演示数据集然后转入(2)。

[0095]

(2)通过演示数据集初始化价值网络v,然后转入(3)。

[0096]

(3)初始化目标价值网络然后转入(4)。

[0097]

(4)初始化经验回放记忆用来打破数据间的关联性,然后转入(5)。

[0098]

(5)进行循环,如果未达到最大执行次数便执行下述步骤,否则退出,并返回价值函数v。

[0099]

a)初始化随机训练空间

[0100]

b)重复执行下述步骤直到成功或者超时:

[0101]

i.a

←

挑选行为

[0102]

ii.通过最大化价值函数和反馈函数之和来挑选最优的行为

[0103][0104]

iii.保存元组至经验回放记忆m中

[0105]

iv.从m中随机抽取训练批次

[0106]

v.设置输出的期望值

[0107]

vi.基于价值函数执行梯度下降

[0108]

c)每训练c次便更新一次目标价值网络

[0109]

d)结束,返回价值函数v

[0110]

本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的实施方法,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。本领域的普通技术人员可以根据本发明公开的这些技术启示做出各种不脱离本发明实质的其它各种具体变形和组合,这些变形和组合仍然在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1