一种基于多智能体深度强化学习的多无人机编队集群控制方法

1.本发明属于多无人机编队集群的智能协同技术领域,尤其涉及一种基于多智能体深度强化学习的多无人机编队集群控制方法。

背景技术:

2.随着无人机技术的深入发展,有关多无人机编队集群的研究也受到更多关注。无人机相互协同共同组成编队集群能够发挥出单无人机所不具有的优势,更加胜任复杂、多任务等场景下的工作。目前,有越来越多的人使用强化学习方法进行无人机编队系统的控制。但是大多数基于强化学习方法的无人机控制都只适应具有较少无人机数量的情况,随着编队集群中的无人机数量增多,训练更加困难,收敛速度更慢,收敛之后的效果也更差。此外,其他的适应具有较多无人机数量的强化学习训练方法则较难形成精确的集群编队结构,仅能实现无人机的一致性运动。

技术实现要素:

3.鉴于此,本发明公开提供了一种基于多智能体深度强化学习的多无人机编队集群控制方法,从而能够实现在更加胜任复杂、多任务等场景下的工作。

4.本发明的技术方案:一种基于多智能体深度强化学习的多无人机编队集群控制方法,包括如下步骤:

5.步骤一:对单无人机的运动过程进行建模;

6.步骤二:将多无人机之间的聚集问题建模为马尔科夫博弈过程;

7.步骤三:使用多智能体深度强化学习方法进行训练,使用actor网络学习聚集策略,critic网络评价学习效果引导无人机聚集;

8.步骤四:在训练过程中引入注意力机制到critic网络中加快训练速度和提升训练效果;

9.步骤五:得到多个无人机的相互聚集模型,完成对应子编队的聚集;

10.步骤六:基于坐标转换将多个不同的编队统一到一起形成一个无人机集群。

11.优选地,步骤一中对单无人机运动过程进行建模具体为:

12.首先定义一个向量集合p=[p1,p2,

…

,pn]

t

,其为集群中的所有无人机在笛卡尔坐标系下的位置,由向量pi=(xi,yi,zi)

t

可确定无人机i在空间中的位置,对单架无人机的运动过程进行建模,有如下公式:

[0013][0014]

其中vi为无人机i的飞行速度,θi和φi分别为无人机i的俯仰角和航向角;在无人机的飞行过程中,通过施加控制输入引导无人机的飞行,给定如下控制输入公式:

[0015][0016]

其中pi和vi分别为无人机i的位置和速度,为在三个方向上的控制输入量。

[0017]

优选地,步骤二中将多无人机之间的聚集问题建模为马尔科夫博弈过程,无人机对应为智能体,给定对应的状态空间、动作空间和奖励函数设定:

[0018]

其中所述状态空间:编队中包含领导者无人机和跟随者无人机,此处从领导者与跟随者的角度对状态空间进行分类,对应的有领导者无人机s

l

和跟随者无人机的状态sf;定义领导者无人机的状态空间为:

[0019]st

=(p

l

,p

tar

,v

l

)

[0020]

跟随者无人机的状态空间为:

[0021]

sf=(pf,p

l

,v

l

,vf)

[0022]

一般情况下领导者无人机向自己的既定目标位置p

tar

=(x

tar

,y

tar

,z

tar

)运动,跟随者无人机通过获取领导者无人机的位置信息,得到自己与其相对位置关系并保持队形;p

l

=(x

l

,y

l

,z

l

)为领导者无人机在笛卡尔坐标系中的坐标,pf=(xf,yf,zf)为跟随者无人机的位置坐标,v

l

为领导者无人机的速度,vf为跟随者无人机的速度;最终有联合状态空间:

[0023]

s=(p

l

,pf,p

tar

,v

l

,vf)

[0024]

动作空间:对无人机的控制主要通过速度和角度的改变实现;此处将动作空间设定为:

[0025]

a=(uv,ur,u

p

)

[0026]

其中av为对无人机速度的控制输入,对速度的控制变化量满足如下条件:

[0027][0028]

角度的控制量包含ur和u

p

,分别为对航向角和俯仰角度的变化控制,对航向角有:

[0029][0030]

其中[-r

φ

,r

φ

]为航向角的允许转向范围,对俯仰角同样有[-p

θ

,p

θ

],控制输入与上式类似;

[0031]

所述奖励函数为(1)领导者无人机的奖励:

[0032][0033]

其中r

tar

>0为目标区域半径,当领导者无人机与目标点距离小于该半径时,即视为到达目标点,给予一个正向奖励α

l

;反之,对其进行惩罚,惩罚程度与目标点的距离成正比,即距离越远惩罚越大;

[0034]

(2)跟随者无人机的奖励:

[0035][0036]

对跟随者的奖励设定类似领导者无人机,当跟随者无人机处于期望位置区域时给予正向奖励αf;反之,给予负奖励进行惩罚;

[0037]

(3)无人机之间的避免碰撞的奖励:

[0038][0039]

(4)全局奖励:

[0040][0041]

优选地,步骤四中在训练过程中引入注意力机制到critic网络中的改进如下:在评价值函数部分中加入了一个注意力模块;利用新加入的注意力模块来聚合评价函数部分的输入信息(x,a1,...,an),其中x=(o1,...,on)为所有无人机的观察信息的集合,加入注意力机制后的值函数可以表示为:

[0042][0043]

其中,fi为一个两层的mlp网络,用于估计衡量该无人机的动作状态值函数;gi为一个一层的mlp网络,用来对无人机本身的状态观察值和动作值进行编码;ci为衡量其他无人机对无人机i的影响程度:

[0044][0045]

其中h是一个非线性的relu函数,同时用注意力权重αj表示无人机j对无人机i的影响;由ci得出无人机j所占的权重越大,则其对无人机i的影响也越大,对注意力权重αj进行softmax归一化,有:

[0046][0047]

对应的第i架无人机的评价函数更新为:

[0048][0049]

其中y为目标网络的值函数:

[0050][0051]

同时第i架无人机的动作值函数更新为:

[0052][0053]

优选地,步骤五中将多个不同的子编队坐标系转换到同一个集群坐标下完成集群的统一:

[0054]

两种坐标系之间在对应轴上有关于角度的旋转关系,考虑编队在水平航向角和纵向俯仰角上的角度变化,首先将编队坐标系ofxfyfzf绕地面坐标系的ogzg轴旋转得到一个水

平方向的-φ角,可以得到一个过渡旋转矩阵:

[0055][0056]

其次,绕地面坐标系的ogyg轴旋转得到关于垂直于水平面的纵向方向上的俯仰角度θ,同样可得到一个过渡的旋转矩阵:

[0057][0058]

由此可得到编队坐标系相对于地面坐标系的旋转矩阵:

[0059][0060]

优选地,步骤六中基于坐标转换将多个不同的编队统一到一起形成一个无人机集群;具体为:

[0061]

假设某编队在x,y和z轴三个方向上分别移动了dx,dy和dz,对其中的任意一架无人机都有p

t

=p+t=[x+dx,y+dy,z+dz],其中t=[dx,dy,dz],同样可以矩阵的形式表示平移运动的过程。为方便计算,引入一个齐次坐标w,取w=1;对该无人机有pw=[x,y,z,w],因此进行平移后的齐次坐标可表示为:

[0062][0063]

其中为进行齐次化处理后的平移矩阵,结合可能发生的旋转r,最终可得编队中任意无人机在地面坐标系下发生的坐标变换:

[0064][0065]

其中p'为无人机在地面坐标系下发生旋转和平移运动后对应的在编队坐标系中的位置;不同的编队向同一个聚集点靠拢,通过上述坐标变换关系统一到同一个集群坐标系下完成集群的聚集。

[0066]

本发明提出了一种基于多智能体深度强化学习的多无人机编队集群控制方法,通过对多无人机的聚集问题进行马尔科夫博弈过程建模,使得无人机自主训练得到对应控制模型。并引入注意力机制加快训练速度和提升训练效果。最终,经过对坐标进行变换完成多个不同编队的聚集。

[0067]

应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本发明的公开。

附图说明

[0068]

此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本发明的实施例,并与说明书一起用于解释本发明的原理。

[0069]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0070]

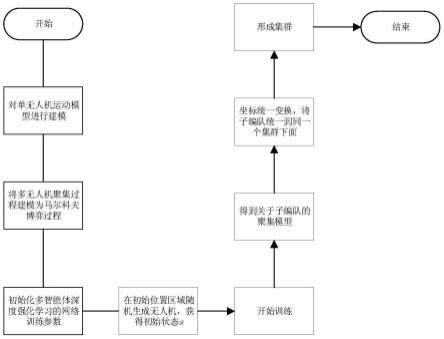

图1是本发明提供的了一种基于多智能体深度强化学习的多无人机编队集群控制方法的流程图;

[0071]

图2是本发明公开实施例中所述加入注意力机制后的多智能体深度强化学习方法示意图;

[0072]

图3是本发明实施例中公开的地面坐标系与编队坐标系的对应关系示意图;

[0073]

图4是本发明实施例中公开的集群的聚集示意图;

[0074]

图5是本发明实施例中公开的训练过程中的全局奖励曲线的变化图;

[0075]

图6是本发明实施例中公开的跟随者无人机奖励对比图;

[0076]

图7是本发明实施例中公开的集群契合度变化图。

具体实施方式

[0077]

这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本发明相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本发明的一些方面相一致的系统的例子。

[0078]

本发明的基于强化学习进行编队控制主要是通过在训练阶段给定控制输入,训练完成后得到符合要求的控制策略,最终在测试和应用阶段即可将得到的控制策略应用到无人机上面;此种方法无需进行大量复杂的集群系统建模,具有一定优势。

[0079]

本发明提供了一种基于多智能体深度强化学习的多无人机编队集群控制方法,通过对多无人机的聚集问题进行马尔科夫博弈过程建模,使得无人机自主训练得到对应控制模型。并引入注意力机制加快训练速度和提升训练效果。最终,经过对坐标进行变换完成多个不同编队的聚集。

[0080]

如图1-4所示,上述方法具体包括如下步骤:

[0081]

步骤一:对单无人机的运动过程进行建模;

[0082]

首先定义一个向量集合p=[p1,p2,

…

,pn]

t

,其为集群中的所有无人机在笛卡尔坐标系下的位置,由向量pi=(xi,yi,zi)

t

可确定无人机i在空间中的位置。对单架无人机的运动过程进行建模,有如下公式:

[0083]

[0084]

其中vi为无人机i的飞行速度,θi和φi分别为无人机i的俯仰角和航向角。在无人机的飞行过程中,通过施加控制输入引导无人机的飞行。给定如下控制输入公式:

[0085][0086]

其中pi和vi分别为无人机i的位置和速度。为在三个方向上的控制输入量,通过对ui的输入控制可以改变无人机的速度和角度等参数。

[0087]

步骤二:将多无人机之间的聚集问题建模为马尔科夫博弈过程;

[0088]

无人机对应为智能体,给定对应的状态空间、动作空间和奖励函数设定:

[0089]

状态空间:编队中包含领导者无人机和跟随者无人机,此处从领导者与跟随者的角度对状态空间进行分类,对应的有领导者无人机s

l

和跟随者无人机的状态sf。定义领导者无人机的状态空间为:

[0090]st

=(p

l

,p

tar

,v

l

)

[0091]

跟随者无人机的状态空间为:

[0092]

sf=(pf,p

l

,v

l

,vf)

[0093]

一般情况下领导者无人机向自己的既定目标位置p

tar

=(x

tar

,y

tar

,z

tar

)运动,跟随者无人机通过获取领导者无人机的位置信息,得到自己与其相对位置关系并保持队形。p

l

=(x

l

,y

l

,z

l

)为领导者无人机在笛卡尔坐标系中的坐标,pf=(xf,yf,zf)为跟随者无人机的位置坐标,v

l

为领导者无人机的速度,vf为跟随者无人机的速度。最终有联合状态空间:

[0094]

s=(p

l

,pf,p

tar

,v

l

,vf)

[0095]

动作空间:对无人机的控制主要通过速度和角度的改变实现。此处将动作空间设定为:

[0096]

a=(uv,ur,u

p

)

[0097]

其中av为对无人机速度的控制输入,对速度的控制变化量满足如下条件:

[0098][0099]

角度的控制量包含ur和u

p

,分别为对航向角和俯仰角度的变化控制,对航向角有:

[0100][0101]

其中[-r

φ

,r

φ

]为航向角的允许转向范围,对俯仰角同样有[-p

θ

,p

θ

],控制输入类似上式;

[0102]

奖励函数:(1)领导者无人机的奖励:

[0103][0104]

其中r

tar

>0为目标区域半径,当领导者无人机与目标点距离小于该半径时,即视为到达目标点,给予一个正向奖励α

l

。反之,对其进行惩罚,惩罚程度与目标点的距离成正比,即距离越远惩罚越大。

[0105]

(2)跟随者无人机的奖励:

[0106][0107]

对跟随者的奖励设定类似领导者无人机,当跟随者无人机处于期望位置区域时给予正向奖励αf。反之,给予负奖励进行惩罚。

[0108]

(3)无人机之间的避免碰撞的奖励:

[0109][0110]

(4)全局奖励:

[0111][0112]

步骤三:使用多智能体深度强化学习方法进行训练,使用actor网络学习聚集策略,critic网络评价学习效果引导无人机聚集;

[0113]

步骤四:在训练过程中引入注意力机制到critic网络中加快训练速度和提升训练效果;

[0114]

对critic网络输入部分的改进如下:

[0115]

在评价值函数部分中加入了一个注意力模块。更具体的,利用新加入的注意力模块来聚合评价函数部分的输入信息(x,a1,...,an),其中x=(o1,...,on)为所有无人机的观察信息的集合。加入注意力机制后的值函数可以表示为:

[0116][0117]

其中,fi为一个两层的mlp网络,用于估计衡量该无人机的动作状态值函数。gi为一个一层的mlp网络,用来对无人机本身的状态观察值和动作值进行编码。ci为衡量其他无人机对无人机i的影响程度:

[0118][0119]

其中h是一个非线性的relu函数,同时用注意力权重αj表示无人机j对无人机i的影响。由ci可以看出,无人机j所占的权重越大,则其对无人机i的影响也越大。对注意力权重αj进行softmax归一化,有:

[0120][0121]

由此,不同无人机利用彼此之间的相似度确定对应的注意力,并依据注意权重的大小获取关键的信息。通过改变无人机的中心化评价函数的输入方式,获得不同的奖励反馈,最终引导无人机采取能够获得更多奖励的行为。

[0122]

对应的第i架无人机的评价函数更新变为了:

[0123]

[0124]

其中y为目标网络的值函数:

[0125][0126]

同时第i架无人机的动作值函数更新公式为:

[0127][0128]

步骤五:得到多个无人机的相互聚集模型,完成对应子编队的聚集;

[0129]

步骤六:基于坐标转换将多个不同的编队统一到一起形成一个无人机集群;

[0130]

将多个不同的子编队坐标系转换到同一个集群坐标下完成集群的统一:

[0131]

两种坐标系之间在对应轴上有关于角度的旋转关系。这里考虑编队在水平航向角和纵向俯仰角上的角度变化,首先将编队坐标系ofxfyfzf绕地面坐标系的ogzg轴旋转得到一个水平方向的-φ角,可以得到一个过渡旋转矩阵:

[0132][0133]

其次,绕地面坐标系的ogyg轴旋转得到关于垂直于水平面的纵向方向上的俯仰角度θ,同样可得到一个过渡的旋转矩阵:

[0134][0135]

由此可得到编队坐标系相对于地面坐标系的旋转矩阵:

[0136][0137]

子编队在空间中相对于地面坐标系除可能发生旋转还会有平移运动,假设某编队在x,y和z轴三个方向上分别移动了dx,dy和dz。对其中的任意一架无人机都有p

t

=p+t=[x+dx,y+dy,z+dz],其中t=[dx,dy,dz],同样可以矩阵的形式表示平移运动的过程。为方便计算,引入一个齐次坐标w,取w=1。对该无人机有pw=[x,y,z,w],因此进行平移后的齐次坐标可表示为:

[0138][0139]

其中为进行齐次化处理后的平移矩阵。结合可能发生的旋转r,最终可得编队中任意无人机在地面坐标系下发生的坐标变换:

[0140][0141]

其中p'为无人机在地面坐标系下发生旋转和平移运动后对应的在编队坐标系中的位置。不同的编队向同一个聚集点靠拢,通过上述坐标变换关系统一到同一个集群坐标系下完成集群的聚集。

[0142]

应用本发明提供的方法,图5展示了训练过程中的全局奖励曲线的变化图。编队聚集是一种合作场景,因此在全局奖励中包含领导者和跟随者在内的所有无人机。可以看到在训练初期两种算法都经历了一个探索过程,奖励值的波动较大,后续随着训练经验的增多,奖励值开始慢慢增大。加入了注意力模块后的a-maddpg算法的收敛速度更快,在大约4000个episode时就已经达到收敛状态,而maddpg则在大约6000个episode时才收敛到稳定状态。最后奖励值达到平衡状态时,基于注意力机制的a-maddpg算法的奖励值要更大,说明其训练效果更好,因此才能获得更大的奖励,更高的奖励值也意味着编队的聚集效果更好。

[0143]

图6展示了在训练时子编队中所有跟随者无人机的奖励值的变化情况。可以看到基于a-maddpg方法训练后的跟随者无人机的奖励值收敛更快,在大约3500个episode时收敛到稳定状态,而maddpg则在约6000个episode时才达到稳定状态,达到稳定状态时同样是基于a-maddpg方法的奖励值要更高。其次可以看到基于a-maddpg方法的奖励值的变化范围要小于maddpg,其奖励值区域的下界隐藏在基于maddpg的奖励值区域内,说明加入注意力机制后的方法的训练效果要更好。因为a-maddpg方法中的跟随者无人机在学习过程中能够更加关注领导者无人机的状态信息,因此无效探索的行为更少,反应在奖励值的变化上就是波动范围更小。

[0144]

图7展示了在集群聚集过程中无人机与期望队形结构的契合程度的变化曲线,定义一个目标函数f(x),f(x)的值越小,契合程度越高。有:

[0145][0146]

其中n为无人机的架数,d(

·

)为距离,用来度量第i架无人机距其虚拟结构中对应点的成本,为该无人机在地面坐标下的位置,为其在虚拟结构中对应的期望位置,则为对应的无人机在编队坐标系和地面坐标系下的转换关系。可以看到在聚集的初始阶段,由于无人机的初始位置是随机的,所以两种方法的初始契合度并不相同,但是基于注意力机制的a-maddpg的收敛速度更快,因此契合度的提升也更快,在图中体现为函数值减小的速率更大,在最终达到收敛时与设定队形的契合度也要更高。

[0147]

以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明技术原理的前提下,还可以做出若干改进和变形,这些改变和变形也应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1