飞行器减载制导方法、设备、存储介质与流程

本技术涉及飞行器制导控制,尤其涉及一种飞行器减载制导方法、设备、存储介质。

背景技术:

1、飞行器(如运载火箭)在发射起飞后的大气层内上升段飞行过程中,在高空中易受到大风的影响导致飞行器受到较大的法向过载和侧向过载。由于飞行器的结构具有长细比较大的特点,此时若法向过载或侧向过载过大时,易发生飞行器自身结构变形导致飞行器因弹性模态发生巨大变化而姿态失稳。甚至发生飞行器断裂,导致飞行任务失败。

2、在飞行过程中,飞行环境中的风场复杂多变且难以进行实时感知测量。目前飞行器的制导律采用传统控制策略设计,在未知风场中减载控制能力较弱,在遇到极大的外界干扰时很难实现飞行器的减载控制。

技术实现思路

1、为了解决上述技术缺陷之一,本技术提供了一种飞行器减载制导方法、设备、存储介质。

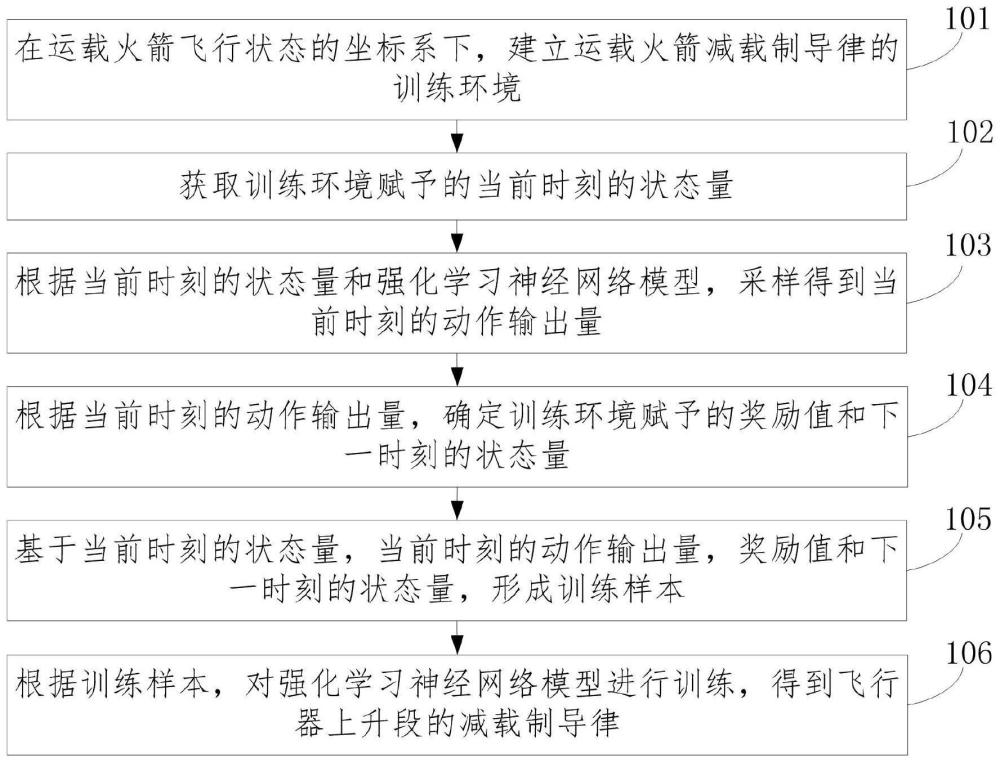

2、本技术第一个方面,提供了一种飞行器减载制导方法,该方法包括:

3、在飞行器飞行状态的坐标系下,建立飞行器减载制导律的训练环境;

4、获取训练环境赋予的当前时刻的状态量;

5、根据当前时刻的状态量和强化学习神经网络模型,采样得到当前时刻的动作输出量;

6、根据当前时刻的动作输出量,确定训练环境赋予的奖励值和下一时刻的状态量;

7、基于当前时刻的状态量,当前时刻的动作输出量,奖励值和下一时刻的状态量,形成训练样本;

8、根据训练样本,对强化学习神经网络模型进行训练,得到飞行器上升段的减载制导律。

9、可选地,飞行器飞行状态的坐标系以发射点为坐标原点,垂直于地面方向为横轴,飞行器法向飞行方向的负向为纵轴,右手定则得到竖轴。

10、可选地,在飞行器飞行状态的坐标系下,建立飞行器减载制导律的训练环境,包括:

11、在飞行器飞行过程中,确定飞行器在飞行器飞行状态的坐标系下的位置、速度以及法向过载;

12、对于任意时刻x,根据飞行器在x时刻位置与标准位置的位置误差、飞行器在x时刻速度与标准速度的速度误差及法向过载,确定训练时的状态量sx;

13、将x时刻神经网络制导律输出的程序角确定为训练时的动作输出量ax;

14、基于制导律的跟踪误差以及法向过载构建奖励函数;

15、将飞行器通过sx与ax作用下,得到的x+1时刻位置与标准位置的位置误差、速度与标准速度的速度误差及法向过载,确定为训练时下一时刻的状态量sx+1;

16、基于sx、ax与sx+1和奖励函数,建立飞行器减载制导律的训练环境。

17、可选地,强化学习神经网络模型包括:1个演员网络、2个评论家网络、2个价值网络;

18、其中,价值网络包括1个执行网络和1个目标网络;

19、2个评论家网络的结构相同;

20、2个价值网络的结构相同;

21、根据当前时刻的状态量和强化学习神经网络模型,采样得到当前时刻的动作输出量之前,还包括:

22、根据发射时刻飞行器的位置,对飞行器初始时刻状态进行初始化;

23、对强化学习神经网络模型中的所有网络的参数进行随机初始化;

24、建立一组空的经验回放缓存池,经验回放缓存池用于存放训练样本。

25、可选地,根据当前时刻的状态量,采样得到当前时刻的动作输出量,包括:

26、当前时刻的状态量作为演员网络的输入,前向解算演员网络,得到策略期望μt和策略标准差σt;其中,t为时刻标识;

27、建立正态分布n(μt,σt);

28、进行随机采样,得到满足n(μt,σt)的当前时刻的动作输出量。

29、可选地,根据训练样本,对强化学习神经网络模型进行训练,得到飞行器上升段的减载制导律之前,还包括:

30、确定超参数的值;

31、超参数包括批采样大小batch_size,温度系数λ,τ参数更新权重,演员网络的学习速率α1,评论家网络的学习速率α2,价值网络的学习速率α3,折扣因子γ。

32、可选地,根据训练样本,对强化学习神经网络模型进行训练,得到飞行器上升段的减载制导律,包括:

33、从经验回放缓存池中通过随机采样获取batch_size个训练样本;

34、将获取的训练样本的中的所有状态量形成当前时刻的状态组{st};

35、将获取的训练样本中的所有下一时刻的状态量形成下一时刻的状态组{st+1};

36、将获取的训练样本的所有奖励值形成奖励值组{rt};

37、将获取的训练样本中的所有动作输出量形成动作组{at};

38、将{st}和{at}作为2个评论家网络的输入,进行评论家网络的前向计算,得到两个评论家网络的输出值组

39、将{st}和{st+1}分别作为2个价值网络的输入,得到当前时刻的价值估计{vt}与下一时刻的价值估计{vt+1};

40、计算累积回报{qt_d}={rt}+γ{vt+1};

41、若累积回报达到收敛状态,且当前强化学习神经网络模型的效果达到预设要求,则将当前的任一演员网络作为飞行器上升段的减载制导律;

42、若累积回报未达到收敛状态,或者,当前强化学习神经网络模型未达到预设要求,但重复优化强化学习神经网络模型参数次数未达到预设次数,则优化强化学习神经网络模型的参数,并重复执行将获取的训练样本的当前时刻的状态量形成当前时刻的状态组{st}的步骤及后续步骤;

43、若累积回报未达到收敛状态,或者,当前强化学习神经网络模型未达到预设要求,且重复优化强化学习神经网络模型参数次数达到预设次数,则调整超参数的值,重复执行从经验回放缓存池中获取batch_size个训练样本的步骤及后续步骤。

44、可选地,优化强化学习神经网络模型的参数,包括:

45、计算价值网络的损失函数其中,e[]为期望函数,为中的值,为中的值,h(π)为策略熵;

46、更新执行网络的参数

47、计算评论家网络的损失函数其中,j=1,2,i为样本标识;

48、更新评论家网络的参数

49、计算演员网络的损失函数ja=-qt+λlogh(π),其中,qt为任一评论家网络的输出;

50、更新演员网络的参数

51、更新目标网络的参数θv_t=(1-τ)θv_t+τθv_e。

52、本技术第二个方面,提供了一种电子设备,包括:

53、存储器;

54、处理器;以及

55、计算机程序;

56、其中,所述计算机程序存储在所述存储器中,并被配置为由所述处理器执行以实现如上述第一个方面所述的方法。

57、本技术第三个方面,提供了一种计算机可读存储介质,其上存储有计算机程序;所述计算机程序被处理器执行以实现如上述第一个方面所述的方法。

58、本技术提供一种飞行器减载制导方法、设备、存储介质,该方法包括:在飞行器飞行状态的坐标系下,建立飞行器减载制导律的训练环境;获取训练环境赋予的当前时刻的状态量;根据当前时刻的状态量和强化学习神经网络模型,通过前向推理得到当前时刻的动作输出量;根据当前时刻的动作输出量,确定训练环境赋予的奖励值和下一时刻的状态量;基于当前时刻的状态量,当前时刻的动作输出量,奖励值和下一时刻的状态量,形成训练样本;根据训练样本,对强化学习神经网络模型进行训练,得到飞行器上升段的减载制导律。本技术提供的方法可以解决飞行器上升段在未知风场下的减载制导问题。

- 还没有人留言评论。精彩留言会获得点赞!