混合现实显示装置和混合现实显示方法与流程

1.本发明涉及一种能够体验由现实空间和虚拟物体合成得到的混合现实(mr:mixed reality)空间的混合现实显示装置和混合现实显示方法。尤其涉及适合于多个mr体验者共享mr体验的技术。

背景技术:

2.在游戏或维护作业等的内容(content)中,常常使用一种在现实空间或摄像机拍摄的现实影像中添加增强现实(ar:augmented reality)对象的技术,其中增强现实对象是由cg(computer graphics)等生成的虚拟物体。为了添加ar对象,用摄像机将被称为ar触发器或者标记的影像与背景同时拍摄,来将与ar触发器关联的ar对象合成到现实影像中。尤其是在mr体验中,使用由摄像机和显示器一体构成的头戴式显示器(hmd),基于hmd中搭载的摄像机所拍摄的现实空间的影像,将根据hmd的位置和姿态而生成的ar对象作为虚拟物体的影像叠加显示在现实空间中。

3.关于该技术,专利文献1记载了一种mr系统,为了让多个人共享mr体验,除hmd之外还组合使用了平板电脑等便携信息终端。其中记载了,在该mr系统中,使hmd中显示的mr影像也显示在平板电脑上,平板电脑的用户能够指定所共享的mr影像中的虚拟物体,并将指定的结果反映到mr影像中。

4.现有技术文献

5.专利文献

6.专利文献1:日本特开2016

‑

224810号公报

技术实现要素:

7.发明要解决的技术问题

8.不过,在专利文献1的方法中,便携信息终端的用户仅能够指定虚拟物体,并不能进行在现实空间中配置虚拟物体或者置换虚拟物体的操作。另外,虽然hmd的现实空间能够共享,但便携信息终端的用户自身的现实空间却不能共享。

9.于是专利文献1中存在这些问题,即,在多个人体验mr空间的情况下,hmd佩戴者以外的其他体验者不能进行在现实空间中配置虚拟物体或者置换虚拟物体的操作,并且不能共享其他体验者的现实空间。

10.本发明是鉴于上述问题而完成的,其目的在于提供一种混合现实显示装置和混合现实显示方法,在多个人体验mr空间的情况下,多个体验者能够同时进行在现实空间中配置虚拟物体或者置换虚拟物体等操作,并且多个体验者的现实空间能够共享。

11.解决问题的技术手段

12.为了解决上述问题,本发明的混合现实显示装置与其他体验者佩戴的其他混合现实显示装置连接,彼此共享现实影像和虚拟物体的影像,其包括:摄像机,其用于拍摄现实影像;控制器,其从摄像机拍摄的现实影像中识别现实物体,并基于体验者的操作对所识别

的现实物体关联规定的虚拟物体;显示部,其能够显示所关联的虚拟物体的影像;存储器,其保存现实物体和所关联的虚拟物体的数据;和通信部,其与其他混合现实显示装置连接来收发数据。所述控制器经由所述通信部取得由其他混合现实显示装置生成的现实物体的识别结果和所关联的虚拟物体的数据,将取得的数据与保存在所述存储器中的数据合成,并将合成的影像显示在所述显示部上,并且,能够基于体验者的操作,对显示在所述显示部上的影像,进行要与现实物体关联的虚拟物体的编辑。

13.并且,本发明的混合现实显示方法包括:在多个混合现实显示装置中拍摄现实影像的步骤;将所拍摄的现实影像拼接并识别现实物体的步骤;将基于各体验者的操作而选中的虚拟物体关联到现实物体上进行合成的步骤;在各混合现实显示装置中,基于拼接后的现实物体和所关联的虚拟物体的合成数据来显示共同的影像的步骤;和对于所显示的影像,由各混合现实显示装置的体验者进行要与现实物体关联的虚拟物体的编辑的步骤。

14.发明效果

15.采用本发明,在多个人体验mr空间的情况下,能够由多个体验者进行在现实空间中配置虚拟物体或者置换虚拟物体等操作,并且多个体验者的现实空间能够共享。

附图说明

16.图1a是表示应用了多个mr显示装置的现实空间的例子的图。

17.图1b是表示将背景影像拼接后的状态的图。

18.图2是表示实施例1的mr显示装置的外观结构的图。

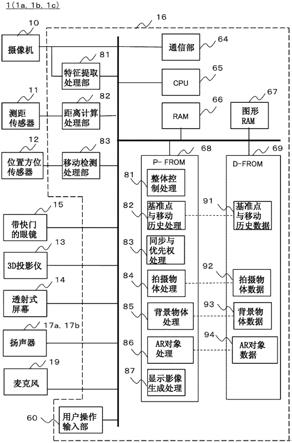

19.图3是表示mr显示装置1的功能结构的框图。

20.图4a是表示配置有ar对象的mr空间的例子的图。

21.图4b是说明交叉对象(cross object)的生成方法的图。

22.图5是整体控制处理81的流程图。

23.图6是基准点与移动历史处理82的流程图。

24.图7是同步与优先权处理83的流程图。

25.图8是拍摄物体处理84的流程图。

26.图9是背景物体处理85的流程图。

27.图10a是ar对象处理86的流程图(场景1)。

28.图10b是ar对象处理86的流程图(场景2)。

29.图11是显示影像生成处理87的流程图。

30.图12a是对拍摄物体设定优先权的操作画面。

31.图12b是对所关联的ar对象进行编辑的操作画面。

32.图13a是头数据的数据表。

33.图13b是基准点与移动历史数据91的数据表。

34.图13c是拍摄物体数据92的数据表。

35.图13d是背景物体数据93的数据表。

36.图13e是ar对象数据94的数据表。

37.图14是表示实施例2的mr空间的例子的图。

38.图15是ar对象处理86的流程图(追加部分)。

39.图16a是拍摄物体数据的数据表。

40.图16b是ar对象数据的数据表。

41.图17是表示实施例3的mr网络系统的结构的图。

42.图18a是mr网络系统的时序图。

43.图18b是表示图18a的时序的详细内容的图。

44.图19是表示实施例4的mr显示装置1’的外观结构的图。

45.图20是表示mr显示装置1’的功能结构的框图。

具体实施方式

46.下面参照附图说明本发明的实施例。下文将混合现实显示装置也称作mr显示装置或者hmd。

47.实施例1

48.实施例1中要说明的是,将多个mr显示装置相互连接,在装置间进行数据交互的系统。

49.[mr显示系统]

[0050]

图1a是表示应用了多个mr显示装置的现实空间的例子的图。该系统包括3台mr显示装置(hmd)1a、1b、1c,mr空间的多个体验者2a、2b、2c在各自的头部佩戴hmd1a、1b、1c。如后文所述,各hmd内置摄像机、测距传感器、显示器、通信部、位置方位传感器,通过摄像机对现实空间进行拍摄,并且利用显示在显示器上的mr影像使体验者观看到mr影像。hmd1a、1b、1c内置的摄像机的拍摄视角用附图标记3a、3b、3c表示。为了在hmd1a、1b、1c之间进行通信,设置有无线lan等的接入点(ap)5。由于体验者(hmd)的位置和视线方向不同,因此各自看到的现实空间不同,但通过在hmd间进行通信,能够体验共同的mr影像。

[0051]

现实空间中,房屋的墙壁4a、4b、4c和地面4d是背景。作为现实物体,在背景上放置了窗户6、沙发7、投影仪8、投影仪8的投影画面8a。mr体验者2a、2b、2c在该现实空间内进行mr体验。具体而言,作为一个例子,设想由多个操作者(mr体验者)进行室内装饰的布局的情景。

[0052]

为了能够共享mr体验,体验者2a、2b、2c进行视线方向(摄像机的拍摄方向)和位置与高度的初始设定(坐标校准)。例如,用摄像机拍摄窗户6,以窗户6的角落6b、6c关于hmd的显示器画面的中央6a对称的方式设定拍摄方向的基准。并保持该状态从窗户6移动到规定距离的位置处,以此作为基准位置。将这样的拍摄方向、位置以及由体验者的身高决定的hmd的高度登记为基准点。基准点的登记由体验者2a、2b、2c分别进行,但也可以用体验者2的高度为基准,按照体验者2b、2c的高度的差进行校正。基准点登记后的体验者2a、2b、2c的移动由位置方位传感器检测,将其作为移动历史数据记录下来。由此,能够将各体验者的位置数据表示在共同的坐标系中。

[0053]

初始化的方法并不限定于上述方法,也可以使用gps传感器、方位中心来进行初始化,只要能够在mr空间的体验者之间共享基准点即可。

[0054]

hmd的摄像机能够拍摄的视角3a、3b、3c仅是现实空间的一部分。在本系统中,将通过hmd1a、1b、1c取得的拍摄视角3a、3b、3c的拍摄影像合成,生成拼接的现实空间的影像(背景影像)。这时,进行视点变换,将拍摄时的各hmd的位置、方位角、高度变换成从基准点拍

摄,在此基础上进行合成。背景影像的拼接在每次体验者2a、2b、2c移动时重复进行,区域重叠的部分用新的背景影像更新。

[0055]

图1b是表示将背景影像拼接后的状态的图。hmd1a拍摄的范围(图1a的拍摄视角)3a、hmd1b拍摄的范围3b、hmd1c拍摄的范围3c是不同拍摄位置的背景影像。对这些影像进行视点变换,得到从基准点拍摄的影像,并映射到以基准点为中心的360度的整周空间,形成拼接的背景影像。

[0056]

在360度的整周空间中,拍摄范围3a、3b、3c并不能够覆盖全部的空间。因此各hmd1a、1b、1c(各体验者2a、2b、2c)移动,并在下一时刻t在新的拍摄范围3at、3bt、3ct进行拍摄。并且,对拍摄范围3at、3bt、3ct的影像进行视点变换,将其追加到已拼接的背景影像中,对背景影像的空间进行扩展。在空间扩展时,将尤其是墙壁的边界、地面与墙壁的接线、窗户的边框这样的特征点重叠地进行扩展,则容易进行拼接。将重复的背景影像的部分置换为时间上较新的背景影像的部分,来对背景影像进行更新。

[0057]

就背景影像的拼接处理而言,也可以不是将hmd的拍摄影像拼接,而是取而代之,在取得了后述的背景物体数据之后,将背景物体数据拼接起来。也可以是,由各个hmd从拍摄影像中取得拍摄物体数据和背景物体数据,将各个hmd所取得的拍摄物体数据共享,并且将背景物体数据拼接起来。

[0058]

像这样,通过进行多个hmd(多个体验者)所取得的背景影像的拼接处理,能够合成出由1台hmd(1位体验者)无法观察到的背景。具体而言,在图1a和图1b中,体验者2b的摄像机的视角3b不能捕捉到沙发7,体验者2c的摄像机的视角3c不能捕捉到投影仪8。但是,通过将各体验者的摄像机影像拼接,并且将所拼接的背景影像由各体验者共享,则能够识别到沙发7、投影仪8的存在,所识别的信息能够作为后述的拍摄物体由多个体验者2a、2b、2c共享。

[0059]

[mr显示装置]

[0060]

图2是表示实施例1的mr显示装置的外观结构的图。mr显示装置(hmd)1(1a~1c)包括摄像机10、测距传感器11、位置方位传感器12、3d投影仪13、透射式屏幕14、带快门的眼镜15、控制器16、扬声器17a、17b、保持具18a、18b、麦克风19。mr的体验者2利用保持具18a、18b将hmd1佩戴在自身的头部。

[0061]

摄像机10以对头部前方(体验者的视线方向)进行拍摄的方式安装,测距传感器11测量其与摄像机10的拍摄影像中捕捉到的现实物体之间的距离。位置方位传感器12由陀螺仪、位置传感器、方位传感器等构成,检测体验者的位置和视线方向。

[0062]

测距传感器11可以是tof(time of flight:飞行时间)方式那样二维地照射光线来测量距离的传感器,也可以是以立体摄像机那样的方式取得轮廓等特征点来计算距离的传感器,只要能够与摄像机的拍摄影像对应地测量摄像机与现实物体之间的距离即可。

[0063]

3d投影仪13将用左眼观察的影像和用右眼观察的影像交替地投影到透射式屏幕14上,来显示3d的虚拟物体(ar对象)。带快门的眼镜15与其同步地使影像左右交替地透射。体验者2能够隔着透射式屏幕14看到前方的风景和现实物体,并且与其叠加地,能够在透射式屏幕14上观看到由3d投影仪13投影的3d的虚拟物体。

[0064]

控制器16取得摄像机10的拍摄影像、测距传感器11的距离数据、位置方位传感器12的位置方位数据,将它们供给到内部的存储器或cpu。另外,生成由3d投影仪13投影的影

像或输出到扬声器17a、17b的声音。并且,生成带快门的眼镜15的驱动信号,与3d投影仪13投影的ar对象的影像同步地切换左右眼镜的透射与否,向体验者提供3d影像。

[0065]

控制器16包括面向mr体验者2的用户接口。在控制器16由智能手机等设备实现的情况下,用户接口能够利用内置有触摸传感器的面板。

[0066]

图3是表示mr显示装置1的功能结构的框图。对于与图2相同的部分标注相同的附图标记。在hmd1的控制器16的内部(用虚线表示)包括特征提取处理部61、距离计算处理部62、移动检测处理部63、通信部64、cpu65、ram66、图形ram67、程序闪存rom(p

‑

from)68、数据闪存rom(d

‑

from)69和用户操作输入部60。

[0067]

特征提取处理部61对来自摄像机10的拍摄影像进行提取现实物体的轮廓(边缘),将轮廓的拐点、顶点作为特征点的处理。距离计算处理部62基于测距传感器11的测量数据计算其到特征点的距离。移动检测处理部63基于位置方位传感器12的测量数据,求得hmd1的位置和移动量以及摄像机10的拍摄方向,即,它们就是体验者2的位置和移动量、视线方向。

[0068]

通信部64将hmd1连接到接入点5,与其他的hmd1之间进行数据交互。或者,能够连接到外部网络,由外部网络上连接的服务器等承担hmd1的一部分处理。

[0069]

程序闪存rom68中保存有各种处理程序。其中包括整体控制处理81、基准点与移动历史处理82、同步与优先权处理83、拍摄物体处理84、背景物体处理85、ar对象处理86、显示影像生成处理87。这些处理程序被加载到ram66中由cpu65执行。

[0070]

数据闪存rom69中保存由执行这些处理程序的过程和结果中产生的数据。其中包括基准点与移动历史数据91、拍摄物体数据92、背景物体数据93和ar对象数据94。由此,在体验者想要重现mr空间来体验的情况下,能够通过读取这些保存的数据来实现其目的。

[0071]

程序闪存rom68和数据闪存rom69可以如图所示由不同的存储器介质构成,也可以由1个存储器介质构成。进而也可以是2个以上的存储器介质,也可以是闪存rom以外的非易失性的存储器介质。另外,数据闪存rom69也可以位于网络上的数据服务器中。

[0072]

显示影像生成处理87生成的影像数据被保存在图形ram67中,通过从图形ram67中读取而由3d投影仪13进行投影。在用户操作输入部60,通过触摸传感器接收用户输入,由3d投影仪13在透射式屏幕14上投影控制菜单影像,对hmd1进行控制。

[0073]

[mr空间]

[0074]

接着,具体说明mr显示装置1的各功能模块的动作,即在现实空间中配置ar对象来生成mr空间的处理。

[0075]

首先,在图1a所示的现实空间中,将现实物体识别并登记为拍摄物体或者背景物体。作为现实空间的房屋由正面墙壁4a、左侧墙壁4b、右侧墙壁4c、地面4d包围,存在有窗户6、沙发7、投影仪8。

[0076]

多个hmd1的摄像机10拍摄这些现实物体,特征提取处理部61进行提取现实物体的轮廓(边缘),并将轮廓的拐点、顶点作为特征点的处理。构成轮廓的特征点的集合被发送到cpu65,来识别物体是什么。这时,可以经由通信部64与外部服务器的影像数据库对照,来进行物体的识别。

[0077]

另一方面,测距传感器11和距离计算处理部62计算到房屋内的各物体的距离,生成现实空间内的概略图。并且,对由特征提取处理部61提取出的特征点组合由距离计算处

理部62计算出的距离数据。进而,在基准点与移动历史处理82中,利用位置方位传感器12和移动检测处理部63记录hmd1是在什么位置(坐标)朝向什么方向的状态下进行拍摄的。

[0078]

通过拍摄物体处理84和背景物体处理85,将识别出的现实物体区分为“拍摄物体”和“背景物体”进行登记。拍摄物体是具有特有的物体形状、并且位于距离数据相对较近处的物体,本例中登记了窗户6、沙发7、投影仪8。另一方面,背景物体例如是不具有平面以外的特有的物体形状、或者距离数据包含最远点的物体,因此在本例中,将正面墙壁4a、左侧墙壁4b、右侧墙壁4c、地面4d登记为背景物体。即,背景物体是构成摄像机的拍摄影像的背景的物体。

[0079]

图4a是表示在现实空间中配置了ar对象的mr空间的例子的图。对于与图1a所示的现实空间相同的物体标注了相同的附图标记,其中作为虚拟物体新配置了ar对象21~26。佩戴着hmd1a~1c的各体验者2a~2c能够体验这样的mr空间。

[0080]

各ar对象21~26与特定的现实物体(拍摄物体或背景物体)的位置相应地(即相关联地、绑定地)配置。ar对象的配置是通过基于各体验者2的操作而执行的ar对象处理86来决定的。该处理也称作“关联处理”。即,在关联处理中,以基于图1b的摄像机影像生成的现实空间的概略图为基础,决定要配置各ar对象的坐标。这时,在ar对象的配置信息(关联信息)中,不仅指定其与哪个物体对应,还指定其配置于物体的哪个部分,因此通过对物体的特定的特征点赋予偏移距离来进行定位。

[0081]

在本例的情况下,tv对象21被配置成用它来置换作为拍摄物体的投影仪8。桌子对象22和花瓶对象23与沙发7关联,其被赋予了距离和方向的偏移以位于沙发7的前面。对花瓶对象23指定了高度方向的偏移,使得花瓶处于正好放置在桌子上的状态。窗帘对象24与窗户6关联,对窗户6的特定的特征点赋予偏移距离来配置该对象。钟表对象25与作为背景物体的墙壁4关联,将正面墙壁4a的任意点设定为伪特征点,在其上配置钟表对象。

[0082]

交叉对象26是能够得到将背景物体用布覆盖的效果的3d对象。本例中,能够应用在作为背景物体的地面4d部分的区域,模拟出一种在地面4d上铺设了地毯的效果。这时,用tv对象21置换的投影仪8也被交叉对象26覆盖,由于存在投影仪8,交叉对象26隆起而形成了皱褶26a。

[0083]

图4b是说明交叉对象26的生成方法的图。使用与要用交叉对象26覆盖的投影仪8之间的距离信息,在与投影仪8接触的位置上配置多边形组26b遮盖投影仪8。在地面部分4d的平面区域和多边形组26b,使用3d计算机图形渲染技术粘贴纹理,生成交叉对象26。

[0084]

[mr显示装置的处理流程]

[0085]

接着,对mr显示装置(hmd)1进行的各种处理流程进行说明。即,cpu65按照程序闪存rom68中保存的以下程序,执行处理。

[0086]

图5是整体控制处理81的流程图。即,表示了在各hmd中从摄像机拍摄至显示ar对象为止的整体的步骤。

[0087]

在s101中,为了参加mr体验而进行登录(login)。登录服务器可以是与ap5直接连接的个人电脑,也可以是从ap5经由网络连接的网络服务器。

[0088]

在s102中开始利用摄像机10对现实空间进行拍摄。摄像机的拍摄可以在执行整个mr显示的时刻进行,例如持续拍摄30fps(frame per second)的动态图像,在执行整个mr显示的时刻捕捉拍摄影像。

[0089]

s103是基准点与移动历史处理82,其中检测hmd的位置、拍摄方向和高度,登记在基准点与移动历史数据91中。

[0090]

s104是同步与优先权处理83。在该处理83中,在参加mr体验的多个hmd之间,进行拍摄物体、背景物体、ar对象的同步和对各拍摄物体、背景物体设定的优先权的处理,将它们更新为最新的状态。所谓优先权是指,例如,将针对特定物体的操作权限分配给特定的hmd(体验者),在设定了优先权的情况下,其他体验者不能对该物体进行编辑。

[0091]

s105是用于生成显示影像的处理87。佩戴着hmd的mr体验者一边确认已将各拍摄物体和背景物体以及优先权更新至最新状态的显示影像,一边进行以下s106的拍摄物体处理84、s107的背景影像处理85、s108的ar对象处理86。

[0092]

s106的拍摄物体处理84对所捕捉的摄像机拍摄影像进行特征提取,选择特征点,针对特征点的集合识别现实物体是什么物体,并将其作为拍摄物体登记到拍摄物体数据92中。

[0093]

在s107的背景物体处理85中,将包含距离数据为最远点的特征点的、除了拍摄物体以外的区域作为背景物体登记在背景物体数据93中,此处,距离数据被赋予各特征点。

[0094]

在s108的ar对象处理86中,选择(追加)要配置于拍摄物体、背景物体的ar对象,并且编辑配置时的参数(显示参数)。在该处理中,包括从网络下载ar对象的数据并由体验者进行选择的操作。将选中的ar对象的数据登记在ar对象数据94中,并将显示参数作为关联数据登记在拍摄物体数据92和背景物体数据93中。

[0095]

s109是显示影像生成处理87,生成s108中追加或者编辑的ar对象的显示影像,mr体验者在各hmd中进行观看。

[0096]

在s110中判断是否继续,在继续的情况下(是)返回s102,在不继续的情况下(否)结束处理。

[0097]

像这样,在本实施例中,将多个体验者2佩戴的多个hmd1相互连接,能够将各hmd取得的拍摄物体、背景物体和与它们关联的虚拟物体(ar对象)的数据同步并共享。其结果是,能够由多个体验者共享同一现实空间,并且各个体验者能够独立地进行在现实空间中配置虚拟物体或者置换虚拟物体等操作。

[0098]

下面详细说明各处理。

[0099]

图6是基准点与移动历史处理82的流程图。该处理是通过位置方位传感器12和移动检测处理部63执行的。

[0100]

在s111中,mr体验者2佩戴hmd1,开始进行摄像机拍摄。

[0101]

在s112中,位置方位传感器12检测hmd1的位置和摄像机10的拍摄方向,取得表示体验者的位置、高度和视线方向的数据。

[0102]

在s113中,确认数据闪存rom69内的基准点与移动历史数据91中是否已登记有基准点数据,即mr体验是否已开始。

[0103]

在已经登记时(是),在s114中将上述数据登记为移动历史数据。在还未登记时(否),在s115中将其登记为基准点数据。移动历史数据由与基准点数据之间的差异表示。

[0104]

之后,每当用户一边在现实空间内移动一边进行摄像机拍摄时,将当前的位置和摄像机拍摄方向这一对数据,作为移动历史登记在基准点与移动历史数据91中。

[0105]

图7是同步与优先权处理83的流程图。

[0106]

首先,所谓同步处理是在多个hmd1之间,进行各自所持有的拍摄物体、背景物体、ar对象的数据的共享和更新至最新状态的处理。

[0107]

在s121中,各hmd经由通信部64与其他hmd进行数据收发,将取得的数据保存在数据闪存rom69中。

[0108]

在s122中,针对拍摄物体数据进行同步。

[0109]

在s123中,针对背景物体数据进行同步。

[0110]

在s124中,针对ar对象数据进行同步。

[0111]

接着,所谓优先权处理是读取对拍摄物体、背景物体所赋予的优先权的处理。对于已设定了优先权的物体,除了进行该设定的mr体验者以外,不能进行编辑(关联ar对象)。

[0112]

在s125中读取对拍摄物体的优先权设定。

[0113]

在s126中读取对背景物体的优先权设定。

[0114]

这些优先权设定信息在执行ar对象的关联处理(s108)时被参照(即,被使用)。

[0115]

图8是拍摄物体处理84的流程图。该处理是通过特征提取处理部61执行的。

[0116]

在s131中从摄像机10读取拍摄影像。

[0117]

在s132中进行影像的特征分析,例如提取边缘,并将边缘的顶点、拐点提取为特征点。

[0118]

在s133中,将测距传感器11和距离计算处理部62取得的距离数据附加给特征点。

[0119]

在s134中,评价与前一次的特征点之间的差异。

[0120]

在s135中,根据被评价为有显著差异(significant difference)的特征点的集合,识别物体的类别等。这时,能够经由通信部64与外部服务器的影像数据库对照,来进行物体的识别。

[0121]

在s136中,将识别的结果作为拍摄物体登记在拍摄物体数据92中。

[0122]

在s137中,在所识别的拍摄物体中包含人物的情况下,将其发送到显示影像生成处理87。这是因为摄像机拍摄到其他mr体验者的可能性较高。如果判断为不需要将其他的mr体验者用作mr影像,则将该人物物体的识别信息发送到显示影像生成处理87,请求将其从显示影像中除去。或者,也可以根据s131中的摄像机拍摄影像,由体验者自身判断为是其他的mr体验者,来将其从显示影像中除去。

[0123]

图9是背景物体处理85的流程图。

[0124]

在s141中,选择由特征提取处理部61所提取的特征点之中、具有最远距离的特征点。在图1a的例子中,相当于正面墙壁4a的角落等。于是,选定包含具有最远距离的特征点的、并且没有被识别为是拍摄物体的区域,将其作为区域a。

[0125]

在s142中,选定由特征提取处理部61所提取的特征点之中、无法进行距离检测(超出检测极限)的区域,将其作为区域b。

[0126]

在s143中,将上述所选定的区域a和区域b用作现实空间的背景物体。

[0127]

在s144中,计算与已登记的背景物体数据之间的差异数据。

[0128]

在s145中,同步从其他hmd取得的背景物体数据。

[0129]

在s146中,将上述差异数据与同步后的背景物体数据合并。

[0130]

在s147中,根据需要将背景物体分割为几个区域。

[0131]

在s148中,在所分割的区域中配置ar对象。例如,如图4a、图4b所示,能够在地面4d

上粘贴交叉对象26。

[0132]

在s149中,将合并后的背景数据和分割后的区域数据作为背景物体登记在背景物体数据93中。

[0133]

图10a和图10b是ar对象处理86的流程图。图10a和图10b中,可以将处理过程的一部分调换,使用任一者的流程。该处理在体验者观看操作画面的同时以对话形式进行。

[0134]

从图10a的情况(场景1)进行说明。

[0135]

在s151中,从拍摄物体或者背景物体(也可以是分割后的区域)选择一个要配置ar对象的物体。

[0136]

在s152中,确认选中的物体是否被其他hmd设定了优先权。为此,参照上述同步与优先权处理83中的优先权的读取结果(图7、s125、s126)。在设定有优先权的情况下(是)进入s156,在没有设定的情况下(否),进入s153。

[0137]

在s153中对选中的物体进行优先权的设定登记。由此,能够优先于其他的hmd对选中的物体进行编辑(关联ar对象)。在选择的是背景物体的情况下,存在对与整个背景物体关联的ar对象赋予的优先权,和对背景物体的每个分割区域赋予的优先权。

[0138]

另外,也能够解除已登记的优先权。优先权的解除指的是,通过接收其他体验者的解除请求(例如通过麦克风19进行语音呼叫),由拥有优先权的体验者改变其设定。或者,也可以由设定优先权的体验者自身进行解除。也可以在解除(删除)ar对象的关联时,使优先权自动消失。具体的设定画面在图12a中表示。

[0139]

在s154中,选择要与选中的物体关联的ar对象。ar对象的候选对象可以预先准备在hmd1中,也可以经由通信部64参照存储在外部服务器中的数据。将选中的ar对象登记在ar对象数据94中。

[0140]

在s155中设定显示ar对象时的显示参数。由此,赋予ar对象相对于物体的显示位置、大小和方向。即,通过相对于选中的物体的某特征点的位置赋予偏移(offset),能够相对于物体将ar对象定位。对于上述区域b那样的特征点不明确的背景物体,可以选择区域内任意的点,将选中的点用作伪特征点。所设定的显示参数被作为ar对象的关联数据登记在拍摄物体数据92或者背景物体数据93中。具体的ar对象的编辑画面表示在图12b中。

[0141]

在s156中,判断能够配置ar对象的拍摄物体或者背景物体是否有剩余,在有剩余的情况下(是)返回s151,在没有剩余的情况下(否)结束处理。

[0142]

接着说明图10b的情况(场景2)。该情况下的顺序是,首先选定ar对象,再对所选定的ar对象分配拍摄物体或者背景物体。

[0143]

在s161中,将要使用的ar对象全部选定。为此,参照内置于hmd1中的数据或者参照外部的服务器。将所选定的ar对象登记在ar对象数据94中。

[0144]

在s162中选择所选定的ar对象之一。

[0145]

在s163中,选择要关联所选中的ar对象的拍摄物体或者背景物体。

[0146]

在s164中,确认选中的物体是否被从其他hmd设定了优先权。为此,参照上述同步与优先权处理83中的优先权的读取结果(图7、s125、s126)。在设定有优先权的情况下(是)进入s167,在没有设定的情况下(否),进入s165。

[0147]

在s165中对选中的物体进行优先权的设定登记。由此,能够优先于其他的hmd对选中的物体进行编辑。

[0148]

在s166中设定显示ar对象时的显示参数(显示上的位置、大小、方向)。所设定的显示参数被作为ar对象的关联数据登记在拍摄物体数据92或者背景物体数据93中。

[0149]

在s167中,判断s161中选定的ar对象是否有剩余,在有剩余的情况下(是)返回s162,在没有剩余的情况下(否)结束处理。

[0150]

图11是显示影像生成处理87的流程图。此处,读取登记在数据闪存rom69中的各种数据,生成ar对象的显示影像,用3d投影仪13进行投影、显示。

[0151]

在s171中,参照拍摄物体数据92和背景物体数据93以及ar对象数据94,选择要显示的ar对象。

[0152]

在s172中,配合hmd1的方向(用户的视线)使ar对象旋转。另外,根据与相关联的拍摄物体(或者背景物体)的距离,使ar对象放大/缩小。

[0153]

在s173中,评价ar对象和与其在视线方向上重叠的现实物体(拍摄物体)之间的距离关系(远近)。到现实物体的距离由测距传感器11测量。

[0154]

在s174中,判断ar对象是否会被现实物体遮挡,即ar对象的前方(更近处)是否存在现实物体。在被遮挡的情况下(是)进入s175,在没有被遮挡的情况下(否)进入s176。

[0155]

在s175中,将ar对象的被遮挡部分或者全部的影像不显示(例如将影像数据改写为0)。

[0156]

在s176中,用3d投影仪13进行ar对象的投影、显示。

[0157]

在s177中,在存在未处理的ar对象的情况下(是),返回s171针对下一ar对象进行处理。在没有未处理的ar对象的情况下(否),进入s178。

[0158]

在s178中,读取拍摄物体中的人物物体的信息。人物物体的信息是在拍摄物体处理84(s137)中发送的信息,被临时存储起来。

[0159]

在s179中,基于人物物体信息,从与人物显示区域一致的背景物体的区域将背景影像剪切出来,将剪切出来的背景影像显示在人物的前面(靠hmd的位置)从而覆盖人物(遮罩(mask)处理)。由此,防止其他mr体验者出现在显示影像中。

[0160]

[优先权和ar对象的设定]

[0161]

接着,说明图10a(图10b)所说明的ar对象处理86中的用户操作画面的例子。

[0162]

图12a表示对拍摄物体设定优先权(s153、s165)的操作画面。此处,将现实物体的沙发7识别为拍摄物体,对该拍摄物体设定优先权。在该设定操作中,首先将光标30置于沙发7上并点击。通过该操作,弹出菜单小画面31。从该菜单小画面31提示的列表之中点击“设定优先权”。所点击的项目转换成黑底白字。该状态为图12a,响应于该点击,出现了优先权的设定画面31a。体验者用光标30选择优先权的“设定”或者“解除”,对沙发7进行所希望的设定。

[0163]

图12b是表示对已关联的ar对象进行编辑(s155、s166)的操作画面。此处表示的是,对与沙发7相关联的桌子对象22改变各种显示参数的设定的情况。将光标30置于桌子对象22上并点击。通过该操作,弹出菜单小画面32,当点击了“编辑ar对象”时出现编辑画面32a。此处,能够进行这样的编辑操作,即,切换“显示/不显示”、改变“显示尺寸”、改变“显示旋转”、改变“显示配置”等。进而,当选择了ar对象的“删除”时,除去所关联的桌子对象22。这时,在桌子对象22与沙发7相关联的情况下,可以解除对沙发7设定的优先权。

[0164]

[数据表]

[0165]

图13a~图13e是表示保存在数据闪存rom69中的各种数据表的例子的图。

[0166]

图13a表示头数据(header data)。位于表的最前头的“内容id”是与后述的拍摄物体、背景物体、ar对象等表共用的id。“内容种类”表示其是头数据。“内容名称”表示其是关于mr体验的数据。“附带内容(accompanying content)”中记载的是hmd1能够处理的数据的一览。此外,还包含有“内容所有者”或“著作权”等信息。

[0167]

图13b表示基准点与移动历史数据91。其中包括共用的“内容id”,在“内容种类”中表示其是基准点与移动历史数据。作为数据记载有“基准点(pbase)”,关于“移动历史记录(mp1、mp2)”记载有时刻(t0、t1、t2)和位置与方向。时刻是mr处理的摄像机拍摄时刻,用协调世界时间(utc=universal time,coordinated)记载。位置和方向以基准点(pbase)为起点,用差异数据表示各个时刻下的mr显示装置1的位置(包含高度)和拍摄方向。例如,时刻t1的移动历史记录(mp1)用位置差(r1,θ1,φ1)=(距离、水平角度、垂直角度)、方向差(θθ1,φφ1)=(水平角度、垂直角度)表示。

[0168]

另外,在本例中作为基准点的值给出的是位置=(0,0,0)、方向=(0,0),但高度以外的位置也可以由gps数据的值给出,方向则由方位角的值给出。

[0169]

图13c表示拍摄物体数据92。拍摄物体数据按照每个拍摄位置区分为基准位置(pbase)、移动位置(mp1,

…

)来记载。拍摄物体数据是经过同步的,记载的是多个hmd的数据的汇总结果。

[0170]

各拍摄位置处识别的拍摄物体按“拍摄物体1”、“拍摄物体2”、

…

的方式分配连续编号,并且记载了识别出的物体名称即“窗户”、“投影仪”、“沙发”等名称。对于各拍摄物体,记载了所提取的“特征点1”、“特征点2

”…

、“关联ar对象”的数据和表示优先权设定状态的优先权标志。

[0171]

各特征点的数据包含相对于hmd1的拍摄位置的相对位置(距离和方向)。“关联ar对象”的数据与后述的ar对象数据94链接,关联了由数据id指定的ar对象(标题)。“关联位置”表示配置ar对象的特征点和偏移距离,“尺寸”和“旋转”是显示ar对象时的参数。

[0172]

在本例中,在拍摄位置为基准位置(pbase)处,记载有拍摄物体1~3,拍摄物体1(窗)关联有关联ar对象1,拍摄物体2(投影仪)关联有关联ar对象2,拍摄物体3(沙发)关联有关联ar对象3。

[0173]

在拍摄位置为移动位置(mp1,

…

)处,也按同样的方式记载拍摄物体。但是,拍摄物体1、2的相对于各特征点的位置、方向的数值,在拍摄位置为基准位置(pbase)与移动位置(mp1)时稍微不同。这是因为,即使拍摄物体1、2在现实空间中不移动,上述数值也会因hmd1的移动而成为不同的值。另外,在移动位置处如果识别到新的拍摄物体,则将其添加到表中。

[0174]

对各拍摄物体赋予了表示优先权设定状态的优先权标志。优先权标志由多位数字(digit)构成,最开头的数字在优先权由该物体的拍摄者(数据提供者)设定的情况下为“1”。其余的数字表示拥有优先权的mr体验者,数字的值与mr体验者的关系在登录时给定。优先权是在某mr体验者将ar对象与拍摄物体关联时,并且不想要其他的mr体验者改变所关联的ar对象时设定的。

[0175]

图13d表示背景物体数据93。背景物体数据按照每个拍摄位置区分,分为基准位置(pbase)、移动位置(mp1,

…

)来记载。背景物体数据也是经过同步的,是多个hmd的背景物体

数据的汇总结果。

[0176]

背景物体数据如果有特征点则记作“特征点1”、“特征点2”、

…

,这些特征点存在包含由体验者指示的伪特征点的情况。接着与拍摄物体的情况同样地记载有“关联ar对象”,在此包含所关联的ar对象的数据id和优先权标志。另外,在背景物体数据中,为了能够掌握其位置、形状,包括与以基准点为中心的虚拟的360

°

摄像机影像的坐标对应的位图数据。

[0177]

并且,在对背景物体进行了区域分割的情况下,具有分割区域数据。在分割区域数据中,具有特征点等区域分割信息和优先权信息,此外还具有能够覆盖分割区域的交叉对象(cross object)的3d图像数据。

[0178]

图13e表示ar对象数据94。ar对象数据例如是从网络上的服务器下载的数据,对每一个ar对象分配了连续编号。各个ar对象数据被赋予了识别用的数据id,利用该数据id与上述的拍摄物体数据、背景物体数据关联。作为项目有标题和著作权的记载,并保存有3d图像数据。使用该3d图像数据生成显示影像。

[0179]

如以上所说明,采用实施例1,将多个体验者佩戴的多个mr显示装置相互连接,通过发送和接收由各装置取得的拍摄物体、背景物体和与它们关联的虚拟物体(ar对象)的数据而能够共享这些数据。其结果是,能够由多个体验者共享同一现实空间,并且各个体验者能够独立地进行在现实空间中配置虚拟物体或者置换虚拟物体等操作。

[0180]

另外,在使虚拟物体与拍摄物体、背景物体关联的处理中,因为设定了优先权来将特定物体的操作权限分配给特定hmd(体验者),因此,例如对于由多个操作者进行的同一空间内的共同作业,能够以分担空间的方式流畅地高效地执行。

[0181]

实施例2

[0182]

实施例2要说明的是,利用多个部件构成ar对象并且按每一个部件设定优先权的情况。

[0183]

[mr空间]

[0184]

图14是表示实施例2的mr空间的例子的图。对于与实施例1的图4a所示的mr空间相同的要素标注相同的附图标记,省略重复说明。与图4a的mr空间的不同点在于,移除了投影仪8,不存在交叉对象26,作为ar对象的tv对象21由3个部件21a、21b、21c构成。此处,21a为平面面板,21b为支柱,21c为底座。3个部件能够分别选择其颜色和形态,并且,每个部件能够由不同的mr体验者设定颜色和形态。

[0185]

图15表示实施例2中的ar对象处理86(追加部分)的流程图。此处,假定已通过实施例1的图10a或者图10b的流程关联了ar对象。所关联的ar对象由多个部件构成,此处是对一部分的部件进行编辑(变更)的情况下的处理。

[0186]

在s201中选择1个ar对象。

[0187]

在s202中,确认与选中的ar对象关联的拍摄物体或者背景物体是否被其他hmd设定了优先权。在设定了优先权的的情况下(是),判断为是优先权涉及整个ar对象的情况,进入s206。在没有设定优先权的情况下(否),进入s203。

[0188]

在s203中,选择要在ar对象中进行变更的部件。

[0189]

在s204中,确认选中的ar对象的部件是否被从其他hmd设定了优先权。在设定了优先权的情况下(是),进入s206。在没有设定优先权的情况下(否),进入s205。

[0190]

在s205中,进行ar对象的部件的编辑(变更),进行优先权的设定并登记到数据表

中。

[0191]

在s206中,判断是否还存在要变更部件的ar对象,在存在的情况下(是)返回s201,在不存在的情况下(否)结束处理。

[0192]

图16a和图16b是实施例2的数据表的例子,图16a表示拍摄物体数据的数据表,图16b表示ar对象数据的数据表。

[0193]

与实施例1相比存在变化的部分是,在图16a中,与拍摄物体2的投影仪相关联的ar对象2由多个部件1~3构成。各个部件记载有数据id的子分类,并且对于各部件赋予了优先权标志来表示不同mr体验者的编辑权限。

[0194]

在图16b的ar对象数据中,在对应的ar对象2的栏中,保存有与部件1~3对应的面板、支柱、底座这3个部件的3d图像数据。

[0195]

如以上所说明,采用实施例2能够具有与实施例1同样的效果,而且,能够由多个部件构成ar对象并对各部件设定不同的优先权。其结果是,能够由多个mr体验者对1个ar对象进行编辑,能够表现出多种组合的mr空间。

[0196]

实施例3

[0197]

实施例3要说明的是,将多个mr显示装置(hmd)连接到网络上,并利用网络上连接的服务器来进行各hmd中的mr处理的结构(下称mr网络系统)。

[0198]

[mr网络系统]

[0199]

图17是表示实施例3的mr网络系统的结构的图。多个mr显示装置(hmd)1a、1b、1c分别被mr体验者2a、2b、2c佩戴,各hmd1a、1b、1c经由无线lan等接入点(ap)5和网关50与网络51相连,能够在体验者间进行数据交换。

[0200]

网络51上连接有应用程序服务器52和数据存储服务器53。应用程序服务器52具有mr处理的应用程序,用于对多个体验者的拍摄影像进行合成,或用于配置ar对象。数据存储服务器53保存ar对象和拍摄物体的数据、所合成的室内的影像数据、配置ar对象时的位置信息等,各体验者能够读取这些数据。

[0201]

因此,在各hmd1a、1b、1c的内部结构中,能够在实施例1的图3所示的功能模块中,将保存在程序闪存rom68中的处理程序81~87、保存在数据闪存rom69中的数据表91~94省略或者简化。

[0202]

[mr网络系统的时序]

[0203]

图18a和图18b是mr网络系统的时序图,表示了各hmd1a、1b、1c(各mr体验者2a、2b、2c)与应用程序服务器52之间的数据收发。

[0204]

图18a是表示整体时序的图。对于与实施例1的图5等同的处理标注相同的附图标记,整个时序由从s101的登录处理至s109的显示影像生成处理构成。本时序虽然也使用了请求和响应这一对基本的通信时序,但为了避免复杂,在此省略了它们的记载。以下,按照处理顺序说明概要。

[0205]

s101:mr体验者2a~2c登录到应用程序服务器52参加mr体验。

[0206]

s102:mr体验者2a~2c对现实空间的一部分进行摄像机拍摄,将拍摄影像数据发送到应用程序服务器52。

[0207]

s103:mr体验者2a~2c进一步将位置和方向的数据作为基准点与移动历史数据发送到应用程序服务器52。

[0208]

s104:应用程序服务器52汇总所有mr体验者的数据,合成影像,并进行同步。

[0209]

s105:应用程序服务器52生成mr体验者各自的显示影像,并进行发送(s105)。

[0210]

s106:应用程序服务器52进行拍摄物体的处理。

[0211]

s107:应用程序服务器52进行背景物体的处理。这时,从mr体验者接受区域分割和交叉对象的指示。

[0212]

s108:应用程序服务器52进行ar对象的处理。这时,接受由mr体验者选择的拍摄物体、背景物体的指定,以及为了关联而选择的ar对象的数据。

[0213]

s109:应用程序服务器52反映上述的执行结果生成显示影像,向mr体验者发送。将应用执行时产生的数据保存在数据存储服务器53中。

[0214]

在以上的时序中,除了s101的登录以外,将一系列的时序作为基本时序反复执行,由此,mr体验者2a~2c能够经由应用程序服务器52实现mr体验。

[0215]

图18b是表示图18a的时序的细节的图。在此为了避免记载的复杂化,在基本时序的处理中,仅表示了同步与优先权处理(s104)和ar对象处理(s18)的重复执行。其他的显示影像生成处理(s105)、拍摄物体处理(s106)、背景物体处理(s107)虽然省略,但能够适当执行,另外也能够适应地将发往数据存储服务器53的数据和显示影像等保存起来。以下,依次说明hmd1a~1c(mr体验者2a~2c)与应用程序服务器52之间的通信内容。

[0216]

t11:从hmd1a~1c将各自的拍摄影像和hmd的位置、拍摄方向发送到应用程序服务器52。关于发送时机,可以按照来自应用程序服务器52的发送请求而进行发送,也可以由应用程序服务器52在合适的时刻从连续地发送来的拍摄影像中进行捕捉。

[0217]

t12:应用程序服务器52进行同步与优先权处理s104a,例如将随着hmd的移动而对应地更新了显示位置的ar对象等的显示影像分别发送到hmd1a~1c。

[0218]

t13:此时,当拥有拍摄物体a的优先权的hmd1a(mr体验者2a)想要将ar对象α关联到拍摄物体a上时,将拍摄物体a的选择信息和要关联的ar对象α的选择信息发送到应用程序服务器52。

[0219]

t14:应用程序服务器52执行ar对象处理s108a,将基于该ar对象α的设定信息而得到的ar对象α的显示影像,发送到hmd1a和其他的hmd1b、1c。

[0220]

t15:从hmd1a~1c将新的拍摄影像和hmd的位置、拍摄方向发送到应用程序服务器52。

[0221]

t16:应用程序服务器52进行同步与优先权处理s104b,将包含ar对象α的配置在内的显示影像分别发送到hmd1a~1c。

[0222]

t17:之后,当不拥有拍摄物体a的优先权的hmd1b(mr体验者2b)想要将不同的ar对象β关联到拍摄物体a上时,将拍摄物体a上赋予的优先权的解除请求发送到hmd1a、1c和应用程序服务器52。若拥有优先权的hmd1a(mr体验者2a)接受了来自hmd1b的优先权的解除请求,则优先权被解除,并对hmd1b赋予优先权。

[0223]

t18:hmd1b将要关联到拍摄物体a上的ar对象β的选择信息发送到应用程序服务器52。

[0224]

t19:应用程序服务器52执行ar对象处理s108b,将基于ar对象β的设定信息而得到的ar对象的显示影像发送到hmd1a~1c。

[0225]

t20:从hmd1a~1c向应用程序服务器52发送新的拍摄影像和hmd的位置、拍摄方

向。

[0226]

t21:应用程序服务器52进行同步与优先权处理s104c,将包含ar对象β的配置在内的显示影像分别发送到hmd1a~1c。

[0227]

t22:这时,假定hmd1c(mr体验者2c)选择了不同的拍摄物体c,发送了要选择ar对象γ的请求,并且该请求得到允许。hmd1c发送要关联的ar对象γ的选择信息。

[0228]

t23:应用程序服务器52执行ar对象处理s108c,并将基于ar对象γ的设定信息而得到的ar对象的显示影像发送到hmd1a~1c。

[0229]

其结果是,hmd1a~1c(mr体验者2a~2c)能够共享位于同一个现实空间中的拍摄物体,在现实空间中添加作为虚拟物体的ar对象,并且该添加的ar对象的影像能够作为按照各自的位置而相应生成的显示影像被体验者观察到。

[0230]

如以上所说明,采用实施例3的mr网络系统能够具有与实施例1同样的效果,并且还具有能够充分利用网络上的应用程序服务器、数据服务器等的资源这一特征。由此具有这样的效果,即,能够降低mr显示装置的负荷,对mr显示装置的小型化、低成本化带来贡献,并且即使在mr体验者的人数增多的情况下也能够容易应对。

[0231]

实施例4

[0232]

实施例4要说明的是一种搭载了3d摄像机来进行拍摄和距离测量的mr显示装置。

[0233]

[mr显示装置]

[0234]

图19是表示实施例4的mr显示装置1’的外观结构的图。对于与实施例1(图2)所示的mr显示装置1具有等同功能的构成要素,标注相同的附图标记,省略重复的说明。

[0235]

mr显示装置1’包括3d(3维)摄像机40a、40b和平面显示器41。3d摄像机40a、40b用于替换实施例1的摄像机10和测距传感器11,不仅能够获得摄像机拍摄影像,还能够利用由40a获得的左眼视线的影像与由40b获得的右眼视线的影像之差,来对摄像机影像内的现实物体进行距离测量。

[0236]

平面显示器41用于替换实施例1中的3d投影仪13和透射式屏幕14,通过控制器16将3d摄像机40a、40b的拍摄影像和ar对象的影像合成来显示。这时,将左眼视线的影像与右眼视线的影像交替地显示,并且与带快门的眼镜15同步来进行3d影像的显示。平面显示器41也可以使用智能手机等通用设备。这时,能够通过智能手机内置的控制装置执行控制器16的功能。

[0237]

图20是表示mr显示装置1’的功能结构的框图。对于与实施例1(图3)所示的模块具有等同功能的模块,标注相同的标记省略重复的说明。与实施例1不同的模块是3d摄像机40a、40b、平面显示器41、影像合成处理部42和控制器16内的特征提取处理部61’、距离计算处理部62’。

[0238]

特征提取处理部61’从3d摄像机40a、40b的影像中提取特征点,根据该特征点识别出现在摄像机拍摄影像中的现实物体。距离计算部62’根据3d摄像机40a、40b获得的左眼/右眼视线的影像之差,来测量摄像机影像内的现实物体的距离。合成处理部42将3d摄像机40a、40b的拍摄影像与ar对象的影像合成,平面显示器41显示所合成的影像。

[0239]

采用实施例4能够具有与实施例1同样的效果,并具有能够充分利用包括平面显示器在内的智能手机等通用设备这一特征。

[0240]

上面说明了本发明的各实施例,但本发明并不限定于此,能够将某实施例的结构

的一部分置换为其他的实施例的结构,或者追加其他的实施例的结构。

[0241]

附图标记说明

[0242]

1(1a~1c)、1’:混合现实显示装置(mr显示装置、hmd)、2a~2c:mr体验者、3a~3c:摄像机拍摄视角、4:现实物体(背景物体)、5:接入点(ap)、6~8:现实物体(拍摄物体)、10:摄像机、11:测距传感器、12:位置方位传感器、13:3d投影仪、14:透射式屏幕、15:带快门的眼镜、16:控制器、17a、17b:扬声器、18a、18b:保持具、19:麦克风、21~26:ar对象(虚拟物体)、40a、40b:3d摄像机、41:平面显示器、50:网关、51:网络、52:应用程序服务器、53:数据存储服务器、60:用户操作输入部、61、61’:特征检测处理部、62、62’:距离计算处理部、63:移动检测处理部、64:通信部、65:cpu、66:ram、67:图形ram、68:程序闪存rom、69:数据闪存rom、81:整体控制处理、82:基准点与移动历史处理、83:同步与优先权处理、84:拍摄物体处理、85:背景物体处理、86:ar对象处理、87:显示影像生成处理。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1