绝热演化路径的预测方法、装置、设备及存储介质与流程

1.本申请实施例涉及人工智能的机器学习领域,特别涉及一种绝热演化路径的预测方法、装置、设备及存储介质。

背景技术:

2.绝热量子计算是实现量子计算机的一种理论模型。绝热量子计算是把一个计算问题转换成一个物理过程,其原本问题的答案会映射到一个目标哈密顿量的基态。

3.绝热量子计算的计算过程是从易制备基态的初始哈密顿量(h0)出发,绝热演化到目标哈密顿量(h1),该演化过程也称为绝热演化路径。如果整个绝热演化过程的时间t足够长(演化足够缓慢),则量子计算机所制备的量子态会一直保持在瞬时哈密顿量的基态。相关技术中,采用增强学习中的q-learning寻找最优的绝热演化路径。

4.当绝热演化路径中的一个系统状态演化到下一个系统状态的可选行为(action)变多时,q-learning的效率会很差,收敛性也容易不稳定。

技术实现要素:

5.本申请实施例提供了一种绝热演化路径的预测方法、装置、设备及存储介质,能够提升预测最优的绝热演化路径时的效率和收敛性。所述技术方案如下:

6.根据本申请的一个方面,本申请提供了一种绝热演化路径的预测方法,所述方法包括:

7.获取量子计算问题的目标哈密顿量h1;

8.根据所述目标哈密顿量h1,确定初始哈密顿量h0和目标基态能量e1;

9.将搜索所述初始哈密顿量h0至所述目标基态能量e1的绝热演化路径转化为棋盘博弈;

10.采用结合神经网络的蒙特卡洛树搜索,求解出所述棋盘博弈的最优棋盘路径;

11.根据所述最优棋盘路径得到所述绝热演化路径。

12.根据本申请的一个方面,本申请提供了一种绝热演化路径的预测装置,所述装置包括:

13.获取模块,用于获取量子计算问题的目标哈密顿量h1;

14.确定模块,用于根据所述目标哈密顿量h1,确定初始哈密顿量h0和目标基态能量e1;

15.转换模块,用于将搜索所述初始哈密顿量h0至所述目标基态能量e1的绝热演化路径转化为棋盘博弈;

16.树搜索模块,用于采用结合神经网络的蒙特卡洛树搜索,求解出所述棋盘博弈的最优棋盘路径;

17.输出模块,用于根据所述最优棋盘路径得到所述绝热演化路径。

18.根据本申请的另一方面,本申请实施例提供了一种计算机设备,所述计算机设备

包括处理器和存储器,所述存储器中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由所述处理器加载并执行以实现上述绝热演化路径的预测方法。

19.根据本申请的另一方面,本申请实施例提供了一种量子计算机,所述量子计算机采用如上所述的方法所预测的绝热演化路径进行绝热演化。

20.根据本申请的另一方面,本申请实施例提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由处理器加载并执行以实现如上述绝热演化路径的预测方法。

21.根据本申请的另一方面,本申请实施例提供了一种计算机程序产品,所述计算机程序产品被处理器执行时,用于实现上述绝热演化路径的预测方法。

22.本申请实施例提供的技术方案至少包括如下有益效果:

23.通过先将绝热演化路径的搜索问题转换为棋盘博弈,采用结合神经网络的蒙特卡洛树搜索求解出棋盘博弈的最优棋盘路径,根据最优棋盘路径能够反推出最优的绝热演化路径,从而在绝热演化路径中的每个状态的候选行为较多时,仍然能够快速和高效地求解出稳定收敛的绝热演化路径,提高绝热量子计算系统的绝热演化效率,缩短制备目标基态的时间。

附图说明

24.为了更清楚地说明本申请实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本申请的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

25.图1是本申请一个实施例提供的计算系统的框图;

26.图2是本申请一个实施例提供的绝热演化路径的预测方法的流程图;

27.图3是本申请一个实施例提供的将绝热演化路径转换为棋盘博弈的流程图;

28.图4是本申请一个实施例提供的棋盘博弈的棋盘示意图;

29.图5是本申请另一个实施例提供的绝热演化路径的预测方法的流程图;

30.图6是本申请一个实施例提供的棋盘博弈对应的博弈树的示意图;

31.图7是本申请一个实施例提供的蒙特卡洛树搜索的四个阶段的示意图;

32.图8是本申请一个实施例提供的蒙特卡洛树搜索和神经网络的原理示意图;

33.图9是本申请一个实施例提供的绝热演化路径的预测方法的流程图;

34.图10是本申请一个实施例提供的蒙特卡洛树搜索在搜索过程中的流程图;

35.图11是本申请一个实施例提供的神经网络在训练时的原理示意图;

36.图12是本申请一个实施例提供的绝热演化路径的预测方法的流程图;

37.图13至图17是本申请预测的绝热演化路径与传统的绝热演化路径的效果对比图;

38.图18是本申请一个实施例提供的绝热演化路径的预测装置的框图;

39.图19是本申请一个实施例提供的计算机设备的结构示意图。

具体实施方式

40.为使本申请的目的、技术方案和优点更加清楚,下面将结合附图对本申请实施方式作进一步地详细描述。

41.首先对本申请的若干个名词进行简介:

42.1、量子计算:基于量子逻辑进行计算的计算方式,存储数据的基本单位是qubit,量子比特。

43.2、量子比特(qubit):量子计算的基本单元。传统计算机使用0和1作为二进制的基本单元。不同的是,量子计算可以同时计算0和1,量子系统(简称系统)可以处于0和1的线性叠加态:|ψ>=α|0>+β|1>,这边α,β代表系统在0和1上的概率幅,是一个复数。它们的模平方|α|2,|β|2代表处于0和1的概率。在一个示例中,|α|2+|β|2=1

44.3、哈密顿量:描述量子系统的总能量的一个厄密共轭的矩阵h。

45.4、本征态:对于一个哈密顿量矩阵h,满足方程:h|ψ>=e|ψ>的解称之h的本征态|ψ>,具有能量本征值e。

46.5、基态:能量最低的本征态。

47.6、可分态,纠缠态:对一个由a和b两部分所组成的量子体系,其量子态如果|ψ>可以被分解成一个张量积,则称之为可分态,不然,称之为纠缠态。

48.7、绝热量子计算:实现量子计算机的一种理论模型,把一个计算问题转换成一个物理过程,其原本问题的答案会映射到一个目标哈密顿量的基态。绝热量子计算的计算过程是从易制备基态的初始哈密顿量(h0)出发绝热演化到目标哈密顿量(h1)。如果整个绝热演化过程时间t足够长(演化足够缓慢),量子计算机所制备的量子态会一直保持在瞬时哈密顿量的基态。经典的绝热量子计算过程中的哈密顿量,可以写成初始哈密顿量和目标哈密顿量随时间变化的组合形式:

49.h(s(t))=(1-s(t))h0+s(t)h1。

50.绝热演化(schedule)函数定义:s(t):[0,t]

→

[0,1]。

[0051]

8、保真度:两个量子纯态,|ψ>,|φ>定义为这个向量的内积的模平方

--

|<ψ|φ>|2。

[0052]

9、最优的绝热路径:对于固定的t,最优的绝热路径为下面优化问题的解:

[0053][0054]

受限于

[0055]

这边|g0>代表h0的基态。

[0056]

10、量子退火:绝热演化是一个比较理想的量子计算理论模型。由于现实中的量子硬件会被噪声干扰或者是绝热演化时间t不够长,使得量子计算机做制备的量子态并不能像理论中的绝热演化一样一直保持在瞬时哈密顿量的基态。这样的计算模式就是量子退火。

[0057]

11、增强学习:机器学习的一个分支,ai算法透过与一个环境的交互过程得到:如何完成一个任务反馈,从中学会如何高效的完成任务。

[0058]

12、决策策略π:在增强学习框架下,一个特定的神经网络。给定一个系统的状态为输入,策略网络输出需要执行的动作。

[0059]

本申请提供了一种使用“蒙特卡洛树搜索搭配神经网络”的增强学习框架来自动设计最优的绝热演化路径,助力量子退火和绝热量子计算高效的解决量子计算问题。这里的“高效”指的是:(1)提高量子态相对于目标哈密顿量的基态的保真度;(2)降低量子计算给出的能量。

[0060]

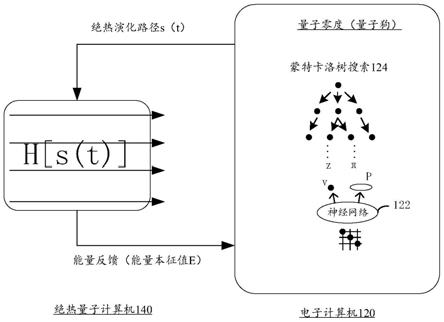

图1示出了本申请一个示例性实施例示出的计算系统100的架构示意图。该计算系统100包括:电子计算机120和量子计算机140。

[0061]

电子计算机120中运行有结合神经网络122的蒙特卡洛树搜索(monte carlo tree search,mcts)124。示例性的,本申请将结合有神经网络122和蒙特卡洛树搜索124的增强学习框架可称为“量子零度”(简称量子狗)。该蒙特卡洛树搜索124用于在神经网络122的引导下预测最优的绝热演化路径s(t)。

[0062]

电子计算机120和量子计算机140相连。

[0063]

量子计算机140用于运行蒙特卡洛树搜索124输出的预测绝热演化路径s(t),并输出根据预测绝热演化路径s(t)演化至末态的能量本征值e,将该能量本征值e提供给电子计算机120。

[0064]

假设胜利条件是:能量本征值e小于或等于目标基态能量e1,则:

[0065]

当该能量本征值e未达到胜利条件时,电子计算机120根据能量本征值e对神经网络122中的参数进行更新,也即强化学习。电子计算机120得到强化学习后的神经网络,再次使用强化学习后的神经网络引导蒙特卡洛树搜索124预测最优的绝热演化路径s(t)。

[0066]

当该能量本征值e达到胜利条件时,将该预测绝热演化路径s(t)输出为最优的绝热演化路径。

[0067]

图2示出了本申请一个示例性实施例示出的绝热演化路径的预测方法的框图。本实施例以该方法应用于图1所示的电子计算机120中执行来举例说明。

[0068]

该方法包括:

[0069]

步骤201,获取量子计算问题的目标哈密顿量h1;

[0070]

针对一个量子计算问题,计算过程是从易制备基态的初始哈密顿量h0出发绝热演化到目标哈密顿量h1。如果整个绝热演化过程的时间t足够长(也即演化足够缓慢),量子计算机所制备的量子态会一直保持在瞬时哈密顿量的基态。

[0071]

可选地,量子计算问题包括如下问题中的至少一种:a:待模拟的化学分子体系,b:待求解基态的量子多体物理模型,c:转化为量子物理问题的组合优化问题,比如3at、maxcut,maxqp等。

[0072]

绝热量子计算过程中的哈密顿量,可表达成初始哈密顿量h0和目标哈密顿量h1随时间变化的组合形式:

[0073]

h(s(t))=(1-s(t))h0+s(t)h1

[0074]

其中,h0是初始哈密顿量,h1是目标哈密顿量。s(t)是绝热演化(schedule)函数,定义为:s(t):[0,t]

→

[0,1]。t是预设的绝热演化时长,t为时间。

[0075]

步骤202,根据目标哈密顿量h1,确定初始哈密顿量h0和目标基态能量e1;

[0076]

初始哈密顿量h0是易于制备的哈密顿量。目标基态能量e1是期望的能量阈值。目

标基态能量e1是初始哈密顿量h0绝热演化至末态时的期望能量的量子态(可理解为能量最低的量子态)。

[0077]

根据量子计算问题的目标哈密顿量h1,可以设定初始哈密顿量h0和目标基态能量e1。比如,由工作人员设定初始哈密顿量h0和目标基态能量e1;或,按照程序设定初始哈密顿量h0和目标基态能量e1。

[0078]

步骤203,将搜索初始哈密顿量h0至目标基态能量e1的绝热演化路径转化为棋盘博弈;

[0079]

绝热演化路径(简称绝热路径)是从初始哈密顿量h0至目标基态能量e1的演化路径。绝热演化路径的搜索问题可以从数学维度模拟为一个棋盘博弈,也即棋盘游戏。该转换过程至少包括如下步骤,如图3所示:

[0080]

203a,将初始哈密顿量h0至目标吉态能量e1的绝热演化路径表达为绝热演化函数s(t);

[0081]

其中,绝热演化函数s(t):[0,t]

→

[0,1]。

[0082]

203b,采用傅里叶变换将绝热演化函数s(t)变换为频域的状态向量序列状态向量序列包括m个向量维度,每个向量维度的取值范围为2l;

[0083]

采用傅里叶变换,将绝热演化函数s(t)表示在频域内,如下公式2:

[0084][0085]

其中,t为时间,t为预设的绝热演化时长,b

i

为状态向量,i为不大于m的整数。使得绝热演化路径的搜索问题,转换为寻找状态向量序列(b1,b2,

…

,b

m

)使得绝热演化得到的末态|ψ(t)〉的能量尽可能的低。也即,需要寻找最优的状态向量序列每一个b

i

值都被预设在一定范围内的分立值,b

j

∈[-l,-l+δ,

…

,l-δ,l]。

[0086]

其中,δ为离散化步长,-l和l是b

i

的取值下限和上限。

[0087]

203c,根据向量维度的维数m和每个向量维度的取值范围2l,转换得到棋盘博弈。

[0088]

如图4所示的示例性棋盘,转换得到的棋盘博弈包括2l/

△

行和m列,每一列对应一个棋子的落子位置,

△

为离散化步长。也即,从棋盘左侧向棋盘右侧依次落子,每一列中刚好落下一个棋子(不多不少),每一列中棋子的候选落子位置为2l/

△

个。m个棋子均下完的棋盘布局,直接对应到一个明确的状态向量序列

[0089]

步骤204,采用结合神经网络的蒙特卡洛树搜索,求解出棋盘博弈的最优棋盘路径;

[0090]

棋盘博弈的博弈过程在数学上可以表示为博弈树。在本实施例中,博弈树包括m层节点,每个节点的下层节点为2l/

△

个,第i层节点对应第i列棋盘中的棋子落下位置。设博弈树中最上层的节点为根节点,则最下层的节点为叶节点(或叶子节点)。最优棋盘路径是博弈树上的一条从根节点到叶节点之间的路径。

[0091]

蒙特卡洛树搜索是一种人工智能问题中做出最优决策的方法,一般是在组合博弈中的行为(move)规划形式。它结合了随机模拟的一般性和树搜索的准确性,在博弈树中具

有较好的应用,比如围棋问题中的阿尔法狗(alphazero)也采用该种计算架构。示例性的,蒙特卡洛树搜索包括如下四个阶段:1、选择(selection);2、扩展(expansion);3、模拟(simulation);4、回溯(backpropagation)。4个阶段会执行多次。

[0092]

结合有神经网络的蒙特卡洛树搜索的强化学习框架,是采用神经网络辅助蒙特卡洛树搜索的一种机器学习架构。示意性的,神经网络辅助蒙特卡洛树搜索中的选择阶段和模拟阶段。该神经网络可以是卷积神经网络,比如采用residual架构的残差网络resnet。

[0093]

在一个示例中,神经网络包括策略网络和价值网络。策略网络用于辅助蒙特卡洛树搜索中的选择节点,从而有效减少搜索时的搜索空间;价值网络用于辅助蒙特卡洛树搜索中的模拟阶段,从而提升模拟阶段的准确性和速度。

[0094]

采用结合神经网络的蒙特卡洛树搜索,能够快速求解出棋盘博弈的最优棋盘路径。

[0095]

步骤205,根据最优棋盘路径得到绝热演化路径。

[0096]

棋盘博弈中的最优棋盘路径对应最优的状态向量序列根据最优的状态向量序列能够得到最优的绝热演化路径s(t)。

[0097]

综上所述,本实施例提供的方法,先将绝热演化路径的搜索问题转换为棋盘博弈,采用结合神经网络的蒙特卡洛树搜索求解出棋盘博弈的最优棋盘路径,根据最优棋盘路径能够反推出最优的绝热演化路径,从而在绝热演化路径中的每个状态的候选行为较多时,仍然能够快速和高效地求解出稳定收敛的绝热演化路径,提高绝热量子计算系统的绝热演化效率,缩短制备目标基态的时间。

[0098]

强化学习(reinforcement learning)是机器学习里面的一个分支。简单来讲,强化学习就是学习如何根据一个环境状态去决定如何行为,使得最后的奖励最大。在本申请中,结合有神经网络的蒙特卡洛树搜索能够预测出绝热演化路径,将该绝热演化路径输入至量子计算机(也即环境)中实际运行,能够得到量子计算机在演化至末态时的能量本征值e,将能量本征值e作为奖励来对神经网络进行强化学习。透过反复多次的尝试,最终蒙特卡洛树搜索会总结出在该棋盘博弈中的最佳落子局面,也即意味着找到了最优的绝热演化路径。

[0099]

在基于图2的可选实施例中,步骤204至少包括如下步骤,如图5所示:

[0100]

步骤204a,采用结合神经网络的蒙特卡洛树搜索,搜索出棋盘博弈的预测棋盘路径;

[0101]

在已知神经网络中的参数θ下,采用结合有神经网络的蒙特卡洛树搜索对棋盘博弈对应的博弈树进行搜索,得到棋盘博弈的预测棋盘路径。也即当前预测能力下的最优棋盘路径。

[0102]

步骤204b,根据预测棋盘路径得到预测绝热演化路径;

[0103]

电子计算机将预测棋盘路径映射为状态向量序列根据状态向量序列得到预测绝热演化路径s(t)。

[0104]

步骤204c,根据量子计算环境计算得到预测绝热演化路径在演化至末态时的能量本征值e;

[0105]

电子计算机将预测绝热演化路径s(t)传输给量子计算机,由量子计算机根据该预测绝热演化路径s(t)执行绝热演化至末态,测量演化至末态后的量子态和对应的能量本征值e。

[0106]

作为一种替代实现,电子计算机在固定的绝热演化时长t下,根据预测绝热演化路径s(t)求解量子薛定谔方程,根据求解结果得到演化至末态后的量子态和对应的能量本征值e。

[0107]

步骤204d,判断能量本征值e是否大于目标基态能量e1;

[0108]

在一个示例中,胜利条件是能量本征值e与目标基态能量e1之间的差值小于阈值。当阈值为0时,设能量本征值e小于或等于目标基态能量e1为胜利条件。本实施例中,以能量本征值e小于或等于目标基态能量e1为胜利条件来举例说明。

[0109]

响应于能量本征值e大于目标基态能量e1,判定结果为未满足胜利条件,执行步骤204e;响应于能量本征值e小于或等于目标基态能量e1,判定结果为满足胜利条件,执行步骤204f。

[0110]

步骤204e,根据本次预测过程对神经网络中的参数进行更新,并在更新后再次执行步骤204a;

[0111]

当能量本征值e大于目标基态能量e1时,表示尚未寻找到最优的绝热演化路径,根据本次预测过程确定未获得胜利的奖励值z=-1,根据奖励值z=-1(以及蒙特卡洛树搜索在本次输出的预测棋盘路径b和行为策略概率π)对神经网络中的参数θ进行更新,得到具有更好性能的参数。在更新神经网络的参数θ后,重新执行步骤204a至步骤204d。

[0112]

步骤204f,将预测棋盘路径确定为棋盘博弈的最优棋盘路径。

[0113]

当能量本征值e小于或等于目标基态能量e1时,表示寻找到最优的绝热演化路径,电子计算机将蒙特卡洛树搜索在本次输出的预测棋盘路径确定为棋盘博弈的最优棋盘路径。

[0114]

需要说明的是,本申请中的“最优棋盘路径”并不一定是理论最优的棋盘路径,而是指在满足胜利条件时的相对最优的棋盘路径。也即本申请中的“最优”并不应当理解为狭义的理论极限值。

[0115]

综上所述,本实施例提供的方法,通过ai算法(蒙特卡洛树搜索+神经网络)在当前能力下预测出最优的预测棋盘路径后,采用量子计算环境所反馈的能量本征值e作为奖励,在能量本征值e不满足胜利条件时,根据奖励对神经网络中的参数进行更新,得到更优的神经网络。经过多次训练或更新过程后,使得ai算法能够输出满足胜利条件的最优棋盘路径。

[0116]

为了便于理解“蒙特卡洛树搜索+神经网络”的运作过程,下文按照如下流程进行讲解:

[0117]

1、博弈树;

[0118]

2、蒙特卡洛模拟;

[0119]

3、基本的蒙特卡洛树搜索;

[0120]

4、结合神经网络的蒙特卡洛树搜索。

[0121]

1、博弈树;

[0122]

博弈树是一种树形式的数据结构,其中每一个节点表征博弈的确定状态。从一个节点向其子节点的转换被称为一个行为(action)。节点的子节点数目被称为分支因子

(branchingfactor)。博弈树的根节点表征博弈的初始状态。博弈树的叶子节点(简称叶节点)为没有子节点的节点,表示博弈无法再继续进行。叶节点的状态可以被评估,并总结本轮博弈的结果(赢或输)。

[0123]

结合图4可知,本申请中的棋盘博弈所对应的博弈树包括m+1层节点,根节点为第0层节点,第i层节点对应第i个状态b

i

的落子位置,每一层节点的分支因子为2l/

△

,也即博弈树的层数等于棋盘的列数m+1,每层节点的分支个数等于棋盘的行数。图6示意性的示出了m为5,2l/

△

2=5的博弈树例子。在初始状态下,根节点对应棋盘上为空的棋盘局面;第1层节点中从左到右的5个节点,对应棋盘中第1列从上到下的5个候选落子位置,当b1状态下在第5个候选落子位置后,展开第2层节点;第2层节点中从左到右的5个节点,对应棋盘中第2列从上到下的5个候选落子位置,当b2状态下在第2个候选落子位置后,展开第3层节点;第3层节点中从左到右的5个节点,对应棋盘中第3列从上到下的5个候选落子位置,当b3状态下在第5个候选落子位置后,展开第4层节点;第4层节点中从左到右的5个节点,对应棋盘中第4列从上到下的5个候选落子位置,当b4状态下在第5个候选落子位置后,展开第5层节点;第5层节点中从左到右的5个节点,对应棋盘中第5列从上到下的5个候选落子位置,当b5状态下在第3个候选落子位置后,结束本次博弈。

[0124]

从根节点到第5层中的第3个叶子节点的树遍历(路径)表征了单个博弈过程。在单个博弈完毕后,对第5层中的第3个节点可以进行评估,评估本次博弈是否满足了胜利条件。

[0125]

2、蒙特卡洛模拟(monte carlo simulations);

[0126]

蒙特卡洛模拟是以概率统计理论为指导的模拟方法。蒙特卡洛模拟得名于摩纳哥的赌城。以一个简单的图形学问题来说明蒙特卡洛模拟的思想:假设要求地面上的一个不规则图形的面积,则在地面上包含该不规则图形的矩形中随机投下一个小球,每次投球均将投球计数n加一,若小球落在了不规则图形中,则将成功计数w加一。在多次投球后,认为不规则图形的面积等于w/n。

[0127]

也即,在不知道不规则图形的面积求和方式下,采用概率统计学中的概率预测出了不规则图形的面积。

[0128]

需要说明的是,蒙特卡洛模拟和蒙特卡洛树搜索是不同的两个过程,只是思想上有类似。

[0129]

3、基本的蒙特卡洛树搜索;

[0130]

回到蒙特卡洛树搜索,蒙特卡洛树搜索的主要概念是搜索,即沿着博弈树向下的一组遍历过程。单次遍历的路径会从根节点(初始博弈状态或当前博弈状态)延伸到没有完全展开的节点,直至本次博弈结束。在蒙特卡洛树中的每个节点代表一个棋盘局面,节点上的属性“w/n”代表这个节点被访问了n次,胜利了w次。例如一开始的根节点是12/21,则代表总共模拟了21次,胜利了12次。其中,w可认为是总模拟奖励,n可以认为是总访问次数。

[0131]

基本的蒙特卡洛树搜索包括四个步骤,如图7所示:

[0132]

1)选择;

[0133]

从根节点往下,每次都选一个“最值得看的子节点”,直到来到一个“存在未扩展子节点”的节点b

i

。什么叫做“存在未扩展的子节点”,其实就是指这个棋盘局面存在未走过的落子着法。如何选择一个“最值得看的子节点”,在下文中描述。

[0134]

2)扩展;

[0135]

对节点b

i

增加一个属性为“0/0”的子节点(位于b

i+1

层),对应上一步骤中“未扩展的子节点”,就是还没有试过的一个着法。

[0136]

3)模拟;

[0137]

从上一步骤中新增的子节点开始,用随机走子策略走到最后一步,得到一个胜负结果。按照普遍的观点,随机走子策略是一个棋力很弱但走子很快的策略。

[0138]

4)回溯。

[0139]

把模拟结果(胜利或失败)加到新增的子节点的所有父节点上。也即所有的父节点中的n+1,若模拟结果为胜利,则所有的父节点中的w+1。

[0140]

在模拟很多次后,选择各层节点中具有最大模拟奖励(或最大访问次数)的节点所形成的路径,作为最优棋盘路径。

[0141]

4、结合神经网络的蒙特卡洛树搜索。

[0142]

根据图6和图7可知,若博弈树的深度(层数)和广度(每层节点数)较小,通过穷举每个分支的形式,博弈树能够求出较为准确的最优棋盘路径。但如果博弈树的深度和广度较大,则上述计算过程中的搜索空间是非常庞大的,难以计算。

[0143]

本申请实施例中采用神经网络来缩小博弈树的搜索空间的深度和广度。主要包括:

[0144]

1)提供策略网络p,对于当前节点b

i

,能够预测出下一步落子过程中最有可能的几个候选落子位置a

i+1

,以及每个候选落子位置a

i+1

的落子概率p(a

i+1

,b

i

)。

[0145]

这样,对于当前节点b

i

,蒙特卡洛树搜索不需要搜索所有的下一层子节点,只需要搜索下一层中最有可能的几个子节点即可,从广度上缩小了博弈树的搜索空间。

[0146]

但为了走出神经网络未能预测出的招数,蒙特卡洛树搜索在选择过程中并不仅仅依赖于策略网络p预测出的落子概率p(也称策略向量p)来进行预测,同时还结合了候选落子位置的历史被访问次数来进行综合选择。即蒙特卡洛树搜索优先选择下一层子节点中同时具有“落子概率高+历史被访问次数低”的子节点作为目标子节点。

[0147]

2)提供价值网络v,能够预测出候选落子位置a

i+1

对应的子节点b

i+1

的博弈结果为胜利的概率v。

[0148]

这样,对于未扩展的子节点bi+1不需要进行随机走子策略走到最后一步的模拟,直接由价值网络v预测出博弈结果v,从深度上缩小了博弈树的搜索空间。

[0149]

根据神经网络中策略网络p和价值网络v的指导,蒙特卡洛树搜索能够快速地搜索出博弈树的最优棋盘路径。

[0150]

在如图8所示的例子中,神经网络包括:特征提取网络,策略网络p和价值网络v。在预测过程中,将当前的棋盘局面b(前i个b

i

)输入特征提取网络进行特征提取,将提取到的特征提供给策略网络p和价值网络v进行预测。策略网络p用于预测出下一手棋子的候选落子位置以及落子概率(简称策略向量p),价值网络v用于预测出下一手棋子对应的整个棋盘局面的价值收益v(获胜可能性)。蒙特卡洛树搜索根据策略网络p和价值网络v的指导,在缩小的搜索空间内快速寻找出当前预测能力下的最优棋盘路径,输出为预测棋盘路径。可选地,该预测棋盘路径是每个状态下具有最高的行为概率分布π的行为所得到的。

[0151]

量子计算环境(比如真实的绝热量子计算机)会根据该预测棋盘路径进行绝热演化,并得到演化至末态的能量本征值e。若能量本征值e不符合胜利条件,则该预测棋盘路径

对应的奖励值z=-1,采用(b,π,z)对神经网络的参数θ进行更新。其中,b是本次预测的预测棋盘路径,π是蒙特卡洛树搜索输出的行为概率分布,z是未取得胜利时的奖励值。训练目标是最大化策略向量p和行为概率分布π之间的相似性,且最小化价值收益v和未取得胜利的奖励值z之间的误差。

[0152]

图9示出了本申请一个示例性实施例示出的绝热演化路径的演化方法的流程图。该方法包括:

[0153]

步骤204a-1,在棋盘博弈对应的博弈树中,采用蒙特卡洛树搜索进行搜索,输出每层节点的行为概率分布π;每层节点的行为概率分布π代表下一手棋子的候选落子位置以及概率分布;

[0154]

在本申请中,棋盘博弈对应的博弈树有m+1层节点。从根节点(或某一层节点中的目标节点)开始,采用蒙特卡洛树搜索进行搜索。示例性的,本步骤包括如下子步骤:

[0155]

s1、在棋盘博弈的第i层目标节点b

i

下,使用策略网络输出第i+1层节点b

i+1

的候选落子位置a

i+1

以及落子概率p

i+1

;

[0156]

第i层目标节点b

i

对应第i层节点的目标落子位置,i为不大于m-1的整数。目标落子位置即为本次预测的最佳落子位置。

[0157]

由于下一层的候选落子位置a

i+1

通常为多个,每个候选落子位置a

i+1

具有各自的落子概率p

i+1

,因此多个候选落子位置a

i+1

以及落子概率p

i+1

可合称为策略向量p(或落子概率分布)。

[0158]

s2、根据候选落子位置a

i+1

扩展第i+1层节点b

i+1

,采用价值网络对第i+1层节点b

i+1

进行评估,得到每个候选落子位置a

i+1

的价值收益v

i+1

;

[0159]

对于扩展出的第i+1层节点b

i+1

,不需要进行实际模拟。直接由价值网络预测出第i+1层节点b

i+1

的价值收益v

i+1

。每个候选落子位置a

i+1

的价值收益v

i+1

代表预测在该候选落子位置下的获胜概率,也即该候选落子位置下的博弈结果。

[0160]

可选地,价值收益v

i+1

采用1或-1来表示,1代表获胜,-1代表失败。换句话说,-1代表预测结果为能量本征值e大于目标基态能量e1,1代表预测结果为能量本征值e小于或等于目标基态能量e1。

[0161]

s3、根据落子概率p

i+1

、价值收益v

i+1

,结合置信上限u来确定出第i+1层节点b

i+1

中的目标节点;

[0162]

示例性的,在蒙特卡洛树的选择阶段,基于“开采-探索”权衡(exploitation-exploration trade-off)的思想执行执行第i+1层目标节点选择,如下公式3:

[0163][0164]

其中,b

i+1

是执行完i层节点选择后的当前棋盘状态,a为下一步执行的行为(也即第i+1步落子),q值是当前棋盘状态b

i+1

下,对第i+1层已经搜索过的节点的价值收益v

i+1

的平均累计值,p是第i+1层节点中各个候选落子位置的落子概率p

i+1

的概率分布,n(b

i+1

,a)是当前的第i+1层节点中某一叶节点a的历史搜索次数,∑

a

,n(b

i+1

,a

′

)是第i+1层节点所有节点的历史搜索总次数,c值是用来平衡已经搜索过的节点和未搜索过的节点的参数。

[0165]

其中,公式3的加号左半部分q与落子概率p

i+1

和价值收益v

i+1

有关,右半部分是置信上限u,置信上限u与历史搜索次数有关。

[0166]

s4、当第i+1层节点不是第m层节点时,以第i+1层目标节点作为新的第i层目标节点,再次执行上述三个步骤;

[0167]

s5、当第i+1层节点是第m层节点时,输出每层节点的行为概率分布π。

[0168]

步骤204a-2,根据每层节点下的行为概率分布π最高的目标落子位置,得到棋盘博弈的预测棋盘路径;

[0169]

步骤204b,根据预测棋盘路径得到预测绝热演化路径;

[0170]

步骤204c,根据量子计算环境计算得到预测绝热演化路径在演化至末态时的能量本征值e;

[0171]

步骤204d,判断能量本征值e是否大于目标基态能量e1;

[0172]

在一个示例中,胜利条件是能量本征值e与目标基态能量e1之间的差值小于阈值。当阈值为0时,设能量本征值e小于或等于目标基态能量e1为胜利条件。本实施例中,以能量本征值e小于或等于目标基态能量e1为胜利条件来举例说明。

[0173]

响应于能量本征值e大于目标基态能量e1,判定结果为未满足胜利条件,执行步骤204e-1;响应于能量本征值e小于或等于目标基态能量e1,判定结果为满足胜利条件,执行步骤204f。

[0174]

步骤204e-1,响应于能量本征值e未达到胜利条件,将预测棋盘路径作为神经网络的输入,获取策略网络输出的策略向量p和价值网络输出的价值收益v;

[0175]

步骤204e-2,以最大化策略向量p和行为概率分布π之间的相似性,且最小化价值收益v和未取得胜利的奖励值z之间的误差为目标,对神经网络中的参数进行更新;

[0176]

示例性的,根据如下损失函数对神经网络中的参数进行调整:

[0177]

loss=(z-v)

2-π

t

logp+c

′

‖θ‖2[0178]

其中,z是未获胜时的奖励值-1,v是价值网络预测的价值收益。π是蒙特卡洛树搜索输出的行为策略概率,p是策略网络预测的策略向量,c’是控制参数l2正则项的一个系数,θ是神经网络的参数。

[0179]

如图11所示,在树搜索阶段,对于每层节点b1、b2和b3,神经网络f

θ

都会输出相应的策略向量p和评估价值v,策略向量p和评估价值v用来指导蒙特卡洛树搜素。在训练阶段,对于每层节点b1、b2和b3,蒙特卡洛树搜素输出的行为概率分布π1、π2和π3,以及未获胜时的奖励值z会作为样本数据,对神经网络f

θ

进行训练。

[0180]

步骤204f,响应于能量本征值e达到胜利条件,将预测棋盘路径确定为棋盘博弈的最优棋盘路径。

[0181]

综上所述,本实施例提供的方法,通过神经网络的指导,能够使得蒙特卡洛树搜索在缩小范围的搜索空间中,快速搜索出最优的预测棋盘路径,提升搜索效率。

[0182]

应用场景:

[0183]

1、加拿大d-wave系统是根植于绝热量子计算,根据本申请的算法可以提高这类计算系统的演化效率,缩短制备目标基态的时间。对于极不稳定的量子系统而言,更短的制备时间意味着本申请可以更好的保护整个演化过程,维持住量子优势,加速绝热量子计算机的发展。

[0184]

2、加快通用量子计算的线路设计。当前阻碍量子计算机发展的一大障碍就是整个系统的相干时间很短,从硬件的角度,增加了科学人员的操作和设计难度。科学家已经证明

绝热量子计算和线路量子计算的等价性,而且量子近似优化(quantum approximate optimization algorithm,qaoa)算法可以帮助将一个绝热路径转化为量子线路。本申请的算法提高绝热量子的效率,等价于本申请可以找到更短的线路去实现常规意义上的量子计算。

[0185]

3、密码破解。绝热量子计算可以用于破解当前主流的加密技术,本申请的算法同样可以在原本最简单的线性绝热路径的基础,加速整个过程,从而大大提高密码破解的效率。

[0186]

近几年增强学习算法在任务路径设计中有着广泛的应用。尤其是阿尔法狗(alpha zero)算法在围棋等游戏中取得重大突破。发明人发现,基于“蒙特卡洛树搜索搭配神经网络”的增强学习框架是可以调整和改进,以便拿来设计最优的绝热路径s(t),助力量子退火和绝热量子计算更高效的解决计算问题。

[0187]

本申请把绝热演化的schedule函数s(t)展开成不同频率的sin函数的叠加。也即,利用傅里叶变化将s(t)表示在频域内:

[0188][0189]

需要找到b1,b2,

…

,b

m

使得演化得到的末态|ψ(t)>的能量尽可能的低。

[0190]

在本申请中,设计最优的绝热演化路径的问题就转化为寻找最优的状态向量序列。本申请将这个排列组合问题转换成一个完全等价的“单人游戏”,并修改阿尔法狗(alpha zero)的围棋算法来搜索最优的“单人游戏”策略。每一次ai算法设计了一个演化路径,采用绝热量子计算机/量子退火机(作为增强学习框架下的环境)执行一遍来验证这个演化路径的功效,比如是不是能够顺利制备出一个目标哈密顿量的基态(能量最低的量子态)。本申请可以用量子硬件所提供的能量测量作为评价这次ai算法设计的路径的好坏。透过自定义的标准,本申请可以评断这一轮的设计ai是否获胜。透过与量子计算机不断的交互(ai指导绝热量子计算的演化并从中得到实时的能量测量反馈),基于增强学习的ai算法一直调整它的游戏策略直到效能达到一个满意的程度。

[0191]

本申请要寻找最优的状态向量每一个b

i

值都被预设在一定范围内的分立值,b

i

∈[-l,-l+δ,

…

,l-δ,l].因此选择一组最优的参数也就转化成在一个大小的棋盘上对于落子点的选择,见图4。

[0192]

这个单人游戏的规则是在每一列都必须刚好下一子(不多不少)。下过子的棋盘直接对应到一个明确的状态向量透过公式(2)得到一个绝热演化路径。根据公式(1),本申请在一台量子绝热计算机执行这个设计,并在计算结束时对量子系统进行能量测量,以供判定这次设计是否在游戏中胜出。透过反复的游戏尝试,最终ai算法会总结出在这个棋盘上最佳的落子点,同时也意味着此算法能找到最优的绝热路径。本申请将这种从头开始学习的,应用于量子绝热演化路径设计的基于mcts与网络结合游戏架构的方法称作“量子狗”(quantumzero)。

[0193]

参见图12,本申请提供的绝热演化路径的方法包括三个部分:量子计算环境、棋盘

空间和量子零度处理。

[0194]

针对量子计算环境:

[0195]

步骤1201,根据目标哈密顿量h1,设定初始哈密顿量h0和目标基态能量e1;

[0196]

步骤1202,在固定的绝热演化时间长度t下,根据预测的绝热演化路径s(t),求解量子薛定谔方程,或者在量子绝热计算机执行演化并测量末态系统,获得演化末态的量子态和对应的能量本征值e。

[0197]

针对棋盘空间:

[0198]

步骤1203,将绝热演化路径s(t),通过傅里叶变换变换到频域的参数序列b,从而将搜索最优绝热演化路径的问题,转换为对最优参数序列b的搜索。

[0199]

步骤1204,将最优参数序列b的搜索离散化,映射到棋盘空间;通过量子零度单人游戏找到最优的棋盘摆法。

[0200]

针对量子零度处理:

[0201]

步骤1205,策略网络和价值网络在某个棋盘状态下产生策略向量p和评估价值v。并根据蒙特卡洛树搜索的反馈(b,π,z)更新网络参数。

[0202]

策略网络和价值网络在某个棋盘状态下产生策略向量p和评估价值v,利用策略向量p和评估价值v指导蒙特卡洛树搜索。在未达到胜利条件时,蒙特卡洛树搜索在反馈(b,π,z)将作为训练样本,用于更新神经网络(策略网络和价值网络)的网络参数。

[0203]

步骤1206,蒙特卡洛树搜索在策略网络和价值网络的引导下,根据开发和探索的原则产生新的行为分布概率π,并根据该棋盘状态下的绝热演化结果,判断输赢,产生新的价值奖励z。

[0204]

本申请开发的新ai算法能够同时提升绝热量子计算的效率(用更短的运算时间得到结果)和准确率(更高的概率得到目标哈密顿量的基态)。本申请透过以下两个案例来佐证这两点。

[0205]

案例一,考虑量子计算的经典问题

--

grover搜索:假设有n个比特,那么这n个比特可以编码2

n

个物体,经典的算法在最差的情况下,需要尝试2

n

次。但是量子计算机可以实现二次加速,也就是本申请只需要2

n/2

次计算。绝热的grover搜索也就是对于下面给定的两个哈密顿量h0,h1设计最优的绝热路径。

[0206]

h0=i-|φ><φ|,h1=i-|m><m|

[0207]

这边i是单位矩阵,|m>是目标二进制字符串。

[0208]

通过对比使用蒙特卡树搜索和增强学习的量子零度所设计的绝热路径与传统的绝热路径(线性搜索),t时间内到达目标的基态的成功概率,就可以清楚的看出量子零度能否在绝热量子演化最优路径的设计中发挥重要作用。

[0209]

案例二,考虑计算机科学中常讨论的3-sat问题,也有广泛的落地应用场景。把这个排列优化组合问题转换成一个绝热量子计算能够处理的问题,本申请必须写下一个目标哈密顿量h1和一个初使哈密顿量h0。

[0210]

[0211][0212]

这个目标哈密顿量h1是由n

c

个逻辑语句组成,每一个语句α是由3个二进制位来决定限制条件。这个问题的解是找到一个n比特的值可以同时满足n

c

个逻辑语句。本申请特意挑了一类对绝热演化会有挑战的3-sat问题:目标哈密顿量只有一个基态,以及多个第一激发态。绝热演化过程中体系容易困在局域最优的解,使得绝热演化效率过低。通过对比使用蒙特卡树搜索和增强学习量子零度所设计的绝热路径与传统的绝热路径(线性搜索),t时间内到达目标的基态的成功概率,就可以清楚的看出量子零度能否在绝热量子演化最优路径的设计中发挥重要作用。

[0213]

图13是量子零度设计的4量子比特grover search在演化时间t=45时绝热量子演化路径的结果。图13中的左图,位于靠下的一组波浪线是策略网络p输出的熵随着量子零度游戏回合数的变化。位于靠上的一组波浪线是策略网络p和价值网络v输出的损失函数的随着量子零度游戏回合数的变化。图13的右图是量子零度设计的演化路径下演化的末态能量。可见随着量子零度逐渐完成训练,找到了设定演化时间下的最优路径,得到了目标哈密顿量基态。

[0214]

延续图13的grover search案例。本申请接着更深入的探讨量子零度所设计的绝热演化路径并和最常见的线性路径做比较。图14的(a)部分是量子零度对于4量子比特grover search在演化时间t=45时所设计的绝热量子演化路径s(t)。图14的(b)部分中虚线是随着绝热演化时间t~(0,t),按照量子零度设计的路径演化,目标哈密顿量基态制备成功的概率。实是随着绝热演化时间t~(0,t),按照线性路径演化,目标哈密顿量基态制备成功的概率。图14的(c)部分是量子零度对于6量子比特grover search在演化时间t=60时所设计的绝热量子演化路径s(t)。图14的(d)部分中虚线是随着绝热演化时间t~(0,t),按照量子零度设计的路径演化,目标哈密顿量基态制备成功的概率。实是随着绝热演化时间t~(0,t),按照线性路径演化,目标哈密顿量基态制备成功的概率。很明显的,量子零度所设计的路径能够保证高成功率。但传统常用的线性路径随着比特数量的增加,明显无法在要求的时间t范围内制备出目标hamiltonian的基态。

[0215]

图15是考虑6量子比特grover search对于不同演化时间长度,目标哈密顿量基态制备成功的概率。圆点是量子零度所设计的演化路径下,目标哈密顿量基态制备成功的概率;叉点是线性演化路径下,目标哈密顿量基态制备成功的概率。很明显看出,由量子零度设计的演化路径很大的提高了量子绝热演化制备目标哈密顿量基态的成功概率。

[0216]

对于前面所提及的第二种案例,量子零度在3-sat问题中绝热演化路径设计的应用,本申请研究了一类对绝热演化会有挑战的3-sat问题:目标哈密顿量只有一个基态,多个第一激发态。绝热演化过程中体系容易困在局域最优的解,使得绝热演化效率过低。本申请以满足上述条件的7个量子比特21个clause的3-sat问题和11个量子比特33个clause的3-sat问题为例,表明随着量子零度训练的逐渐,能稳定的找到了设定演化时间下的最优路径。并且将使用量子零度所设计的绝热路径与传统的绝热路径(线性搜索)相比,t时间内到达目标的基态的成功率明显更高。

[0217]

图16的(a)是量子零度对于7量子比特3-sat问题在演化时间t=85时所设计的绝

热量子演化路径s(t)。图16的(b)中虚线是随着绝热演化时间t~(0,t),按照量子零度设计的路径演化,目标哈密顿量基态制备成功的概率。实线是随着绝热演化时间t~(0,t),按照线性路径演化,目标哈密顿量基态制备成功的概率。明显的量子零度设计的路径结果比较好。

[0218]

图17中的(a)图和(b)图分别是考虑7量子比特和11量子比特的3-sat问题对于不同演化时间长度,目标哈密顿量基态制备成功的概率。圆点是量子零度所设计的演化路径下,目标哈密顿量基态制备成功的概率;叉点是线性演化路径下,目标哈密顿量基态制备成功的概率。很明显看出,由量子零度设计的演化路径很大的提高了量子绝热演化制备目标哈密顿量基态的成功概率。

[0219]

图18是本申请一个示例性实施例示出的一种绝热演化路径的预测装置,所述装置包括:

[0220]

获取模块1810,用于获取量子计算问题的目标哈密顿量h1;

[0221]

确定模块1820,用于根据所述目标哈密顿量h1,确定初始哈密顿量h0和目标基态能量e1;

[0222]

转换模块1830,用于将搜索所述初始哈密顿量h0至所述目标基态能量e1的绝热演化路径转化为棋盘博弈;

[0223]

树搜索模块1840,用于采用结合神经网络的蒙特卡洛树搜索,求解出所述棋盘博弈的最优棋盘路径;

[0224]

输出模块1850,用于根据所述最优棋盘路径得到所述绝热演化路径。

[0225]

在一个可选的实施例中,所述树搜索模块1840,用于采用结合所述神经网络的所述蒙特卡洛树搜索,搜索出所述棋盘博弈的预测棋盘路径;根据所述预测棋盘路径得到预测绝热演化路径;根据量子计算环境计算得到所述预测绝热演化路径在演化至末态时的能量本征值e;响应于所述能量本征值e未达到胜利条件,根据本次预测过程对所述神经网络中的参数进行更新,并在更新后再次执行所述采用结合所述神经网络的所述蒙特卡洛树搜索,预测出所述棋盘博弈的预测棋盘路径的步骤;响应于所述能量本征值e达到所述胜利条件,将所述预测棋盘路径确定为所述棋盘博弈的最优棋盘路径;

[0226]

其中,所述胜利条件是所述能量本征值e与所述目标基态能量e1之间的差值小于阈值。

[0227]

在一个可选的实施例中,所述神经网络包括:策略网络和价值网络;

[0228]

所述树搜索模块1840,用于在所述棋盘博弈对应的博弈树中,采用所述蒙特卡洛树搜索进行搜索,输出每层节点的行为概率分布π;所述每层节点的行为概率分布π代表下一手棋子的候选落子位置以及概率分布;根据每层节点下的所述行为概率分布π最高的目标落子位置,得到所述棋盘博弈的预测棋盘路径;

[0229]

以及,所述树搜索模块1840,还用于响应于所述能量本征值e未达到所述胜利条件,将所述预测棋盘路径中作为所述神经网络的输入,获取所述策略网络输出的策略向量p和所述价值网络输出的价值收益v;以最大化所述策略向量p和所述行为概率分布π之间的相似性,且最小化所述价值收益v和未取得胜利的奖励值z之间的误差为目标,对所述神经网络中的参数进行更新。

[0230]

在一个可选的实施例中,所述树搜索模块1840,用于在所述棋盘博弈的第i层目标

节点b

i

下,使用所述策略网络输出第i+1层节点b

i+1

的候选落子位置a

i+1

以及落子概率p

i+1

,所述第i层目标节点bi对应第i层节点的目标落子位置,i为不大于m-1的整数;根据所述候选落子位置a

i+1

扩展所述第i+1层节点b

i+1

,采用所述价值网络对所述第i+1层节点b

i+1

进行评估,得到每个所述候选落子位置a

i+1

的价值收益v

i+1

;根据所述落子概率p

i+1

、所述价值收益v

i+1

,结合置信上限u来确定出所述第i+1层节点b

i+1

中的目标节点;当所述第i+1层节点不是第m层节点时,以所述第i+1层目标节点作为新的第i层目标节点,再次执行上述三个步骤;当所述第i+1层节点是第m层节点时,输出所述每层节点的行为概率分布π。

[0231]

在一个可选的实施例中,所述置信上限与所述候选落子位置的历史搜索次数有关。

[0232]

在一个可选的实施例中,所述转换模块1830,用于将所述初始哈密顿量h0至所述目标基态能量e1的绝热演化路径表达为绝热演化函数s(t);采用傅里叶变换将所述绝热演化函数s(t)变换为频域的状态向量序列b,所述状态向量序列b包括m个向量维度,每个向量维度的取值范围为2l;根据所述向量维度的维数m和所述每个向量维度的取值范围2l,转换得到棋盘博弈;所述棋盘博弈包括2l/

△

行和m列,每一列对应一个棋子的落子位置,

△

为离散化步长。

[0233]

需要说明的是,上述实施例提供的装置,在实现其功能时,仅以上述各功能模块的划分进行举例说明,实际应用中,可以根据需要而将上述功能分配由不同的功能模块完成,即将设备的内部结构划分成不同的功能模块,以完成以上描述的全部或者部分功能。另外,上述实施例提供的装置与方法实施例属于同一构思,其具体实现过程详见方法实施例,这里不再赘述。

[0234]

图19示出了本申请一个实施例提供的计算机设备1900的结构框图。该计算机设备1900可以是手机、平板电脑、可穿戴设备、多媒体播放设备、相机等电子设备。

[0235]

通常,计算机设备1900包括有:处理器1901和存储器1902。

[0236]

处理器1901可以包括一个或多个处理核心,比如4核心处理器、19核心处理器等。处理器1901可以采用dsp(digital signal processing,数字信号处理)、fpga(field programmable gate array,现场可编程门阵列)、pla(programmable logic array,可编程逻辑阵列)中的至少一种硬件形式来实现。处理器1901也可以包括主处理器和协处理器,主处理器是用于对在唤醒状态下的数据进行处理的处理器,也称cpu(central processing unit,中央处理器);协处理器是用于对在待机状态下的数据进行处理的低功耗处理器。在一些实施例中,处理器1901可以在集成有gpu(graphics processing unit,图像处理器),gpu用于负责显示屏所需要显示的内容的渲染和绘制。一些实施例中,处理器1901还可以包括ai(artificial intelligence,人工智能)处理器,该ai处理器用于处理有关机器学习的计算操作。

[0237]

存储器1902可以包括一个或多个计算机可读存储介质,该计算机可读存储介质可以是非暂态的。存储器1902还可包括高速随机存取存储器,以及非易失性存储器,比如一个或多个磁盘存储设备、闪存存储设备。在一些实施例中,存储器1902中的非暂态的计算机可读存储介质用于存储至少一条指令、至少一段程序、代码集或指令集,该至少一条指令、至少一段程序、代码集或指令集用于被处理器1901所执行以实现本申请中方法实施例提供的绝热演化路径的预测方法或者语音互动方法。

[0238]

在一些实施例中,计算机设备1900还可选包括有:外围设备接口1903和至少一个外围设备。处理器1901、存储器1902和外围设备接口1903之间可以通过总线或信号线相连。各个外围设备可以通过总线、信号线或电路板与外围设备接口1903相连。具体地,外围设备可以包括:射频电路1904、触摸显示屏1905、摄像头1906、音频电路1907、定位组件1908和电源1909中的至少一种。

[0239]

其中,摄像头1906可以是彩色摄像头+深度摄像头形成的三维摄像头。

[0240]

本领域技术人员可以理解,图19中示出的结构并不构成对计算机设备1900的限定,可以包括比图示更多或更少的组件,或者组合某些组件,或者采用不同的组件布置。

[0241]

在示例性实施例中,还提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或所述指令集在被计算机设备的处理器执行时以实现上述绝热演化路径的预测方法。

[0242]

在示例性实施例中,还提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或所述指令集在被计算机设备的处理器执行时以实现上述绝热演化路径的预测方法。

[0243]

可选地,该计算机可读存储介质可以包括:rom、ram、ssd(solid state drives,固态硬盘)或光盘等。其中,随机存取记忆体可以包括reram(resistance random access memory,电阻式随机存取记忆体)和dram(dynamic random access memory,动态随机存取存储器)。

[0244]

在示例性实施例中,还提供一种计算机程序产品,所述计算机程序产品被计算机设备的处理器执行时,用于实现上述绝热演化路径的预测方法。

[0245]

在示例性实施例中,还提供一种计算机程序产品,所述计算机程序产品被终端的处理器执行时,用于实现上述绝热演化路径的预测方法。

[0246]

应当理解的是,在本文中提及的“多个”是指两个或两个以上。“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。另外,本文中描述的步骤编号,仅示例性示出了步骤间的一种可能的执行先后顺序,在一些其它实施例中,上述步骤也可以不按照编号顺序来执行,如两个不同编号的步骤同时执行,或者两个不同编号的步骤按照与图示相反的顺序执行,本申请实施例对此不作限定。

[0247]

以上所述仅为本申请的示例性实施例,并不用以限制本申请,凡在本申请的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本申请的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1