基于语义分割网络和多视图几何的动态环境信息检测方法与流程

[0001]

本发明涉及无人机自主巡检中基于视觉的定位与导航领域,更具体地,涉及基于语义分割网络和多视图几何的动态环境信息检测方法。

背景技术:

[0002]

无人机智能巡检过程中需要无人机根据当前所处环境的实时信息、自主确定下一步操作。因此对无人机进行实时定位与工作环境建图是无人机智能巡检过程中的重要环节。尤其是在网格化布置的多无人机协同工作中,每个无人机所检测到的环境都是动态场景(包含时有时无的移动物体),因此在定位和环境建图过程中还需针对动态场景开发专用算法。

[0003]

同时定位与建图(simultaneous localization and mapping,slam)是一种在没有任何环境先验信息的情况下,能通过传感器由相应的运动估计算法估计出当前的位置和姿态,并建立环境的三维地图的技术。随着计算机视觉和深度学习技术的发展,以及硬件计算能力的提高,基于视觉的slam研究不断深化,并广泛应用于自主驾驶、移动机器人和无人机等领域。

[0004]

公开号为“cn110322511a”,公开日为2019年10月11日的中国专利申请文件公开了一种基于物体和平面特征的语义slam方法和系统,获取场景的rgb-d图像流,利用rgb-d图像流进行逐帧跟踪得到关键帧图像;利用关键帧图像构建关于场景的局部地图,对关键帧图像的深度图进行平面分割得到当前平面,利用当前平面构建全局平面地图,对关键帧图像进行物体检测,得到检测框和置信度,利用检测框和置信度重建物体的点云,将检测框中的特征点归并到物体,得到全局物体地图;利用关键帧图像进行回环检测,得到回环帧,利用回环帧进行回环修正优化平面约束与物体约束,得到场景的平面地图和物体地图。本发明可以提升slam优化性能,并增强对环境的语义描述。但是在上述的方法中,一旦场景中动态物体占据多数,就会影响方法的精度和鲁棒性。另外,上述方法中处理每一帧的时延过长,并未考虑实时性对系统的影响

技术实现要素:

[0005]

本发明为克服上述现有技术中检测精度和鲁棒性低的问题,提供基于语义分割网络和多视图几何的动态环境信息检测方法,提高检测精度和系统的鲁棒性,同时还可以提高检测速度。

[0006]

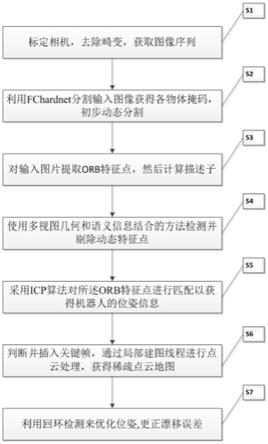

为解决上述技术问题,本发明采用的技术方案是:基于语义分割网络和多视图几何的动态环境信息检测方法,包括以下步骤:

[0007]

步骤一:标定相机,去除图像畸变;获取环境图像并输入;

[0008]

步骤二:通过语义分割网络对输入图像进行分割,获得各物体掩码,实现初步动态分割;

[0009]

步骤三:对输入图像提取orb特征点,然后计算描述子;

[0010]

步骤四:使用多视图几何和语义信息结合的方法检测并剔除动态特征点;

[0011]

步骤五:对orb特征点进行匹配以获得机器人的位姿信息;

[0012]

步骤六:判断并插入关键帧,通过局部建图线程进行点云处理,获得稀疏点云地图;

[0013]

步骤七:利用回环检测来优化位姿,更正漂移误差。

[0014]

优选的,在所述步骤一中,标定相机,去除图像畸变具体的步骤为:

[0015]

s1.1:首先获取相机内参,其中内参包括f

x

,f

y

,c

x

,c

y

,将三维坐标(x,y,z)归一化为齐次坐标(x,y);

[0016]

s1.2:去除畸变对图像的影响,其中[k1,k2,k3,p1,p2]为该镜头的畸变系数,人为该点到坐标系原点的距离:

[0017][0018]

s1.3:将该摄像机坐标系下的坐标转到像素坐标系下:

[0019][0020]

优选的,所述语义分割网络为轻量级语义分割网络fchardnet。通过hdb块连接1x1的卷积来减少模型大小,该网络在相同硬件环境下,比其他的网络结构图像处理速度快30%左右。通过fchardnet分割出图像的潜在动态区域,并生成掩模。

[0021]

优选的,在所述步骤三中,对输入图像提取orb特征点的过程中构建高斯金字塔并在金字塔的不同层进行特征点检测,达到尺度不变的特性。

[0022]

优选的,orb特征点提取的具体步骤为:

[0023]

s3.1:当某点p周围有超过一定数量的点与该点p的灰度值相差较大就认为该点为目标角点,具体表示为:

[0024][0025]

s3.2:为了使特征点保存方向不变,计算质心:

[0026][0027]

s3.3:为使特征点具有尺度不变性,通过对原图像序列以一定比例缩放,构图像金字塔。图像金字塔的每一级不同大小的图像中提取相应的角点;

[0028]

s3.4:同时为了使特征点在图像中均匀分布采用四叉树均匀算法,将图像不断向下细分四分尺寸相同的节点,合并无特征点的节点,当节点中特征点数目大于1时增加节点;节点分布完成后,删除子节点中多余特征点。

[0029]

优选的,在所述步骤四中,具体的步骤为:

[0030]

s4.1:将关键帧中的特征点xkf根据计算的相对位姿投影到当前帧中,获得匹配的特征点xcur,以及xcur在当前帧的深度zproj;

[0031]

s4.2:判断特征点是否为动态点;

[0032]

s4.3:剔除通过多视图几何方法得出的动态点和语义分割结果中动态掩模内的所

有动态点,输出剩余静态点。

[0033]

优选的,在所述步骤s4.2中,动态点的判断方法为:根据当前帧对应的深度图获得特征点xcur实际测得的深度值zcur。如果该点为静态投影的深度值和实际的深度值应该近似相等,所以通过计算当前帧的深度zproj和实际测得的深度值zcur的差值δz来判断特征点的是否为动态点。如果δz大于某个阈值threshold,则认为特征点xcur是在动态物体上,是动态点,需要将其剔除,其中:

[0034][0035]

优选的,在所述步骤s4.2中,动态点的判断方法为:根据视差,如特征点xkf和其投影点xcur之间的视差角α大于30

°

,认为该特征点xcur为动态点,从图像中剔除。

[0036]

优选的,通过迭代最近点算法计算相机位姿,迭代最近点算法利用匹配点对间的空间距离作为依据,通过不断迭代优化调整相机的位姿使得匹配点间的累积距离最小化,从而计算出相机在两帧图像间移动的最优旋转矩阵r和平移矩阵t,具体步骤为:

[0037]

s5.1:计算匹配点对的误差平方和最小二乘问题,其中p

i

和p

′

分别是特征点集和特征点匹配点集如下:

[0038][0039]

式中,p

i

为特征点集;p

′

为特征点;r为最优旋转矩阵;t为平移矩阵。

[0040]

s5.2:通过奇异值分解法求得旋转矩阵,进而求得平移向量。

[0041]

优选的,在所述步骤六中,稀疏点云的构建步骤为:

[0042]

s6.1:选择并插入关键帧选择满足了以下条件:当前帧距离最近关键帧的距离大于阈值;距离上次插入关键帧的时间大于阈值;与上一关键帧的共视点是低于阈值;该帧的跟踪质量达到要求;

[0043]

s6.2:更新该关键帧和其他关键帧之间的共视关系以及关键帧和地图点的观察关系,删除不符合条件的关键帧;将其余关键帧中的符合条件的特征点转化为点云地图点。

[0044]

与现有技术相比,本发明的有益效果是:本发明提高了rgb-d slam系统在高动态的环境中运行的精度和鲁棒性。同时,使用轻量级语义分割网络可以减少系统存储和时间开销,在保持高精度的同时也兼顾了系统的实时性。

附图说明

[0045]

图1是本发明的基于语义分割网络和多视图几何的动态环境信息检测方法的流程图;

[0046]

图2是本发明的剔除动态特征点的流程图;

[0047]

图3是语义分割网络的网络框架。

具体实施方式

[0048]

附图仅用于示例性说明,不能理解为对本专利的限制;为了更好说明本实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;对于本领域技术人员来说,

附图中某些公知结构及其说明可能省略是可以理解的。附图中描述位置关系仅用于示例性说明,不能理解为对本专利的限制。

[0049]

本发明实施例的附图中相同或相似的标号对应相同或相似的部件;在本发明的描述中,需要理解的是,若有术语“上”、“下”、“左”、“右”“长”“短”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此附图中描述位置关系的用语仅用于示例性说明,不能理解为对本专利的限制,对于本领域的普通技术人员而言,可以根据具体情况理解上述术语的具体含义。

[0050]

下面通过具体实施例,并结合附图,对本发明的技术方案作进一步的具体描述:

[0051]

实施例

[0052]

如图1-3所示为基于语义分割网络和多视图几何的动态环境信息检测方法的实施例,包括如下步骤:

[0053]

步骤一:标定相机,去除图像畸变;获取环境图像并输入;标定相机,去除图像畸变具体的步骤为:

[0054]

s1.1:首先获取相机内参,其中内参包括f

x

,f

y

,c

x

,c

y

,将三维坐标(x,y,z)归一化为齐次坐标(x,y);

[0055]

s1.2:去除畸变对图像的影响,其中[k1,k2,k3,p1,p2]为该镜头的畸变系数,人为该点到坐标系原点的距离:

[0056][0057]

s1.3:将该摄像机坐标系下的坐标转到像素坐标系下:

[0058][0059]

步骤二:通过语义分割网络对输入图像进行分割,获得各物体掩码,实现初步动态分割;语义分割网络为轻量级语义分割网络fchardnet。通过hdb块连接1x1的卷积来减少模型大小,该网络在相同硬件环境下,比其他的网络结构图像处理速度快30%左右。通过fchardnet分割出图像的潜在动态区域,并生成掩模。

[0060]

步骤三:对输入图像提取orb特征点,然后计算描述子;orb特征点提取的具体步骤为:

[0061]

s3.1:当某点p周围有超过一定数量的点与该点p的灰度值相差较大就认为该点为目标角点,具体表示为:

[0062][0063]

s3.2:为了使特征点保存方向不变,计算质心:

[0064][0065]

s3.3:为使特征点具有尺度不变性,通过对原图像序列以一定比例缩放,构图像金字塔。图像金字塔的每一级不同大小的图像中提取相应的角点;

[0066]

s3.4:同时为了使特征点在图像中均匀分布采用四叉树均匀算法,将图像不断向下细分四分尺寸相同的节点,合并无特征点的节点,当节点中特征点数目大于1时增加节点;节点分布完成后,删除子节点中多余特征点。

[0067]

步骤四:使用多视图几何和语义信息结合的方法检测并剔除动态特征点;具体步骤为:

[0068]

s4.1:将关键帧中的特征点xkf根据计算的相对位姿投影到当前帧中,获得匹配的特征点xcur,以及xcur在当前帧的深度zproj;

[0069]

s4.2:判断特征点是否为动态点;具体的方法依次为:一个是根据当前帧对应的深度图获得特征点xcur实际测得的深度值zcur。如果该点为静态投影的深度值和实际的深度值应该近似相等,所以通过计算当前帧的深度zproj和实际测得的深度值zcur的差值δz来判断特征点的是否为动态点。如果δz大于某个阈值threshold,则认为特征点xcur是在动态物体上,是动态点,需要将其剔除,其中:

[0070][0071]

采用上述经过上述判断方法得到的静态点,根据视差,如特征点xkf和其投影点xcur之间的视差角α大于30

°

,认为该特征点xcur为动态点,从图像中剔除。

[0072]

s4.3:剔除通过多视图几何方法得出的动态点和语义分割结果中动态掩模内的所有动态点,输出剩余静态点。

[0073]

步骤五:对orb特征点进行匹配以获得机器人的位姿信息;通过迭代最近点算法计算相机位姿,迭代最近点算法利用匹配点对间的空间距离作为依据,通过不断迭代优化调整相机的位姿使得匹配点间的累积距离最小化,从而计算出相机在两帧图像间移动的最优旋转矩阵r和平移矩阵t,具体步骤为:

[0074]

s5.1:计算匹配点对的误差平方和最小二乘问题,其中p

i

和p

′

分别是特征点集和特征点匹配点集如下:

[0075][0076]

式中,p

i

为特征点集;p

′

为特征点;r为最优旋转矩阵;t为平移矩阵。

[0077]

s5.2:通过奇异值分解法求得旋转矩阵,进而求得平移向量。

[0078]

步骤六:判断并插入关键帧,通过局部建图线程进行点云处理,获得稀疏点云地图;具体步骤为:s6.1:选择并插入关键帧选择满足了以下条件:当前帧距离最近关键帧的距离大于阈值;距离上次插入关键帧的时间大于阈值;与上一关键帧的共视点是低于阈值;该帧的跟踪质量达到要求;

[0079]

s6.2:更新该关键帧和其他关键帧之间的共视关系以及关键帧和地图点的观察关系,删除不符合条件的关键帧;将其余关键帧中的符合条件的特征点转化为点云地图点。

[0080]

步骤七:利用回环检测来优化位姿,更正漂移误差。

[0081]

本实例的有益效果:本发明提高了rgb-d slam系统在高动态的环境中运行的精度和鲁棒性。同时,使用轻量级语义分割网络可以减少系统存储和时间开销,在保持高精度的同时也兼顾了系统的实时性。

[0082]

显然,本发明的上述实施例仅仅是为清楚地说明本发明所作的举例,而并非是对本发明的实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明权利要求的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1