一种提高内容一致性的长文本故事生成方法及系统与流程

[0001]

本发明属于故事生成领域,尤其涉及一种提高内容一致性的长文本故事生成方法及系统。

背景技术:

[0002]

长文本故事生成是自然语言处理领域的一项重要的工作,已成为自然语言处理的重要组成部分。然而,实现一个好的故事生成模型一直是一个非常具有挑战性的任务。故事生成是指自动确定故事的内容并使用适当的语言来编写故事的任务。这些故事最重要的一个方面就是它们的连贯性。整体连贯的范围包括:按照合理的顺序安排内容、生成的内容贴合主题、文字表达上尽可能流畅等。在传统方法中,自动故事生成往往是通过符号规划系统来完成的。这些符号规划系统通常包含一个层次化的结构流程,一般包括高层模块与底层模块:高层模块用来执行文本规划,根据文章的主题思想,确定每个句子的子主题以及句子之间的关系;低级模块则根据高层模块的规划,生成每个句子的具体内容。尽管这种层次化的文本规划系统能够产生流畅连贯的故事,但其很大程度上仍然依赖人工知识工程来选择每个句子的动作、角色等,因此该系统在某些领域中的表现难以令人满意。

技术实现要素:

[0003]

为了解决上述技术问题,本发明的目的是提供一种提高内容一致性的长文本故事生成方法及系统,实现了在保证可拓展性前提下具有更高预测准确率。

[0004]

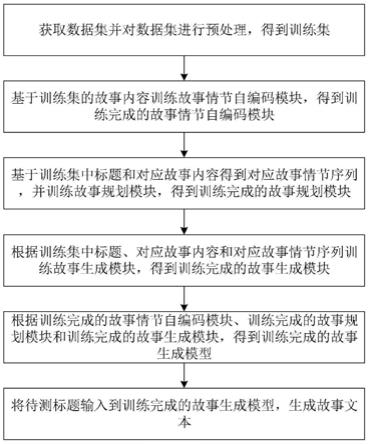

本发明所采用的第一技术方案是:一种提高内容一致性的长文本故事生成方法,包括以下步骤:

[0005]

获取数据集并对数据集进行预处理,得到训练集;

[0006]

基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型;

[0007]

将待测标题输入到训练完成的故事生成模型,生成故事文本。

[0008]

进一步,所述故事生成模型包括故事情节自编码模块、故事规划模块和故事生成模块。

[0009]

进一步,所述基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型这一步骤,其具体包括:

[0010]

基于训练集的故事内容训练故事情节自编码模块,得到训练完成的故事情节自编码模块;

[0011]

基于训练集中标题和对应故事内容得到对应故事情节序列,并训练故事规划模块,得到训练完成的故事规划模块;

[0012]

根据训练集中标题、对应故事内容和对应故事情节序列训练故事生成模块,得到训练完成的故事生成模块;

[0013]

根据训练完成的故事情节自编码模块、训练完成的故事规划模块和训练完成的故

事生成模块,得到训练完成的故事生成模型。

[0014]

进一步,所述基于训练集的故事内容训练故事情节自编码模块,得到训练完成的故事情节自编码模块这一步骤,其具体还包括:

[0015]

对训练集中多个故事内容分别编码压缩,得到多个特征图;

[0016]

将多个特征图映射成向量情节序列,得到故事情节向量表;

[0017]

存储故事情节向量表,得到训练完成的故事情节自编码模块。

[0018]

进一步,所述将待测标题输入到训练完成的故事生成模型,生成故事文本这一步骤,其具体包括:

[0019]

基于故事情节自编码模块对待测标题进行编码,得到标题编码信息;

[0020]

将标题编码信息输入到训练完成的故事规划模块,映射得到故事情节序列;

[0021]

将故事情节序列输入到训练完成的故事生成模块,将故事情节向量序列解码得到故事文本。

[0022]

进一步,所述标题编码信息具体为特征图。

[0023]

进一步,所述故事生成模块采用反卷积神经网络。

[0024]

本发明所采用的第二技术方案是:一种提高内容一致性的长文本故事生成系统,包括以下模块:

[0025]

数据集获取模块,用于获取数据集并对数据集进行预处理,得到训练集;

[0026]

训练模块,用于基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型;

[0027]

生成模块,用于将待测标题输入到训练完成的故事生成模型,生成故事文本。

[0028]

本发明方法及系统的有益效果是:本发明从大规模的故事语料中自动总结归纳出各种抽象的故事情节并制作成向量表,并将故事生成分解为两个阶段,首先根据标题对故事情节进行规划,得到故事情节序列,然后根据标题与故事情节序列,依次生成每个故事情节对应的具体内容,提高模型生成的故事内容一致性。

附图说明

[0029]

图1是本发明具体实施例一种提高内容一致性的长文本故事生成方法的步骤流程图;

[0030]

图2是本发明具体实施例一种提高内容一致性的长文本故事生成系统的结构框图;

[0031]

图3是本发明具体实施例故事生成模型的结构示意图。

具体实施方式

[0032]

下面结合附图和具体实施例对本发明做进一步的详细说明。对于以下实施例中的步骤编号,其仅为了便于阐述说明而设置,对步骤之间的顺序不做任何限定,实施例中的各步骤的执行顺序均可根据本领域技术人员的理解来进行适应性调整。

[0033]

在本发明的故事生成中,所要实现的目标为:给定title={t1,t2,

…

,t

n

},生成一个story={s1,s2,

…

,s

m

}。其中ti表示title的第i个单词,story由m个故事情节对应的文本组成,s

i

表示story的第i个故事情节对应的文本内容。

[0034]

如图1所示,本发明提供了一种单步逆向合成方法,该方法包括以下步骤:

[0035]

s1、获取数据集并对数据集进行预处理,得到训练集;

[0036]

具体地,获取大量训练样本,设样本数量为n,样本形式为(title,story),其中title表示故事标题,story表示故事的具体内容。

[0037]

s2、基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型;

[0038]

s3、将待测标题输入到训练完成的故事生成模型,生成故事文本。

[0039]

具体地,本发明设计了一种故事情节自编码器,可以从大规模的故事语料中自动总结归纳出各种抽象的故事情节。本发明提出的层次故事生成方法,将故事生成分解为两个阶段,首先根据标题对故事情节进行规划,得到故事情节序列。然后根据标题与故事情节序列,依次生成每个故事情节对应的具体内容。该策略能够提高模型生成的故事内容一致性。

[0040]

进一步作为本方法的优选实施例,所述故事生成模型包括故事情节自编码模块、故事规划模块和故事生成模块。

[0041]

具体地,故事情节自编码模块,由多个卷积层堆叠而成的,每个卷积层可以捕获输入文本不同粒度的语义信息。经过故事情节自编码模块之后,输入的故事文本被编码压缩成一个特征图,特征图中包含一系列的特征向量。故事规划模块将特征图映射成为一个故事情节向量序列。更具体的,计算特征图中的每个特征向量与每个故事情节向量的距离,将特征向量映射为距离最近的故事情节向量,从而得到该故事情节序列。故事生成模块由反卷积神经网络组成,反卷积神经网络由多个反卷积操作堆叠而成。参照图3。

[0042]

进一步作为本方法优选实施例,所述基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型这一步骤,其具体包括:

[0043]

基于训练集的故事内容训练故事情节自编码模块,得到训练完成的故事情节自编码模块;

[0044]

具体地,使用n个story,训练故事情节自编码模块,对大规模故事语料的故事情节自动进行总结归纳,并且得到每个故事情节对应的故事情节向量。从而得到一个故事情节向量表,表示为<e1,e2,...,en>,其中ei表示第i个故事情节对应的向量,n为故事情节的个数。

[0045]

基于训练集中标题和对应故事内容得到对应故事情节序列,并训练故事规划模块,得到训练完成的故事规划模块;

[0046]

具体地,对于每个数据(title,story),得到story对应的故事情节序列,然后使用(title,故事情节序列)训练故事情节规划模块,使得故事情节规划模块能够学会根据title生成故事情节序列。

[0047]

根据训练集中标题、对应故事内容和对应故事情节序列训练故事生成模块,得到训练完成的故事生成模块;

[0048]

具体地,使用(title,故事情节序列,story)训练故事生成模块,使得故事生成模块学会如何根据title与故事情节序列生成对应的story。故事生成模块的训练目标为:给定上文,一次性预测接下来的n个单词,使得模型在生成每个单词时候,能够考虑更加长期

的收益。

[0049]

根据训练完成的故事情节自编码模块、训练完成的故事规划模块和训练完成的故事生成模块,得到训练完成的故事生成模型。

[0050]

进一步作为本发明的优选实施例,所述基于训练集的故事内容训练故事情节自编码模块,得到训练完成的故事情节自编码模块这一步骤,其具体还包括:

[0051]

对训练集中多个故事内容分别编码压缩,得到多个特征图;

[0052]

将多个特征图映射成向量情节序列,得到故事情节向量表;

[0053]

具体地,该故事情节向量表由若干个故事情节向量组成,每个向量表示一个抽象的故事情节,向量表的规模由人为设定。

[0054]

存储故事情节向量表,得到训练完成的故事情节自编码模块。

[0055]

具体地,进一步作为本发明优选实施例,所述将待测标题输入到训练完成的故事生成模型,生成故事文本这一步骤,其具体包括:

[0056]

基于故事情节自编码模块对待测标题进行编码,得到标题编码信息;

[0057]

将标题编码信息输入到训练完成的故事规划模块,映射得到故事情节序列;

[0058]

将故事情节序列输入到训练完成的故事生成模块,将故事情节向量序列解码得到故事文本。

[0059]

具体地,在故事生成阶段,根据输入的title,首先使用柜式规划模块对故事情节进行规划,得到故事情节序列。然后故事生成模块再根据title与故事情节序列,生成每个故事情节的具体内容。

[0060]

进一步作为本发明优选实施例,所述标题编码信息具体为特征图。

[0061]

具体地,输入的故事文本或标题被编码压缩成一个特征图,特征图中包含一系列的特征向量。

[0062]

进一步作为本发明优选实施例,所述故事生成模块采用反卷积神经网络。

[0063]

如图2所示,一种提高内容一致性的长文本故事生成系统,包括以下模块:

[0064]

数据集获取模块,用于获取数据集并对数据集进行预处理,得到训练集;

[0065]

训练模块,用于基于训练集的故事标题、故事内容和故事情节序列对预构建故事生成模型进行训练,得到训练完成的故事生成模型;

[0066]

生成模块,用于将待测标题输入到训练完成的故事生成模型,生成故事文本。

[0067]

上述系统实施例中的内容均适用于本方法实施例中,本方法实施例所具体实现的功能与上述系统实施例相同,并且达到的有益效果与上述系统实施例所达到的有益效果也相同。

[0068]

以上是对本发明的较佳实施进行了具体说明,但本发明创造并不限于所述实施例,熟悉本领域的技术人员在不违背本发明精神的前提下还可做作出种种的等同变形或替换,这些等同的变形或替换均包含在本申请权利要求所限定的范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1