应用于单线激光雷达的深度补全方法

1.本发明涉及的是一种图像处理领域的技术,具体是一种应用于单线激光雷达的深度补全方法。

背景技术:

2.近年来,准确而稠密的深度图在各类任务中都变得愈发重要,例如在增强现实、无人机、机器人控制和自动驾驶等领域中。然而在室外环境中,如近红外、结构光等传感器都将因为室外环境干扰强和距离远而失效。而激光雷达凭借其抗干扰性强与测量距离远成为目前室外环境的主流测量手段。但激光雷达有限的扫描线将导致其获取深度图的高稀疏性,以目前的velodyne hdl-64e(64线激光雷达)为例,其获取深度图中的有效值大约只有4%。如此稀疏的深度图对实际应用而言是远远不够。所以如何凭借现有激光雷达的稀疏深度图来生成准确而稠密的深度图就变成目前一大研究热点。

3.现有技术在室外环境中,只能获取稀疏的深度图,目前的主流方案都是使用64线激光雷达配合rgb相机来获取数据,之后再使用二者的数据来生成稠密深度图,即深度补全。64线激光雷达代表此类激光雷达使用64条扫描线。近年来随着深度学习的兴起,越来越多的团队开始尝试使用神经网络来实现深度补全。具体来说,此类方案会使用64线激光雷达与rgb相机分别获取64线稀疏深度图与rgb彩色图片,并将二者对齐。之后将二者作为输入送入训练好的神经网络中生成稠密深度图。由于神经网络训练数据与检测准确率有密切关系,现有的训练数据集如kitti采用64线深度图,其导致系统在使用时必须使用64线激光雷达,严重限制应用范围。

技术实现要素:

4.本发明针对现有技术存在的上述不足,提出一种应用于单线激光雷达的深度补全方法,通过单线激光雷达来替换64线激光雷达实现深度补全,显著降低稠密深度图的获取成本,不仅能应用于单线激光雷达,同时可以应用于任意n线(n≤64)激光雷达,如4线激光雷达、16线激光雷达等。

5.本发明是通过以下技术方案实现的:

6.本发明涉及一种应用于单线激光雷达的深度补全方法,对kitti 64线深度补全数据集处理得到单线深度补全数据集,并使用单线深度补全数据集训练双分支深度学习网络后,以对齐过的单线深度图与rgb图为神经网络的输入便能得到稠密深度图。

7.所述的处理是指:将现有的64线kitti深度补全数据集中的64线稀疏深度图转换成单线深度图,从而得到单线深度补全数据集。

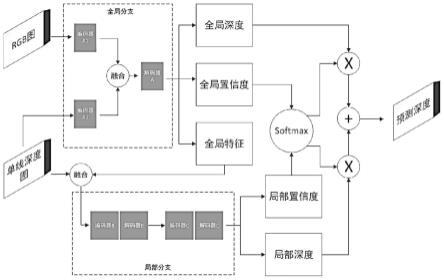

8.所述的双分支深度学习网络包括全局分支和局部分支,其中:全局分支利用rgb图像中的全局语义信息辅助预测物体的边界以找到深度相似的区域;局部分支聚焦于深度图中的有效值区域并预测有效值区域周围的深度的同时,利用全局分支提取的全局特征来修正稀疏深度图的内在误差。

9.所述的双分支深度学习网络,通过用于单线深度补全的组合损失函数训练,该组合损失函数为l

final

=l

mse

+λl

vn

,其中:λ为权重参数,用于实现像素级约束的均方误差损失函数用于实现三维几何约束的虚拟法线误差损失函数n

p

为真值深度图中有效深度值的像素数,和分别为预测深度图和真值深度图i处的深度值;nn为随机采样出的虚拟平面数,和分别为预测深度图和真值深度图中的第i个虚拟平面的虚拟法线。

10.所述的权重参数λ用来平衡二者数量级,优选取100。技术效果

11.本发明整体解决了现有深度补全技术只能应用于64线激光雷达,无法应用于单线激光雷达的问题,具体技术问题主要包括:1、缺乏单线深度补全数据集;2、单线深度补全任务中深度信息极度缺乏,现有技术的网络很难在此情况下生成精确的稠密深度图。对于第一个问题,本发明通过对已有的64线深度补全数据集kitti进行处理,得到了单线深度补全数据集。对于第二个问题,本发明通过使用全局分支与局部分支相结合的方式,在保证充分利用稀少深度信息的同时,在全局分支中的部分上采样中使用了本发明提出的一种内容感知的上采样模块,根据不同位置的语义信息分别使用不同的卷积核,能更好地利用rgb图的语义信息,以弥补深度信息稀少带来的问题。同时,本发明提出的组合损失函数实现的像素级约束和三维几何约束也大大提升了本发明网络的精度。凭借上述技术,本发明的单线深度补全误差达到非常低的水平,其中绝对相对误差仅4.68%,完全满足实际使用的需求,能够应用于单线激光雷达,获得稠密深度图,且稍加变换,便能应用于任意n线(n≤64)激光雷达,如4线、16线等。

附图说明

12.图1为本发明系统结构示意图;

13.图2为实施例rgb输入示意图;

14.图3为实施例单线深度输入示意图;

15.图4为实施例网络输出效果示意图。

具体实施方式

16.如图1所示,为本实施例涉及一种应用于单线激光雷达的深度补全方法,具体步骤包括:

17.步骤1)数据集生成:将现有的64线kitti深度补全数据集中的64线稀疏深度图转换成单线深度图,从而得到单线深度补全数据集。

18.所述的64线深度补全数据集中每组数据包括:rgb图(输入)、对齐的64线稀疏深度图(输入)以及半稠密深度图(真值,用作神经网络的监督)。

19.所述的转换包括:

20.①

将64线稀疏深度图转换为点云图;

21.②

计算点云图中每个三维点的垂直角

22.③

以0.4

°

为间隔将每个三维点的垂直角划分为64个级别,从而将每个三维点分配到对应的扫描线上;

23.④

直接选取中间的扫描线生成单线深度图。

24.本实施例中利用kitti(64线深度补全数据集)生成应用于单线激光雷达的单线深度补全数据集,进一步将其划分为三者互不相交的训练集(85898组数据)、验证集(5852组数据)与测试集(1000组数据),其中:训练集用于训练,验证集用于挑选最佳网络模型,测试集用于评估最佳网络模型的性能,每组数据包含rgb图(输入),对齐的单线深度图(输入),与半稠密深度图(真值)。

25.步骤2)布置神经网络:布置一种具有全局分支(上分支)、局部分支(下分支)和归一化层的双分支深度学习网络,其中:全局分支利用rgb图像中的全局语义信息辅助预测物体的边界以找到深度相似的区域;局部分支聚焦于深度图中的有效值区域并预测有效值区域周围的深度的同时,利用全局分支提取的全局特征来修正稀疏深度图的内在误差。

26.所述的全局分支包括并联的两个编码器a1、a2以及利用其输出融合的特征作为输入的解码器a,该全局分支依靠rgb图像提供的全局语义信息,在远离单线深度图中有效值的区域能取得更好的结果,两个编码器分别输入rgb图和单线深度图并将提取的特征融合后由解码器a生成全局深度图、全局置信度图和全局特征。

27.所述的局部分支包括:依次串联的两组编码器-解码器(b和c),该局部分支接收融合后的全局特征与单线深度图生成局部置信度图与局部深度图,其中全局特征起到引导单线深度的作用,在单线深度图中接近有效值的区域,局部分支可以取得更好的效果。

28.所述的归一化层对全局置信度图和局部置信度图通过softmax函数做归一化得到全局权重图和局部权重图,分别用于对后续的全局深度图和局部深度图进行对应的权重加权求和,实现融合输出。

29.所述的softmax函数其中:si代表元素i经过softmax函数后的输出,i代表元素i,j代表所有元素,也就是元素的softmax值,就是该元素的指数与所有元素指数和的比值。此处的元素i分别指的是全局和局部置信度图,而所有元素指数和就是全局置信度图和局部置信度的指数和。

30.所述的融合输出具体为:其中:d

final

为最终输出的预测深度图,c

global

为全局置信度图,c

local

为局部置信度图,d

global

为全局深度图,d

local

为局部深度图。

31.本实施例中全局分支使用2个编码器分别提取rgb图和单线深度图的特征并融合,每个编码器由13个残差块组成,每个残差块包含2组3x1和1x3的卷积,之后使用解码器利用融合后特征生成全局深度图、全局置信度图和用于引导局部分支的全局特征,全局分支的解码器使用内容感知的上采样模块和转置卷积来实现上采样,其中内容感知的上采样模块也是本发明设计的一种用于上采样的结构,该结构使用3x3卷积来动态根据特征图的内容在不同位置生成不同的核矩阵,相对于转置卷积在所有位置使用同一核矩阵进行上采样,本发明设计的此模块能更好地利用rgb图提供的语义信息来补全深度。局部分支使用全局特征与单线深度图作为输入,共使用2组编码器-解码器,局部分支中的编码器与解码器只

使用普通的卷积和转置卷积,局部分支最后生成局部深度图和局部置信度图。最终,全局深度图与局部深度图以置信度图进行融合生成最终预测的深度图。

32.步骤3)设置损失函数:通过用于单线深度补全的组合损失函数训练步骤2中得到的双分支深度学习网络,该组合损失函数由用于实现像素级约束的均方误差损失函数和用于实现三维几何约束的虚拟法线误差损失函数组成。由于真值深度图是半稠密的,所以只使用真值深度图中的有效值部分计算损失。

33.所述的虚拟法线误差损失函数分别在预测深度图和真值深度图上随机采样若干组点来构成虚拟平面,每组点包含不共线的3个点,之后根据若干组虚拟平面生成虚拟法线,最终使用预测深度图的虚拟法线与真值深度图的虚拟法线计算损失。

34.优选地,为使均方误差损失函数和虚拟法线误差损失函数在同一数量级,本方法将虚拟法线损失的权重设为100,均方误差损失的权重设为1,使网络关注像素级的预测,同时也使其关注于三维几何信息。

35.通过上述数据集训练出能应用于单线激光雷达的神经网络,在使用时仅需输入rgb图和对齐的单线深度图就能直接得到准确而稠密的深度图,其中使用的单线激光雷达与rgb相机均成本低廉。

36.本实施例在每次训练迭代时得到全局深度图、局部深度图与最终预测的深度图,使用上述组合损失函数计算这三者与真值的损失,并使用adamw优化器根据损失进行梯度下降训练网络。由于全局深度与局部深度仅用作中间监督,所以损失的权重设为0.1,而最终预测深度损失的权重为1。

37.优选地,在训练网络的过程中,使用验证集评估网络的泛化性能,并存储其中最佳的那组网络参数,作为最终网络的参数。

38.本实施例最后将使用此组参数作为最终网络模型的参数,并使用测试集评估其性能。一共使用4组指标来评估的网络,具体如表1所示。由于真值深度图是半稠密的,所以计算误差时只使用真值深度图中的有效值部分计算误差。

39.表1本发明网络在测试集上的性能表现网络均方根误差平均绝对误差平方相对误差绝对相对误差ours2921.94mm1080.99mm0.97%4.68%

40.可以发现本发明的网络在各项指标上均取得不错的效果,其中绝对相对误差更是仅仅只有4.68%,这意味着如果真实深度值为1m,那补全出的深度值误差也仅仅只有

±

4.68cm,如此误差已经能满足实际应用。

41.如图4所示,为本发明网络在单线深度补全测试集上的表现,经观察可以发现本发明设计的网络以rgb图和对齐的单线深度图为输入,已经能很准确地生成稠密深度图,其中汽车边界、骑自行车人边界均精确生成。

42.表2本发明与现有的先进深度补全方法的对比网络均方根误差平均绝对误差平方相对误差绝对相对误差ours2921.94mm1080.99mm0.97%4.68%revisiting3356.27mm1374.82mm1.53%6.88%nconv-cnn6607.35mm3035.96mm7.45%16.33%

43.现有的深度补全网络都是基于64线激光雷达设计的,对于这些网络,虽然通过将

训练时的64线深度图替换为本发明生成的单线深度图后也能用于单线激光雷达,但由于他们并未针对单线激光雷达的任务进行优化,所以效果往往不佳。表2对比了目前64线深度补全任务中的一些先进方法,在同时使用本发明生成的单线深度补全数据集训练的情况下,可以发现本发明设计的网络在各个指标上都具有很大的优势,在均方根误差这个主要指标上本发明网络相较那些用于64线深度补全的先进网络,误差下降了12.94%以上。

44.表3为本发明中内容感知的上采样模块与组合损失函数的消融实验网络均方根误差平均绝对误差平方相对误差绝对相对误差ours(full)2921.94mm1080.99mm0.97%4.68%w/o caum3013.59mm1128.84mm1.01%4.82%w/o vnl3098.18mm1208.70mm1.34%5.68%

45.这是本发明中内容感知的上采样模块与组合损失函数的消融实验,其中ours(full)代表本发明使用的完整结构,w/o caum(without content-aware upsampling module)代表将内容感知的上采样模块替换为转置卷积,w/o vnl(without virtual normal loss)代表将本发明使用的组合损失函数替换为均方误差损失函数,也就是移除了虚拟法线损失。通过实验结果可以发现,本发明设计的内容感知的上采样模块与虚拟法线损失均能大幅度提升本发明网络在单线深度补全任务上的精度。

46.本实施例将得到训练好的网络模型后,本发明将此模型部署在实际场景下,进而以低廉的成本得到准确而稠密的深度图。对于rgb相机与单线激光雷达的部署,需要保证二者以相对位置固定的方式部署在同一平台上,同时完成二者的对齐。之后,需要将的网络模型部署在硬件平台中。最后,在运行过程中,将实时得到的对齐过的rgb图与单线深度图同时送入网络,如此便能以十分低廉的成本获得准确而稠密的深度图。

47.经过具体实际实验,本发明使用利用kitti生成的单线深度补全测试集来模拟真实运行环境,将对齐过的单线深度图和rgb图作为网络输入,模拟真实场景下的rgb相机与单线激光雷达部署在同一平台上,测试集共包含1000组数据,相当于在模拟场景下完成1000帧图像的单线深度补全,1000帧的定量误差已在表1显示,定性结果本发明选取了1组数据进行展示。

48.现有技术由于深度补全数据集的稀疏深度图都是64线的限制,只能基于64线激光雷达来生成稠密深度图。并且现有技术的网络即使在使用了本发明生成的数据集进行训练的情况下,由于并未针对单线深度补全任务做过优化,所以精度也远不如本发明设计的网络,同时使用本发明生成的单线深度补全数据集训练的情况下,在均方根误差这个主要指标上本发明设计的网络相对那些用于64线深度补全的先进网络,误差下降了12.94%以上。

49.上述具体实施可由本领域技术人员在不背离本发明原理和宗旨的前提下以不同的方式对其进行局部调整,本发明的保护范围以权利要求书为准且不由上述具体实施所限,在其范围内的各个实现方案均受本发明之约束。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1